У вас может быть очень крутой сайт. Качественный, с интересным контентом, с полезными товарами. Дизайном шикарным и удобным меню. Но если на нем есть битые ссылки (особенно если их много), это автоматически делает его подозрительным в глазах поисковых роботов и создает дурное впечатление о ресурсе со стороны посетителей. Такого допускать нельзя. Ваш прекрасный сайт должен быть прекрасным во всем. И мы этого добьемся.

Что такое битая ссылка?

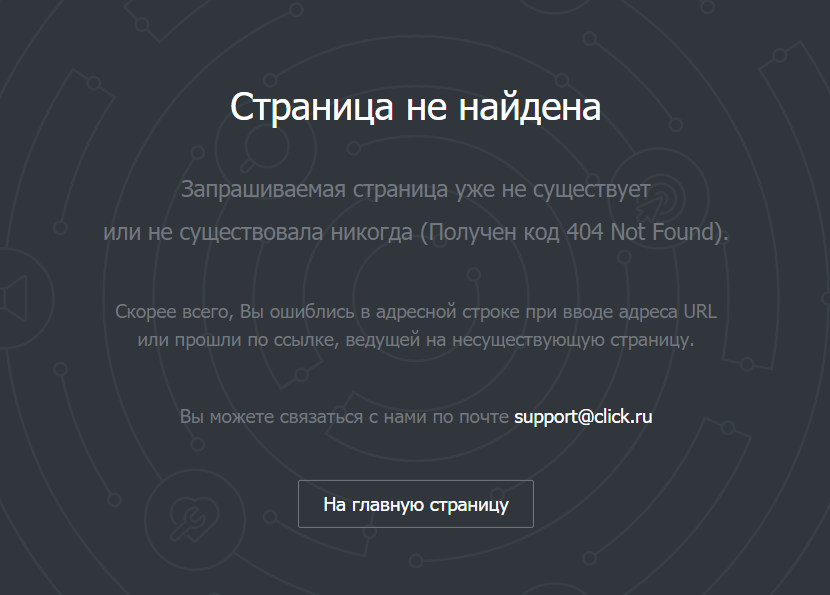

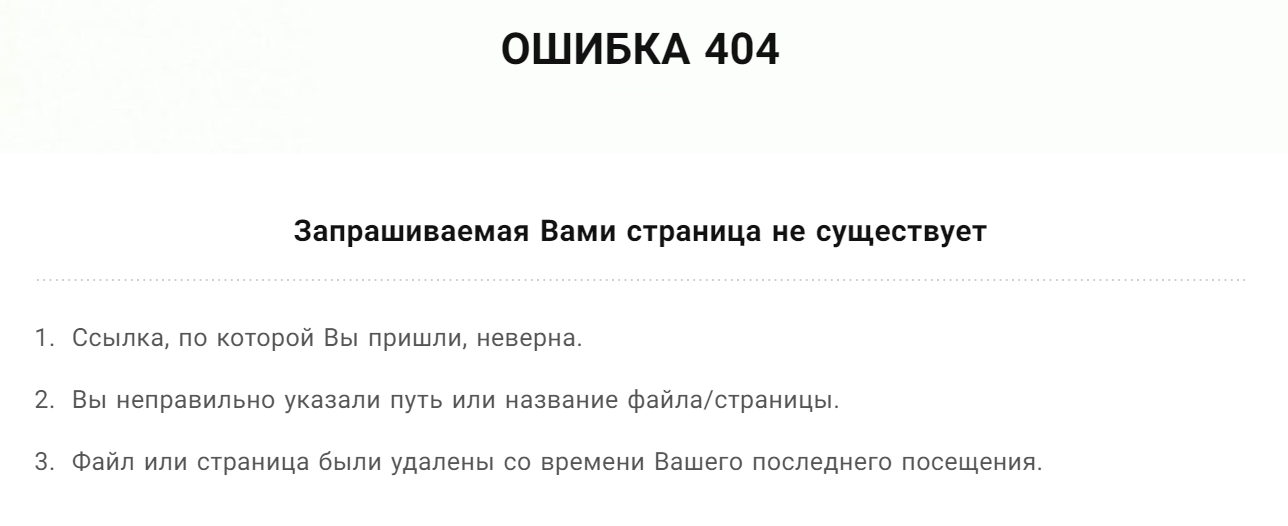

Битая ссылка — это страница на сайте, которую нельзя открыть. Ее не существует. Когда потенциальный посетитель пытается на нее попасть, то получает в ответ ошибку. Это может быть ошибка 404 Not Found или 400 Bad Request. Или без кода вовсе: Timeout, Empty, Reset. Зависит от настроек конкретного ресурса. Оболочка разная, а смысл один и тот же. Сервер говорит, что искомой страницы здесь нет.

Такие ссылки еще изредка называют «мертвыми». Они возникают по нескольким распространенным причинам:

- В адресе страницы допущена ошибка. Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

- Структуру сайта недавно кардинально поменяли, не настроив при этом перенаправление со старых ссылок.

- Ссылки на сторонний контент на странице удалили или каким-либо образом «сломали».

- В коде сайта затесались ошибки. В HTML или в JavaScript. Может быть, это сбой в CMS.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Чем опасны битые ссылки?

Есть две неподтвержденные теории и один солидный факт, подтверждающие серьезную угрозу со стороны битых ссылок.

Первая теория такая. Считается, что поисковые роботы Google и Яндекс не любят битые ссылки. Заприметив оные, поисковики решат, что сайт уже давно бросили или сделали так криво, что и стыдно его людям показывать. В связи с этим, позиции ресурса в Google и Яндекс заметно «просядут». Но никто еще не доказал, что это так.

Вторая теория. Якобы битые ссылки расходуют краулинговый бюджет — объем страниц, который поисковики сканируют за определенный период времени. Здесь вмешался представитель Google и сказал, что появление 404 ошибки никак не повлияет на краулинговый бюджет.

А вот что реально важно, так это отношение посетителей к сайту с битыми ссылками. На таких долго не задерживаются. Обычно 404 Not Found говорит о том, что надо бы перейти на главную страницу и воспользоваться поиском. Но всем плевать. Человек просто вернется в Google и будет искать ресурс с рабочими ссылками. Все. Вы потеряли своего посетителя.

Из-за этого вырастет доля отказов. А это не только упущенная аудитория, но и проблемы с ранжированием. Поисковик простит вам битую ссылку, но не простит визитер, который провел на сайте всего секунду и неожиданно убежал.

Читайте также

Как разыскать все битые ссылки на сайте?

Никто не будет сидеть и тыкать во все ссылки на сайте, чтобы найти битые. Тем более, если такие есть на чужих ресурсах. Поиском мертвых страниц занимаются специальные веб-сервисы и приложения. Кому что удобнее.

Я бы советовал не останавливать выбор на чем-то одном. Бывает так, что один сервис отображает неполную информацию. Это как с антивирусами. В тандеме находят больше угроз, чем по одиночке.

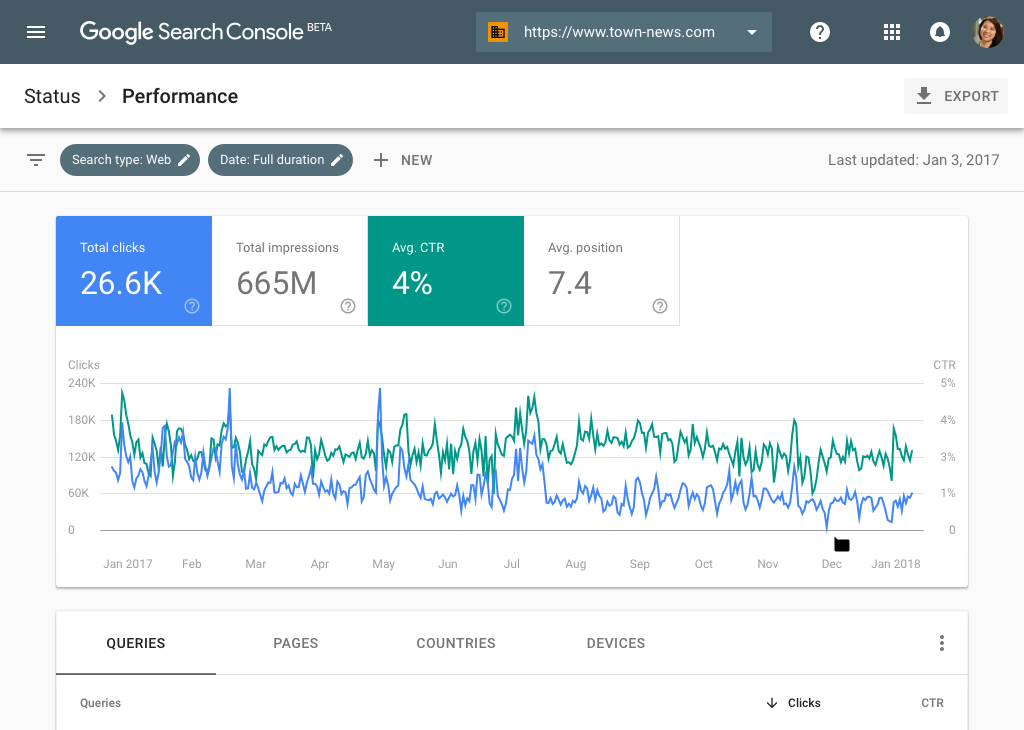

Google Search Console

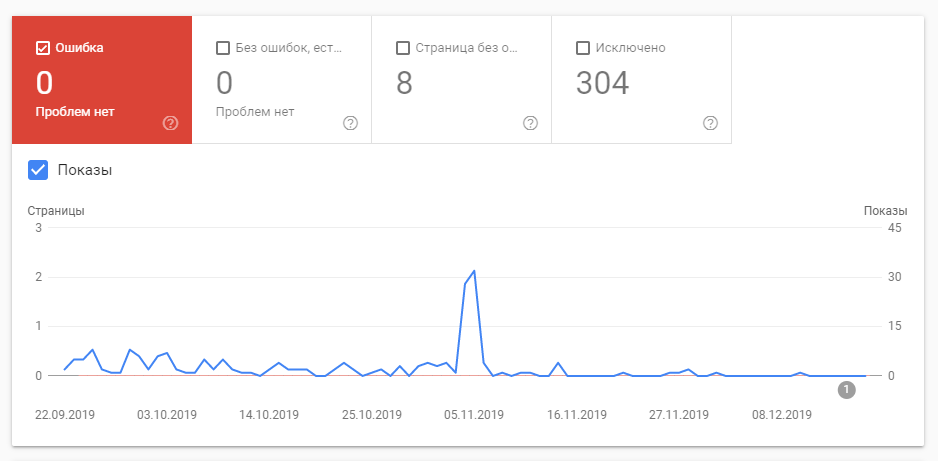

Официальная панель управления Google отлично справляется с поиском битых ссылок. Так что можно отлавливать 404-е с помощью нее. Надо только подтвердить свои права на домен, а потом открыть пункт меню «Покрытие».

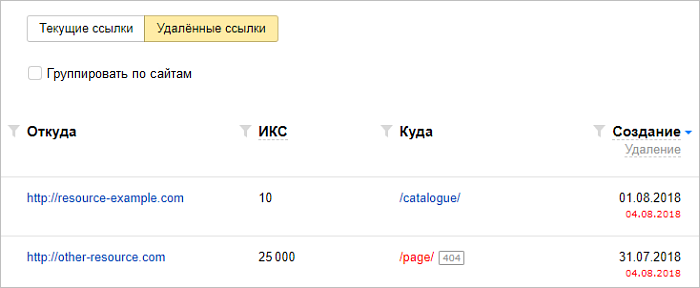

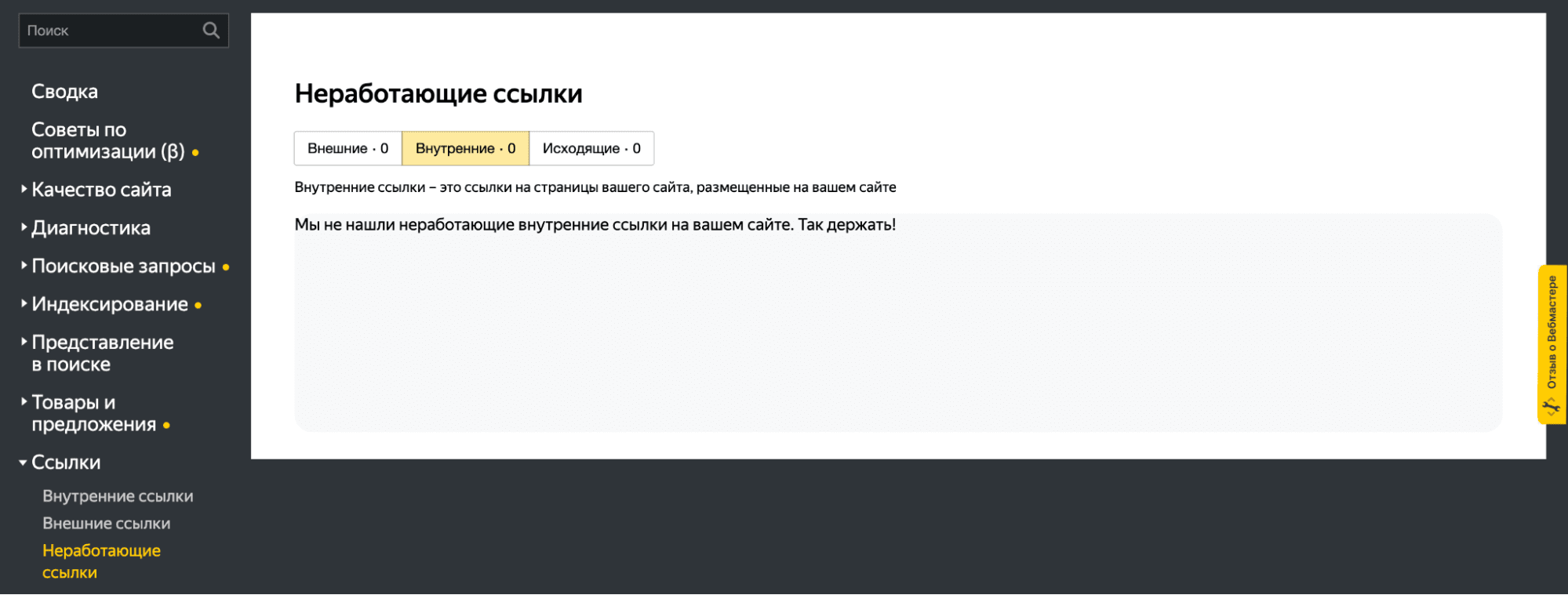

Яндекс.Вебмастер

Аналогичная функция есть в Яндексе. В их Вебмастере есть раздел «Ссылки», где можно взглянуть на все поломанные. Только вот здесь есть сложности с экспортом отчета. Раньше не было удобного способа вытащить все данные об ошибках, чтобы потом их устранить. Сейчас можно скачать TSV-файл с 10 000 битых ссылок. Кому-то даже этого будет мало.

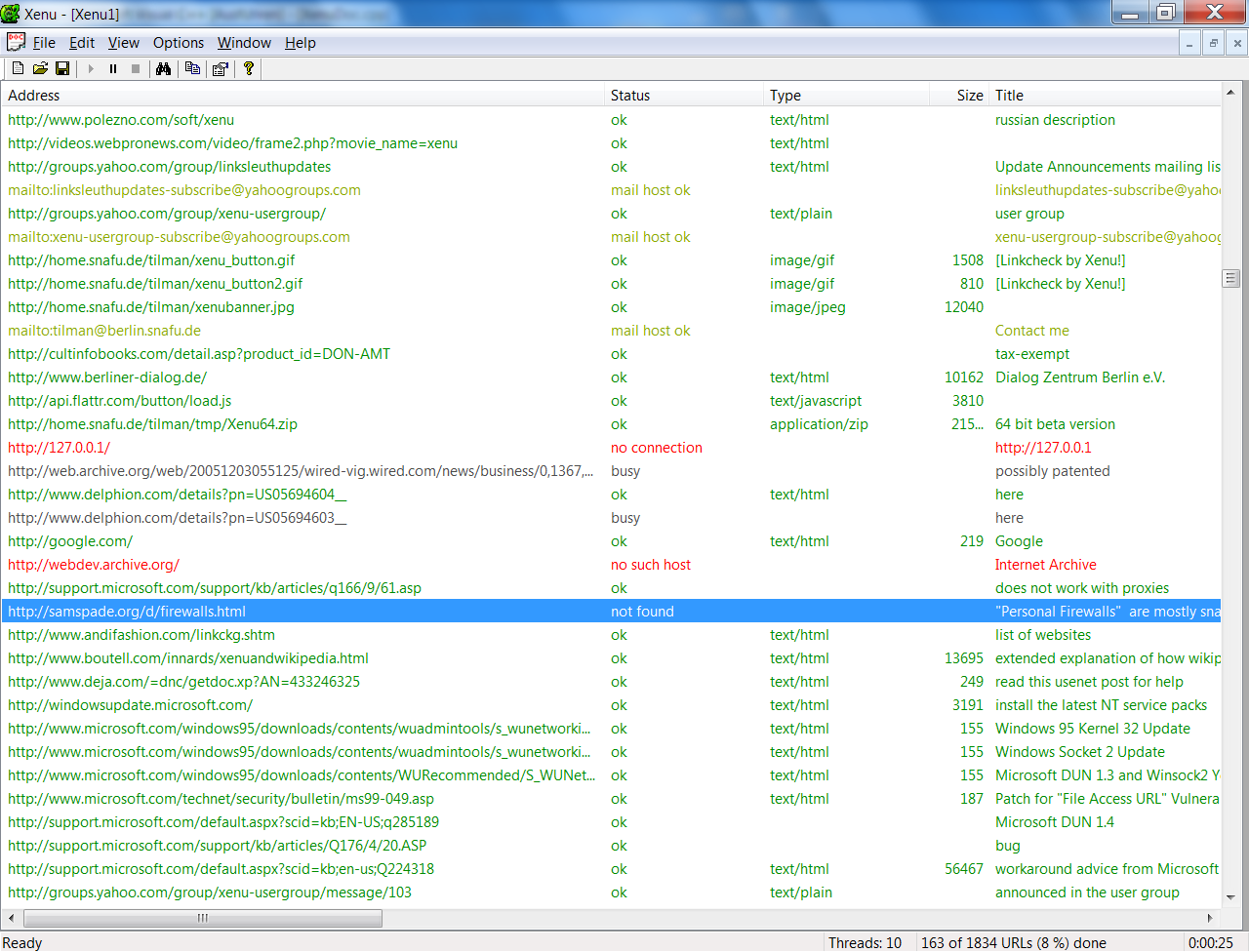

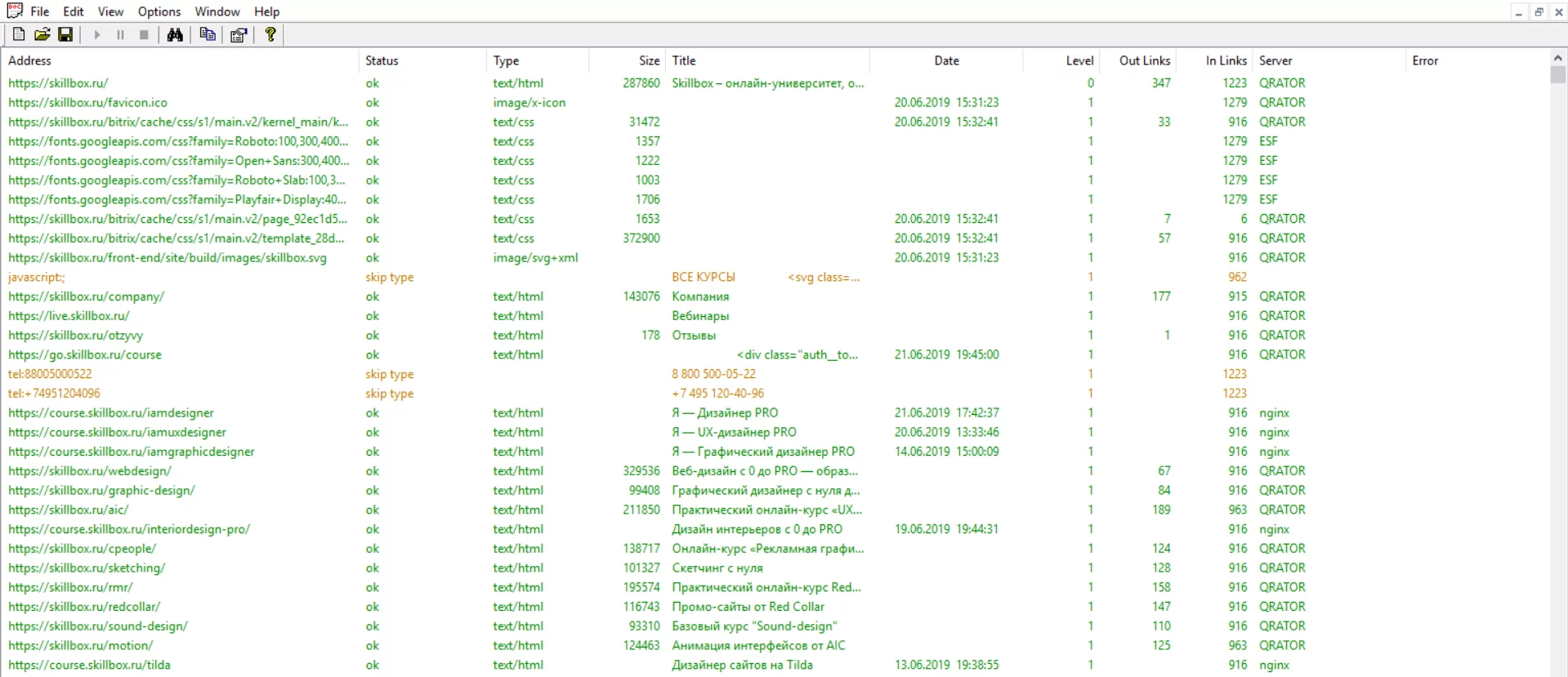

Xenu

Это старая программа, но отчеты из нее многие до сих пор считают эталонными. Xenu предоставляет информацию бесплатно, поэтому можно попробовать самостоятельно и без финансовых потерь.

- Поддерживает страницы с шифрованием.

- Работает быстрее большинства аналогов.

- Может обнаружить перенаправления.

- Позволяет делать повторные проверки.

Broken Link Checker

Это даже не отдельная программа, а плагин для WordPress. Дико популярный и полезный. Из плюсов можно выделить то, что он бесплатный и встраивается в WordPress. А из минусов — то, что он не всегда работает корректно и сложно настраивается. Часто приходится запускать модуль по несколько раз, чтобы был какой-то прок. Но другие дополнения к WordPress подобного рода оказываются еще хуже.

Netpeak Spider

Это дорогой и сложный инструмент для скрупулезного SEO-аудита. Он справляется с поиском сломанных страниц, но создавался для решения более широкого круга задач. Скорее всего, его покупка себя полностью не оправдает. Но функциональность хвалят, да.

Dead Link Checker

Платный онлайн-сервис для поиска ошибок 404 на ресурсе. Работает по подписке. То есть платите 10$ в месяц и получаете возможность отсканировать до 50 000 ссылок. Когда есть бесплатные альтернативы, кажется, что это не самый лучший выбор. Но я его не тестировал. Возможно, он творит какие-то чудеса и находит то, что не способны найти конкуренты.

Есть еще с десяток подобных приложений и сайтов, но они так себе. Либо работают чересчур медленно, либо стоят неадекватно дорого.

Нашел все битые ссылки, что дальше?

То, что нашли, уже хорошо. Только теперь надо их исправить. Будем действовать по следующей схеме действий:

- Разберем все ссылки.

- Категоризируем их.

- И исправим все ошибки.

Анализируем ссылки

Сначала надо организовать данные, полученные из сервисов по поиску битых ссылок. Надо понять, почему те или иные ссылки поломаны. Например, если дело в опечатке, то проще всего исправить эту самую опечатку в коде сайта. Если страницы больше не существует, то надо удалить ссылку и добавить заглушку с соответствующим сообщением. Мол, «410 Gone, ребята, странички не будет». А если вы недавно переехали на другой домен, то самым адекватным решением будет — настроить массовый редирект.

Поэтому для начала можно создать такую простенькую табличку:

| Мертвая ссылка | Количество посещений | Редирект сюда |

| kakaya-to-statya.net | 17 | kakaya-to-statya.blog.net |

| sayt-s-opechatkay.ru | 12 | — |

| sayt-s-opecahtloy-2.ru | 1 | — |

На ней сразу будет видно ссылки, которым нужен редирект, ссылки, для которых стоит заморочиться с исправлением опечаток, и те, о которых можно забыть.

Но это, конечно, исключительно пример. Вы можете организовать полученную информацию, как вздумается.

Исправляем опечатки

Опечатки бывают двух типов. Те, что допустили вы как владелец сайта. И те, что допускают посетители, надумавшие зайти к вам вручную, указав адрес страницы (страшные люди). Какие опечатки стоит исправлять и так понятно. Те, что допустили сами.

Но есть еще один момент. Если по ссылке с опечаткой пытаются пройти регулярно, то имеет смысл настроить перенаправление на правильную страницу. Или сделать вариант с опечаткой рабочей альтернативой для самых настойчивых.

Настраиваем редирект

Теперь займемся ссылками, которые по-вашему мнению нуждаются в перенаправлении.

Тут и пригодится таблица, которую я описал выше. Наглядно показано, что и куда должно переехать.

Расскажу, как можно сделать 301 редирект в CMS WordPress и с помощью файла .htaccess

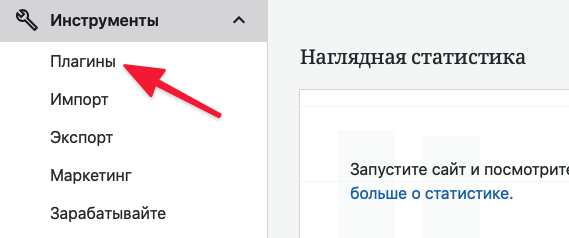

WordPress

- Открываем вкладку «Инструменты»

- Переходим в подпункт «Плагины».

- Кликаем по поисковому полю.

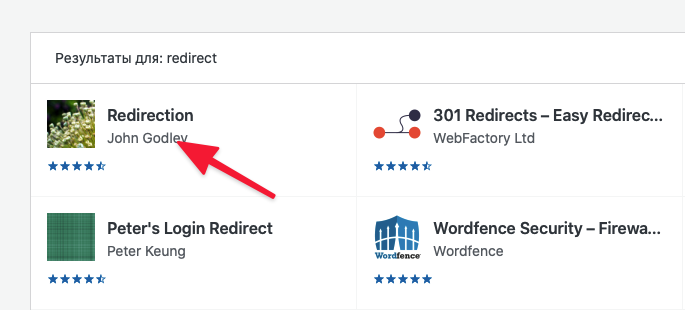

- Ищем плагин Redirection и устанавливаем его.

В поисковике будут и другие плагины, с помощью которых можно настроить редирект. Можете попробовать их. Это уже дело вкуса.

- Потом снова открываем вкладку «Инструменты».

- Переходим к настройкам плагина «Перенаправления».

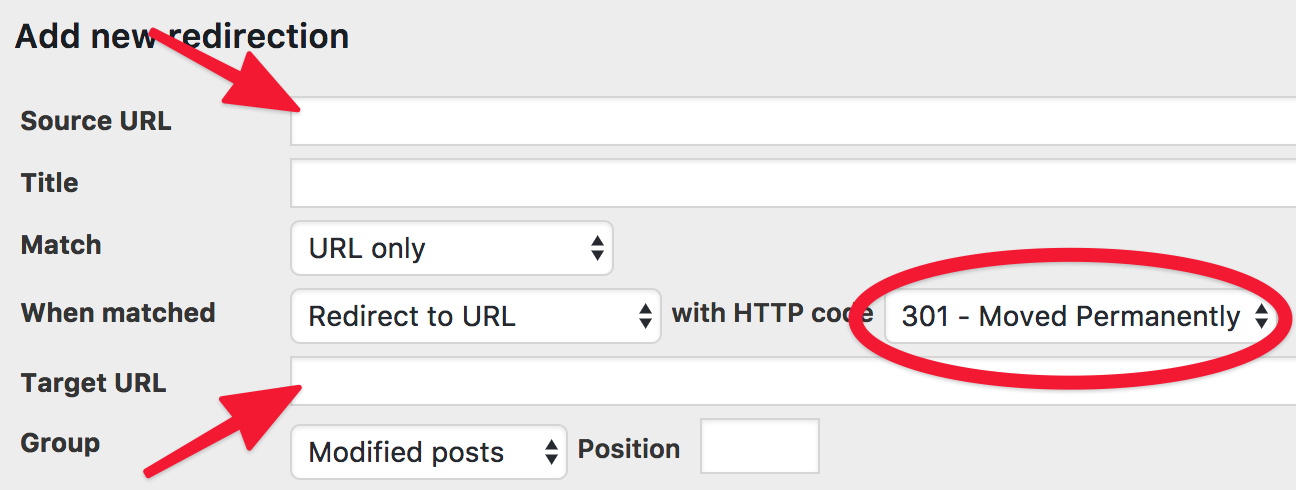

- Нажимаем на Add new redirection.

- Указываем Source URL (ссылку, с которой надо перенаправить).

- А потом Target URL (куда надо перенаправить).

- И сохраняем заданные параметры.

Ну и так придется повторять до тех пор, пока все ссылки, нуждающиеся в перенаправлении, не получат его. Эти задачи нередко достаются верстальщикам на аутсорсе или «разнорабочим» с UpWork и других бирж.

Как сделать массовый редирект

При переезде на новый домен вручную делать редирект всех битых ссылок — это нерациональный адский труд. Поэтому проще воспользоваться массовым редиректом. Делаем следующее:

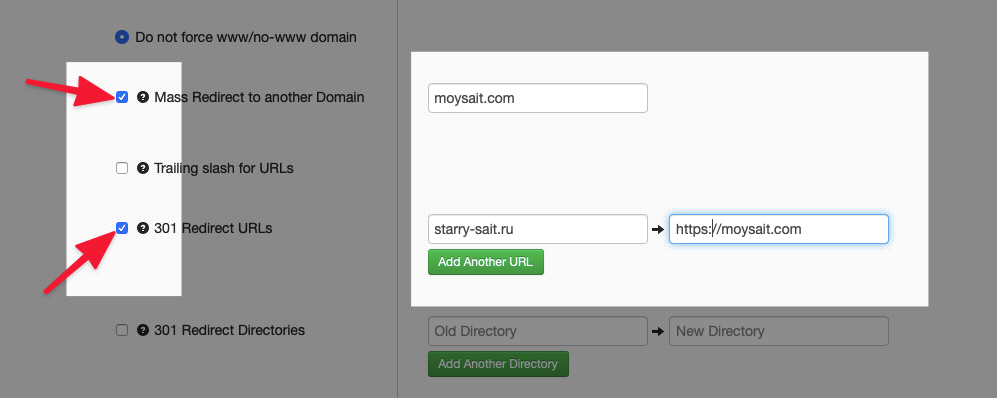

- Открываем сайт для генерации файла .htaccess с настроенным перенаправлением.

- Ставим галочки напротив пунктов Mass Redirect to another Domain и 301 Redirect URLs.

- Напротив первого вписываем название сайта.

- Напротив второго домен, с которого нужно перенаправить пользователей, и домен, на которой надо перенаправить.

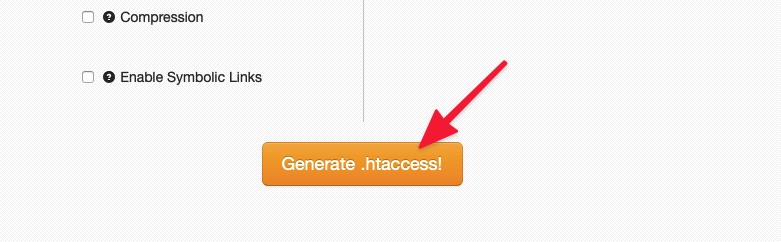

- Нажимаем на кнопку Generate .htaccess в нижней части страницы.

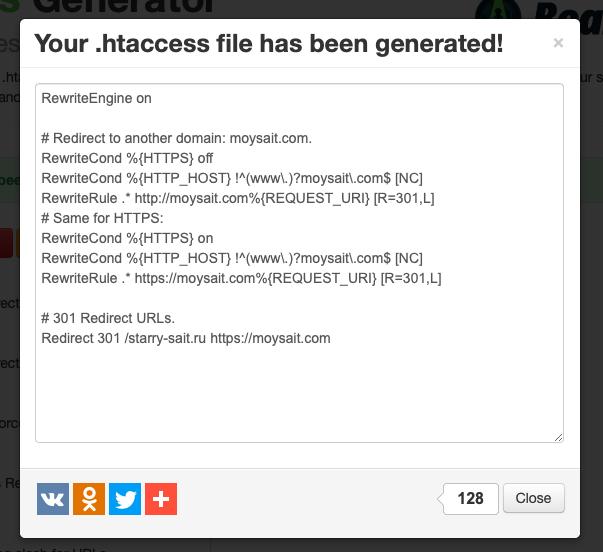

- Потом копируем сгенерированный код и вставляем его в файл .htaccess на сервере.

Впрочем, так можно сгенерировать код для любого типа перенаправлений.

Что делать с битыми ссылками на чужих сайтах?

Теперь вы знаете, что делать со страницами, которые убили сами и к которым у нас есть доступ. Проблематичнее дела обстоят с чужими сайтами, где есть ссылки на ваш ресурс. Они тоже подвержены опечаткам и переезду. Тоже будeт ошибка. Но дело поправимое.

Попросим владельца сайта поменять ссылку

Это, наверное, до боли очевидное решение. Просто постучите владельцам сайта, на котором лежит битая ссылка на ваш ресурс. Попросите их исправить опечатку или указать в материале обновленный адрес. Если удастся с ними связаться, то больше ничего делать и не придется. Все поправят за вас. Но шансы, что вас проигнорируют ощутимо выше.

Настроим редирект с битой ссылки на рабочую

Работает так же, как и в случае со своими ссылками. Просто настройте редирект, чтобы пользователь оказался в нужном месте. Для этого не надо ни с кем связываться и ждать ответа. Настраиваем перенаправление удобным способом и радуемся.

Заново создаем пропавшую страницу

Если уже успели удалить страницу, на которую ведет битая ссылка, то можно создать ее заново. Добавьте туда аналогичный контент. Или тот же, что был раньше. Это может пригодиться, если с чужой страницы приходит большое число посетителей.

Настроим редирект на похожую страницу

Может, контент на уже несуществующей странице устарел? Подумайте, возможно, у вас есть страничка с похожей информацией. Будет хорошей идеей настроить редирект на нее. Тогда и вы ничего не теряете, и посетитель получит то, чего ждет.

И бонусом делаем кастомную страничку 404

Тоже хороший вариант. Сделайте страницу с ошибкой 404 более привлекательной. Оригинальной, что ли. Добавьте картинку, анимацию. Не плоскую шутку. А самое главное, ссылку на главную страницу или на встроенный поисковик. Так вы в десятки раз повысите вероятность, что пользователь останется на вашем сайте, а не ретируется, заметив страшные черные буквы — Not Found.

Можно испробовать все описанные способы в том же порядке. Не ответил владелец чужого сайта? Пилите редирект. Не подходит вариант с редиректом? Так хотя бы сделайте нормальную страничку с ошибкой. Это уже что-то.

Выводы

Итак, еще раз:

- Битые ссылки — поломанные страницы, отзывающиеся ошибками 400 и 404.

- Они портят жизнь посетителям вашего сайта. Так что придется принимать какие-то меры.

- Их несложно найти с помощью бесконечного количества сайтов и программ, заточенных под эту задачу.

- И есть ворох путей исправления ситуации, независимо от того, почему появились проклятые битые ссылки.

Думаю, на этом и закончим. Спасибо.

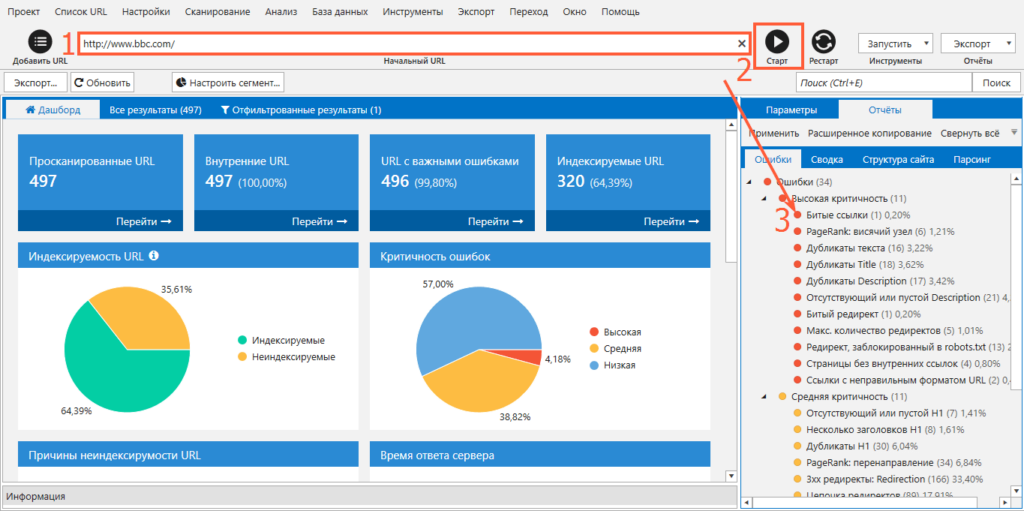

Наличие технических ошибок на сайте может негативно сказаться на его ранжировании, что в свою очередь приведет к снижению поискового трафика и позиций в поисковых системах. Чтобы выявить технические ошибки, необходимо провести комплексный технический SEO-аудит сайта. Одним из основных помощников в этой сложной и трудозатратной задаче для нас выступает десктопная программа Screaming Frog.

О Screaming Frog

Screaming Frog – это софт для сканирования сайта, ключевыми функциями которого являются:

-

поиск битых ссылок;

-

поиск ссылок с редиректом;

-

поиск дублей страниц;

-

анализ изображений;

-

поиск страниц, где отсутствуют мета-теги или основной заголовок h1;

-

извлечение элементов со страниц сайта;

-

поиск пустых страниц или неинформативных страниц, где крайне мало контента.

С помощью данной программы можно проанализировать страницы, которые закрыты в файле robots.txt, проверить наличие и корректность заполнения тегов alt у изображений, а также наличие атрибута Canonical и многое другое.

Screaming Frog может просканировать весь сайт полностью, либо же определенный каталог, либо заданный вручную список страниц. Чтобы не создавать сильную нагрузку на сервер, можно в любой момент остановить сканирование.

Важным плюсом является то, что результат сканирования можно выгрузить в формате csv или xlsx. Но есть и некоторые минусы:

-

сложный и интуитивно непонятный интерфейс для новых пользователей;

-

данные хранятся в оперативной памяти вашего ПК, в связи чем довольно проблематично полностью сканировать объемный сайт. А также при работе с софтом работа ПК может замедлиться;

-

программа платная (но есть бесплатная версия с ограничениями).

А теперь подробнее.

Поиск битых ссылок

Мы намеренно перескочили через тему «Настройка Screaming Frog», так как в сети присутствует большое количество мануалов по настройке программы, описаний интерфейса и вводной информации о том, как работать с программой и сканировать сайт. Переходим сразу к техническому анализу сайта.

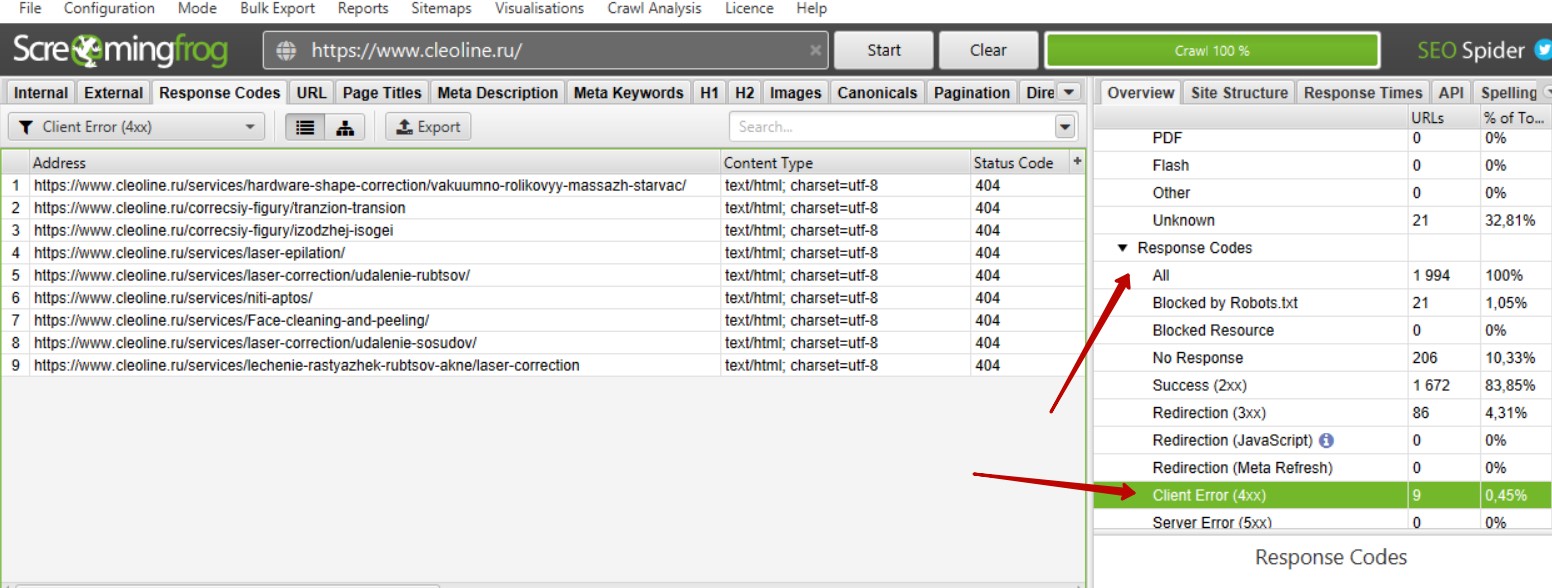

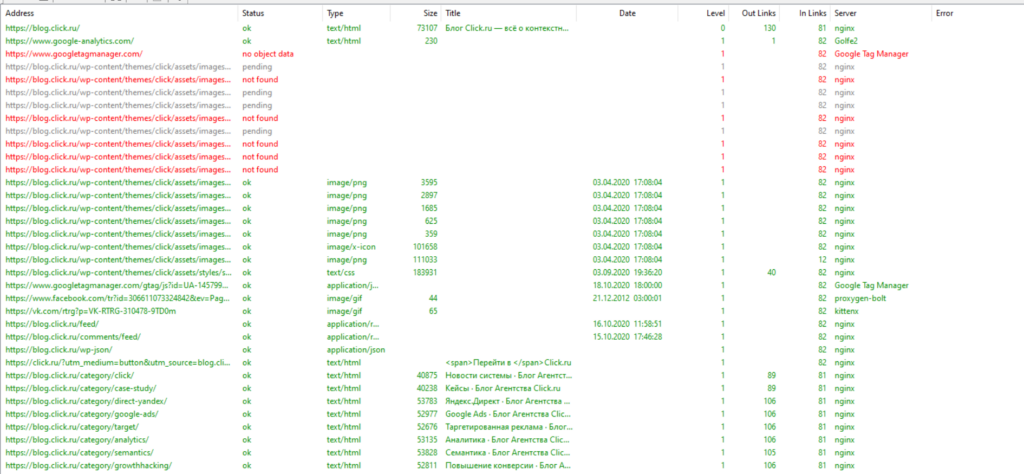

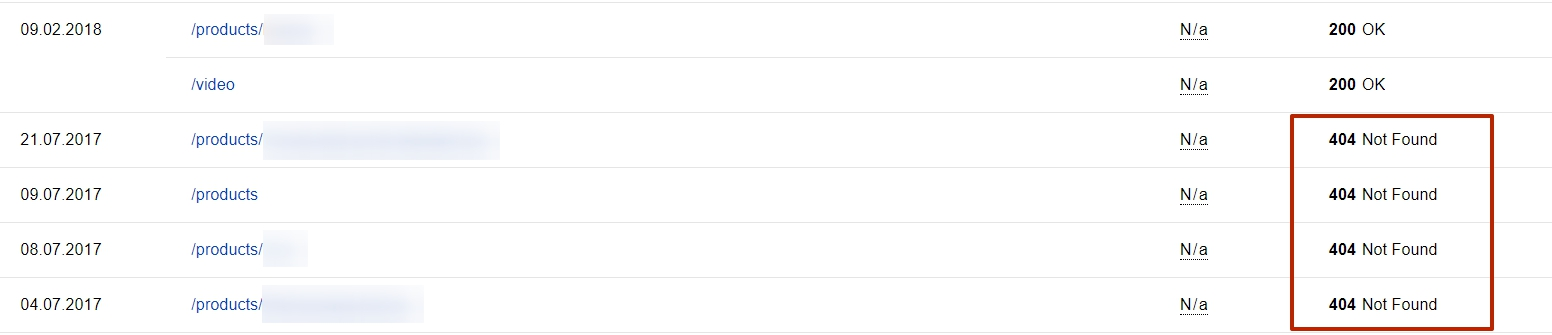

Итак, мы просканировали сайт. Для поиска битых ссылок необходимо справа найти вкладку «Response Code» — «Client Error (4xx)». Теперь мы видим список битых ссылок при их наличии на сайте.

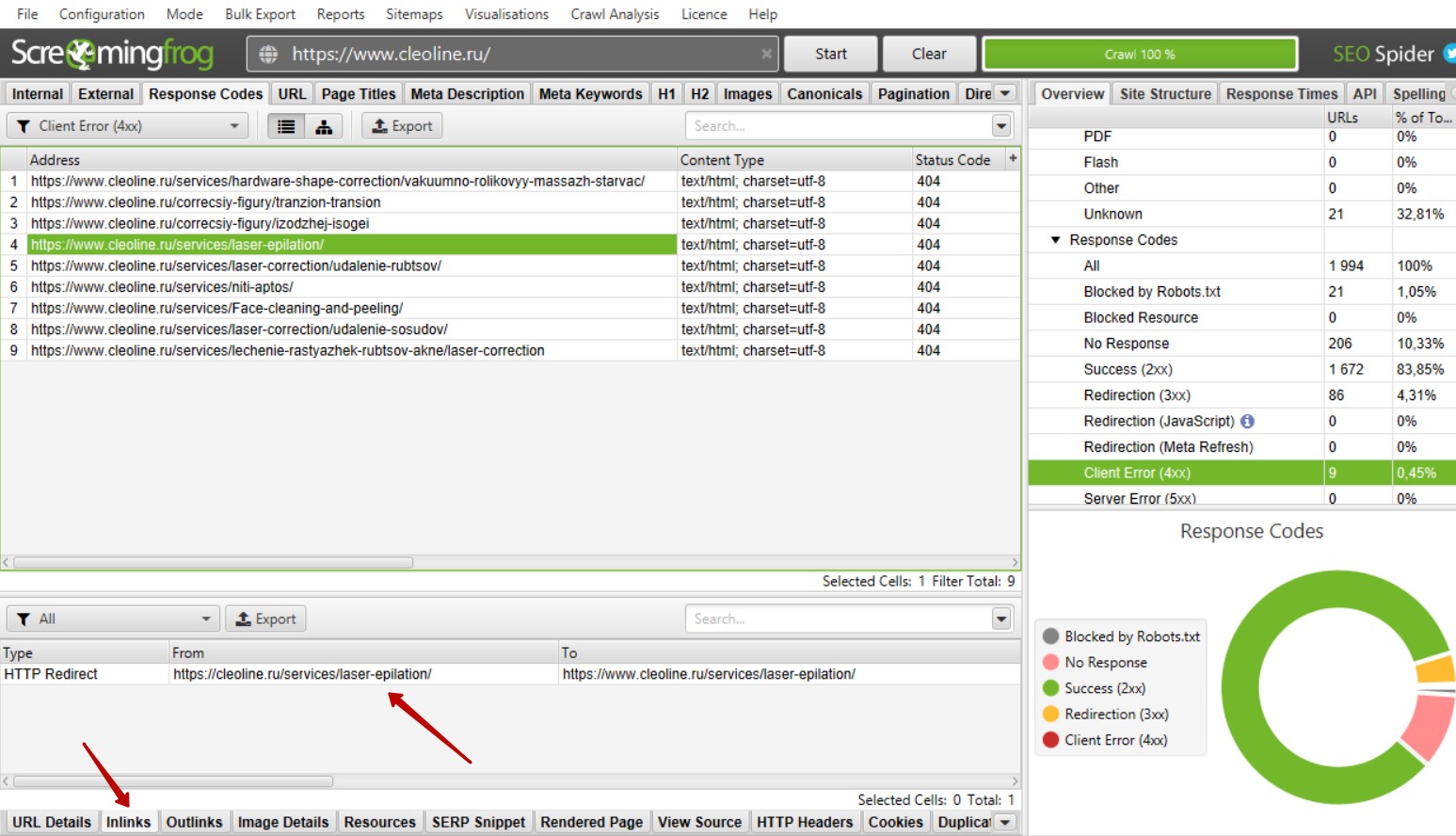

Как определить на каких страницах находятся битые ссылки?

Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылка или список ссылок.

Такие ссылки рекомендуется убирать, так как большое количество битых ссылок может негативно сказаться на ранжировании сайта.

Как найти битые ссылки на странице сайта?

Если при осмотре страницы битая ссылка не бросается в глаза, необходимо открыть код сайта «ctrl + shift + i», далее открыть форму поиска в коде «ctrl + а» и вбить адрес битой ссылки.

Битые ссылки могут быть размещены в текстах страниц. В таком случае необходимо убирать ссылки вручную. В некоторых случаях ссылка может быть размещена сразу на нескольких страницах. Это говорит о том, что ссылка размещена в меню, в футере или в каком-либо другом сквозном блоке. В таком случае не нужно заходить на каждую страницу отдельно, а можно просто удалить или заменить ссылку.

Почему битые ссылки – это плохо?

Битые ссылки не оказывают прямого влияния на ранжирование сайта, и каких-либо санкций за битые ссылки со стороны поисковых систем нет. Однако они могут потратить часть краулингового бюджета поисковых роботов, понизить показатель качества сайта, увеличить количество отказов. Кроме того, битые ссылки не передают вес другим страницам, а если на неё стоят ссылки с внешних ресурсов, вес такой ссылки не учитывается. Поэтому битые ссылки необходимо удалять с сайта либо заменять их на действующие.

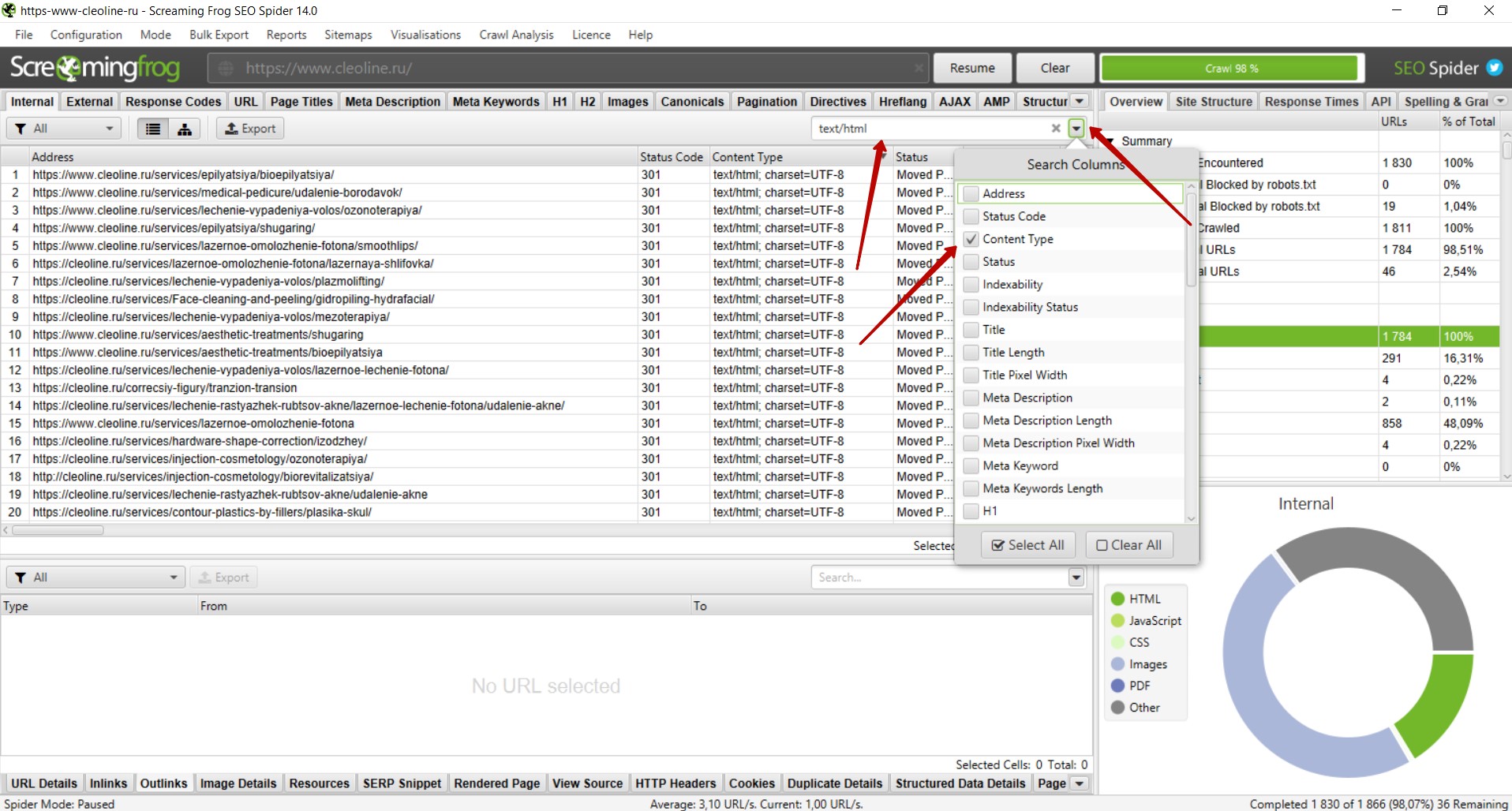

Поиск ссылок с 301 редиректом

301 редирект – перенаправление со старого адреса на новый, если изменился адрес страницы, а контент не менялся. Это делается как раз для того, чтобы не появлялись битые ссылки. Но лучше сразу ставить ссылку с 200 кодом ответа на существующую страницу. Если нет возможности менять ссылки, тогда настраивают 301 редирект. Обычно мы от таких ссылок избавляемся.

Поиск ссылок с 301 редиректом производится аналогичным поиску битых ссылок образом. Необходимо справа найти вкладку «Response Code» — «Redirection (3xx)». Теперь мы видим список ссылок с 301 редиректом и другими редиректами с 3xx кодом при их наличии на сайте.

Как определить на каких страницах находятся ссылки с 301 редиректом?

Поиск таких ссылок осуществляется так же, как и поиск битых ссылок. Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылки или список ссылок, как и в случае с битыми ссылками.

Рядом присутствует вкладка Outlinks, где указаны страницы, куда приходит редирект.

Почему желательно избавляться от таких ссылок?

Небольшое количество таких ссылок никак не отразится на ранжировании сайта. Однако, если ссылок с редиректами много или такие ссылки размещены на всех страницах в меню, футере или других сквозных блоках, рекомендуется заменить данные ссылки на существующие страницы, на которые настроен редирект. Такие ссылки не несут в себе информацию о том, почему происходит перенаправление на другой адрес, что усложняет поисковым системам обработку данного редиректа.

Поиск дублей страниц

Наличие дублей страниц негативно сказывается на ранжировании сайта, так как из двух страниц поисковые системы вероятнее всего будут индексировать только одну наиболее релевантную, на их взгляд, страницу. Дублями страниц могут восприниматься страницы с разным контентом, но одинаковыми тегами title. Бывает, что у страниц услуг и статей идентичные теги title, и такие страницы признаются дублями. При этом интент запросов совсем разный: у первой – информационный, у второй – коммерческий. Для избежания возникновения дублей следует в первую очередь проверять сайт на наличие дубликатов title и при наличии дублей корректировать мета-теги.

Как искать дубликаты title?

Выбираем справа вкладку «Page Titles» — «Duplicate» и получаем список страниц на которых дублируются мета-теги.

В случае, когда на страницах разный контент и одинаковые теги title, необходимо скорректировать мета-теги.

Если страницы идентичны и по тегами, и по контенту, следует удалить одну страницу и настроить 301 редирект с адреса удаленной страницы на существующую страницу. Это поможет, если ссылки на удаленные страницы размещены на других сайтах или находится в индексе. 301 редирект здесь нужен, чтобы пользователи попадали не на удаленную, а на нужную страницу.

Но на самом сайте такие ссылки нужно удалить. Поэтому рекомендуем сразу проверить, есть ли на сайте ссылки на удаленную страницу (см. инструкции выше) и заменить их на существующую страницу.

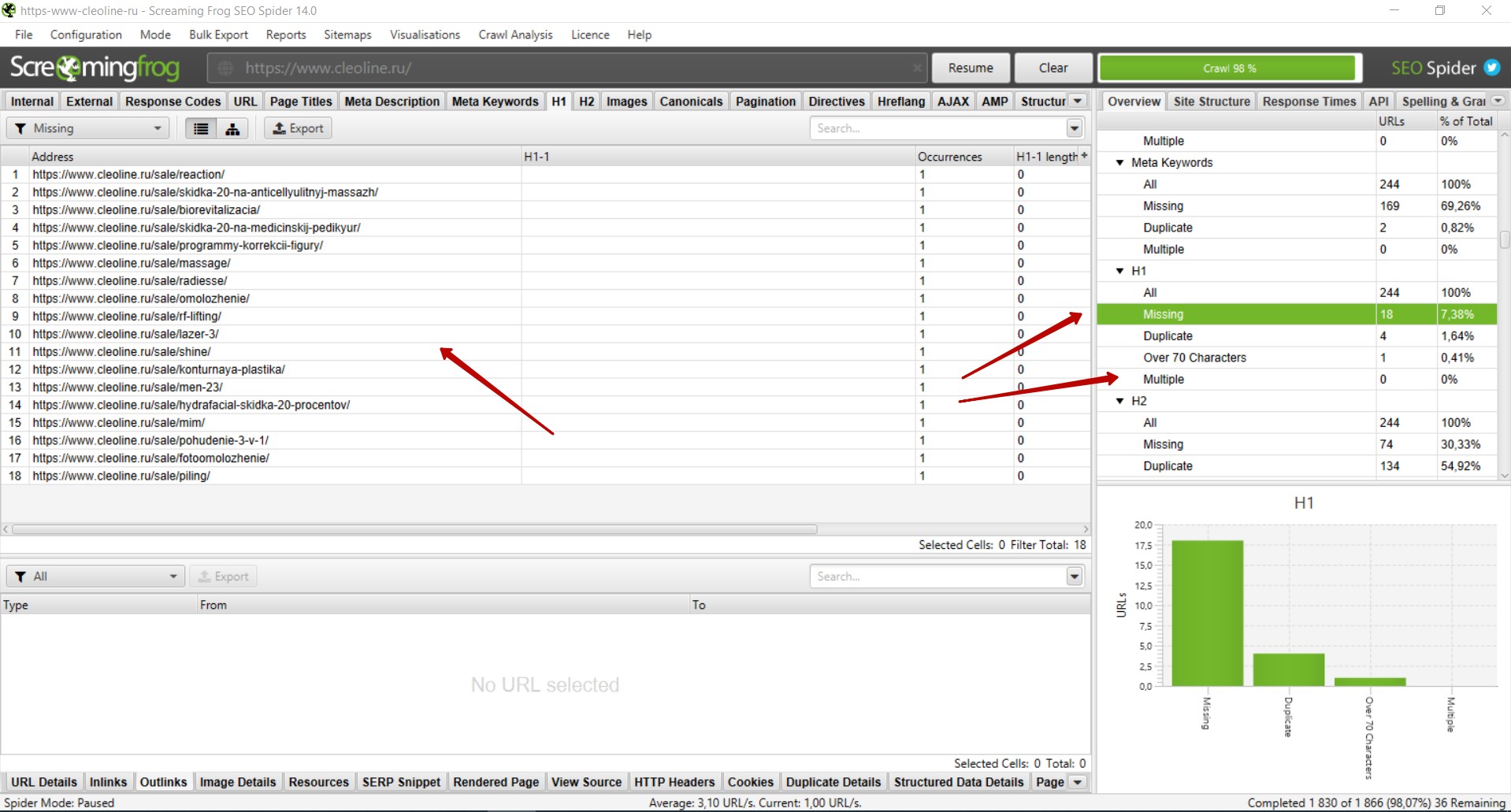

Анализ заголовков h1

На каждой странице должен присутствовать основной заголовок в тегах <h1>, который максимально подробно и при этом кратко отражает содержание страницы. Это позволяет поисковым система более точно определить, что за информация размещена на странице. При проведении SEO-аудита необходимо проверить наличие основного заголовка на всех страницах сайта. Кроме того, тегами <h1> должен быть размечен только один основной заголовок.

Как найти страницы, где отсутствует основной заголовок h1?

Необходимо справа выбрать вкладку «H1» — «Missing>. Вы увидите список страниц, где отсутствует заголовок h1. Следует добавить данный заголовок на все страницы сайта.

В том же блоке справа во вкладке «Multiple» будут страницы, где присутствует несколько заголовков h1. В таком случае необходимо удалить второй заголовок, если он дублирует первый либо в нём нет необходимости, или разметить заголовок тегами <h2> — <h6> в соответствии с его иерархией.

Рекомендуем также проверить вкладку «Duplicate» на наличие дублей заголовков h1. В целом, дубли h1 не являются проблемой. Однако при наличии большого количества дублей рекомендуем корректировать заголовки, в особенности на страницах товаров / услуг / статей и в случаях, когда на сайте настроена автоматическая генерация мета-тегов.

Проверка наличия и корректности Canonical

Для избежания возникновения дублей страниц рекомендуется на всех страницах размещать атрибут Canonical с указанием канонической (основной) страницы. Атрибут rel=canonical тега <link> указывает поисковым системам, что некоторые страницы могут быть одинаковыми, несмотря на разные URL-адреса (например, страницы пагинации).

Наличие данного атрибута не является фактором ранжирования, но в некоторых случаях может положительно сказаться на индексации сайта и избежать возникновения дублей страниц, например когда в URL добавляются GET-параметры (рекламные метки, сортировка и т.п.).

Для того, чтобы проверить на каких страницах размещен данный атрибут и корректно ли указаны ссылки, необходимо справа выбрать вкладку «Canonicals» — «All». Во вкладке «Missing» можно посмотреть список страниц, где данный атрибут отсутствует.

Поиск пустых или малоинформативных страниц

Наличие пустых или малоинформативных страниц может негативно сказаться на ранжировании сайта. Чаще всего такие страницы исключаются из индекса поисковых систем. Такие страницы рекомендуется удалять или дорабатывать таким образом, чтобы страница полностью отвечала на вопросы пользователя.

Для поиска пустых или малоинформативных страниц необходимо справа выбрать вкладку «Crawl Dara» — «Internal» — «All».

Через форму поиска следует отфильтровать страницы с контентом.

Далее необходимо в поле со списком страниц найти столбец «Word Count», отсортировать список страниц по убыванию количества слов и уже вручную проверить страницы с низким количеством слов в тексте страниц.

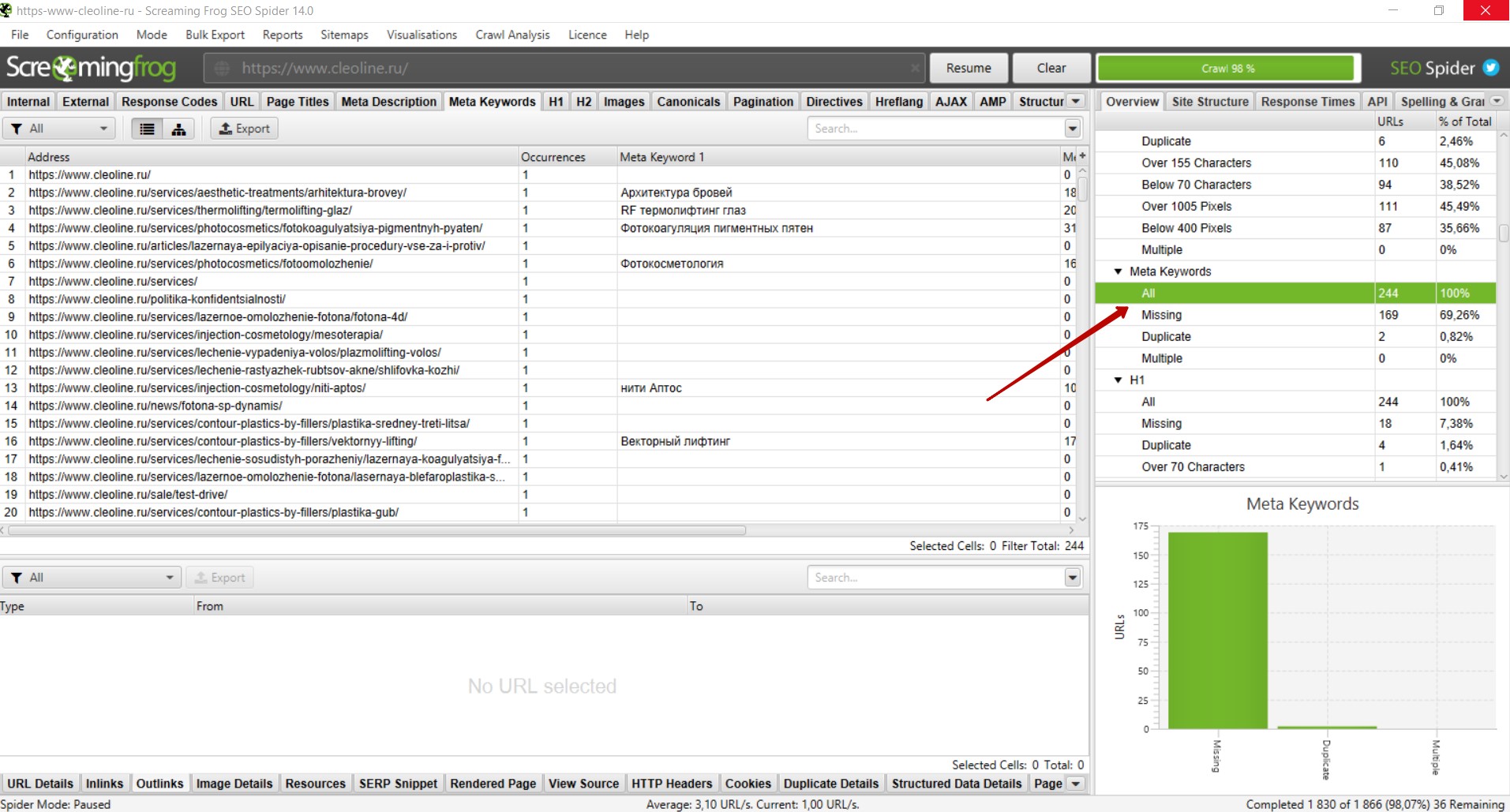

Спамный тег Keywords

Тег Keywords давно не учитывается поисковыми системами как фактор ранжирования и не оказывает положительного влияния. Однако при наличии на сайте спамных текстов и мета-тегов данный тег может стать одним из сигналов, что страница продвигается неестественными способами.

Для избежания таких ситуаций, мы рекомендуем удалять теги Keywords со всех страниц сайта.

Чтобы найти страницы, где размещен данный тег, необходимо справа выбрать вкладку «Meta Keywords» — «Missing», и вы увидите список страниц, где присутствует данный тег.

Анализ изображений

Изображения на сайте очень важны для продвижения и правильная оптимизация изображений может положительно сказаться на ранжировании сайтов и принести дополнительный трафик, например с поиска по картинкам.

Чтобы приступить к анализу изображений, следует перейти справа во вкладку «Crawl Data» — «Internal» — «Images». Вы увидите список ссылок на изображения. Необходимо проверить код ответа сервера в столбце «Status Code» — все ссылки должны отдавать 200 код ответа. Битые изображения следует удалить либо заменить на существующие. Если закрыты служебные папки, изображения рекомендуем открывать в файле robots.txt , чтобы они индексировались поисковыми системами.

Следует также проверить вес изображений в столбце «Size». Изображения с весом более 3 мб рекомендуем сжимать, чтобы они не замедляли скорость загрузки страниц.

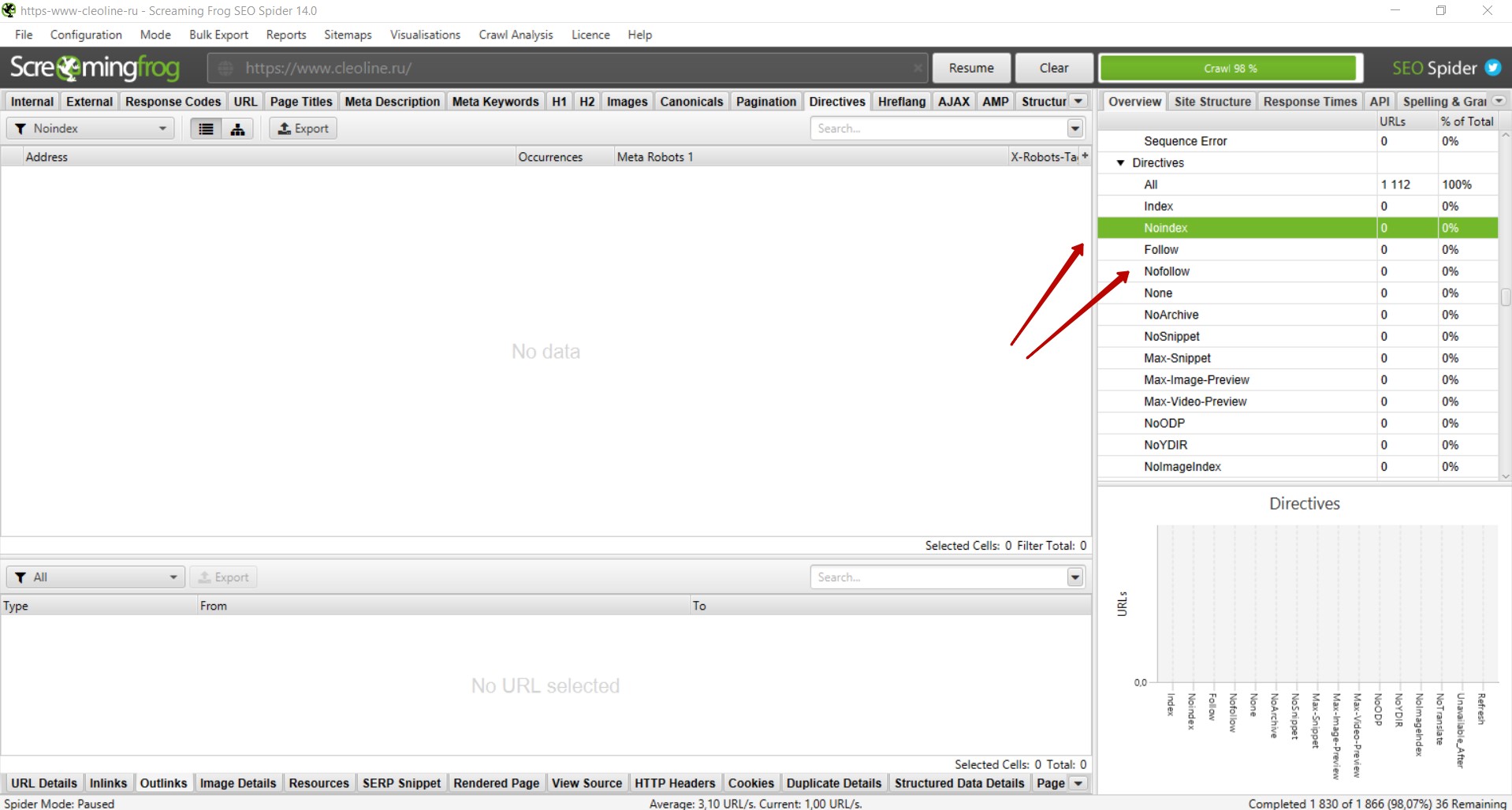

Анализ тегов Noindex и Nofollow

На некоторых страницах могут быть размещены теги «noindex», «nofollow». Чаще всего с помощью таких тегов намеренно закрывают страницы, которые не должны индексироваться. Однако некоторые теги могут быть размещены на страницах сайта ошибочно, в результате чего нужные страницы не попадут в индекс и не будут приносить трафик.

Поэтому рекомендуем проверять наличие данных тегов на страницах сайта. Для этого необходимо справа выбрать вкладку «Directives» — «noindex» и «nofollow» и проверить, не размещены ли данные теги на нужных для продвижения страницах. При наличии таких тегов на важных страницах рекомендуем убрать их из кода, чтобы страницы индексировались поисковыми системами.

Извлечение элементов со страниц сайта

Иногда возникает потребность извлечь какой либо элемент со страниц сайта. Например, подзаголовки, цены, названия каких-то определенных блоков и т.д.

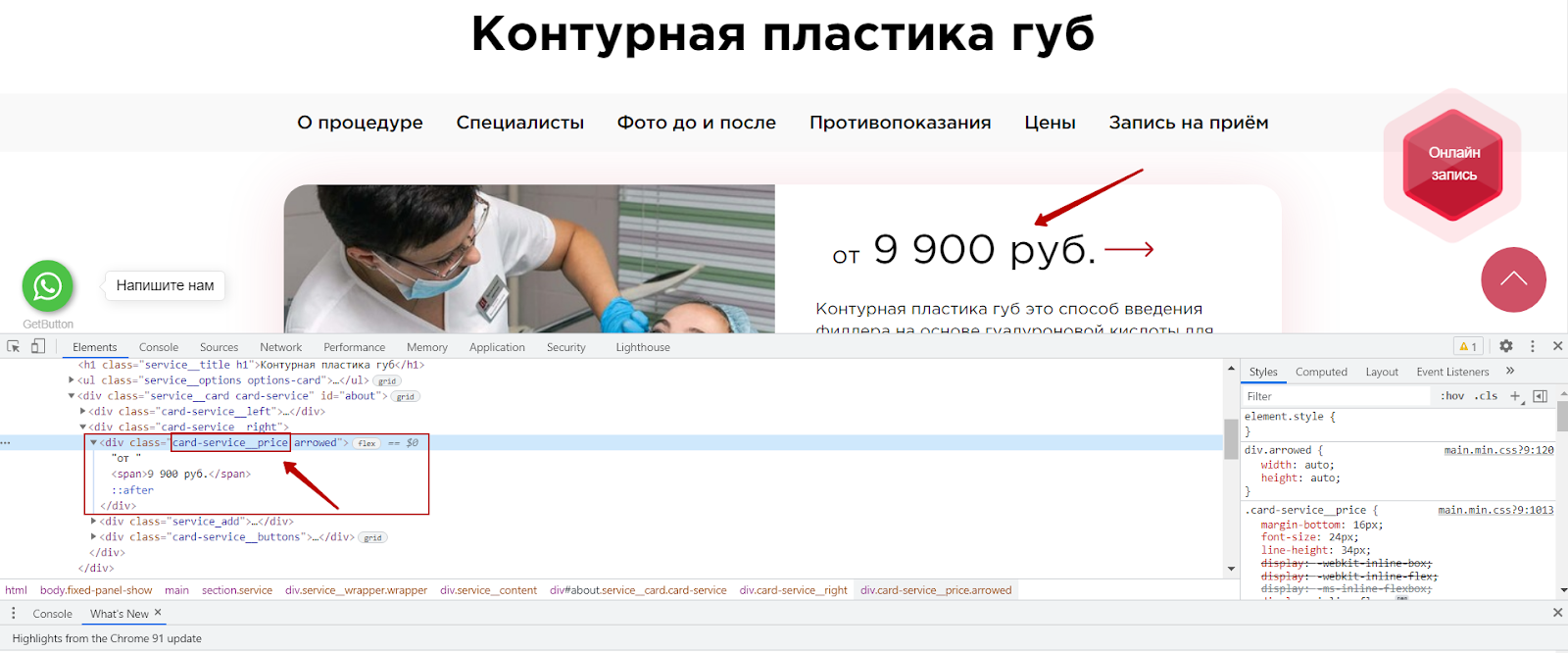

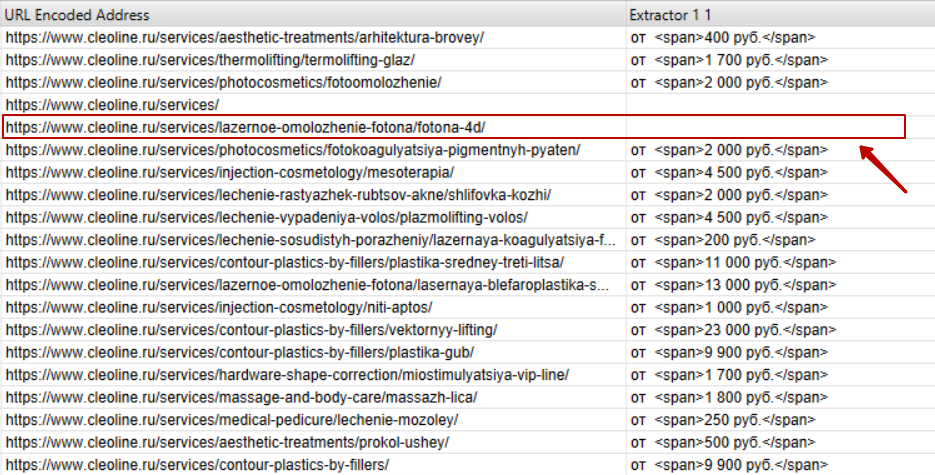

В случае с нашим клиентом мы обнаружили, что на некоторых страницах отсутствуют цены. Наличие цены на коммерческих страницах является одним из факторов ранжирования, в связи с чем мы подготовили рекомендацию о необходимости разместить цену на всех страницах сайта. Чтобы подготовить список страниц, где отсутствует цена, мы воспользовались функцией Custom Extraction.

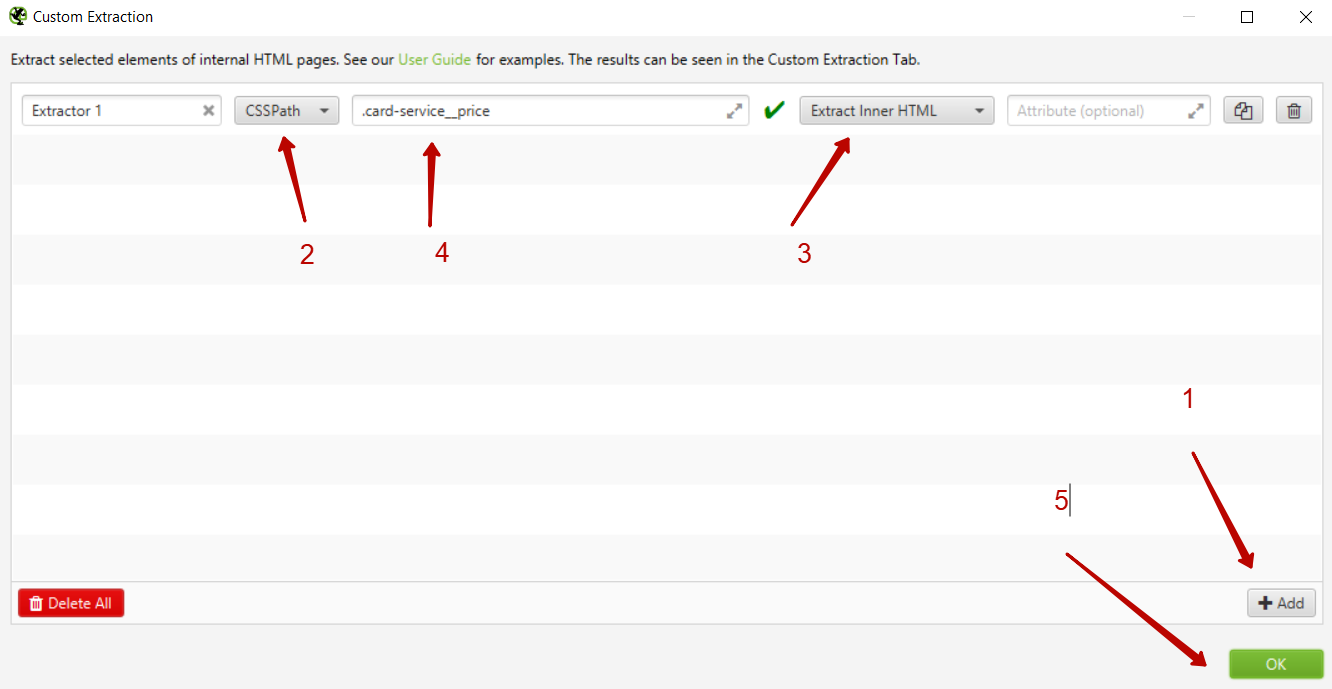

Как это сделать?

Для начала необходимо определить, где находится нужный элемент на странице сайта, и скопировать стиль данного элемента.

В интерфейсе Screaming Frog необходимо выбрать вкладку Configuration — Custom — Extraction.

Далее необходимо добавить новый элемент, нажав на кнопку add, и выбрать способ извлечения — CSSPath и что извлекаем — Extract Inner HTML. Далее указываем CSS стиль элемента, который ранее мы скопировали из кода сайта и ставим перед названием стиля точку.

После этого запускаем парсинг.

Нас интересуют только страницы услуг, поэтому необходимо отфильтровать только страницы раздела /services/, где размещены ссылки на страницы услуг. И мы получаем список извлеченных страниц и элементов и можем найти страницы, где отсутствует цена.

Функционал Custom Extraction довольно сложен, мы привели лишь небольшой пример, как с его помощью можно извлечь элементы страницы. Если вам будет интересно, мы можем рассказать о возможностях этой функции более подробно в следующей статье.

Выводы

Мы рассмотрели основные моменты, которые необходимо всегда проверять при проведении технического SEO-аудита в программе Screaming Frog. Многие технические проблемы / недочеты могут не оказывать прямого влияния на ранжирование сайта, однако в совокупности большое количество технических ошибок может значительно затруднить поисковое продвижение.

Обращаем внимание, что технический анализ должен проводиться не только через Screaming Frog, но и с помощью других инструментов, например Яндекс.Вебмастер и Google Search Console.

Мы рекомендуем не останавливаться на одной технической проверке и проводить такой анализ раз в 1-3 месяца, в зависимости от обновления страниц сайта.

Стоит учитывать, что устранение технических недочетов не гарантирует улучшение позиций и рост поискового трафика. Для увеличения видимости сайта в поисковых системах необходима комплексная доработка технической составляющей сайта, коммерческих факторов, работа с текстами и мета-тегами, структурой сайта, ссылочным окружением и другими факторами.

Если у вас остались какие-либо вопросы, — готовы ответить на них в комментариях.

А если вопросов будет много, подробнее раскроем их уже в следующих статьях.

Битая ссылка — неработающая, ведет на несуществующую страницу на сайте. При переходе по такой посетитель увидит сообщение об ошибке. (Говоря техническим языком, сервер отправит код ответа 404 «Not found».)

Битые ссылки могут появиться из-за банальной ошибки при написании, а также страниц, которые раньше существовали, а потом были удалены или перенесены.

Главная проблема в том, что битые ссылки ухудшают поведенческие факторы сайта, влияющие на успех SEO-продвижения. Потому что не все посетители настойчивые и терпеливые: многие могут просто уйти, если возникают сложности с навигацией. К тому же избыток broken links — риск попасть под один из фильтров Google.

Рассказываем о 11 способах найти нерабочие ссылки на сайтах. Дальше дело будет за малым: останется вручную поправить их через панель управления или настроить 301 редирект.

Вебмастеры Яндекса и Google

В отчетах обоих этих официальных инструментов можно увидеть, сколько на сайте сломанных ссылок и где они находятся.

В Google Search Console: «Индекс» → «Покрытие» → «Ошибка 404». В Яндекс.Вебмастере: «Индексирование» → «Статистика обхода», а также «Ссылки» → «Внутренние ссылки».

Естественно, этот способ проверки работает, только если есть права доступа к сайту. Чужой ресурс не получится проанализировать таким образом.

Читайте также: 26 полезных функций «Яндекс.Вебмастера»

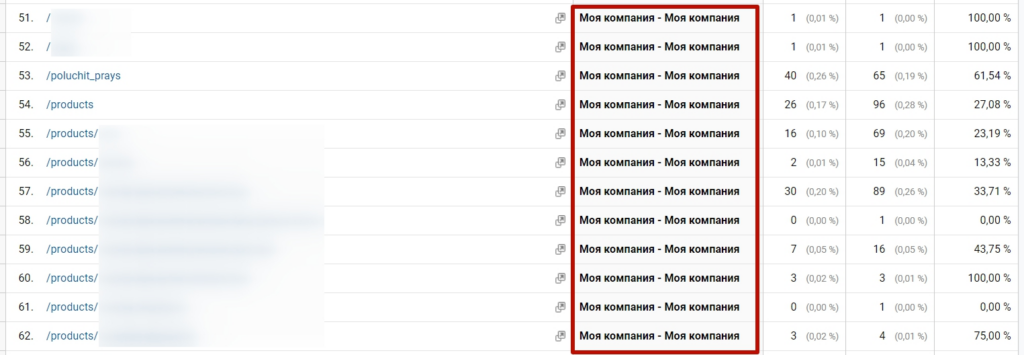

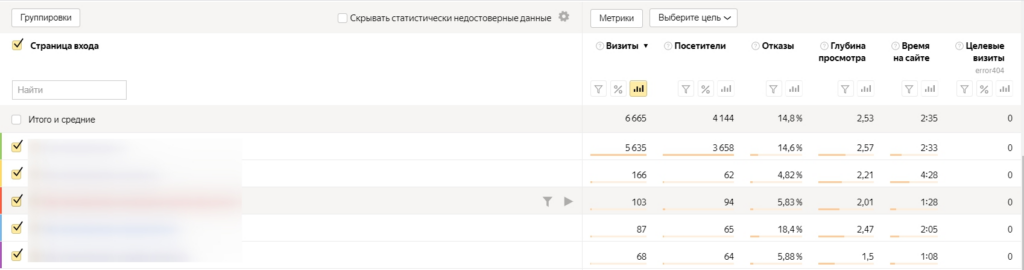

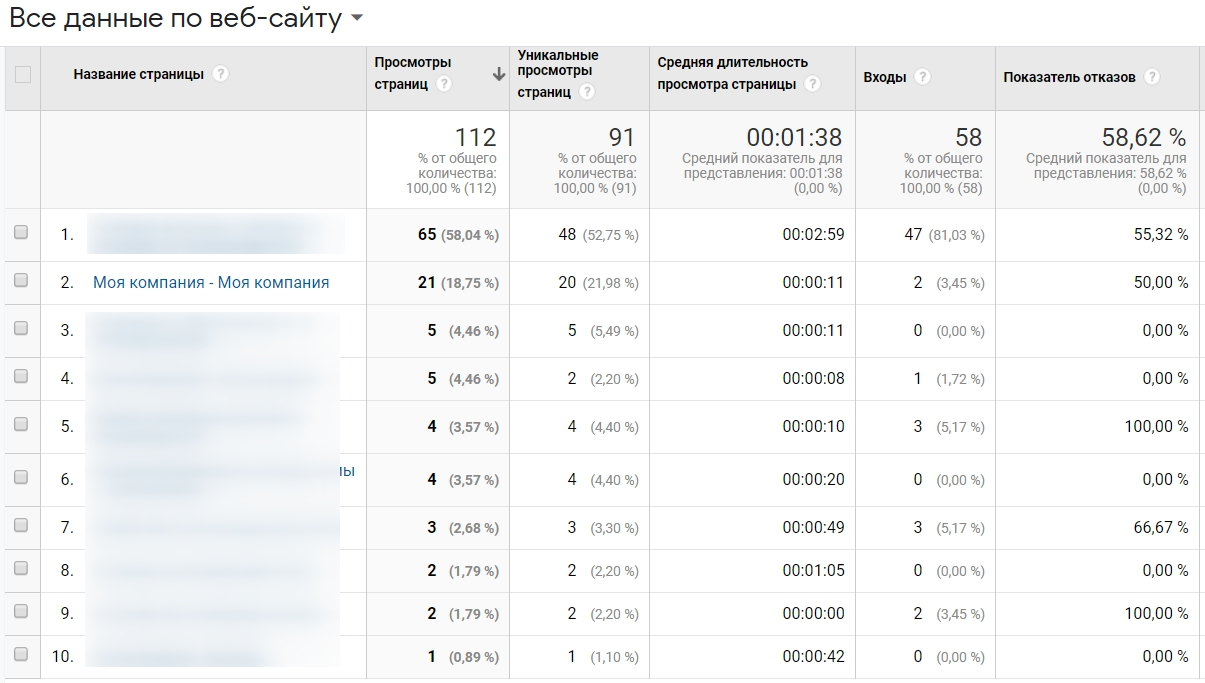

Системы веб-аналитики

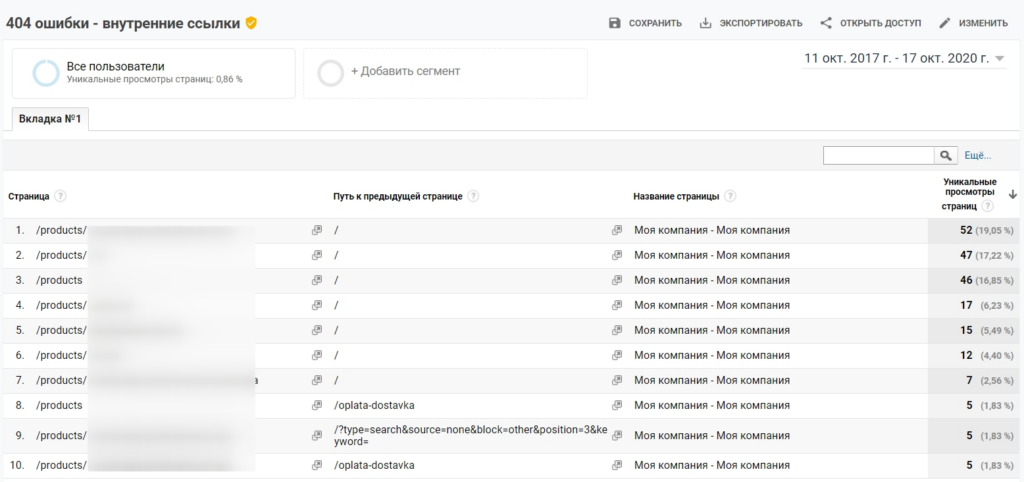

Самые популярные счетчики веб-аналитики тоже могут помочь обнаружить проблемы с работоспособностью ссылок.

Само по себе количество ошибочных переходов (на страницу 404) можно увидеть в отчетах:

- Яндекс.Метрики: «Содержание» → «Заголовки страниц».

- Google Analytics: «Поведение» → «Контент сайта» → «Все страницы» (выбрать параметр «Название страницы»).

Важно: при условии, что 404-страница имеет отличный от других title. Еще она, скорее, будет выделяться и в отчетах «Страницы выхода». Там как раз можно увидеть, насколько битые ссылки ухудшают юзабилити сайта.

Кстати, с помощью Click.ru вы можете спарсить метатеги и заголовки с любого сайта. Первые 500 запросов — бесплатно. Дальше от 0,04 р. за запрос.

Отследить, где именно находится битая ссылка, немного сложнее. В Яндекс.Метрике для этого нужно:

1. Создать цель JavaScript-событие с идентификатором типа «error404», название сделать таким же.

2. Добавить в код страницы (XXXXXX — номер счетчика):

<script>

window.onload = function (){

ym(XXXXXX, 'reachGoal', 'error404');

}

</script>

3. Отслеживать в отчетах достижения этой цели по параметру «Страница входа».

В Google Analytics можно сделать похожим образом, с помощью событий, или настроить специальный отчет (для этого проще взять шаблон Якова Осипенкова).

Эти фильтры Google Analytics тоже работают только в том случае, если 404-страница имеет уникальный заголовок (title).

Читайте также: 20+ ресурсов для обучения веб-аналитике: блоги, курсы, каналы, сообщества, рассылки

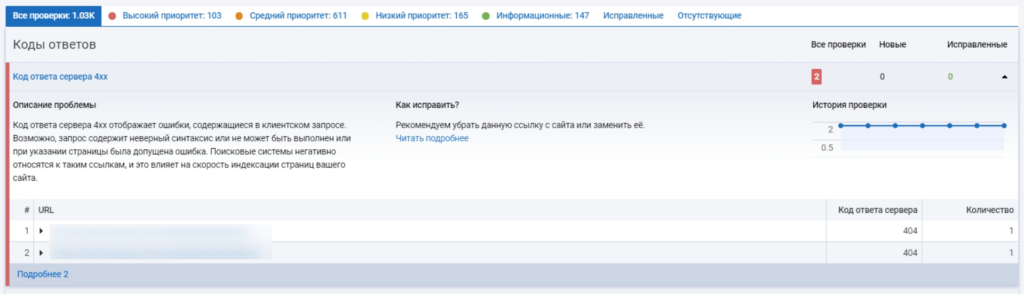

Сервисы комплексного SEO-анализа

Другой способ проверить сайт на битые ссылки — воспользоваться одним из сервисов для SEO-аудита.

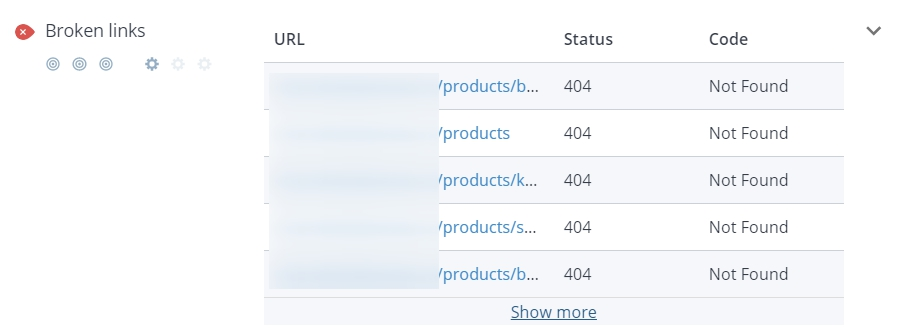

Netpeak Spider предлагает найти не только broken links, но и дубли метатегов; проверить код сервера сервера, структуру сайта, редиректы, индексацию и др. Мощная фича: встроенный парсер для извлечения данных с различных ресурсов. Подписка стоит от 15 $ в месяц, есть бесплатный тариф.

Serpstat анализирует и битые ссылки, и битые картинки. И много чего еще делает: мониторит ссылочную массу, показывает ошибки в заголовках и метатегах, показывает позиции сайта в поисковиках и т. д. Подписка стоит от 55 $ в месяц, есть демо-доступ.

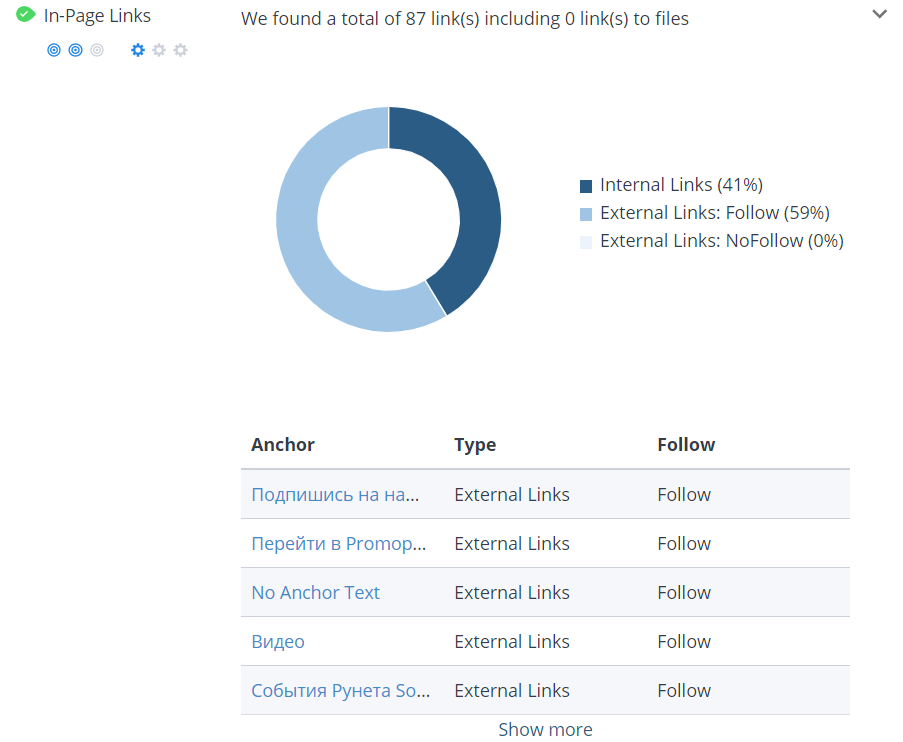

Screaming Frog SEO Spider сканирует сайт и находит нерабочие ссылки, дубли, ошибки в метаданных, показывает структуру, анализирует редиректы, директивы и др. Лицензия на программу стоит 149 евро в год, однако поиск битых ссылок есть и в бесплатной версии.

Обзор 10 версии Screaming Frog

SEO Analysis & Website Review by WooRank отображает тайтл, дескрипшн и сниппет в Google, проверяет валидность Sitemap, мобильность, юзабилити, структурированные данные — и, конечно, битые ссылки тоже. Это расширение для Chrome, и оно бесплатное. (Правда, в отличие от других, подойдет только для небольших сайтов, так как надо анализировать постранично, вручную).

Кстати, анализ битых ссылок может входить в функционал сервисов автоматизации рекламы и сквозной аналитики. Например, такая возможность есть у Alytics, Marilyn.

Специализированные инструменты

Вебмастерские, системы веб-аналитики, сервисы комплексного SEO-аудита не подходят — есть более узкие инструменты, заточенные чисто под поиск битых ссылок.

Xenu’s Link Sleuth — старая-добрая программа, проверяет сайты на наличие «сломанных» ссылок. Впрочем проверяет не только ссылки, но и изображения, фреймы, плагины, скрипты. Инструмент полностью бесплатный.

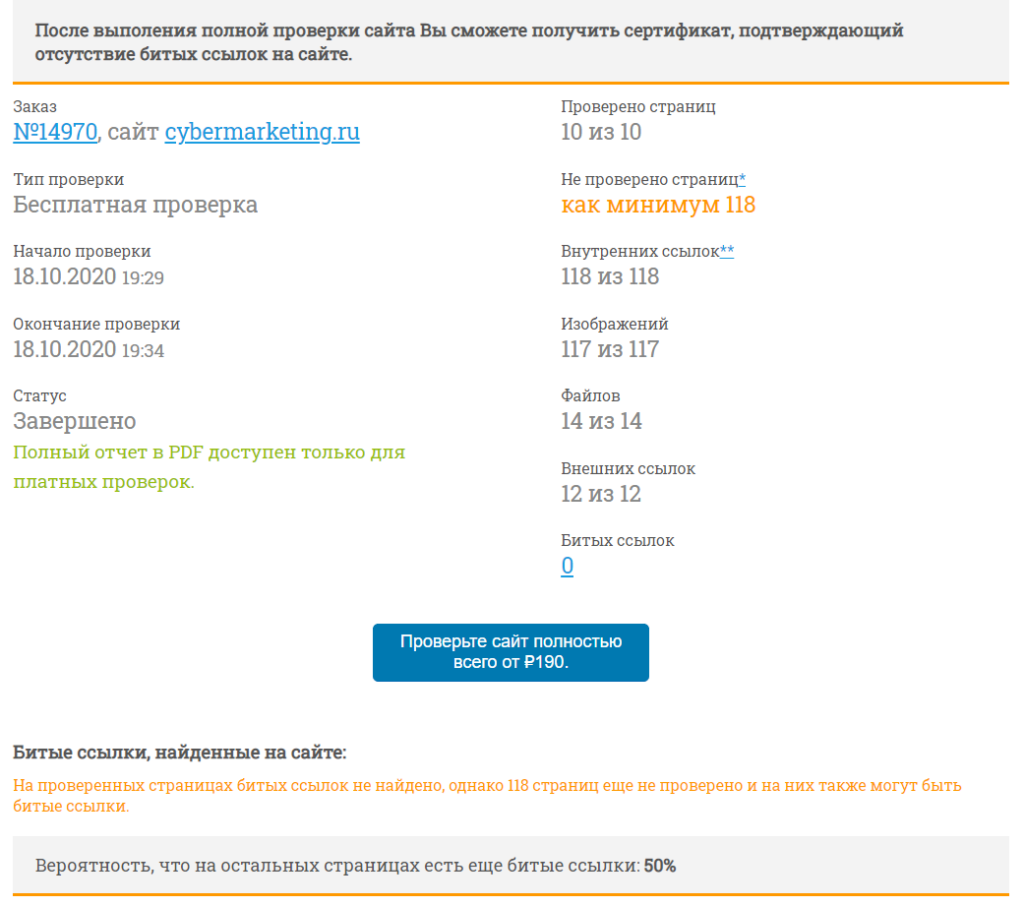

Badlinks — онлайн-сервис, который предлагает как разовую, так и регулярную проверку «плохих» ссылок на сайте. Разовая стоит от 50 рублей, регулярная — от 250 рублей в год. Стоимость сильно варьируется, так как зависит от частоты анализа и размера сайта. Бесплатный поиск ограничен 10 страницами.

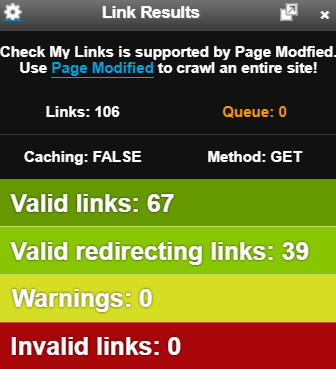

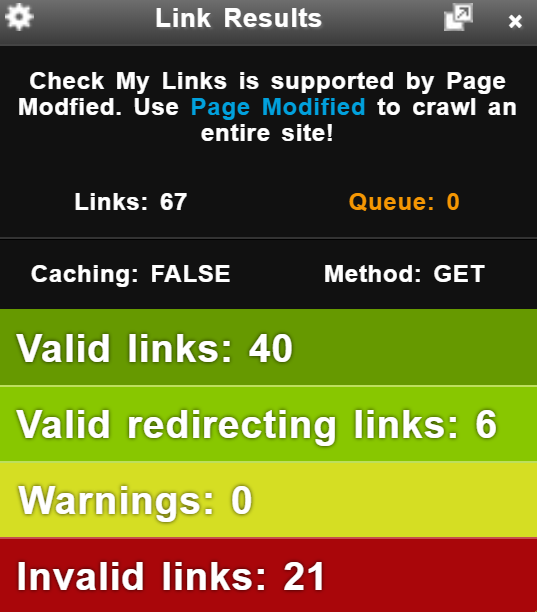

Check My Links — расширение Chrome для поиска нерабочих ссылок на странице. Есть возможность скопировать весь список в буфер обмена, не учитывать ссылки на определенные домены, включить отслеживание nofollow. Инструмент абсолютно бесплатный.

Если работаете с Google Ads, обратите внимание на скрипт, который сканирует все посадочные страницы и сообщает о битых ссылках на почту. О других скриптах и том, как с ними работать, — в блоге Click.ru.

Читайте также: 35+ ресурсов для обучения SEO и развития в профессии

#Руководства

- 6 фев 2020

-

11

Чем опасны битые ссылки на сайте, как их искать и что делать дальше

Едете до указанного адреса, а там… пустой офис, гараж или вообще будка с трансформатором. Обидно? Ещё как. Вот с битыми ссылками примерно так же.

vlada_maestro / shutterstock

Пишущий интернет-маркетолог, автор-фрилансер. Помогает развивать и продвигать блоги, делает контент для внешних площадок. Пишет об интернет-маркетинге, реже о финансах и бизнесе.

Битая ссылка (broken link) — ссылка, которая ведёт на несуществующую страницу. При переходе по ней пользователь видит сообщение об ошибке. Например, такое:

Ошибка 404 или Not Found — стандартный код ответа сервера. Он сообщает, что по заданному адресу HTML-страницы не существует, запрошенные данные найти не удаётся.

В процессе продвижения сайта приходится постоянно вносить изменения: удалять устаревшие статьи, объединять разделы в интернет-магазине, переименовывать URL. И чем сложнее ресурс, тем легче что-то забыть и допустить ошибки.

Например, страница имела адрес «site.ru/page123», а получила «site.ru/price-list». При этом не было настроено перенаправление с первого URL на второй. Значит, все ссылки, ведущие на «site.ru/page123», станут битыми. При попытке перехода по ним пользователь увидит в браузере ошибку 404.

Broken links появляются также в результате банальных опечаток. Копирайтер при написании статьи может случайно вставить в текст ссылки лишний символ, что тоже сделает её нерабочей. Сервер не догадается интуитивно, что «site.ru/statya-» — это вроде похоже на «site.ru/statya» и, значит, можно открыть её.

В общем, битые ссылки — не проделки хакеров или злых конкурентов, а вполне естественное явление.

Битые ссылки, скорее всего, ухудшают продвижение в поисковых системах. Для поисковых роботов они могут быть признаком некачественного, неудобного для пользователей, устаревшего ресурса. Правда, пока нет подтверждённых данных, что битые ссылки напрямую влияют на ранжирование.

Ещё некоторые специалисты считают, что такие ссылки расходуют краулинговый бюджет. Проще говоря, это лимиты по количеству URL вашего сайта, которые сканирует поисковый робот Google. Однако представитель компании Джон Мюллер говорил, что ошибки 404 не снижают этот бюджет и не ухудшают рейтинг всего сайта.

Тем не менее битые ссылки однозначно влияют на поведение на сайте. Допустим, пользователь хочет почитать статью, кликает и видит ошибку. Он может вернуться назад, воспользоваться меню или поиском по сайту — а может просто уйти.

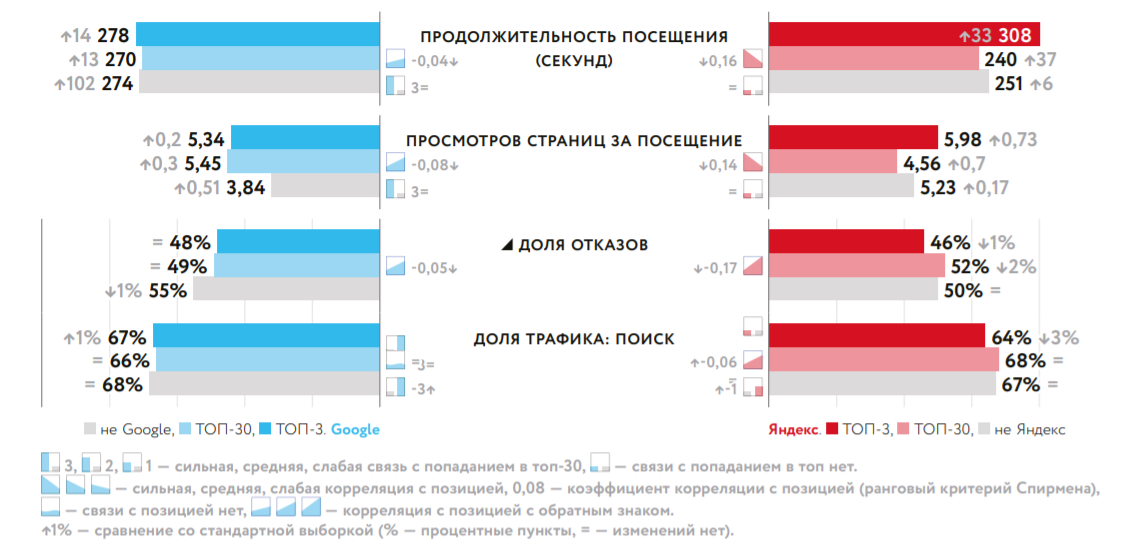

А вот поведенческие показатели (отказы, количество просмотров страниц, продолжительность посещения) уже играют значительную роль в SEO. Исследование компании «Ашманов и партнёры» показывает корреляцию с топом или позициями и в Google, и в Яндексе.

Получается, самая главная опасность битых ссылок в том, что они ухудшают пользовательский опыт. Затрудняют потребление контента, изучение товаров/услуг и выполнение целевых действий. А это важно при любом, не только поисковом трафике.

Если сайт с большим количеством страниц, невозможно вручную проверять каждую и кликать по всем имеющимся ссылкам. Для поиска лучше использовать специальные инструменты. Это можно сделать с помощью официальных вебмастеров:

- Google Search Console. В старом интерфейсе ошибочные ссылки показывались в отчёте «Ошибки сканирования». В новом — в разделе «Покрытие».

- Яндекс.Вебмастер. Данные лежат в разделе «Индексирование» → «Статистика обхода». Ещё можно посмотреть в разделе «Ссылки».

Ещё битые ссылки видны в отчётах по заголовкам страниц в Яндекс.Метрике и Google Analytics. Если, конечно, у 404-страницы title отличается от других. На скриншоте ниже — статистика по сайту на одном из конструкторов. Переходы по битым ссылкам выдают заголовок страницы по умолчанию.

Если хотите быть на «ты» с инструментами вебмастеров и системами веб-аналитики, приглашаем на онлайн-курс «SEO-специалист с нуля до PRO». Подходит новичкам в поисковом продвижении, интернет-маркетологам, владельцам бизнеса.

Также можно выбрать для проверки один из сторонних инструментов SEO-аудита. Например:

- Xenu Link Sleuth. Это бесплатная десктопная программа, достаточно функциональная, хоть и немного устаревшая.

- Screaming Frog SEO Spider. Платная десктопная программа. Проверка 500 URL бесплатно.

- SEO & Website Analysis. Бесплатный и удобный плагин для Chrome.

- Check My Links. Ещё один бесплатный плагин для Google Chrome. Можно скопировать список битых ссылок в CSV-формате.

- Badlinks.ru. Платный онлайн-сервис. Стоит от 50 рублей, сумма зависит от количества страниц и регулярности проверки.

Ссылки, ведущие на несуществующие страницы, можно просто удалить. Если в тексте опечатка, то нужно внести правки. Это легко сделать самому через панель управления сайтом или делегировать тому, кто отвечает за наполнение и редактирование контента, — вебмастеру, контент-менеджеру или верстальщику.

Когда битые ссылки возникают в результате массовой смены URL (например, блог переехал с «site.ru/blog» на «blog.site.ru»), нет смысла исправлять вручную — нужно настроить редирект. Это сложная техническая задача, с которой лучше обратиться к опытному разработчику или веб-программисту. Если всё же хочется уметь делать редиректы своими руками, действуйте по гайду TexTerra или Promopult.

Но даже если на сайте не будет битых ссылок, пользователи всё равно будут видеть код ответа 404. Написать URL с ошибкой могут и в соцсетях, и на сторонних ресурсах. И всегда есть вероятность, что пользователь опечатается, когда захочет напрямую зайти на ваш сайт. Чтобы уменьшить процент отказов и негатив в таких случаях, лучше оформить страницу 404 нестандартно. Дайте задание копирайтеру и дизайнеру, а разработчика попросите настроить переадресацию.

Научитесь: Интернет-маркетолог с нуля

Узнать больше

05 мая 2023

Одной из главных задач, которую выполняет сайт, является предоставление быстрого доступа к данным о конкретной компании, услуге, товаре и пр. Пользователи интернета переходят по ссылкам, надеясь получить нужную им информацию, и раздражаются, когда вместо этого видят ошибку 404 и надпись «Страница не найдена». Битые ссылки (broken links) не только злят человека, но и вынуждают его тут же закрыть вкладку, а это ухудшает поведенческие факторы и негативно сказывается на рейтинге сайта в поисковых системах. Исправление неработающих гиперссылок — важный шаг для улучшения пользовательского опыта. О том, что такое битая ссылка, а также как найти и исправить битые ссылки на веб-ресурсе, читайте в статье.

Что такое битые ссылки

Битой, а также сломанной или нерабочей, называется ссылка, которая ведет в никуда. Например, на несуществующую или сменившую адрес веб-страницу. Когда пользователь кликает по такой ссылке, то вместо перехода на целевую страницу он получает сообщение «Error 404 Not Found» или его браузер вовсе не может найти сайт.

Нерабочие гиперссылки возникают по многим причинам. Обычно это результат невнимательности веб-мастера: он может удалить, переименовать, переместить или изменить страницу так, что ее новый URL больше не будет соответствовать старому, но при этом забыть поменять адреса ссылок, которые раньше на нее вели. В итоге правильная и актуальная ссылка становится битой, и ее нужно либо устранить, либо исправить.

Эта проблема вызывает разочарование и недовольство у пользователей, а кроме того битые ссылки отрицательно влияют на авторитет веб-ресурса в поисковиках, так как указывают на низкое качество и неактуальность контента. Именно поэтому каждый веб-мастер должен регулярно заниматься поиском и удалением сломанных линков.

Изображение Vectorarte от Freepik.

Как найти битые ссылки на сайте

Отыскать и убрать все нерабочие ссылки вручную довольно трудно даже на небольшом веб-проекте, что уж говорить о крупных интернет-магазинах, корпоративных порталах или новостных блогах. Чем больше страниц у сайта и чем тщательнее на нем настроена внутренняя перелинковка, тем выше вероятность появления 404-х ошибок и поломок ранее рабочих ссылок. Особенно хорошо это заметно после проведения работ по SEO оптимизации: изменения структуры и названий разделов, создания человекопонятных урлов (ЧПУ), удаления или перемещения нерелевантного/некачественного контента. Такие перемены «бьют» как внешние, так и внутренние линки, поэтому исправлять положение необходимо быстро.

Существуют специальные инструменты для веб-мастеров, которые проверят ваш сайт на наличие битых ссылок и укажут, на какие конкретно страницы стоит обратить внимание. О трех популярных сервисах расскажем ниже. Если вы используете CMS (например, WordPress), то помочь в этом вопросе также могут плагины.

№1. Screaming Frog SEO Spider

Платная программа для SEO-анализа с большим набором функций, в число которых входит и обнаружение битых гиперссылок. Screaming Frog почти мгновенно сканирует ресурс, выявляя ошибки и на стороне клиента (в частности, 404-е), и на стороне сервера. Она находит не только сам нерабочий link, но и URL, где есть на него переход. Одно из преимуществ этого приложения состоит в возможности выгрузить найденные ошибки в отдельный файл, чтобы исправлять их было проще.

У Screaming Frog имеется бесплатная версия, но в ней установлен лимит проверки на 500 URL. Если у вас меньше страниц, то для поиска сломанных ссылок этого инструмента будет вполне достаточно. Если нет, придется купить подписку ($259 в год).

Алгоритм работы достаточно прост:

- Установите программу на компьютер, откройте ее и введите в поисковую строку веб-адрес сайта. Нажмите «Start».

- После завершения анализа отсортируйте проверенные страницы по параметру «Status Code».

- Выделите все проблемные ссылки и выберите пункт «Inlinks» в нижней части интерфейса. В столбце «From» будут указаны адреса, на которых присутствуют битые ссылки, а в столбце «To» — адреса самих этих ссылок.

Вы можете исправить все самостоятельно или просто экспортировать файл с ошибками (кнопка «Export»), чтобы передать их своему веб-мастеру.

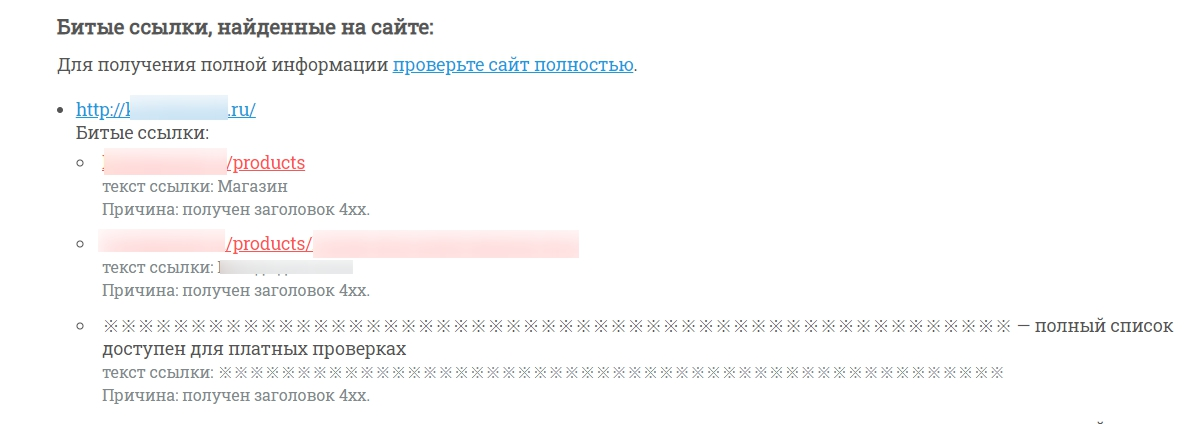

№2. Яндекс.Вебмастер

Отечественный онлайн-сервис для веб-аналитики. Вебмастер от Яндекса полностью бесплатен: чтобы пользоваться им, нужно лишь зарегистрировать в панели свой веб-сайт и подтвердить права на владение доменом. Сервис предоставляет обширный функционал для анализа качества и эффективности ресурса: здесь можно отслеживать индексирование страниц Яндексом, просматривать статистику запросов, проводить диагностику безопасности, видеть показатели качества и, конечно, мониторить внутренние и внешние ссылки. С недавних пор в панели появилась даже отдельная вкладка для отслеживания битых линков.

Откройте интерфейс, выберите пункт «Ссылки» в боковом меню и перейдите в «Неработающие ссылки». На экране появится список всех сломанных ссылок. Вы увидите их количество, коды ответа сервера, а также откуда и куда они ведут. Останется только всё исправить.

№3. Google Search Console

GSC — аналогичный Вебмастеру инструмент, только для системы Google. Это бесплатный онлайн-сервис, который помогает следить за производительностью веб-сайта и его продвижением в поисковой выдаче. Для использования консоли также потребуется регистрация сайта и подтверждение права на домен.

Чтобы найти битые ссылки с помощью GSC, войдите в аккаунт и откройте панель своего ресурса. В боковом меню выберите вкладку «Индексирование» и нажмите «Страницы». В рабочей области отобразится график с соотношением проиндексированных веб-страниц и непроиндексированных. Ниже вы увидите таблицу, в которой будут перечислены причины неудавшегося сканирования. Среди них могут присутствовать строчки «Не найдено (404)» или «Ошибка 404». Кликните по ним, чтобы увидеть список неработающих линков. К сожалению, Google не показывает, где именно расположена сломанная ссылка, так что исправить ее в источнике не получится.

Как удалить битые ссылки

Когда вы обнаружили неработающие линки, полдела уже сделано. Но теперь их необходимо исправить: убрать, заменить, скорректировать. Способ исправления будет зависеть от причины, по которой эта ссылка возникла. Существует несколько возможных вариантов.

Коррекция опечаток

Человеческий фактор по-прежнему остается причиной многих проблем при работе над сайтом. Нередко битые ссылки становятся результатом банальной опечатки: достаточно изменить, добавить или удалить один символ, чтобы URL сломался и перестал работать. К счастью, исправить эту оплошность тоже нетрудно.

Если некорректный адрес указали вы сами (внутри своего ресурса или на внешней площадке), то просто замените его на корректный. В случае, когда опечатку допускают ваши посетители (например, при ручном наборе URL), скорректировать ее, конечно, не удастся. Однако имеет смысл настроить перенаправление с ошибочного веб-адреса на правильный, если пользователи часто делают одну и ту же опечатку.

Настройка редиректа

Этот способ касается гиперссылок на те страницы, которые были удалены, перемещены на другой адрес или стали недоступны по какой-то другой причине. В таком случае вам не придется менять сами ссылки — достаточно будет настроить автоматическую переадресацию в файле .htaccess. Как это работает? Человек переходит по сломанному линку, т. е. запрашивает у вашего сервера некорректный URL страницы, но тот вместо ошибки выдает пользователю искомый или похожий документ по правильному адресу.

Редиректы могут быть временными (302) или постоянными (301). Если вы не планируете возвращать удаленную страницу или вводить в эксплуатацию сломанный линк, рекомендуем использовать постоянное перенаправление. Настройкой редиректов можно заняться вручную, применить плагины или обратиться за помощью к специалистам на стороне.

Исправление на чужих сайтах

Разобраться с линками, к которым у вас есть доступ, достаточно просто. Но вот исправить битые ссылки на внешних площадках уже труднее, поскольку вы не можете напрямую влиять на содержание чужого ресурса. Если вы столкнулись с проблемой внешних битых гиперссылок, свяжитесь с владельцем веб-сайта и попросите исправить сломанный линк. В случае отказа или отсутствия ответа варианты действий следующие:

- Сделать редирект на рабочую страницу. Подойдет, если в линке допущена опечатка или указан старый адрес.

- Настроить перенаправление на похожую страницу. Для ситуаций, когда контент уже неактуален, а трафик на него еще идет.

- Восстановить удаленную страницу.

Если ни один из методов не подходит, то постарайтесь оформить экран с ошибкой 404 таким образом, чтобы он не пугал пользователя, объяснял ему проблему и давал возможность перейти на другие веб-страницы вашего ресурса. К слову, заняться оформлением 404 страницы полезно в любом случае.

Изображение от vectorjuice на Freepik.

Заключение

Битые ссылки — распространенная проблема, которая негативно влияет на пользовательский опыт и рейтинг веб-сайта в поиске. В процессе продвижения части проекта могут удаляться, менять названия, переноситься и т. п., но чтобы это не приносило вреда, важно вовремя находить и исправлять возникающие ошибки.