Если страница (файл) уже удалена[править]

Если нужная вам веб-страница была по какой-либо причине удалена, попробуйте найти в Интернете зеркало сайта, на котором она была расположена.

Зеркало веб-сайта — это точная копия этого сайта, которая находится на другом сервере в Интернете. Если вы ищете удалённый файл, попробуйте найти зеркало страницы, на которой находилась ссылка на него. Может быть, на странице-зеркале ссылка будет изменена и файл, в отличие от оригинального, не будет удалён.

Найти зеркало веб-сайта очень просто: надо ввести известную часть текста одной из его страниц в качестве запроса поисковой системе. Если текст на страницах сайта вам совершенно незнаком, укажите имя страницы или файла, путь к которым вы знаете. Например, если вы не нашли страницу http://www.example.com/biology/human_body.html, зайдите на сайт одной из поисковых машин и введите запрос human_body.html. Если сама страница-зеркало и не будет найдена, возможно, отыщется веб-страница со ссылкой на неё.

Один из способ получить доступ к содержимому уже удалённой веб-страницы — воспользоваться функцией Восстановить текст «Рамблера» или схожей функцией Сохранено в кэше поисковой системы Google. Если в этих поисковых системах нужная вам страница не была сохранена, придётся обратиться к так называемому архиву Интернета.

Архив Интернета ( http://www.archive.org/ ) — глобальная программа. Была основанная в 1996 году в американском городе Сан-Франциско. Один из её подпроектов, The Wayback Machine (в переводе с англ. — «Машина времени»), предназначен для хранения «снимков» Интернета различных временных промежутков. Сервер «Машины времени» с определённой периодичностью просматривает все страницы Сети, которые может найти, и сохраняет содержимое каждой из них. И даже если какие-нибудь страницы когда-нибудь будут удалены, мы сможетем ознакомиться с их прежним содержанием. То же происходит и с файлами: если тот или иной файл был удалён, остаётся вероятность, что нам удастся отыскать его резервную копию в архиве Интернета.

Для того,чтобы воспользоваться услугами «Машины времени», надо:

зайти на сайт http://web.archive.org/ ;

в поле, где уже заданы первые символы адреса удалённой страницы или файла, http://, введите адрес, нажмите клавишу Enter. Перед вами появится список дат, когда были сделаны «снимки» веб-страницы, которую вы ищите;

щелкнуть на определённой дате — откроется нужная вам страница с прежним содержанием.

«Машина времени» сохраняет далеко не все страницы и файлы, выложенные во Всемирную паутину, но шанс найти удалённую из Интернета информацию достаточно велик.

Достаём потерянные статьи из сетевых хранилищ

Время на прочтение

4 мин

Количество просмотров 299K

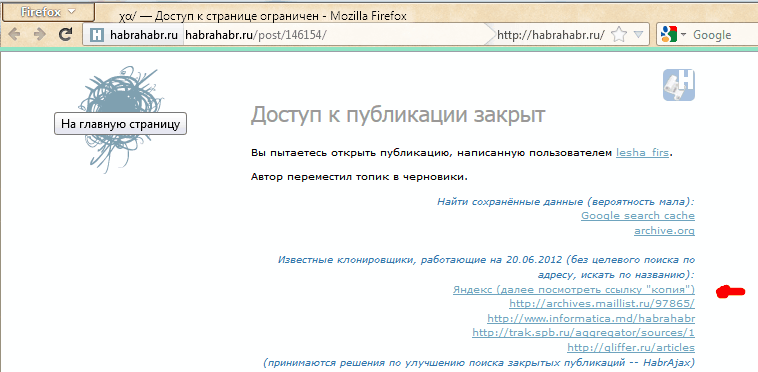

Решение рассматривается (пока) только для одного сайта — того, на котором мы находимся. Идея появилась в результате того, что один пользователь сделал юзерскрипт, который переадресует страницу на кеш Гугла, если вместо статьи видим «Доступ к публикации закрыт». Понятно, что это решение будет работать лишь частично, но полного решения пока не существует. Можно повысить вероятность нахождения копии выбором результата из нескольких сервисов. Этим стал заниматься скрипт HabrAjax (наряду с 3 десятками других функций). Теперь (с версии 0.859), если пользователь увидел полупустую страницу, с которой можно перейти лишь на главную, в личную страницу автора (если повезёт) и назад, юзерскрипт предоставляет несколько альтернативных ссылок, в которых можно попытаться найти потерю. И тут начинается самое интересное, потому что ни один сервис не заточен на качественное архивирование одного сайта.

Кстати, статья и исследования порождены интересным опросом А вас раздражает постоянное «Доступ к публикации закрыт»? и скриптом пользователя dotneter — комментарий habrahabr.ru/post/146070/#comment_4914947.

Требуется, конечно, более качественный сервис, поэтому, кроме описания нынешней скромной функциональности (вероятность найти в Гугл-кеше и на нескольких сайтах-копировщиках), поднимем в статье краудсорсинговые вопросы — чтобы «всем миром» задачу порешать и прийти к качественному решению, тем более, что решение видится близким для тех, кто имеет сервис копирования контента. Но давайте обо всём по порядку, рассмотрим все предложенные на данный момент решения.

Кеш Гугла

В отличие от кеша Яндекса, к нему имеется прямой доступ по ссылке, не надо просить пользователя «затем нажать кнопку „копия“». Однако, все кеширователи, как и известный archive.org, имеют ряд ненужных особенностей.

1) они просто не успевают мгновенно и многократно копировать появившиеся ссылки. Хотя надо отдать должное, что к популярным сайтам обращение у них частое, и за 2 и более часов они кешируют новые страницы. Каждый в своё время.

2) далее, возникает такая смешная особенность, что они могут чуть позже закешировать пустую страницу, говорящую о том, что «доступ закрыт».

3) поэтому результат кеширования — как повезёт. Можно обойти все такие кеширующие ссылки, если очень надо, но и оттуда информацию стоит скопировать себе, потому что вскоре может пропасть или замениться «более актуальной» бессмысленной копией пустой страницы.

Кеш archive.org

Он работает на весь интернет с мощностями, меньшими, чем у поисковиков, поэтому обходит страницы какого-то далёкого русскоязычного сайта редко. Частоту можно увидеть здесь: wayback.archive.org/web/20120801000000*/http://habrahabr.ru

Да и цель сайта — запечатлеть фрагменты истории веба, а не все события на каждом сайте. Поэтому мы редко будем попадать на полезную информацию.

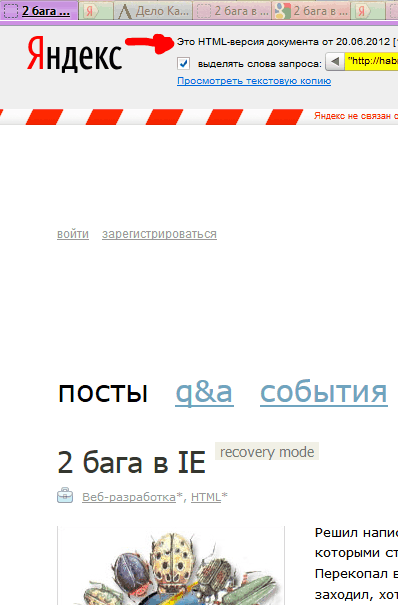

Кеш Яндекса

Нет прямой ссылки, поэтому нужно просить (самое простое) пользователя нажать на ссылку «копия» на странице поиска, на которой будет одна эта статья (если её Яндекс вообще успел увидеть).

Как показывает опыт, статья, повисевшая пару часов и закрытая автором, довольно успешно сохраняется в кешах поисковиков. Впоследствии, скорее всего, довольно быстро заменится на пустую. Всё это, конечно, не устроит пользователей веба, который по определению должен хранить попавшую в него информацию.

Yahoo Pipes

pipes.yahoo.com/pipes/search?q=habrahabr+full&x=0&y=0 и прочие.

Довольно интересное решение. Те, кто умеет их настраивать, возможно, полноценно решат задачу архивирования RSS. Из имеющегося, я не нашёл пайпов с поиском статьи по её номеру, поэтому пока нет прямой ссылки на такие сохранённые полные статьи. (Кто умеет с ним работать — прошу изготовить такую ссылку для скрипта.)

Многочисленные клонировщики

Все из них болеют тем, что не дают ссылки на статью по её номеру, не приводят полный текст статьи, а некоторые вообще ограничиваются «захабренным» или «настолько ленивы», что копируют редко (к примеру, раз в день), что актуально не всегда. Однако, если хотя бы один автор копировщика подкрутит движок на сохранение полноценного и актуального контента, он окажет неоценимую услугу интернету, и его сервис займёт главное место в скрипте HabrAjax.

Из живых я нашёл пока что 4, некоторые давно существовавшие (itgator) на данный момент не работали. В общем, пока что они почти бесполезны, потому что заставляют искать статью по названию или ключевым словам, а не по адресу, по которому пользователь пришёл на закрытую страницу (а по словам отлично ищет Яндекс и не только по одному их сайту). Приведены в скрипте для какой-нибудь полезной информации.

Задача

Перед сообществом стоит задача, не утруждая организаторов сайта, довести продукт до качественного, не теряющего информацию ресурса. Для этого, как правильно заметили в комментариях к опросу, нужен архиватор актуальных полноценных статей (и комментариев к ним заодно).

В настоящее время неполное решение её, как описано выше, выглядит так:

Если искать в Яндексе, то подобранный адрес выведет единственную ссылку (или ничего):

Нажав ссылку «копия», увидим (если повезёт) сохранённую копию (страница выбрана исключительно для актуального на данный момент примера):

В Гугле несколько проще — сразу попадаем на копию, если тоже повезёт, и Гугл успел сохранить именно то, что нам надо, а не дубль отсутствующей страницы.

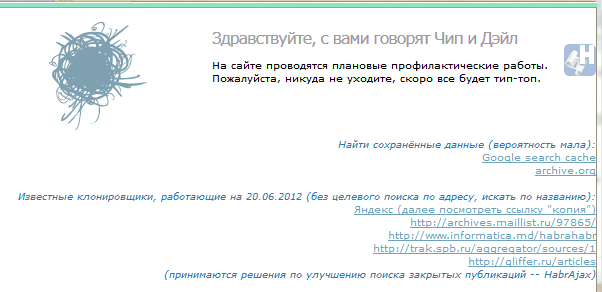

Забавно, что скрипт теперь предлагает «выбор альтернативных сервисов» и в этом случае («профилактические работы»):

Жду предложений по добавлению сервисов и копировщиков (или хотя бы проектов) (для неавторизованных — на почту spmbt0 на известном гуглоресурсе, далее выберем удобный формат).

UPD 23:00: опытным путём для mail.ru было выяснено строение прямой ссылки на кеш:

'http://hl.mailru.su/gcached?q=cache:'+ window.location

Знатоки или инсайдеры, расскажите, что это за ссылка, насколько она стабильна (не изменится ли, например, домен 3-го уровня), что значит приставка «g»-cached? Значит ли это кеш Гугла или это кеш движка Gogo? Пример.

Добавил ссылки мейла и ВК в обновление скрипта (habrAjax) (0.861), теперь там — на 2 строчки больше.

Представьте себе библиотеку с каталогом. Чтобы найти нужную книгу, достаточно в каталоге посмотреть, в каком ряду и на какой полке она стоит. Если из каталога убрать карточку, то книгу найти будет невозможно. Всё, нет такой книги! Вот же каталог — видите? Нету! Хотя с полки её никто и не убирал…

С файлами то же самое. Что в компьютере, что в интернете. Когда вы смотрите список файлов на диске или на сайте, вам показывают каталог. Список файлов. Если из этого списка убрать ссылку на файл, то система его найти не сможет и выдаст сообщение «Файл не найден» (для интернет-страницы это может быть «ошибка 404»). При этом физически файл вовсе не обязательно будет стёрт — если только на то же место не запишут другой файл.

Так что удалённые файлы вовсе не обязательно куда-то деваются, они просто становятся недоступными. По крайней мере недоступными снаружи.

Но даже и тут есть трюк: веб-архив, из которых наиболее известен веб-архив Гугла. Поисковый механизм этого сервиса регулярно делает мгновенный снимок сайта — и складывает его в архив. Для одного и того же сайта может скопиться огромное число таких снимков, соответствующих разным моментам времени. И если в какой-то день Х вот этот файл был с сайта удалён, то на снимке, соответствующем дню Х-1, его ещё запросто можно будет найти.

Find the Wayback Machine useful?

DONATE

deviantart.com

Oct 15, 2013 21:28:20

cl.cam.ac.uk

Feb 29, 2000 18:34:39

foodnetwork.com

Oct 20, 2013 22:40:56

yahoo.com

Dec 20, 1996 15:45:10

spiegel.com

Oct 01, 2013 15:26:30

imdb.com

Oct 21, 2013 16:53:47

stackoverflow.com

Oct 14, 2013 21:22:10

ubl.com

Dec 27, 1996 20:38:47

bloomberg.com

Oct 01, 2013 23:10:45

reference.com

Oct 18, 2013 07:12:58

feedmag.com

Dec 23, 1996 10:53:17

wikihow.com

Oct 21, 2013 20:56:46

nbcnews.com

Oct 21, 2013 17:24:52

goodreads.com

Oct 21, 2013 00:42:42

obamaforillinois.com

Nov 09, 2004 04:28:06

geocities.com

Feb 22, 1997 17:47:51

amazon.com

Feb 04, 2005 00:47:33

nytimes.com

Oct 01, 2013 01:42:36

bbc.co.uk

Oct 01, 2013 00:13:32

huffingtonpost.com

Oct 21, 2013 17:11:12

reddit.com

Oct 01, 2013 03:15:39

cnet.com

Oct 21, 2013 02:07:03

whitehouse.gov

Dec 27, 1996 06:25:41

aol.com

Oct 01, 2013 05:01:31

yelp.com

Oct 19, 2013 02:44:53

etsy.com

Jun 01, 2013 01:38:52

foxnews.com

Oct 01, 2013 01:08:27

well.com

Jan 08, 1997 06:53:37

w3schools.com

Oct 19, 2013 00:55:10

buzzfeed.com

Oct 21, 2013 17:32:21

nasa.gov

Dec 31, 1996 23:58:47

mashable.com

Oct 21, 2013 02:16:14

nfl.com

Oct 21, 2013 07:39:25

Tools

Banish broken links from your blog.

Help users get where they were going.

Save Page Now

Capture a web page as it appears now for use as a trusted citation in the future.

Only available for sites that allow crawlers.

Зачем нужна информация об истории сайта в прошлом

Историю любого сайта можно посмотреть в интернете. Для этого достаточно, чтобы ресурс существовал хотя бы пару дней. Это может понадобиться в следующих случаях:

- Если необходимо купить домен, который уже был в использовании, и нужно посмотреть контент какой тематики был на нем размещен, не было ли огромного количества рекламы, исходящих ссылок и т.д.

- Нужен уникальный контент. Его можно скачать с существовавших когда-то ресурсов. Такое наполнение подойдет, например, для сайта-сателлита.

- Нужно восстановить сайт, когда нет его бэкапа.

- Нужно проанализировать конкурентов. Этот способ понадобится чтобы посмотреть историю изменений на их сайтах, какие ошибки они допускали или, наоборот, какие “фишки” стоит позаимствовать.

- Необходимо посмотреть страницу, если она теперь недоступна напрямую.

- Интересно , как выглядел ресурс 10-20 лет назад.

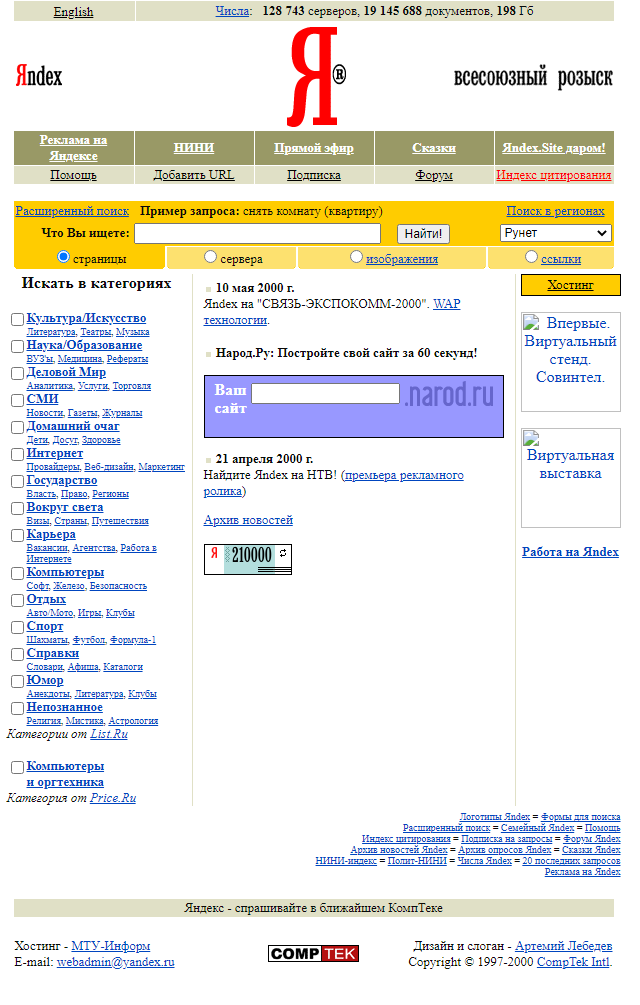

Ниже приведен пример того, как выглядела стартовая страница поисковой системы Яндекс в 2000 году:

Как посмотреть сайт в прошлом

Есть несколько сервисов, в которых можно посмотреть, как менялось визуальное оформление страниц сайта, его структуру страниц и контент, положение в поисковой выдаче и какие изменения вносились в регистрационные данные за время существования ресурса.

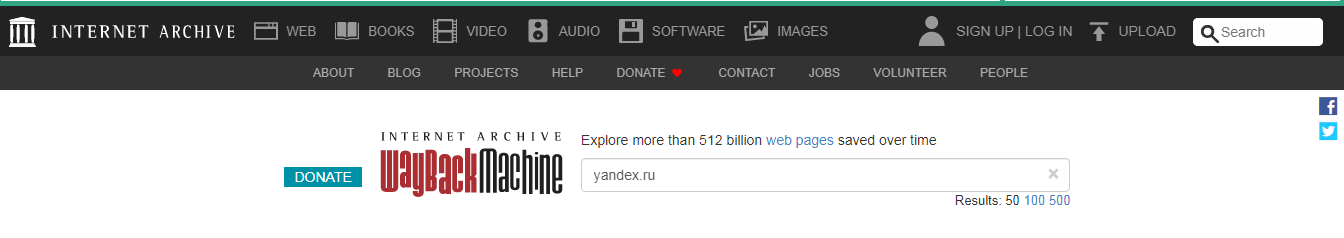

Сервис Веб-архив

При его использовании сначала заходим на сайт https://web.archive.org/ и после вводим адрес страницы.

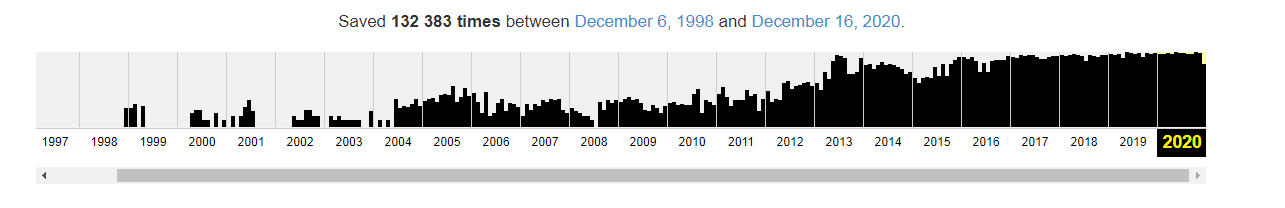

График ниже показывает количество сохранений: первое было в 1998 году.

Дни, в которые были сохранения, отмечены кружком. При клике на время во всплывающем окне, открывается сохраненная версия. Показано ниже:

Как выгрузить сайт из ВебАрхива, расскажем дальше.

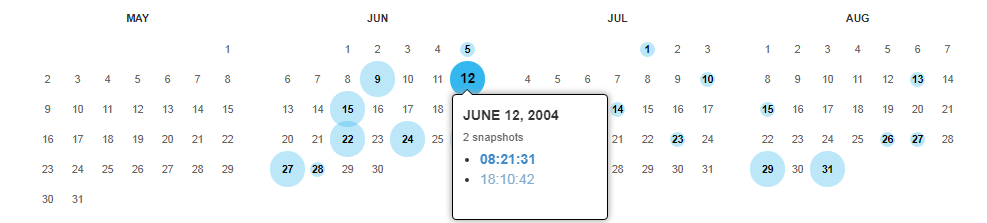

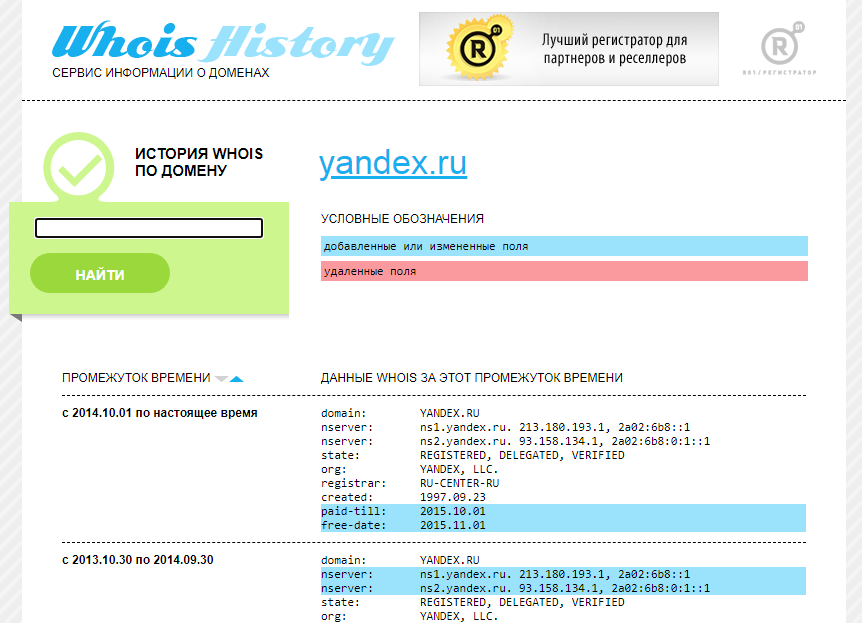

Сервис Whois History

Для его использования заходим на сайт http://whoishistory.ru/ и вводим данные в поиске по доменам и IP, либо по домену:

Сервис покажет информацию по данным Whois, где собраны сведения от всех регистраторов доменных имен. Посмотреть можно возраст домена, кто владелец, какие изменения вносились в регистрационные данные и т.д.

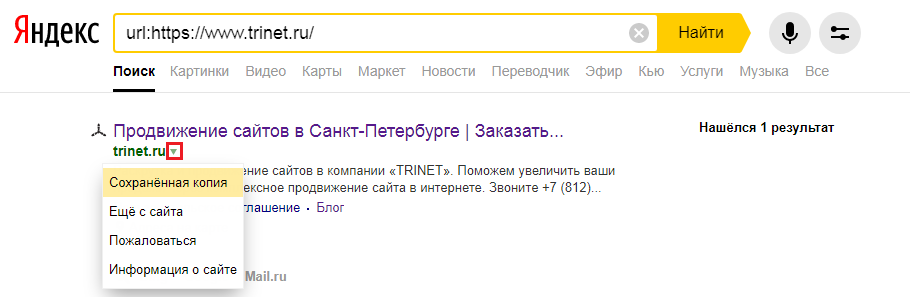

Сохраненная копия страницы в поисковых системах Яндекс и Google

Для сохранения копий страниц понадобятся дополнительные сервисы. Поисковые системы сохраняют последние версии страниц, которые были проиндексированы поисковым роботом.

Для этого в строке поиска Яндекс вводим адрес сайта с оператором site: или url: в зависимости от того, что хотим проверить конкретную страницу или ресурс целиком. Нажимаем на стрелочку рядом с URL и выбираем «Сохраненная копия».

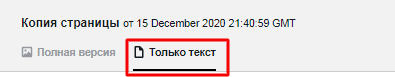

Откроется последняя версия страницы, которая есть у ПС. Можно посмотреть только текст, выбрав одноименную вкладку.

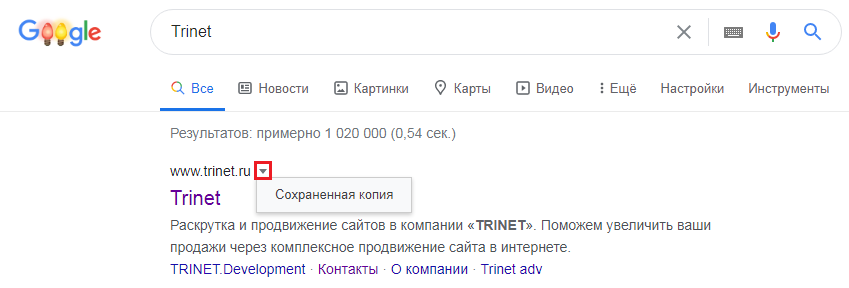

Посмотреть сохраненную копию конкретной страницы в Google можно с помощью оператора cache. Например, вводим cache:trinet.ru и получаем:

Вы так же можете посмотреть текстовую версию страницы.

Найти сохраненную версию страницы можно и через выдачу Google. Необходимо:

- использовать оператор site:, либо указать сразу необходимый URL

- найти страницу в выдаче

- нажать на стрелочку рядом с URL

- выбрать «Сохраненная копия»

Платформа Serpstat

С помощью этого инструмента можно посмотреть изменения видимости сайта в поисковой выдаче за год или за все время, что сайт находится в базе Serpstat.

Сервис Keys.so

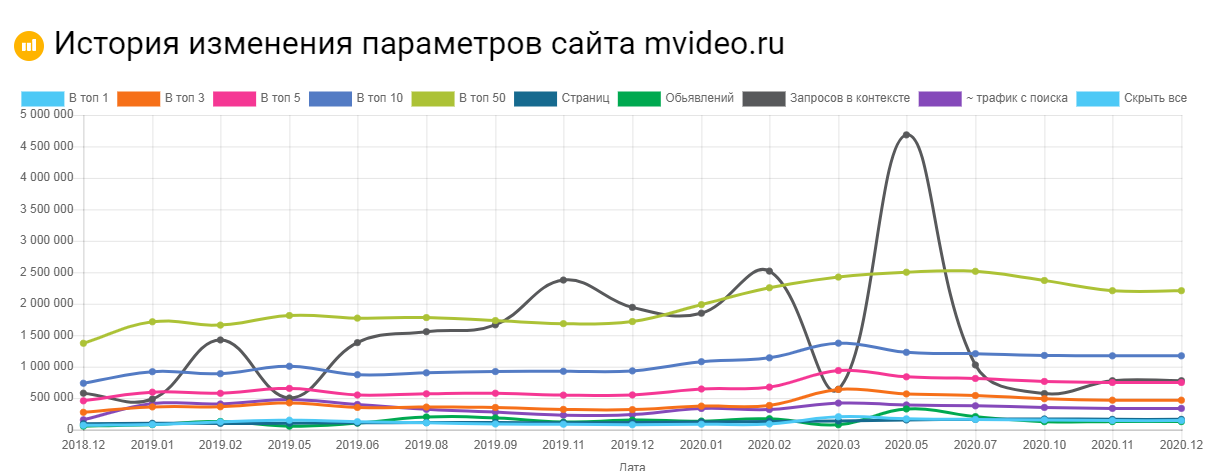

Используя этот сервис можно посмотреть, сколько страниц находится в выдаче, в ТОП – 1, ТОП – 3 и т.д. Можно регулировать параметры на графике и выгружать полную статистику в Excel.

Как восстановить сайт из архива

Часто нужно не только посмотреть, как менялись страницы в прошлом, но и скачать содержимое сайта. Это легко сделать с помощью автоматических сервисов.

О самых популярных расскажем ниже.

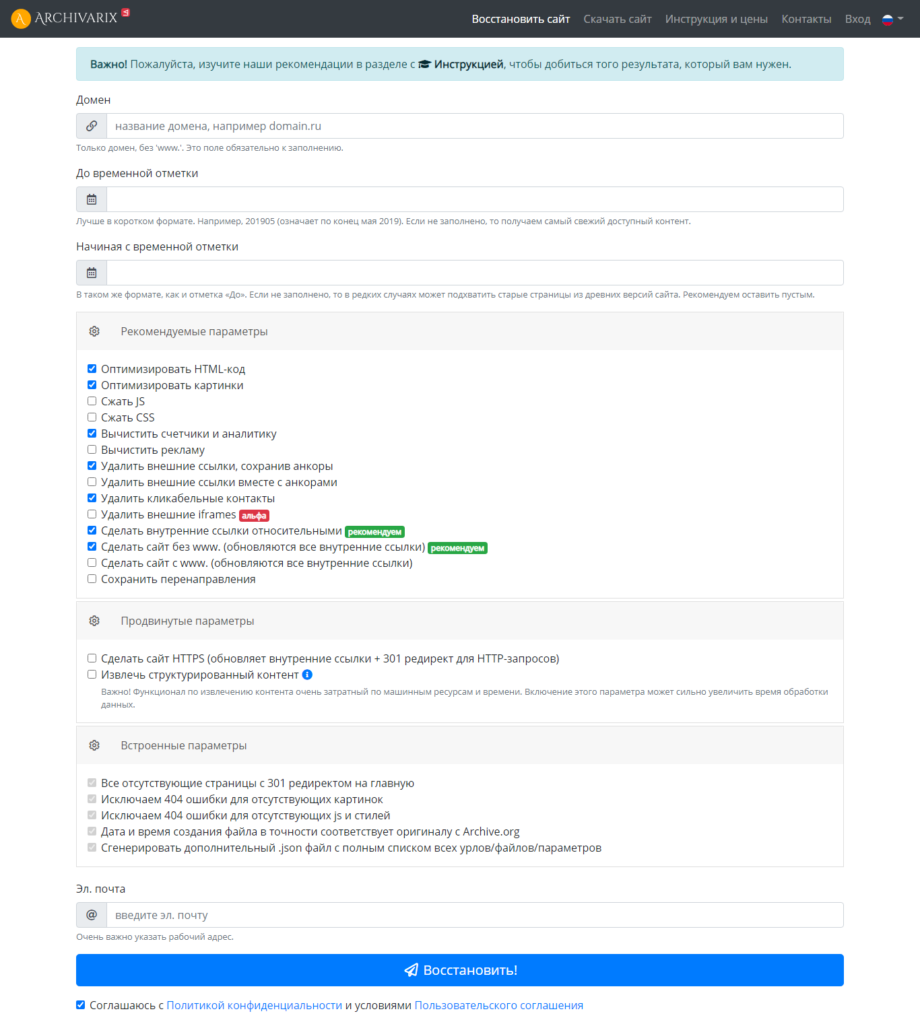

Сервис Архиварикс

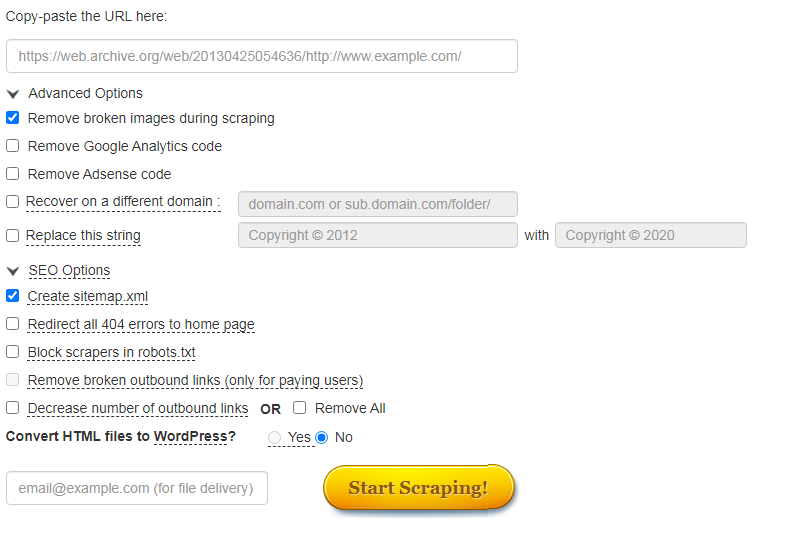

Сервис может восстановить как рабочие, так и не рабочие сайты. Недоступные ресурсы он скачивает из Веб-архива. Для этого нужно заполнить данные на странице https://archivarix.com/ru/restore/ и нажать кнопку «Восстановить».

Для работы с полученными файлами Архиварикс предоставляет собственную систему CMS, которая совместима с любыми другими системами.

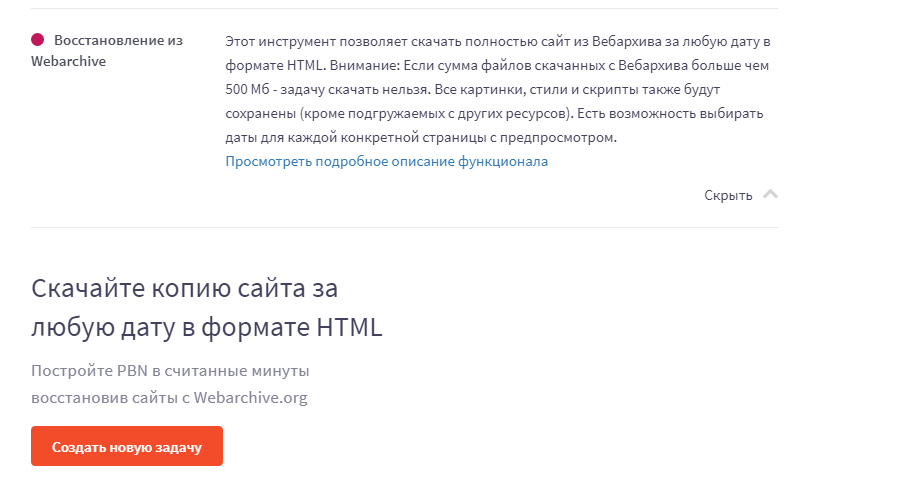

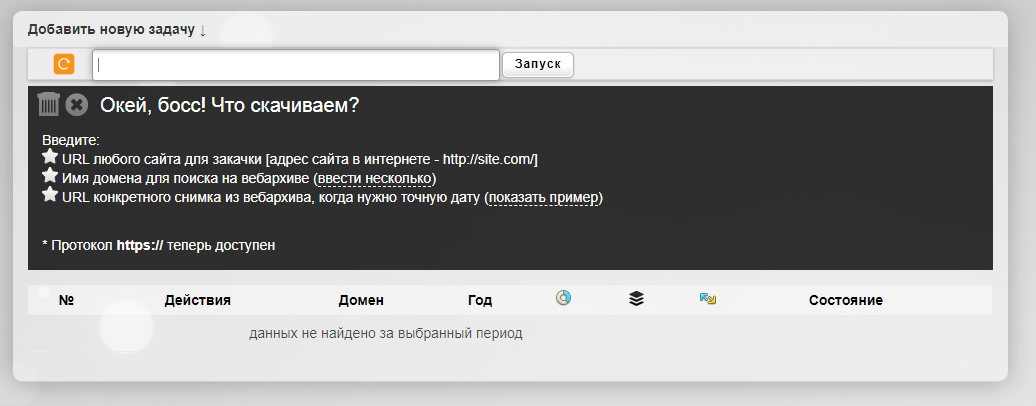

Сервис Rush Analytics

Данный сервис также восстанавливает сайты из Веб-архива. Можно задать нужную дату скачивания для любой страницы. На выходе получаем html-документ со всеми стилями, картинками и т.д.

Ссылка на сервис https://www.rush-analytics.ru/land/skachivanie-kopiy-saytov-iz-wayback-machine

Сервис R-tools.org

Еще один сервис, который позволяет скачивать сайты из Веб-архива. Можно скачать сайт целиком, можно отдельные страницы. Оплата происходит только за то, что скачено, поэтому выгоднее использовать данный сервис только для небольших сайтов.

Сервис Wayback Machine Download (waybackmachinedownloader.com)

С помощью него можно скачивать данные из Веб-архива. Есть демо-версия. Подходит для больших проектов. Единственный минус – сервис не русифицирован.

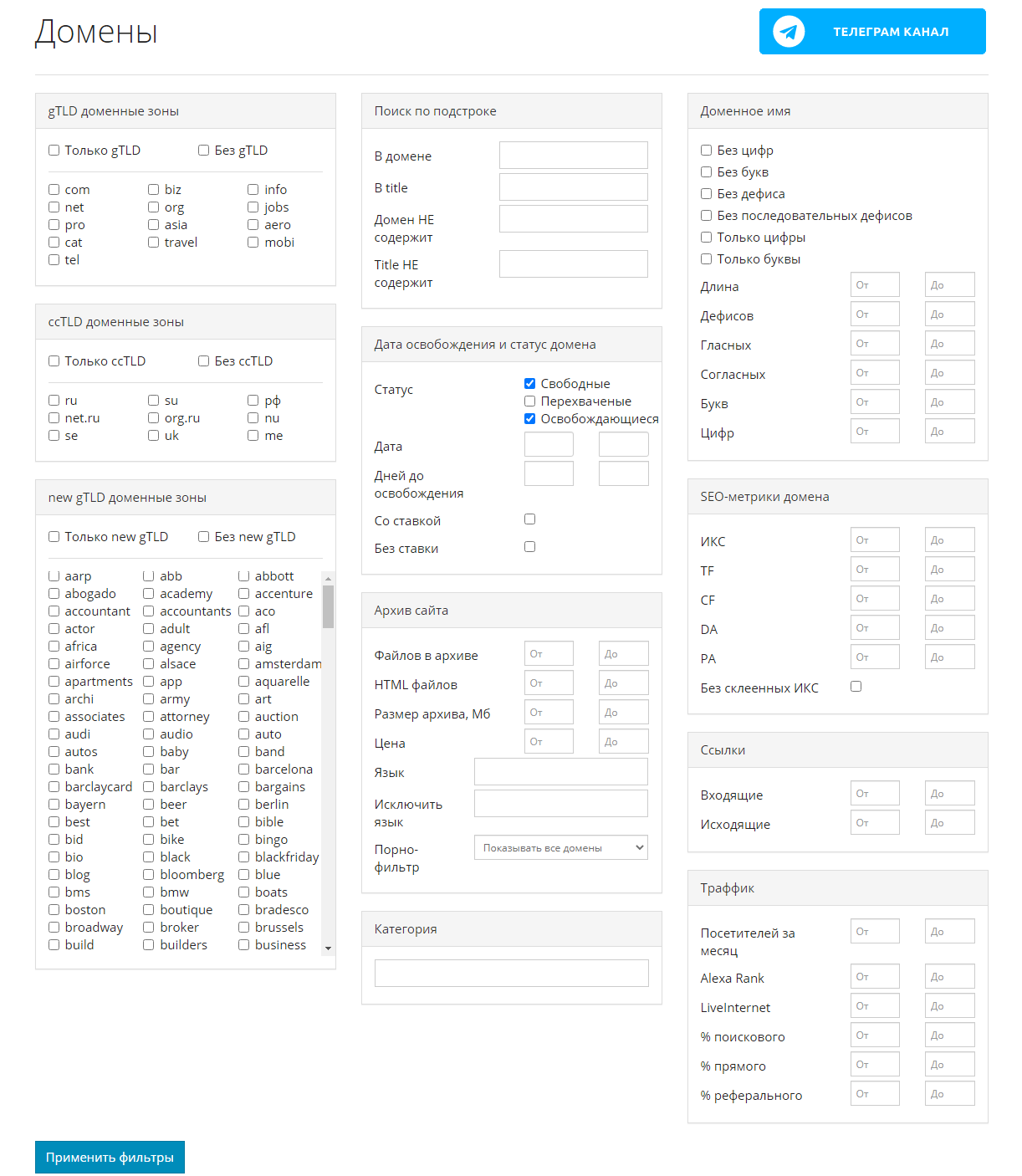

Сервис Mydrop.io

Этот сервис помогает найти уже освободившиеся или скоро освобождающиеся интересные домены по вашим параметрам.

Для этого необходимо применить заданные фильтры, после чего можно скачать контент этих сайтов. Сервис делает скриншоты сайтов до их удаления. Перед скачиванием можно предварительно посмотреть содержимое ресурса. Особенностью является то, что данные выгружаются не из ВебАрхива, а из собственной базы.

Плагины

Восстановить сайт из бэкапа можно автоматически с помощью плагинов для CMS. Таких инструментов множество. Например, плагины Duplicator, UpdraftPlus для системы WordPress. Все, что нужно – это иметь резервную копию, которую также можно сделать с помощью этих плагинов, если сайтом владеете вы.

Множество сервисов, предоставляющие хостинг для сайта, сохраняют бэкапы и можно восстановить предыдущую версию собственного проекта.

Заключение

Мы привели примеры основных сервисов, в которых можно посмотреть изменения сайтов и восстановить их содержимое. Список не ограничивается только этими инструментами.

Если у вас есть интересные и проверенные сервисы, о которых мы не упомянули, расскажите в комментариях. А если нужна помощь со скачиванием контента или комплексные услуги по продвижению и созданию сайтов, обращайтесь к нашим специалистам.

И до встречи в следующей публикации!