Построение линейной модели регрессии по данным эксперимента

- Результативные и факторные признаки

- Линейная модель парной регрессии

- Метод наименьших квадратов, вывод системы нормальных уравнений

- Оценка тесноты связи

п.1. Результативные и факторные признаки

Совокупность информации, которая характеризует исследуемый процесс или объект, называют набором признаков.

Если признаки связаны между собой причинно-следственными связями, то их разделяют на два класса:

1) факторные (независимые) признаки – те, что влияют на изменение других признаков;

2) результативные (зависимые) признаки – те, что меняются под действием факторных признаков.

Например:

Факторный (независимый) признак

Результативный (зависимый) признак

Инвестиции в проект

Прибыльность проекта

Затраты на рекламу

Объем продаж

По характеру зависимости признаков различают:

- Функциональную зависимость, когда каждому определенному значению факторного признака x соответствует одно и только одно значение результативного признака (y=f(x)).

- Статистическую зависимость, когда каждому определенному значению факторного признака x соответствует некоторое распределение (F_Y(y|x)) вероятностей значений результативного признака.

Например:

Функциональные зависимости: (y(x)=x^2+3, S(R)=pi R^2, V(a)=a^3)

Статистические зависимости: средний балл успеваемости в зависимости от потраченного на учебу времени, рост в зависимости от возраста, количество осадков в зависимости от времени года и т.п.

Линейная модель парной регрессии

Статистическая модель – это результат обобщения результатов экспериментального исследования на основе их статистической обработки.

Например:

Прогноз погоды, автоматическая диагностика заболевания по результатам обследования, распознавание отпечатка на сканере и т.п.

В принципе, все сегодняшние компьютерные «чудеса» по поиску, обучению и распознаванию основаны на статистических моделях.

Рассмотрим саму простую модель: построение прямой (Y=aX+b) на основе полученных данных. Такая модель называется линейной моделью парной регрессии.

Пусть Y — случайная величина, значения которой требуется определить в зависимости от факторной переменной X.

Пусть в результате измерений двух случайных величин X и Y был получен набор точек (left{(x_i;y_i)right}, x_iin X, y_iin Y).

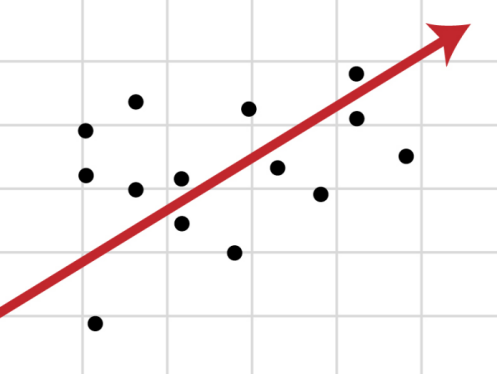

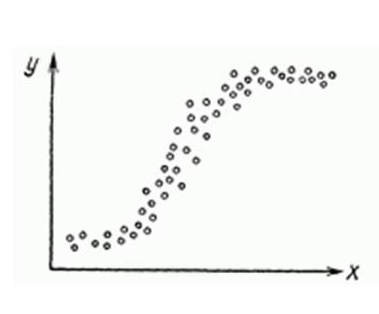

Пусть (y*=y*(x)) — оценка значений величины Y на данном наборе (x_i). Тогда для каждого значения x случайной величиной является ошибка оценки: $$ varepsilon (x)=y*(x)-Y $$ Например, если полученный набор точек при размещении на графике имеет вид:

тогда разумно будет выдвинуть гипотезу, что для генеральной совокупности (Y=aX+b).

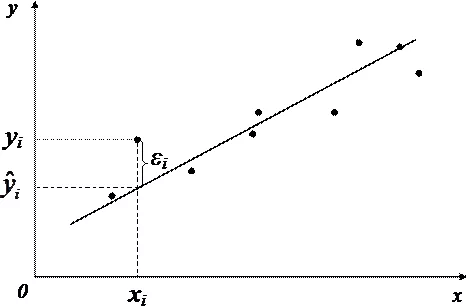

А для нашей выборки: (y_i=ax_i+b+varepsilon_i, i=overline{1,k})

т.к., каждая точка выборки может немного отклоняться от прямой.

Наша задача: на данном наборе точек (left{(x_i;y_i)right}) найти параметры прямой a и b и построить эту прямую так, чтобы отклонения (varepsilon_i) были как можно меньше.

п.3. Метод наименьших квадратов, вывод системы нормальных уравнений

Идея метода наименьших квадратов (МНК) состоит в том, чтобы найти такие значения a и b, для которых сумма квадратов всех отклонений (sum varepsilon_i^2rightarrow min) будет минимальной.

Т.к. (y_i=ax_i+b+varepsilon_i), сумма квадратов отклонений: $$ sum_{i=1}^k varepsilon_i^2=sum_{i=1}^k (y_i-ax_i-b)^2rightarrow min $$ Изучая производные, мы уже решали задачи на поиск экстремума (см. §50 данного справочника).

В данном случае нас интересует «двойной» экстремум, по двум переменным: $$ S(a,b)=sum_{i=1}^k (y_i-ax_i-b)^2 $$ Сначала берем производную по a, считая b постоянной, и приравниваем её к 0: begin{gather*} frac{partial S(a,b)}{partial a}=frac{partial}{partial a}sum_{i=1}^k (y_i-ax_i-b)^2=sum_{i=1}^k frac{partial}{partial a}(y_i-ax_i-b)^2=\ =sum_{i=1}^k 2(y_i-ax_i-b)cdot (-x_i)=-2sum_{i=1}^k x_i(y_i-ax_i-b)=0 end{gather*} Теперь то же самое делаем для b: begin{gather*} frac{partial S(a,b)}{partial b}=frac{partial}{partial b}sum_{i=1}^k (y_i-ax_i-b)^2=sum_{i=1}^k frac{partial}{partial b}(y_i-ax_i-b)^2=\ =sum_{i=1}^k 2(y_i-ax_i-b)cdot (-1)=-2sum_{i=1}^k (y_i-ax_i-b)=0 end{gather*} Получаем систему: begin{gather*} begin{cases} sum_{i=1}^k x_i(y_i-ax_i-b)=0\ sum_{i=1}^k (y_i-ax_i-b)=0 end{cases} \ begin{cases} sum_{i=1}^k x_iy_i-asum_{i=1}^k x_i^2-bsum_{i=1}^k x_i=0\ sum_{i=1}^k y_i-asum_{i=1}^k x_i-bsum_{i=1}^k 1=0 end{cases} end{gather*} Переставим уравнения местами и запишем в удобном для решения виде.

Система нормальных уравнений для параметров парной линейной регрессии $$ begin{cases} asum_{i=1}^k x_i+bk=sum_{i=1}^k y_i\ asum_{i=1}^k x_i^2+bsum_{i=1}^k x_i=sum_{i=1}^k x_iy_i end{cases} $$

Наши неизвестные – это a и b. И получена нами система двух линейных уравнений с двумя неизвестными, которую мы решаем методом Крамера (см. §48 справочника для 7 класса). begin{gather*} triangle = begin{vmatrix} sum_{i=1}^k x_i & k\ sum_{i=1}^k x_i^2 & sum_{i=1}^k x_i end{vmatrix}, triangle_a = begin{vmatrix} sum_{i=1}^k y_i & k\ sum_{i=1}^k x_iy_i & sum_{i=1}^k x_i end{vmatrix}, triangle_b = begin{vmatrix} sum_{i=1}^k x_i & sum_{i=1}^k y_i\ sum_{i=1}^k x_i^2 & sum_{i=1}^k x_iy_i end{vmatrix} \ a=frac{triangle_a}{triangle}, b=frac{triangle_b}{triangle} end{gather*}

Например:

Найдем и построим прямую регрессии для набора точек, представленных на графике выше. Общее число точек k=10.

Расчетная таблица:

| (i) | (x_i) | (y_i) | (x_i^2) | (x_iy_i) |

| 1 | 0 | 3,86 | 0 | 0 |

| 2 | 0,5 | 3,25 | 0,25 | 1,625 |

| 3 | 1 | 4,14 | 1 | 4,14 |

| 4 | 1,5 | 4,93 | 2,25 | 7,395 |

| 5 | 2 | 5,22 | 4 | 10,44 |

| 6 | 2,5 | 7,01 | 6,25 | 17,525 |

| 7 | 3 | 6,8 | 9 | 20,4 |

| 8 | 3,5 | 7,79 | 12,25 | 27,265 |

| 9 | 4 | 9,18 | 16 | 36,72 |

| 10 | 4,5 | 9,77 | 20,25 | 43,965 |

| ∑ | 22,5 | 61,95 | 71,25 | 169,475 |

Получаем: begin{gather*} sum_{i=1}^k x_i=22,2; sum_{i=1}^k x_i^2=71,25; sum_{i=1}^k x_iy_i=169,475; sum_{i=1}^k y_i=61,95\ triangle = begin{vmatrix} 22,2 & 10\ 71,25 & 22,2 end{vmatrix}=22,2^2-10cdot 71,25=-206,25\ triangle_a = begin{vmatrix} 61,95 & 10\ 169,475 & 22,2 end{vmatrix}=61,95cdot 22,2-10cdot 169,475=-300,875\ triangle_b = begin{vmatrix} 22,2 & 61,95\ 71,25 & 169,475 end{vmatrix}=22,2cdot 169,475-61,95cdot 71,25=-600,75 \ a=frac{triangle_a}{triangle}=frac{-300,875}{-206,25}approx 1,46, b=frac{triangle_b}{triangle}=frac{-600,75}{-206,25}approx 2,91 end{gather*}

Уравнение прямой регрессии: $$ Y=1,46cdot X+2,91 $$

п.4. Оценка тесноты связи

Найденное уравнение регрессии всегда дополняют расчетом показателя тесноты связи.

Введем следующие средние величины: $$ overline{x}=frac1ksum_{i=1}^k x_i, overline{y}=frac1ksum_{i=1}^k y_i, overline{x^2}=frac1ksum_{i=1}^k x_i^2, overline{y^2}=frac1ksum_{i=1}^k y_i^2, overline{xy}=frac1ksum_{i=1}^k x_iy_i $$ Дисперсия каждой из случайных величин x и y: $$ D_x=overline{x^2}-(overline{x})^2, D_y=overline{y^2}-(overline{y})^2 $$ СКО каждой из случайных величин: $$ sigma_x=sqrt{overline{x^2}-(overline{x})^2}, sigma_y=sqrt{overline{y^2}-(overline{y})^2}, $$

Линейный коэффициент корреляции (r_{xy}) является показателем тесноты линейной связи между факторной переменной x и результативной переменной y и рассчитывается по формуле: $$ r_{xy}=frac{overline{xy}-overline{x}cdot overline{y}}{sigma_x sigma_y} $$

Значения линейного коэффициента корреляции находится в интервале $$ -1leq r_{xy}leq 1 $$ Чем ближе (|r_{xy}|) к единице, тем сильнее линейная связь между x и y.

Отрицательные значения (|r_{xy}|) соответствуют обратной связи: убывающей прямой с отрицательным угловым коэффициентом.

Для оценки тесноты связи на практике пользуются шкалой Чеддока:

Значение (|r_{xy}|)

Теснота линейной связи

(left.left[0; 0,3right.right))

Очень слабая

(left.left[0,3; 0,5right.right))

Слабая

(left.left[0,5; 0,7right.right))

Средняя

(left.left[0,7; 0,9right.right))

Высокая

([0,9; 1])

Очень высокая

Например:

Для построенной выше прямой регрессии получаем: begin{gather*} overline{x}=frac1ksum_{i=1}^k x_i=frac{22,2}{10}=2,22\ overline{y}=frac1ksum_{i=1}^k y_i=frac{61,95}{10}=6,195\ overline{x^2}=frac1ksum_{i=1}^k x_i^2=frac{71,25}{10}=7,125\ overline{y^2}=frac1ksum_{i=1}^k y_i^2approx frac{429,94}{10}=42,994\ overline{xy}=frac1ksum_{i=1}^k x_i y_i= frac{169,475}{10}approx 16,948\ overline{xy}-overline{x}cdot overline{y}=16,948-2,22cdot 6,195approx 3,009\ D_x=overline{x^2}-(overline{x})^2=7,125-(2,22)^2approx 2,063\ D_y=overline{y^2}-(overline{y})^2=42,994-(6,195)^2approx 4,616\ r_{xy}=frac{overline{xy}-overline{x}cdot overline{y}}{sqrt{D_xcdot D_y}}approx frac{3,009}{sqrt{2,063cdot 4,616}}approx 0,975 end{gather*}

По шкале Чеддока полученное значение коэффициента (r_{xy}) указывает на очень высокую прямую линейную связь.

При изучении объектов и явлений исследователю, как правило, приходится иметь дело с несколькими некоторым

образом связанными статистическими признаками.

Например, объём продукции предприятия связан с численностью работников, мощностью оборудования, стоимостью

производственных фондов и еще многими

признаками. Признаки «пол» и «число лейкоцитов в крови» могли бы рассматриваться как зависимые, если бы

большинство мужчин имело высокий уровень

лейкоцитов, а большинство женщин – низкий, или наоборот. Рост связан с весом, потому что обычно высокие

индивиды тяжелее низких; IQ (коэффициент

интеллекта) связан с количеством ошибок в тесте, т.к. люди высоким значением IQ делают меньше ошибок и т.д.

Невозможно управлять явлениями, предсказывать их развитие без изучения характера, силы и других особенностей

связей. Поэтому методы исследования,

направленные на измерение связей, составляют чрезвычайно важную часть методологии научного исследования,

в том числе и статистического.

При исследовании причинно-следственных связей статистические признаки разделяют на факторные и результативные.

Факторные признаки, или факторы, – это признаки, обуславливающие изменение других, связанных с ними, признаков. Результативными называются признаки, изменяющиеся

под воздействием факторных признаков.

Различают два типа связей между факторными и результативными признаками: функциональную и статистическую.

Функциональной называют такую связь, при

которой каждому определённому значению x факторного признака соответствует одно и только одно

значение y результативного признака:

$y=f(x)$.

Функциональная связь двух величин возможна лишь при условии, что вторая из них зависит только от первой и

ни от чего более. Такие связи являются

абстракциями, в реальной жизни они встречаются редко, но находят широкое применение в точных науках

и в первую очередь, в математике.

Например, зависимость площади круга от радиуса $S(R)=pi {{R}^{2}}$.

Функциональная зависимость результативного признака y от многих факторов

x1,…,xk возможна только в том

случае, если признак y всегда зависит от перечисленного набора факторов и ни от чего более. Такие

связи также являются абстракциями, поскольку

большинство явлений и процессов безграничного реального мира связаны между собой, и нет такого конечного

числа переменных, которые абсолютно полно

определяли бы собою зависимую величину. Тем не менее, на практике нередко используют представление реальных

связей как функциональных. Например, длина года

(период обращения Земли вокруг Солнца) почти функционально зависит только от массы Солнца и расстояния

Земли от него. На самом деле она зависит в очень

слабой степени и от масс, и от расстояний других планет от Земли, но вносимые ими (и тем более в миллионы

раз более далекими звездами) искажения

функциональной связи для всех практических целей, кроме космонавтики, пренебрежимо малы.

Статистической связью

между результативным и факторным признаками называется связь, при которой каждому определённому

значению x факторного признака соответствует

некоторое распределение ${{F}_{Y}}(y|x)$ вероятностей значений результативного признака.

Такие связи имеют место, например, если на результативный признак действуют несколько факторных признаков,

а для описания связи используется один или

несколько определяющих (учтённых) факторов.

Частным случаем статистической связи между результативным и факторным признаками y и x

является корреляционная связь. При

корреляционной связи от значения x факторного признака зависит не всё распределение вероятностей

FY(y), а лишь

математическое ожидание величины Y.

Математическое ожидание случайной величины Y при фиксированном значении случайной величины

X = x называется условным математическим ожиданием и обозначается

M[Y|x], а уравнение

$text{M}[Y|x]=f(x)$

называется уравнением регрессии Y на X.

В зависимости от типа рассматриваемых статистических признаков для анализа статистических связей между

ними используют различные статистические методы

(табл. 6.1).

Для анализа степени тесноты связи между количественными факторным и результативным признаками,

т.е. признаками, варианты которых имеют числовое

выражение, используются методы корреляционного анализа, для анализа уравнения регрессии – методы

регрессионного анализа. Корреляционный и

регрессионный анализы также могут быть применены для случая качественных порядковых, или

ординальных, признаков, т.е. признаков,

значения которых могут быть некоторым образом упорядочены. Для таких признаков можно сказать, какие

значения больше или меньше, но нельзя сказать

насколько.

В случае если факторный признак является номинальным (категориальным,

или атрибутивным), т.е. признаком, варианты которого могут

быть измерены только в терминах принадлежности к некоторым категориям, а результативный – количественным,

то для анализа статистической связи между ними

используются методы дисперсионного анализа.

Если же оба признака – и факторный, и результативный – являются номинальными, то для анализа статистической

связи между ними используют метод таблиц сопряжённости.

Если факторный признак является количественным, а результативный – номинальным, то задачу, как правило,

сводят к случаю двух номинальных признаков путём

группировки значений факторного признака.

Таблица 6.1

Методы исследования статистических связей

|

факторный результативный |

номинальный |

количественный |

|

номинальный |

таблицы сопряжённости |

таблицы сопряжённости |

|

количественный |

дисперсионный анализ |

корреляционный, |

Основные задачи корреляционно-регрессионного

анализа

-

Выявления наличия (или отсутствия)

корреляционной связи между изучаемыми

признаками. -

Определение формы корреляционной

зависимости, то есть вида функции

регрессии (линейной, логарифмической,

параболической и др.). -

Построение уравнения регрессии.

-

Оценка степени тесноты корреляционной

связи.

Понятие корреляционной зависимости

Одна из основных задач статистики

-установление и измерение связей между

явлениями.

При изучении связей выделяют факторные

и результативные признаки.

Факторные— это признаки,

оказывающие влияние на изменение

результативных признаков.

Результативныепредставляют

собой результат влияния факторных

признаков.

Связь изучается между вариацией результативного и факторного признаков, а не между их отдельными величинами

Виды взаимосвязей

Функциональная связьхарактеризуется

строго определенным изменением значения

переменной упри изменении другой

переменнойх.

Такие связи обычно встречаются в

естественных науках: математике, физике

и др.

Частным случаем стохастической или

статистической связи является

корреляционная связь.

Статистическая зависимостьхарактеризуется изменением распределения

одной переменной под влиянием изменения

другой.

Например, уровень машины в зависимости

от занимаемой должности

Корреляционной связьюназывают

важнейший частный случай статистической

связи, состоящий в том, что разным

значениям одной переменной соответствуют

различныесредние значениядругой.

С изменением значения признакахзакономерным образом изменяется среднее

значение признакау;в то время как

в каждом отдельном случае значение

признакау(с различными вероятностями)

может принимать множество различных

значений.

Например, скорость машины зависит от

мощности двигателя

Виды зависимостей между факторным

и результативным признаками

1) По направлению связи выделяют прямую

и обратную зависимости:

Прямая зависимость— направление

изменения результативной переменной

совпадает с изменением направления

факторной переменной.

Например, общая производительность

зависит от тактовой частоты процессора

Обратная зависимость— направление

изменения результативной переменной

противоположно направлению изменения

факторной переменной.

Например, чем выше температура

процессора, тем меньше его производительность

2) по количеству факторных признаков

выделяют парную и множественную

зависимости:

Парная зависимость(однофакторная)

— это связь между одной факторной

переменной и одной результативной

переменной.

Например, чем быстрее бежит спортсмен,

тем быстрее он достигнет финиша

Множественная зависимость(многофакторная) — это связь между

несколькими факторными переменными и

одной (иногда несколькими) результативной

переменной.

Например, чем быстрее бежит один

спортсмен, чем медленнее бегут остальные

по сравнению с ним, тем больше шансов,

что он получит медаль.

Выявление наличия (или отсутствия)

корреляционной связи между изучаемыми

признаками производится:

-

на основе параллельного сопоставления

(сравнения)значений хиу; -

с помощью группировок;

-

путем построения и анализа специальных

корреляционных таблиц; -

графическим способом.

Теснота связи между факторным

и результативным признаками колеблется

от -1 до +1

Термин «регрессионный анализ»

подразумевает всестороннее

исследование корреляционных связей, в

том числе:

-

нахождение уравнений регрессии,

-

определение возможных ошибок параметров

уравнений регрессии и показателей

тесноты связи, -

оценка существенности коэффициента

регрессии и уравнения связи.

Простейшей системой корреляционной

связи является линейная связь между

двумя признаками —парная

линейная корреляция.

Практическое значение ее в том, что есть

системы, в которых среди всех факторов,

влияющих на результативный признак,

выделяется один важнейший фактор,

который в основном определяет вариацию

результативного признака. Измерение

парных корреляций составляет необходимый

этап в изучении сложных, многофакторных

связей. Есть такие системы связей, при

изучении которых следует предпочесть

парную корреляцию. Внимание к линейным

связям объясняется ограниченной

вариацией переменных и тем, что в

большинстве случаев нелинейные формы

связей для выполнения расчетов

преобразуются в линейную форму.

Уравнение парной линейной корреляционной

связи называется уравнением парной

регрессиии имеет вид:у

= а + bх,

где у —среднее

значение результативного признака при

определенном значении факторного

признаках; а —свободный член уравнения;b

— коэффициент регрессии, измеряющий

среднее отношение отклонения

результативного признака от его средней

величины к отклонению факторного

признака от его средней величины на

одну единицу его измерения

-вариацияу,приходящаяся на

единицу вариациих.

Параллельное рассмотрение коррелирующих

значений проводится:

-

показателем тесноты связи -коэффициентом

Фехнера; -

ранговым коэффициентом Спирмэна;

-

группировками;

-

на основе таблиц сопряженности.

Содержание курса лекций «Статистика»

Причинность, регрессия, корреляция

Исследование объективно существующих связей между социально-экономическими явлениями и процессами является важнейшей задачей теории статистики. В процессе статистического исследования зависимостей вскрываются причинно-следственные отношения между явлениями, что позволяет выявлять факторы (признаки), оказывающие основное влияние на вариацию изучаемых явлений и процессов. Причинно-следственные отношения ‑ это такая связь явлений и процессов, когда изменение одного из них ‑ причины ведет к изменению другого ‑ следствия.

Финансово-экономические процессы представляют собой результат одновременного воздействия большого числа причин. Следовательно, при изучении этих процессов необходимо выявлять главные, основные причины, абстрагируясь от второстепенных.

В основе первого этапа статистического изучения связи лежит качественный анализ, связанный с анализом природы социального или экономического явления методами экономической теории, социологии, конкретной экономики.

Второй этап – построение модели связи, базируется на методах статистики: группировках, средних величинах, и так далее.

Третий, последний этап ‑ интерпретация результатов, вновь связан с качественными особенностями изучаемого явления. Статистика разработала множество методов изучения связей. Выбор метода изучения связи зависит от познавательной цели и задач исследования.

Признаки по их сущности и значению для изучения взаимосвязи делятся на два класса.

Признаки, обуславливающие изменения других, связанных с ними признаков, называются факторными, или просто факторами.

Признаки, изменяющиеся под действием факторных признаков, называются результативными.

В статистике различают функциональную и стохастическую зависимости.

Функциональной называют такую связь, при которой определенному значению факторного признака соответствует одно и только одно значение результативного признака.

Если причинная зависимость проявляется не в каждом отдельном случае, а в общем, среднем, при большом числе наблюдений, то такая зависимость называется стохастической. Частным случаем стохастической связи является корреляционная связь, при которой изменение среднего значения результативного признака обусловлено изменением факторных признаков.

Связи между явлениями и их признаками классифицируются по степени тесноты, направлению и аналитическому выражению.

Таблица 11.1. ‑ Количественные критерии оценки тесноты связи

|

Величина показателя связи |

Характер связи |

|

До ±0,3 |

практически отсутствует |

|

±0.3 – ±0,5 |

слабая |

|

±0,5 – ±0,7 |

умеренная |

| ±0,7 -±1,0 |

сильная |

По направлению выделяют связь прямую и обратную.

Прямая ‑ это связь, при которой с увеличением или с уменьшением значений факторного признака происходит увеличение или уменьшение значений результативного признака.

Пример. Так, рост объемов производства способствует увеличению прибыли предприятия.

В случае обратной связи значения результативного признака изменяются под воздействием факторного, но в противоположном направлении по сравнению с изменением факторного признака, то есть обратная ‑ это связь, при которой с увеличением или с уменьшением значений одного признака происходит уменьшение или увеличение значений другого признака.

Пример. Так, снижение себестоимости единицы производимой продукции влечет за собой рост рентабельности.

По аналитическому выражению выделяют связи прямолинейные (или просто линейные) и нелинейные.

Если статистическая связь между явлениями может быть приблизительно выражена уравнением прямой линии, то ее называют линейной связью вида:

(11.1)

Если же связь может быть выражена уравнением какой-либо кривой, то такую связь называют нелинейной или криволинейной, например:

(11.2)

(11.3)

Для выявления наличия связи, ее характера и направления в статистике используются методы: приведения параллельных данных; графический; аналитических группировок; корреляции, регрессии.

Метод приведения параллельных данных основан на сопоставлении двух или нескольких рядов статистических величин. Такое сопоставление позволяет установить наличие связи и получить представление о ее характере.

Графически взаимосвязь двух признаков изображается с помощью поля корреляции. В системе координат на оси абсцисс откладываются значения факторного признака, а на оси ординат ‑ результативного. Каждое пересечение линий, проводимых через эти оси, обозначаются точкой. При отсутствии тесных связей имеет место беспорядочное расположение точек на графике. Чем сильнее связь между признаками, тем теснее будут группироваться точки вокруг определенной линии, выражающей форму связи.

В статистике принято различать следующие виды зависимостей:

- Парная корреляция ‑ связь между двумя признаками (результативным и факторным, или двумя факторными).

- Частная корреляция ‑ зависимость между результативным и одним факторным признаками при фиксированном значении других факторных признаков.

- Множественная корреляция ‑ зависимость результативного и двух или более факторных признаков, включенных в исследование.

Корреляционный анализ имеет своей задачей количественное определение тесноты и направления связи между двумя признаками (при парной связи) и между результативным и множеством факторных признаков (при многофакторной связи).

Теснота связи количественно выражается величиной коэффициентов корреляции, которые, давая количественную характеристику тесноты связи между признаками, позволяют определять «полезность» факторных признаков при построении уравнения множественной регрессии. Знаки при коэффициентах корреляции характеризуют направление связи между признаками.

Регрессия тесно связана с корреляцией и позволяет исследовать аналитическое выражение взаимосвязи между признаками.

Регрессионный анализ заключается в определении аналитического выражения связи, в котором изменение одной величины (называемой зависимой или результативным признаком), обусловлено влиянием одной или нескольких независимых величин (факторных признаков).

Одной из проблем построения уравнений регрессии является их размерность, то есть определение числа факторных признаков, включаемых в модель. Их число должно быть оптимальным. Сокращение размерности за счет исключения второстепенных, несущественных факторов позволяет получить модель, быстрее и качественнее реализуемую. В то же время, построение модели малой размерности может привести к тому, что она будет недостаточно полно описывать исследуемое явление или процесс.

При построении моделей регрессии должны соблюдаться требования:

- Совокупность исследуемых исходных данных должна быть однородной и математически описываться непрерывными функциями.

- Возможность описания моделируемого явления одним или несколькими уравнениями причинно-следственных связей.

- Все факторные признаки должны иметь количественное (числовое) выражение.

- Наличие достаточно большого объема исследуемой совокупности (в последующих примерах в целях упрощения изложения материала это условие нарушено, т.е. объем очень мал).

- Причинно-следственные связи между явлениями и процессами должны описываться линейной или приводимой к линейной форме зависимостью.

- Отсутствие количественных ограничений на параметры модели связи.

- Постоянство территориальной и временной структуры изучаемой совокупности.

Соблюдение данных требований позволяет построить модель, наилучшим образом описывающую реальные социально-экономические явления и процессы.

Парная регрессия на основе метода наименьших квадратов позволяет получить аналитическое выражение связи между двумя признаками: результативным и факторным.

Определить тип уравнения можно, исследуя зависимость графически, однако существуют более общие указания, позволяющие выявить уравнение связи, не прибегая к графическому изображению. Если результативный и факторный признаки возрастают одинаково, то это свидетельствует о том, что связь между ними линейная, а при обратной связи ‑ гиперболическая. Если результативный признак увеличивается в арифметической прогрессии, а факторный значительно быстрее, то используется параболическая или степенная регрессия.

Оценка параметров уравнений регрессии ( и — в уравнении параболы второго порядка) осуществляется методом наименьших квадратов, в основе которого лежит предположение о независимости наблюдений исследуемой совокупности и нахождении параметров модели , при которых минимизируется сумма квадратов отклонений эмпирических (фактических) значений результативного признака от теоретических, полученных по выбранному уравнению регрессии:

Система нормальных уравнений для нахождения параметров линейной парной регрессии методом наименьших квадратов имеет следующий вид:

(11.4)

где п ‑ объем исследуемой совокупности (число единиц наблюдения).

В уравнениях регрессии параметр ао показывает усредненное влияние на результативный признак неучтенных в уравнении факторных признаков. Коэффициент регрессии а1 показывает, на сколько в среднем изменяется значение результативного признака при увеличении факторного признака на единицу собственного измерения. xi – теоретические значения результативного признака; yi – наблюдаемые значения факторного признака.

Пример. Имеются данные по 10 однотипным предприятиям о выпуске продукции (х) в тыс.ед. и о расходе условного топлива (у) в тоннах (графы 1 и 2 табл. 17).

Требуется найти уравнение зависимости расхода топлива от выпуска продукции (или уравнение регрессии у по х) и измерить тесноту зависимости между ними. Для этого представим данные в табл. 11.2 (вместе с расчетными столбцами).

Таблица 11.2 – Расчет показателей для нахождения уравнения регрессии

| № п/п | Выпуск продукции, xi,тыс.ед. | Расход топлива, yi, тонн |

|

|

|

|

| 1 | 5 | 4 | 25 | 20 | 16 | 3,9 |

| 2 | 6 | 4 | 36 | 24 | 16 | 4,4 |

| 3 | 8 | 6 | 64 | 48 | 36 | 5,5 |

| 4 | 8 | 5 | 64 | 40 | 25 | 5,5 |

| 5 | 10 | 7 | 100 | 70 | 49 | 6,6 |

| 6 | 10 | 8 | 100 | 80 | 64 | 6,6 |

| 7 | 14 | 8 | 196 | 112 | 64 | 8,8 |

| 8 | 20 | 10 | 400 | 200 | 100 | 12,1 |

| 9 | 20 | 12 | 400 | 240 | 144 | 12,1 |

| 10 | 24 | 16 | 576 | 384 | 256 | 14,3 |

| ∑* | 125 | 80 | 1961 | 1218 | 770 | 80 |

Необходимые для решения суммы рассчитаны выше в таблице. Подставим их в уравнение и решим систему.

Из системы уравнений получим a1 = 0,547; а0 = 1,16.

Получив искомое уравнение регрессии можно утверждать, что с увеличение выпуска продукции на тыс. ед., расход топлива возрастет в среднем на 0,547 тонны.

*Если параметры уравнения найдены верно, то

(11.5)

Измерение тесноты (силы) и направления связи является важной задачей изучения и количественного измерения взаимосвязи социально-экономических явлений. Оценка тесноты связи между признаками предполагает определение меры соответствия вариации результативного признака и одного (при изучении парных зависимостей) или нескольких (множественных зависимостей) факторных признаков.

Линейный коэффициент корреляции (К. Пирсона) характеризует тесноту и направление связи между двумя коррелируемыми признаками в случае наличия между ними линейной зависимости.

В теории разработаны и на практике применяются различные модификации формулы расчета данного коэффициента.

Для измерения тесноты зависимости между у и х применяют линейный коэффициент корреляции, который может быть рассчитан по любой из нижеприведенных формул:

(11.6)

(11.7)

(11.8)

Таблица 11.3 – Оценка линейного коэффициента корреляции

| Значение линейного коэффициента связи | Характеристика связи | Интерпретация связи |

| г = 0 | отсутствует | – |

| 0<г<1 | прямая | с увеличением х увеличивается у |

| -1<г<0 | обратная | с увеличением х уменьшается у и наоборот |

| г=1 | функциональная | каждому значению факторного признака строго соответствует одно значение результативного признака |

Пример вычисления коэффициента корреляции

Найдем коэффициент корреляции по данным табл. 11.2., используя формулы (11.6‑11.8):

Пример вычисления формула 11.6

Пример вычисления формула 11.7

Пример вычисления формула 11.8

Линейный коэффициент корреляции может принимать по модулю значения от 0 до 1 (знак + при прямой зависимости и знак – при обратной зависимости).

Найденный коэффициент корреляции означает, что характер связи между исследуемыми признаками прямой.

По степени тесноты связи между признаками (одним из критериев оценки служит коэффициент корреляции) различают связи:

Следовательно, 0,7≤0,96≤ 1 , значит, связь в данном примере сильная (с увеличением выпуска продукции увеличивается расход топлива).

Немного истории

Термин “корреляция” впервые применил французский палеонтолог Ж. Кювье, который вывел “закон корреляции частей и органов животных” (этот закон позволяет восстанавливать по найденным частям тела облик всего животного). В статистику указанный термин ввел в 1886 году английский биолог и статистик Френсис Гальтон (не просто связь – relation, а “как бы связь” – co-relation). Однако точную формулу для подсчёта коэффициента корреляции разработал его ученик – математик и биолог – Карл Пирсон (1857 – 1936).

Корреляционным называется исследование, проводимое для подтверждения или опровержения гипотезы о статистической связи между несколькими (двумя и более) переменными. В психологии переменными могут выступать психические свойства, процессы, состояния и др.

Содержание курса лекций «Статистика»

Контрольные задания.

По данным статистических сборников постройте таблицу: по 10 однотипным предприятиям с данными о численности персонала, выпуске продукции, расходах; данных о прожиточном минимуме и средней заработной плате и т.п.; найдите уравнение зависимости (или уравнение регрессии) и измерьте тесноту связи между показателями.

Построение линейной модели регрессии по данным эксперимента

п.1. Результативные и факторные признаки

Инвестиции в проект

Затраты на рекламу

По характеру зависимости признаков различают:

- Функциональную зависимость , когда каждому определенному значению факторного признака x соответствует одно и только одно значение результативного признака (y=f(x)).

- Статистическую зависимость , когда каждому определенному значению факторного признака x соответствует некоторое распределение (F_Y(y|x)) вероятностей значений результативного признака.

Например:

Функциональные зависимости: (y(x)=x^2+3, S(R)=pi R^2, V(a)=a^3)

Статистические зависимости: средний балл успеваемости в зависимости от потраченного на учебу времени, рост в зависимости от возраста, количество осадков в зависимости от времени года и т.п.

Линейная модель парной регрессии

Например:

Прогноз погоды, автоматическая диагностика заболевания по результатам обследования, распознавание отпечатка на сканере и т.п.

В принципе, все сегодняшние компьютерные «чудеса» по поиску, обучению и распознаванию основаны на статистических моделях.

Рассмотрим саму простую модель: построение прямой (Y=aX+b) на основе полученных данных. Такая модель называется линейной моделью парной регрессии .

Пусть Y — случайная величина, значения которой требуется определить в зависимости от факторной переменной X.

Пусть в результате измерений двух случайных величин X и Y был получен набор точек (left<(x_i;y_i)right>, x_iin X, y_iin Y).

Пусть (y*=y*(x)) — оценка значений величины Y на данном наборе (x_i). Тогда для каждого значения x случайной величиной является ошибка оценки: $$ varepsilon (x)=y*(x)-Y $$ Например, если полученный набор точек при размещении на графике имеет вид:

тогда разумно будет выдвинуть гипотезу, что для генеральной совокупности (Y=aX+b).

А для нашей выборки: (y_i=ax_i+b+varepsilon_i, i=overline<1,k>)

т.к., каждая точка выборки может немного отклоняться от прямой.

Наша задача: на данном наборе точек (left<(x_i;y_i)right>) найти параметры прямой a и b и построить эту прямую так, чтобы отклонения (varepsilon_i) были как можно меньше.

п.3. Метод наименьших квадратов, вывод системы нормальных уравнений

Идея метода наименьших квадратов (МНК) состоит в том, чтобы найти такие значения a и b, для которых сумма квадратов всех отклонений (sum varepsilon_i^2rightarrow min) будет минимальной.

Т.к. (y_i=ax_i+b+varepsilon_i), сумма квадратов отклонений: $$ sum_^k varepsilon_i^2=sum_^k (y_i-ax_i-b)^2rightarrow min $$ Изучая производные, мы уже решали задачи на поиск экстремума (см. §50 данного справочника).

В данном случае нас интересует «двойной» экстремум, по двум переменным: $$ S(a,b)=sum_^k (y_i-ax_i-b)^2 $$ Сначала берем производную по a, считая b постоянной, и приравниваем её к 0: begin frac<partial S(a,b)><partial a>=frac<partial><partial a>sum_^k (y_i-ax_i-b)^2=sum_^k frac<partial><partial a>(y_i-ax_i-b)^2=\ =sum_^k 2(y_i-ax_i-b)cdot (-x_i)=-2sum_^k x_i(y_i-ax_i-b)=0 end Теперь то же самое делаем для b: begin frac<partial S(a,b)><partial b>=frac<partial><partial b>sum_^k (y_i-ax_i-b)^2=sum_^k frac<partial><partial b>(y_i-ax_i-b)^2=\ =sum_^k 2(y_i-ax_i-b)cdot (-1)=-2sum_^k (y_i-ax_i-b)=0 end Получаем систему: begin begin sum_^k x_i(y_i-ax_i-b)=0\ sum_^k (y_i-ax_i-b)=0 end \ begin sum_^k x_iy_i-asum_^k x_i^2-bsum_^k x_i=0\ sum_^k y_i-asum_^k x_i-bsum_^k 1=0 end end Переставим уравнения местами и запишем в удобном для решения виде.

Наши неизвестные – это a и b. И получена нами система двух линейных уравнений с двумя неизвестными, которую мы решаем методом Крамера (см. §48 справочника для 7 класса). begin triangle = begin sum_^k x_i & k\ sum_^k x_i^2 & sum_^k x_i end, triangle_a = begin sum_^k y_i & k\ sum_^k x_iy_i & sum_^k x_i end, triangle_b = begin sum_^k x_i & sum_^k y_i\ sum_^k x_i^2 & sum_^k x_iy_i end \ a=frac<triangle_a><triangle>, b=frac<triangle_b> <triangle>end

Например:

Найдем и построим прямую регрессии для набора точек, представленных на графике выше. Общее число точек k=10.

Расчетная таблица:

| (i) | (x_i) | (y_i) | (x_i^2) | (x_iy_i) |

| 1 | 0 | 3,86 | 0 | 0 |

| 2 | 0,5 | 3,25 | 0,25 | 1,625 |

| 3 | 1 | 4,14 | 1 | 4,14 |

| 4 | 1,5 | 4,93 | 2,25 | 7,395 |

| 5 | 2 | 5,22 | 4 | 10,44 |

| 6 | 2,5 | 7,01 | 6,25 | 17,525 |

| 7 | 3 | 6,8 | 9 | 20,4 |

| 8 | 3,5 | 7,79 | 12,25 | 27,265 |

| 9 | 4 | 9,18 | 16 | 36,72 |

| 10 | 4,5 | 9,77 | 20,25 | 43,965 |

| ∑ | 22,5 | 61,95 | 71,25 | 169,475 |

Получаем: begin sum_^k x_i=22,2; sum_^k x_i^2=71,25; sum_^k x_iy_i=169,475; sum_^k y_i=61,95\ triangle = begin 22,2 & 10\ 71,25 & 22,2 end=22,2^2-10cdot 71,25=-206,25\ triangle_a = begin 61,95 & 10\ 169,475 & 22,2 end=61,95cdot 22,2-10cdot 169,475=-300,875\ triangle_b = begin 22,2 & 61,95\ 71,25 & 169,475 end=22,2cdot 169,475-61,95cdot 71,25=-600,75 \ a=frac<triangle_a><triangle>=frac<-300,875><-206,25>approx 1,46, b=frac<triangle_b><triangle>=frac<-600,75><-206,25>approx 2,91 end

Уравнение прямой регрессии: $$ Y=1,46cdot X+2,91 $$

п.4. Оценка тесноты связи

Найденное уравнение регрессии всегда дополняют расчетом показателя тесноты связи.

Введем следующие средние величины: $$ overline=frac1ksum_^k x_i, overline=frac1ksum_^k y_i, overline=frac1ksum_^k x_i^2, overline=frac1ksum_^k y_i^2, overline=frac1ksum_^k x_iy_i $$ Дисперсия каждой из случайных величин x и y: $$ D_x=overline-(overline)^2, D_y=overline-(overline)^2 $$ СКО каждой из случайных величин: $$ sigma_x=sqrt<overline-(overline)^2>, sigma_y=sqrt<overline-(overline)^2>, $$

Значения линейного коэффициента корреляции находится в интервале $$ -1leq r_leq 1 $$ Чем ближе (|r_|) к единице, тем сильнее линейная связь между x и y.

Отрицательные значения (|r_|) соответствуют обратной связи: убывающей прямой с отрицательным угловым коэффициентом.

Для оценки тесноты связи на практике пользуются шкалой Чеддока :

Факторный признак в уравнении регрессии

Регрессионный анализ позволяет приближенно определить форму связи между результативным и факторными признаками, а также решить вопрос о том, значима ли эта связь. Вид функции, с помощью которой приближенно выражается форма связи, выбирают заранее, исходя из содержательных соображений или визуального анализа данных. Математическое решение задачи основано на методе наименьших квадратов.

Суть метода наименьших квадратов. Рассмотрим содержание метода на конкретном примере. Пусть имеются данные о сборе хлеба на душу населения по совокупности черноземных губерний. От каких факторов зависит величина этого сбора? Вероятно, определяющее влияние на величину сбора хлеба оказывает величина посева и уровень урожайности. Рассмотрим сначала зависимость величины сбора хлеба на душу населения от размера посева на душу ( столбцы 1 и 2 табл .4 ) Попытаемся представить интересующую нас зависимость с помощью прямой линии. Разумеется, такая линия может дать только приближенное представление о форме реальной статистической связи. Постараемся сделать это приближение наилучшим. Оно будет тем лучше, чем меньше исходные данные будут отличаться от соответствующих точек, лежащих на линии. Степень близости может быть выражена величиной суммы квадратов отклонении, реальных значений от, расположенных на прямой. Использование именно квадратов отклонений (не просто отклонений) позволяет суммировать отклонения различных знаков без их взаимного погашения и дополнительно обеспечивает сравнительно большее внимание, уделяемое большим отклонениям. Именно этот критерий (минимизация суммы квадратов отклонений) положен в основу метода наименьших квадратов.

В вычислительном аспекте метод наименьших квадратов сводится к составлению и решению системы так называемых нормальных уравнений. Исходным этапом для этого является подбор вида функции, отображающей статистическую связь.

Тип функции в каждом конкретном случае можно подобрать путем прикидки на графике исходных данных подходящей, т. е. достаточно хорошо приближающей эти данные, линии. В нашем случае связь между сбором хлеба на душу и величиной посева на душу может быть изображена с помощью прямой линии ( рис. 14 ) и записана в виде

где у—величина сбора хлеба на душу (результативный признак или зависимая переменная); x—величина посева на душу (факторный признак или независимая переменная); a o и a 1 — параметры уравнения, которые могут быть найдены методом наименьших квадратов.

Для нахождения искомых параметров нужно составить систему уравнений, которая в данном случае будет иметь вид

Полученная система может быть решена известным из школьного курса методом Гаусса. Искомые параметры системы из двух нормальных уравнений можно вычислить и непосредственно с помощью последовательного использования нижеприведенных формул:

где y i — i-e значение результативного признака; x i — i-e значение факторного признака; и — средние арифметические результативного и факторного признаков соответственно; n— число значений признака y i , или, что то же самое, число значений признака x i .

Пример 9. Найдем уравнение линейной связи между величиной сбора хлеба (у) и размером посева (х) по данным табл. 4. Проделав необходимые вычисления, получим из (6.17):

Таким образом, уравнение связи, или, как принято говорить, уравнение регрессии, выглядит следующим образом:

Интерпретация коэффициента регрессии. Уравнение регрессии не только определяет форму анализируемой связи, но и показывает, в какой степени изменение одного признака сопровождается изменением другого признака.

Коэффициент при х, называемый коэффициентом регрессии, показывает, на какую величину в среднем изменяется результативный признак у при изменении факторного признака х на единицу.

В примере 9 коэффициент регрессии получился равным 24,58. Следовательно, с увеличением посева, приходящегося на душу, на одну десятину сбор хлеба на душу населения в среднем увеличивается на 24,58 пуда.

Средняя и предельная ошибки коэффициента регрессии. Поскольку уравнения регрессии рассчитываются, как правило, для выборочных данных, обязательно встают вопросы точности и надежности полученных результатов. Вычисленный коэффициент регрессии, будучи выборочным, с некоторой точностью оценивает соответствующий коэффициент регрессии генеральной совокупности. Представление об этой точности дает средняя ошибка коэффициента регрессии ( ), рассчитываемая по формуле

у i , — i-e значение результативного признака; ŷ i — i-e выравненное значение, полученное из уравнения (6.15); x i —i-e значение факторного признака; σ x —среднее квадратическое отклонение х; n — число значений х или, что то же самое, значений у; m—число факгорных признаков (независимых переменных).

В формуле (6.18), в частности, формализовано очевидное положение: чем больше фактические значения отклоняются от выравненных, тем большую ошибку следует ожидать; чем меньше число наблюдений, на основе которых строится уравнение, тем больше будет ошибка.

Средняя ошибка коэффициента регрессии является основой для расчета предельной ошибки. Последняя показывает, в каких пределах находится истинное значение коэффициента регрессии при заданной надежности результатов. Предельная ошибка коэффициента регрессии вычисляется аналогично предельной ошибке средней арифметической (см. гл. 5), т. е. как t где t—величина, числовое значение которой определяется в зависимости от принятого уровня надежности.

Пример 10. Найти среднюю и предельную ошибки коэффициента регрессии, полученного в примере 9.

Для расчета прежде всего подсчитаем выравненные значения ŷ i для чего в уравнение регрессии, полученное в примере 9, подставим конкретные значения x i :

ŷ i = 17,6681 +24,5762*0,91 = 40,04 и т. д.

Затем вычислим отклонения фактических значений у i , от выравненных и их квадраты

Далее, подсчитав средний по черноземным губерниям посев на душу ( =0,98), отклонения фактических значений x i от этой средней, квадраты отклонений и среднее квадратическое отклонение , получим все необходимые составляющие формул (618) и (619):

Таким образом, средняя ошибка коэффициента регрессии равна 2,89, что составляет 12% от вычисленного коэффициента

Задавшись уровнем надежности, равным 0,95, найдем по табл. 1 приложения соответствующее ему значение t=1,96, рассчитаем предельную ошибку 1,96*2,89=5,66 и пределы коэффициента регрессии для принятого уровня надежности ( В случае малых выборок величина t находится из табл. 2 приложения. ). Нижняя граница коэффициента регрессии равна 24,58-5,66=18,92, а верхняя граница 24,58+5,66=30,24

Средняя квадратическая ошибка линии регрессии. Уравнение регрессии представляет собой функциональную связь, при которой по любому значению х можно однозначно определить значение у. Функциональная связь лишь приближенно отражает связь реальную, причем степень этого приближения может быть различной и зависит она как от свойств исходных данных, так и от выбора вида функции, по которой производится выравнивание.

На рис. 15 представлены два различных случая взаимоотношения между двумя признаками. В обоих случаях предполагаемая связь описывается одним и тем же уравнением, но во втором случае соотношение между признаками х и у достаточно четко выражено и уравнение, по-видимому, довольно хорошо описывает это соотношение, тогда как в первом случае сомнительно само наличие сколько-нибудь закономерного соотношения между признаками. И в том, и в другом случаях, несмотря на их существенное различие, метод наименьших квадратов дает одинаковое уравнение, поскольку этот метод нечувствителен к потенциальным возможностям исходного материала вписаться в ту или иную схему. Кроме того, метод наименьших квадратов применяется для расчета неизвестных параметров заранее выбранного вида функции, и вопрос о выборе наиболее подходящего для конкретных данных вида функции в рамках этого метода не ставится и не решается. Таким образом, при пользовании методом наименьших квадратов открытыми остаются два важных вопроса, а именно: существует ли связь и верен ли выбор вида функции, с помощью которой делается попытка описать форму связи.

Чтобы оценить, насколько точно уравнение регрессии описывает реальные соотношения между переменными, нужно ввести меру рассеяния фактических значений относительно вычисленных с помощью уравнения. Такой мерой служит средняя квадратическая ошибка регрессионного уравнения, вычисляемая по приведенной выше формуле (6.19).

Пример 11. Определить среднюю квадратическую ошибку уравнения, полученного в примере 9.

Промежуточные расчеты примера 10 дают нам среднюю квадратическую ошибку уравнения. Она равна 4,6 пуда.

Этот показатель аналогичен среднему квадратическому отклонению для средней. Подобно тому, как по величине среднего квадратического отклонения можно судить о представительности средней арифметической (см. гл. 5), по величине средней квадратической ошибки регрессионного уравнения можно сделать вывод о том, насколько показательна для соотношения между признаками та связь, которая выявлена уравнением. В каждом конкретном случае фактическая ошибка может оказаться либо больше, либо меньше средней. Средняя квадратическая ошибка уравнения показывает, насколько в среднем мы ошибемся, если будем пользоваться уравнением, и тем самым дает представление о точности уравнения. Чем меньше σ y.x , тем точнее предсказание линии регрессии, тем лучше уравнение регрессии описывает существующую связь. Показатель σ y.x позволяет различать случаи, представленные на рис. 15. В случае б) он окажется значительно меньше, чем в случае а). Величина σ y.x зависит как от выбора функции, так и от степени описываемой связи.

Варьируя виды функций для выравнивания и оценивая результаты с помощью средней квадратической ошибки, можно среди рассматриваемых выбрать лучшую функцию, функцию с наименьшей средней ошибкой. Но существует ли связь? Значимо ли уравнение регрессии, используемое для отображения предполагаемой связи? На эти вопросы отвечает определяемый ниже критерий значи-мости регрессии.

Мерой значимости линии регрессии может служить следующее соотношение:

где ŷ i —i-e выравненное значение; —средняя арифметическая значений y i ; σ y.x —средняя квадратическая ошибка регрессионного уравнения, вычисляемая по формуле (6.19); n—число сравниваемых пар значений признаков; m—число факторных признаков.

Действительно, связь тем больше, чем значительнее мера рассеяния признака, обусловленная регрессией, превосходит меру рассеяния отклонений фактических значений от выравненных.

Соотношение (6.20) позволяет решить вопрос о значимости регрессии. Регрессия значима, т. е. между признаками существует линейная связь, если для данного уровня значимости вычисленное значение F ф [m,n-(m+1)] превышает критическое значение F кр [m,n-(m+1)], стоящее на пересечении m-го столбца и [n—(m+1)]-й строки специальной таблицы ( см. табл. 4 приложения ).

Пример 12. Выясним, связаны ли сбор хлеба на душу населения и посев на душу населения линейной зависимостью.

Воспользуемся F-критерием значимости регрессии. Подставив в формулу (6.20) данные табл. 4 и результат примера 10, получим

Обращаясь к таблице F-распределения для Р=0,95 (α=1—Р=0,5) и учитывая, что n=23, m =1, в табл. 4А приложения на пересечения 1-го столбца и 21-й строки находим критическое значение F кр , равное 4,32 при степени надежности Р=0,95. Поскольку вычисленное значение F ф существенно превосходит по величине F кр , то обнаруженная линейная связь существенна, т. е. априорная гипотеза о наличии линейной связи подтвердилась. Вывод сделан при степени надежности P=0,95. Между прочим, вывод в данном случае останется прежним, если надежность повысить до Р=0,99 (соответствующее значение F кр =8,02 по табл. 4Б приложения для уровня значимости α=0,01).

Коэффициент детерминации. С помощью F-критерия мы Установили, что существует линейная зависимость между величиной сбора хлеба и величиной посева на душу. Следовательно, можно утверждать, что величина сбора хлеба, приходящегося на душу, линейно зависит от величины посева на душу. Теперь уместно поставить уточняющий вопрос — в какой степени величина посева на душу определяет величину сбора хлеба на душу? На этот вопрос можно ответить, рассчитав, какая часть вариации результативного признака может быть объяснена влиянием факторного признака.

Оно показывает долю разброса, учитываемого регрессией, в общем разбросе результативного признака и носит название коэффициента детерминации. Этот показатель, равный отношению факторной вариации к полной вариации признака, позволяет судить о том, насколько «удачно» выбран вид функции ( Отметим, что по смыслу коэффициент детерминации в регрессионном анализе соответствует квадрату корреляционного отношения для корреляционной таблицы (см. § 2). ). Проведя расчеты, основанные на одних и тех же исходных данных, для нескольких типов функций, мы можем из них выбрать такую, которая дает наибольшее значение R 2 и, следовательно, в большей степени, чем другие функции, объясняет вариацию результативного признака. Действительно, при расчете R 2 для одних и тех же данных, но разных функций знаменатель выражения (6.21) остается неизменным, а числитель показывает ту часть вариации результативного признака, которая учитывается выбранной функцией. Чем больше R 2 , т. е. чем больше числитель, тем больше изменение факторного признака объясняет изменение результативного признака и тем, следовательно, лучше уравнение регрессии, лучше выбор функции.

Наконец, отметим, что введенный ранее, при изложении методов корреляционного анализа, коэффициент детерминации совпадает с определенным здесь показателем, если выравнивание производится По прямой линии. Но последний показатель (R 2 ) имеет более широкий спектр применения и может использоваться в случае связи, отличной от линейной ( см. § 4 данной главы ).

Пример 13. Рассчитать коэффициент детерминации для уравнения, полученного в примере 9.

Вычислим R 2 , воспользовавшись формулой (6.21) и данными табл. 4:

Итак, уравнение регрессии почти на 78% объясняет колебания сбора хлеба на душу. Это немало, но, По-видимому, можно улучшить модель введением в нее еще одного фактора.

Случай двух независимых переменных. Простейший случай множественной регрессии. В предыдущем изложении регрессионного анализа мы имели дело с двумя признаками — результативным и факторным. Но на результат действует обычно не один фактор, а несколько, что необходимо учитывать для достаточно полного анализа связей.

В математической статистике разработаны методы множественной регрессии ( Регрессия называется множественной, если число независимых переменных, учтенных в ней, больше или равно двум. ), позволяющие анализировать влияние на результативный признак нескольких факторных. К рассмотрению этих методов мы и переходим.

Возвратимся к примеру 9. В нем была определена форма связи между величиной сбора хлеба на душу и размером посева на душу. Введем в анализ еще один фактор — уровень урожайности (см. столбец З табл. 4). Без сомнения, эта переменная влияет на сбор хлеба на душу. Но в какой степени влияет? Насколько обе независимые переменные определяют сбор хлеба на душу в черноземных губерниях? Какая из переменных — посев на душу или урожайность — оказывает определяющее влияние на сбор хлеба? Попытаемся ответить на эти вопросы.

После добавления второй независимой переменной уравнение регрессии будет выглядеть так:

где у—сбор хлеба на душу; х 1 —размер посева на душу; x 2 —урожай с десятины (в пудах); а 0 , а 1 , а 2 —параметры, подлежащие определению.

Для нахождения числовых значений искомых параметров, как и в случае одной независимой переменной, пользуются методом наименьших квадратов. Он сводится к составлению и решению системы нормальных уравнений, которая имеет вид

Когда система состоит из трех и более нормальных уравнений, решение ее усложняется. Существуют стандартные программы расчета неизвестных параметров регрессионного уравнения на ЭВМ. При ручном счете можно воспользоваться известным из школьного курса методом Гаусса.

Пример 14. По данным табл. 4 описанным способом найдем параметры a 0 , а 1 , а 2 уравнения (6.22). Получены следующие результаты: a 2 =0,3288, a 1 =28,7536, a 0 =-0,2495.

Таким образом, уравнение множественной регрессии между величиной сбора хлеба на душу населения (у), размером посева на душу (x 1 ) и уровнем урожайности (х 2 ) имеет вид:

у=-0,2495+28,7536x 1 +0,3288x 2 .

Интерпретация коэффициентов уравнения множественной регрессии. Коэффициент при х 1 в полученном уравнении отличается от аналогичного коэффициента в уравнении примера 9.

Коэффициент при независимой переменной в уравнении простой регрессии отличается от коэффициента при соответствующей переменной в уравнении множественной регрессии тем, что в последнем элиминировано влияние всех учтенных в данном уравнении признаков.

Коэффициенты уравнения множественной регрессии поэтому называются частными или чистыми коэффициентами регрессии.

Частный коэффициент множественной регрессии при х 1 показывает, что с увеличением посева на душу на 1 дес. и при фиксированной урожайности сбор хлеба на душу населения вырастает в среднем на 28,8 пуда. Частный коэффициент при x 2 показывает, что при фиксированном посеве на душу увеличение урожая на единицу, т. е. на 1 пуд с десятины, вызывает в среднем увеличение сбора хлеба на душу на 0,33 пуда. Отсюда можно сделать вывод, что увеличение сбора хлеба в черноземных губерниях России идет, в основном, за счет расширения посева и в значительно меньшей степени—за счет повышения урожайности, т. е. экстенсивная форма развития зернового хозяйства является господствующей.

Введение переменной х 2 в уравнение позволяет уточнить коэффициент при х 1 . Конкретно, коэффициент оказался выше (28,8 против 24,6), когда в изучаемой связи вычленилось влияние урожайности на сбор хлеба.

Однако выводы, полученные в результате анализа коэффициентов регрессии, не являются пока корректными, поскольку, во-первых, не учтена разная масштабность факторов, во-вторых, не выяснен вопрос о значимости коэффициента a 2 .

Величина коэффициентов регрессии изменяется в зависимости от единиц измерения, в которых представлены переменные. Если переменные выражены в разном масштабе измерения, то соответствующие им коэффициенты становятся несравнимыми. Для достижения сопоставимости коэффициенты регрессии исходного уравнения стандартизуют, взяв вместо исходных переменных их отношения к собственным средним квадратическим отклонениям. Тогда уравнение (6.22) приобретает вид

Сравнивая полученное уравнение с уравнением (6.22), определяем стандартизованные частные коэффициенты уравнения, так называемые бета-коэффициенты, по формулам:

где β 1 и β 2 —бета-коэффициенты; а 1 и а 2 —коэффициенты регрессии исходного уравнения; σ у , , и — средние квадратические отклонения переменных у, х 1 и х 2 соответственно.

Вычислив бета-коэффициенты для уравнения, полученного в примере 14:

видим, что вывод о преобладании в черноземной полосе россии экстенсивной формы развития хозяйства над интенсивной остается в силе, так как β 1 значительно больше, чем β 2 .

Оценка точности уравнения множественной регрессии.

Точность уравнения множественной регрессии, как и в случае уравнения с одной независимой переменной, оценивается средней квадратической ошибкой уравнения. Обозначим ее , где подстрочные индексы указывают, что результативным признаком в уравнении является у, а факторными признаками х 1 и x 2 . Для расчета средней квадратической ошибки уравнения множественной регрессии применяется приведенная выше формула (6.19).

Пример 15. Оценим точность полученного в примере 14 уравнения регрессии.

Воспользовавшись формулой (6.19) и данными табл. 4, вычислим среднюю квадратическую ошибку уравнения:

Оценка полезности введения дополнительной переменной. Точность уравнения регрессии тесно связана с вопросом ценности включения дополнительных членов в это уравнение.

Сравним средние квадратические ошибки, рассчитанные для уравнения с одной переменной х 1 (пример 11) и для уравнения с двумя независимыми переменными х 1 и х 2 . Включение в уравнение новой переменной (урожайности) уменьшило среднюю квадратическую ошибку почти вдвое.

Можно провести сравнение ошибок с помощью коэффициентов вариации

где σ f —средняя квадратическая ошибка регрессионного уравнения; —средняя арифметическая результативного признака.

Для уравнения, содержащего одну независимую переменную:

Для уравнения, содержащего две независимые переменные:

Итак, введение независимой переменной «урожайность» уменьшило среднюю квадратическую ошибку до величины порядка 7,95% среднего значения зависимой переменной.

Наконец, по формуле (6.21) рассчитаем коэффициент детерминации

Он показывает, что уравнение регрессии на 81,9% объясняет колебания сбора хлеба на душу населения. Сравнивая полученный результат (81,9%) с величиной R 2 для однофакторного уравнения (77,9%), видим, что включение переменной «урожайность» заметно увеличило точность уравнения.

Таким образом, сравнение средних квадратических ошибок уравнения, коэффициентов вариации, коэффициентов детерминации, рассчитанных до и после введения независимой переменной, позволяет судить о полезности включения этой переменной в уравнение. Однако следует быть осторожными в выводах при подобных сравнениях, поскольку увеличение R 2 или уменьшение σ и V σ не всегда имеют приписываемый им здесь смысл. Так, увеличение R 2 может объясняться тем фактом, что число рассматриваемых параметров в уравнении приближается к числу объектов наблюдения. Скажем, весьма сомнительными будут ссылки на увеличение R 2 или уменьшение σ, если в уравнение вводится третья или четвертая независимая переменная и уравнение строится на данных по шести, семи объектам.

Полезность включения дополнительного фактора можно оценить с помощью F-критерия.

Частный F-критерий показывает степень влияния дополнительной независимой переменной на результативный признак и может использоваться при решении вопроса о добавлении в уравнение или исключении из него этой независимой переменной.

Разброс признака, объясняемый уравнением регрессии (6.22), можно разложить на два вида: 1) разброс признака, обусловленный независимой переменной х 1 , и 2) разброс признака, обусловленный независимой переменной x 2 , когда х 1 уже включена в уравнение. Первой составляющей соответствует разброс признака, объясняемый уравнением (6.15), включающим только переменную х 1 . Разность между разбросом признака, обусловленным уравнением (6.22), и разбросом признака, обусловленным уравнением (6.15), определит ту часть разброса, которая объясняется дополнительной независимой переменной x 2 . Отношение указанной разности к разбросу признака, регрессией не объясняемому, представляет собой значение частного критерия. Частный F-критерий называется также последовательным, если статистические характеристики строятся при последовательном добавлении переменных в регрессионное уравнение.

Пример 16. Оценить полезность включения в уравнение регрессии дополнительной переменной «урожайность» (по данным и результатам примеров 12 и 15).

Разброс признака, объясняемый уравнением множественной регрессии и рассчитываемый как сумма квадратов разностей выравненных значений и их средней, равен 1623,8815. Разброс признака, объясняемый уравнением простой регрессии, составляет 1545,1331.

Разброс признака, регрессией не объясняемый, определяется квадратом средней квадратической ошибки уравнения и равен 10,9948 (см. пример 15).

Воспользовавшись этими характеристиками, рассчитаем частный F-критерий

С уровнем надежности 0,95 (α=0,05) табличное значение F (1,20), т. е. значение, стоящее на пересечении 1-го столбца и 20-й строки табл. 4А приложения, равно 4,35. Рассчитанное значение F ф значительно превосходит табличное, и, следовательно, включение в уравнение переменной «урожайность» имеет смысл.

Таким образом, выводы, сделанные ранее относительно коэффициентов регрессии, вполне правомерны.

Важным условием применения к обработке данных метода множественной регрессии является отсутствие сколько-нибудь значительной взаимосвязи между факторными признаками. При практическом использовании метода множественной регрессии, прежде чем включать факторы в уравнение, необходимо убедиться в том, что они независимы.

Если один из факторов зависит линейно от другого, то система нормальных уравнений, используемая для нахождения параметров уравнения, не разрешима. Содержательно этот факт можно толковать так: если факторы х 1 и x 2 связаны между собой, то они действуют на результативный признак у практически как один фактор, т. е. сливаются воедино и их влияние на изменение у разделить невозможно. Когда между независимыми переменными уравнения множественной регрессии имеется линейная связь, следствием которой является неразрешимость системы нормальных уравнений, то говорят о наличии мультиколлинеарности.

На практике вопрос о наличии или об отсутствии мультиколлинеарности решается с помощью показателей взаимосвязи. В случае двух факторных признаков используется парный коэффициент корреляции между ними: если этот коэффициент по абсолютной величине превышает 0,8, то признаки относят к числу мультиколлинеарных. Если число факторных признаков больше двух, то рассчитываются множественные коэффициенты корреляции. Фактор признается мультиколлинеарным, если множественный коэффициент корреляции, характеризующий совместное влияние на этот фактор остальных факторных признаков, превзойдет по величине коэффициент множественной корреляции между результативным признаком и совокупностью всех независимых переменных.

Самый естественный способ устранения мультиколлинеарности — исключение одного из двух линейно связанных факторных признаков. Этот способ прост, но не всегда приемлем, так как подлежащий исключению фактор может оказывать на зависимую переменную особое влияние. В такой ситуации применяются более сложные методы избавления от мультиколлинеарности ( См.: Мот Ж. Статистические предвидения и решения на предприятии. М., 1966; Ковалева Л. Н. Многофакторное прогнозирование на основе рядов динамики. М., 1980. ).

Выбор «наилучшего» уравнения регрессии. Эта проблема связана с двойственным отношением к вопросу о включении в регрессионное уравнение независимых переменных. С одной стороны, естественно стремление учесть все возможные влияния на результативный признак и, следовательно, включить в модель полный набор выявленных переменных. С другой стороны, возрастает сложность расчетов и затраты, связанные с получением максимума информации, могут оказаться неоправданными. Нельзя забывать и о том, что для построения уравнения регрессии число объектов должно в несколько раз превышать число независимых переменных. Эти противоречивые требования приводят к необходимости компромисса, результатом которого и является «наилучшее» уравнение регрессии. Существует несколько методов, приводящих к цели: метод всех возможных регрессий, метод исключения, метод включения, шаговый регрессионный и ступенчатый регрессионный методы.

Метод всех возможных регрессий заключается в переборе и сравнении всех потенциально возможных уравнений. В качестве критерия сравнения используется коэффициент детерминации R 2 . «Наилучшим» признается уравнение с наибольшей величиной R 2 . Метод весьма трудоемок и предполагает использование вычислительных машин.

Методы исключения и включения являются усовершенствованными вариантами предыдущего метода. В методе исключения в качестве исходного рассматривается регрессионное уравнение, включающее все возможные переменные. Рассчитывается частный F-критерий для каждой из переменных, как будто бы она была последней переменной, введенной в регрессионное уравнение. Минимальная величина частного F-критерия (F min ) сравнивается с критической величиной (F кр ), основанной на заданном исследователем уровне значимости. Если F min >F кр , то уравнение остается без изменения. Если F min кр , то переменная, для которой рассчитывался этот частный F-критерий, исключается. Производится перерасчет уравнения регрессии для оставшихся переменных, и процедура повторяется для нового уравнения регрессии. Исключение из рассмотрения уравнений с незначимыми переменными уменьшает объем вычислений, что является достоинством этого метода по сравнению с предыдущим.

Метод включения состоит в том, что в уравнение включаются переменные по степени их важности до тех пор, пока уравнение не станет достаточно «хорошим». Степень важности определяется линейным коэффициентом корреляции, показывающим тесноту связи между анализируемой независимой переменной и результативным признаком: чем теснее связь, тем больше информации о результирующем признаке содержит данный факторный признак и тем важнее, следовательно, введение этого признака в уравнение.

Процедура начинается с отбора факторного признака, наиболее тесно связанного с результативным признаком, т. е. такого факторного признака, которому соответствует максимальный по величине парный линейный коэффициент корреляции. Далее строится линейное уравнение регрессии, содержащее отобранную независимую переменную. Выбор следующих переменных осуществляется с помощью частных коэффициентов корреляции, в которых исключается влияние вошедших в модель факторов. Для каждой введенной переменной рассчитывается частный F-критерий, по величине которого судят о том, значим ли вклад этой переменной. Как только величина частного F-критерия, относящаяся к очередной переменной, оказывается незначимой, т. е. эффект от введения этой переменной становится малозаметным, процесс включения переменных заканчивается. Метод включения связан с меньшим объемом вычислений, чем предыдущие методы. Но при введении новой переменной нередко значимость включенных ранее переменных изменяется. Метод включения этого не учитывает, что является его недостатком. Модификацией метода включения, исправляющей этот недостаток, является шаговый регрессионный метод.

Шаговый регрессионный метод кроме процедуры метода включения содержит анализ переменных, включенных в уравнение на предыдущей стадии. Потребность в таком анализе возникает в связи с тем, что переменная, обоснованно введенная в уравнение на ранней стадии, может оказаться лишней из-за взаимосвязи ее с переменными, позднее включенными в уравнение. Анализ заключается в расчете на каждом этапе частных F-критериев для каждой переменной уравнения и сравнении их с величиной F кр , точкой F-распределения, соответствующей заданному исследователем уровню значимости. Частный F-критерий показывает вклад переменной в вариацию результативного признака в предположении, что она вошла в модель последней, а сравнение его с F кр позволяет судить о значимости рассматриваемой переменной с учетом влияния позднее включенных факторов. Незначимые переменные из уравнения исключаются.

Рассмотренные методы предполагают довольно большой объем вычислений и практически неосуществимы без ЭВМ. Для реализации ступенчатого регрессионного метода вполне достаточно малой вычислительной техники.

Ступенчатый регрессионный метод включает в себя такую последовательность действий. Сначала выбирается наиболее тесно связанная с результативным признаком переменная и составляется уравнение регрессии. Затем находят разности фактических и выравненных значений и эти разности (остатки) рассматриваются как значения результативной переменной. Для остатков подбирается одна из оставшихся независимых переменных и т. д. На каждой стадии проверяется значимость регрессии. Как только обнаружится незначимость, процесс прекращается и окончательное уравнение получается суммированием уравнений, полученных на каждой стадии за исключением последней.

Ступенчатый регрессионный метод менее точен, чем предыдущие, но не столь громоздок. Он оказывается полезным в случаях, когда необходимо внести содержательные правки в уравнение. Так, для изучения факторов, влияющих на цены угля в Санкт-Петербурге в конце XIX— начале XX в., было получено уравнение множественной регрессии. В него вошли следующие переменные: цены угля в Лондоне, добыча угля в России и экспорт из России. Здесь не обосновано появление в модели такого фактора, как добыча угля, поскольку Санкт-Петербург работал исключительно на импортном угле. Модели легко придать экономический смысл, если независимую переменную «добыча» заменить независимой переменной «импорт». Формально такая замена возможна, поскольку между импортом и добычей существует тесная связь. Пользуясь ступенчатым методом, исследователь может совершить эту замену, если предпочтет содержательно интерпретируемый фактор.

§ 4. Нелинейная регрессия и нелинейная корреляция

Построение уравнений нелинейной регрессии. До сих пор мы, в основном, изучали связи, предполагая их линейность. Но не всегда связь между признаками может быть достаточно хорошо представлена линейной функцией. Иногда для описания существующей связи более пригодными, а порой и единственно возможными являются более сложные нелинейные функции. Ограничимся рассмотрением наиболее простых из них.

Одним из простейших видов нелинейной зависимости является парабола, которая в общем виде может быть представлена функцией (6.2):

Неизвестные параметры а 0 , а 1 , а 2 находятся в результате решения следующей системы уравнений:

Дает ли преимущества описание связи с помощью параболы по сравнению с описанием, построенным по гипотезе линейности? Ответ на этот вопрос можно получить, рассчитав последовательный F-критерий, как это делалось в случае множественной регрессии (см. пример 16).

На практике для изучения связей используются полиномы более высоких порядков (3-го и 4-го порядков). Составление системы, ее решение, а также решение вопроса о полезности повышения порядка функции для этих случаев аналогичны описанным. При этом никаких принципиально новых моментов не возникает, но существенно увеличивается объем расчетов.

Кроме класса парабол для анализа нелинейных связей можно применять и другие виды функций. Для расчета неизвестных параметров этих функций рекомендуется использовать метод наименьших квадратов, как наиболее мощный и широко применяемый.

Однако метод наименьших квадратов не универсален, поскольку он может использоваться только при условии, что выбранные для выравнивания функции линейны по отношению к своим параметрам. Не все функции удовлетворяют этому условию, но большинство применяемых на практике с помощью специальных преобразований могут быть приведены к стандартной форме функции с линейными параметрами.

Рассмотрим некоторые простейшие способы приведения функций с нелинейными параметрами к виду, который позволяет применять к ним метод наименьших квадратов.

Функция не является линейной относительно своих параметров.

Прологарифмировав обе части приведенного равенства

получим функцию, линейную относительно своих новых параметров:

Кроме логарифмирования для приведения функций к нужному виду используют обратные величины.

с помощью следующих переобозначений:

может быть приведена к виду

Подобные преобразования расширяют возможности использования метода наименьших квадратов, увеличивая число функций, к которым этот метод применим.

Измерение тесноты связи при криволинейной зависимости. Рассмотренные ранее линейные коэффициенты корреляции оценивают тесноту взаимосвязи при линейной связи между признаками. При наличии криволинейной связи указанные меры связи не всегда приемлемы. Разберем подобную ситуацию на примере.

Пример 17. В 1-м и 2-м столбцах табл. 5 приведены значения результативного признака у и факторного признака х (данные условные). Поставив вопрос о тесноте связи между ними, рассчитаем парный линейный коэффициент корреляции по формуле (6.3). Он оказался равным нулю, что свидетельствует об отсутствии линейной связи. Тем не менее связь между признаками существует, более того, она является функциональной и имеет вид

Для измерения тесноты связи при криволинейной зависимости используется индекс корреляции, вычисляемый по формуле

где у i —i-e значение результативного признака; ŷ i —i-e выравненное значение этого признака; —среднее арифметическое значение результативного признака.

Числитель формулы (6.27) характеризует разброс выравненных значений результативного признака. Поскольку изменения выравненных, т. е. вычисленных по уравнению регрессии, значений признака происходят только в результате изменения факторного признака х. то числитель измеряет разброс результативного признака, обусловленный влиянием на него факторного признака. Знаменатель же измеряет разброс признака-результата, который определен влиянием на него всех факторов, в том числе и учтенного. Таким образом, индекс корреляции оценивает участие данного факторного признака в общем действии всего комплекса факторов, вызывающих колеблемость результативного признака, тем самым определяя тесноту зависимости признака у от признака х. При этом, если признак х не вызывает никаких изменений признака у, то числитель и, следовательно, индекс корреляции равны 0. Если же линия регрессии полностью совпадает с фактическими данными, т. е. признаки связаны функционально, как в примере 17, то индекс корреляции равен 1. В случае линейной зависимости между х и у индекс корреляции численно равен линейному коэффициенту корреляции г. Квадрат индекса корреляции совпадает с введенным ранее (6.21) коэффициентом детерминации. Если же вопрос о форме связи не ставится, то роль коэффициента детерминации играет квадрат корреляционного отношения η 2 y/x (6.12).

Таковы основные принципы и условия, методика и техника применения корреляционного и регрессионного анализа. Их подробное рассмотрение обусловлено тем, что они являются высокоэффективными и потому очень широко применяемыми методами анализа взаимосвязей в объективном мире природы и общества. Корреляционный и регрессионный анализ широко и успешно применяются и в исторических исследованиях.

R — значит регрессия

Статистика в последнее время получила мощную PR поддержку со стороны более новых и шумных дисциплин — Машинного Обучения и Больших Данных. Тем, кто стремится оседлать эту волну необходимо подружится с уравнениями регрессии. Желательно при этом не только усвоить 2-3 приемчика и сдать экзамен, а уметь решать проблемы из повседневной жизни: найти зависимость между переменными, а в идеале — уметь отличить сигнал от шума.

Для этой цели мы будем использовать язык программирования и среду разработки R, который как нельзя лучше приспособлен к таким задачам. Заодно, проверим от чего зависят рейтинг Хабрапоста на статистике собственных статей.