От автора: хотите составить для своего проекта файл с указаниями для робота, но не знаете как? Сегодня разберемся, как посмотреть robots.txt сайта и изменить его под свои нужды.

В интернете каждый день появляются готовые решения по той или иной проблеме. Нет денег на дизайнера? Используйте один из тысяч бесплатных шаблонов. Не хотите нанимать сео-специалиста? Воспользуйтесь услугами какого-нибудь известного бесплатного сервиса, почитайте сами пару статей.

Уже давно нет необходимости самому с нуля писать тот же самый robots.txt. К слову, это специальный файл, который есть практически на любом сайте, и в нем содержатся указания для поисковых роботов. Синтаксис команд очень простой, но все равно на составление собственного файла уйдет время. Лучше посмотреть у другого сайта. Тут есть несколько оговорок:

Сайт должен быть на том же движке, что и ваш. В принципе, сегодня в интернете куча сервисов, где можно узнать название cms практически любого веб-ресурса.

Это должен быть более менее успешный сайт, у которого все в порядке с поисковым трафиком. Это говорит о том, что robots.txt составлен нормально.

Профессия Frontend-разработчик PRO

Готовим Frontend-разработчиков с нуля

На курсе вы научитесь создавать интерфейсы веб-сервисов с помощью языков программирования и

дополнительных технологий. Сможете разрабатывать планировщики задач, мессенджеры, интернет-магазины…

Узнать подробнее

До 10 проектов в портфолио для старта карьеры

Подходит для новичков без опыта в программировании

Практика на вебинарах с разработчиками из крупных компаний

Профессия Frontend-разработчик PRO

Готовим Frontend-разработчиков с нуля

На курсе вы научитесь создавать интерфейсы веб-сервисов с помощью языков программирования и

дополнительных технологий. Сможете разрабатывать планировщики задач, мессенджеры, интернет-магазины…

Узнать подробнее

До 10 проектов в портфолио для старта карьеры

Подходит для новичков без опыта в программировании

Практика на вебинарах с разработчиками из крупных компаний

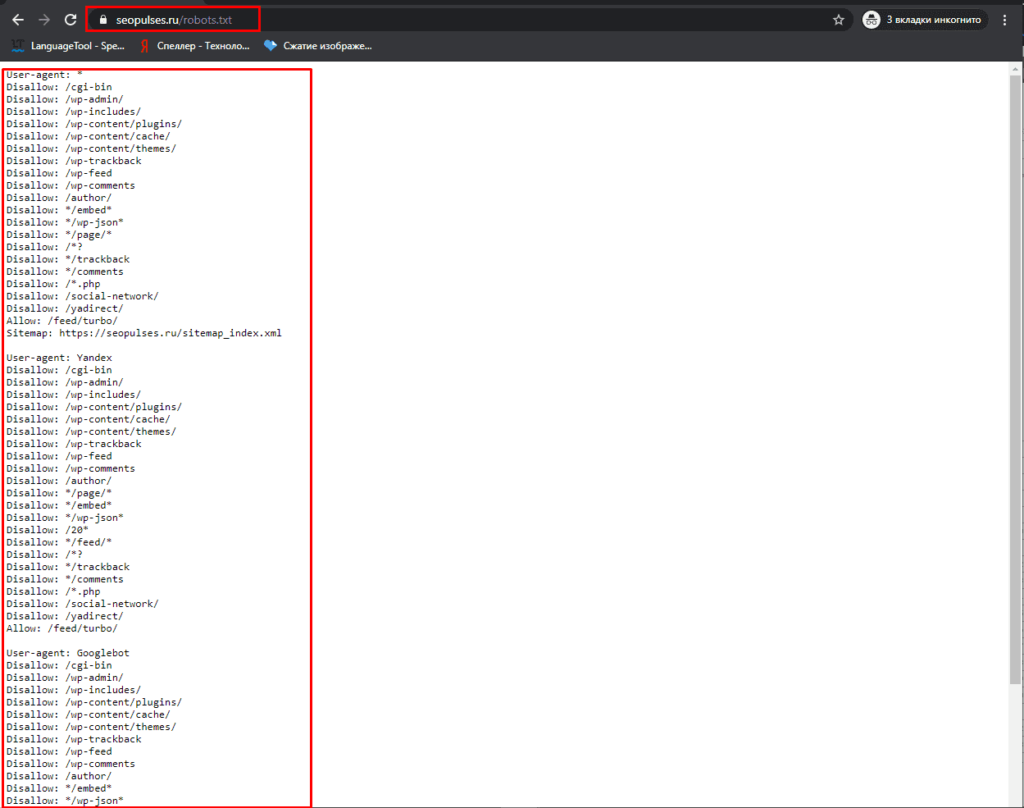

Итак, чтобы посмотреть этот файл нужно в адресной строке набрать: доменное-имя.зона/robots.txt

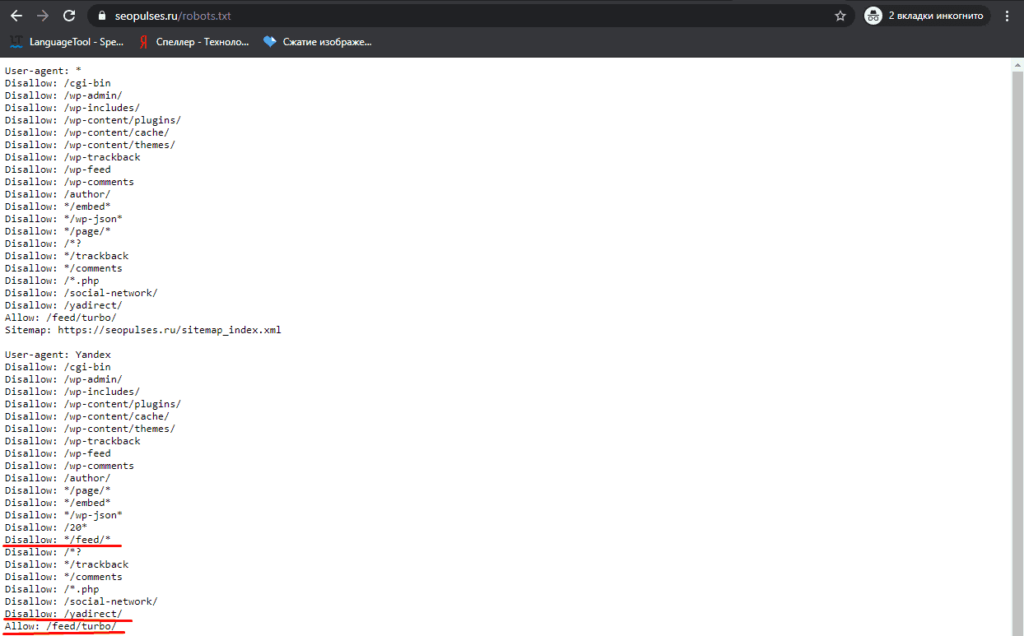

Все неверятно просто, правда? Если адрес не будет найден, значит такого файла на сайте нет, либо к нему закрыт доступ. Но в большинстве случаев вы увидите перед собой содержимое файла:

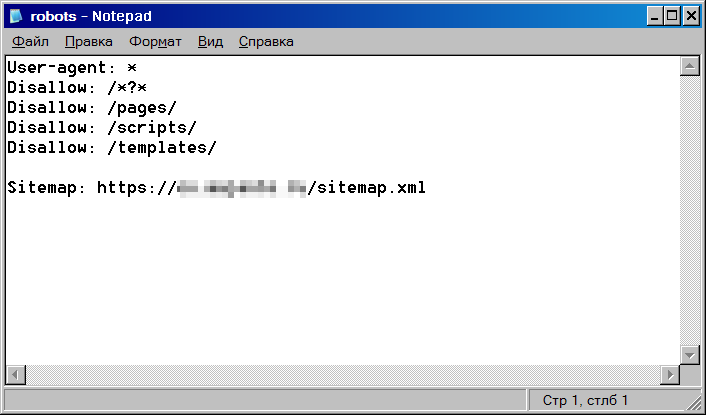

В принципе, даже человек не особо разбирающийся в коде быстро поймет, что тут написать. Команда allow разрешает что-либо индексировать, а disallow – запрещает. User-agent – это указание поисковых роботов, к которым обращены инструкции. Это необходимо в том случае, когда нужно указать команды для отдельного поисковика.

Что делать дальше?

Скопировать все и изменить под свой сайт. Как изменять? Я уже говорил, что движки сайтов должны совпадать, иначе изменять что-либо бессмысленно – нужно переписывать абсолютно все.

Итак, вам необходимо будет пройтись по строкам и определить, какие разделы из указанных присутствуют на вашем сайте, а какие – нет. На скриншоте выше вы видите пример robots.txt для wordpress сайта, причем в отдельном каталоге есть форум. Вывод? Если у вас нет форума, все эти строки нужно удалить, так как подобных разделов и страниц у вас просто не существует, зачем тогда их закрывать?

Самый простой robots.txt может выглядеть так:

|

User—agent: * Disallow: /wp—admin Disallow: /wp—includes Disallow: /wp—content Allow: /wp—content/uploads/ |

Все вы наверняка знаете стандартную структуру папок в wordpress, если хотя бы 1 раз устанавливали этот движок. Это папки wp-admin, wp-content и wp-includes. Обычно все 3 закрывают от индексации, потому что они содержат чисто технические файлы, необходимые для работы движка, плагинов и шаблонов.

Каталог uploads открывают, потому что в нем содержаться картинки, а их обыно индексируют.

В общем, вам нужно пройтись по скопированному robots.txt и просмотреть, что из написанного действительно есть на вашем сайте, а чего нет. Конечно, самому определить будет трудно. Я могу лишь сказать, что если вы что-то не удалите, то ничего страшного, просто лишняя строчка будет, которая никак не вредит (потому что раздела нет).

Так ли важна настройка robots.txt?

Конечно, необходимо иметь этот файл и хотя бы основные каталоги через него закрыть. Но критично ли важно его составление? Как показывает практика, нет. Я лично вижу сайты на одних движках с абсолютно разным robots.txt, которые одинаково успешно продвигаются в поисковых системах.

Я не спорю, что можно совершить какую-то ошибку. Например, закрыть изображения или оставить открытым ненужный каталог, но чего-то супер страшного не произойдет. Во-первых, потому что поисковые системы сегодня умнее и могут игнорировать какие-то указание из файла. Во-вторых, написаны сотни статей о настройке robots.txt и уж что-то можно понять из них.

Я видел файлы, в которых было 6-7 строчек, запрещающих индексировать пару каталогов. Также я видел файлы с сотней-другой строк кода, где было закрыто все, что только можно. Оба сайта при этом нормально продвигались.

В wordpress есть так называемые дубли. Это плохо. Многие борятся с этим с помощью закрытия подобных дублей так:

|

Disallow: /wp—feed Disallow: */trackback Disallow: */feed Disallow: /tag/ Disallow: /archive/ |

Это лишь некоторые из дублей, создаваемых wordpress. Могу сказать, что так можно делать, но защиты на 100% ожидать не стоит. Я бы даже сказал, что вообще не нужно ее ожидать и проблема как раз в том, о чем я уже говорил ранее:

Поисковые системы все равно могут забрать в индекс такие вещи.

Тут уже нужно бороться по-другому. Например, с помощью редиректов или плагинов, которые будут уничтожать дубли. Впрочем, это уже тема для отдельной статьи.

Где находится robots.txt?

Этот файл всегда находится в корне сайта, поэтому мы и можем обратиться к нему, прописав адрес сайта и название файла через слэш. По-моему, тут все максимально просто.

Профессия Frontend-разработчик PRO

Готовим Frontend-разработчиков с нуля

На курсе вы научитесь создавать интерфейсы веб-сервисов с помощью языков программирования и

дополнительных технологий. Сможете разрабатывать планировщики задач, мессенджеры, интернет-магазины…

Узнать подробнее

До 10 проектов в портфолио для старта карьеры

Подходит для новичков без опыта в программировании

Практика на вебинарах с разработчиками из крупных компаний

Профессия Frontend-разработчик PRO

Готовим Frontend-разработчиков с нуля

На курсе вы научитесь создавать интерфейсы веб-сервисов с помощью языков программирования и

дополнительных технологий. Сможете разрабатывать планировщики задач, мессенджеры, интернет-магазины…

Узнать подробнее

До 10 проектов в портфолио для старта карьеры

Подходит для новичков без опыта в программировании

Практика на вебинарах с разработчиками из крупных компаний

В общем, сегодня мы рассмотрели вопрос, как посмотреть содержимое файла robots.txt, скопировать его и изменить под свои нужды. О настройке я также напишу еще 1-2 статьи в ближайшее время, потому что в этой статье мы рассмотрели не все. Кстати, также много информации по продвижению сайтов-блогов вы можете найти в нашем курсе. А я на этом пока прощаюсь с вами.

Рассмотрим, зачем нужен файл robots.txt для WordPress, где он находится на хостинге и как настроить правильный robots.txt для WordPress.

Для чего нужен файл robots.txt?

Для того чтобы сайт начал отображаться в Яндекс, Google, Yahoo и других поисковых системах (ПС), они должны внести его страницы в свои каталоги. Этот процесс называется индексацией.

Чтобы проиндексировать тот или иной веб-ресурс, поисковые системы посылают на сайты поисковых роботов (иногда их называют ботами). Они методично сканируют и обрабатывают содержимое каждой страницы сайта. После окончания индексации начинается «социальная жизнь» ресурса: его контент попадается пользователям в результатах поиска по запросам.

Многие сайты создаются на готовых движках и CMS (системах управления контентом) WordPress, Joomla, Drupal и других. Как правило, такие системы содержат страницы, которые не должны попадать в поисковую выдачу:

- временные файлы (tmp);

- личные данные посетителей (private);

- служебные страницы (admin);

- результаты поиска по сайту и т. д.

Чтобы внутренняя информация не попала в результаты поиска, ее нужно закрыть от индексации. В этом помогает файл robots.txt. Он служит для того, чтобы сообщить поисковым роботам, какие страницы сайта нужно индексировать, а какие — нет. Иными словами, robots.txt — это файл, состоящий из текстовых команд (правил), которыми поисковые роботы руководствуются при индексации сайта.

Наличие robots.txt значительно ускоряет процесс индексации. Благодаря нему в поисковую выдачу не попадают лишние страницы, а нужные индексируются быстрее.

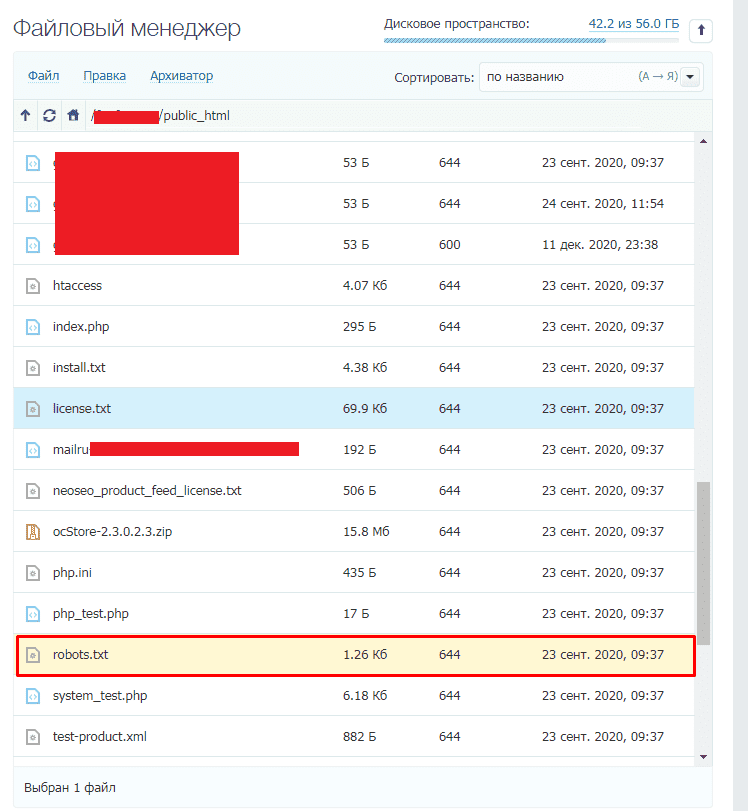

Где находится robots.txt WordPress?

Файл robots.txt находится в корневой папке сайта. Если сайт создавался на WordPress, скорее всего, robots.txt присутствует в нем по умолчанию. Чтобы найти robots.txt на WordPress, введите в адресной строке браузера:

https://www.домен-вашего-сайта/robots.txt- Если файл присутствует, откроется страница с перечнем правил индексации. Однако чтобы редактировать их, вам потребуется найти и открыть robots.txt на хостинге. Как правило, он находится в корневой папке сайта:

- Если же файл robots.txt по какой-то причине отсутствует, вы можете создать его вручную на своем компьютере и загрузить на хостинг или воспользоваться готовыми решениями (плагинами WordPress).

Как создать файл robots.txt для WordPress?

Есть два способа создания robots.txt:

-

Вручную на компьютере.

-

С помощью плагинов в WordPress.

Первый способ прост лишь на первый взгляд. После создания пустого документа и загрузки его на сайт, вы должны будете наполнить его содержанием (директивами). Ниже мы расскажем об основных правилах, однако стоит учитывать, что тонкая настройка требует специальных знаний SEO-оптимизации.

Создание robots.txt вручную

-

1.

Откройте программу «Блокнот».

-

2.

Нажмите Файл → Сохранить как… (или комбинацию клавиш Ctrl + Shift + S):

-

3.

Введите название robots.txt и нажмите Сохранить.

-

4.

Откройте корневую папку сайта и загрузите в нее созданный файл по инструкции.

Готово, вы разместили пустой файл и после этого сможете редактировать его прямо в панели управления хостингом.

Создание robots.txt с помощью плагина

-

1.

Откройте административную панель WordPress по инструкции.

-

2.

Перейдите в раздел «Плагины» и нажмите Добавить новый:

-

3.

Введите в строке поиска справа название Yoast SEO и нажмите Enter.

-

4.

Нажмите Установить → Активировать:

-

5.

Перейдите к настройкам плагина, выбрав в меню SEO → Инструменты. Затем нажмите Редактор файлов:

-

6.

Нажмите Создать файл robots.txt:

-

7.

Нажмите Сохранить изменения в robots.txt:

Готово, файл с минимальным количеством директив будет создан автоматически.

Настройка robots.txt WordPress

После создания файла вам предстоит настроить robots.txt для своего сайта. Рассмотрим основы синтаксиса (структуры) этого файла:

- Файл может состоять из одной и более групп директив (правил).

- В каждой группе должно указываться, для какого поискового робота предназначены правила, к каким разделам/файлам у него нет доступа, а к какому — есть.

- Правила читаются поисковыми роботами по порядку, сверху вниз.

- Файл чувствителен к регистру, поэтому если название раздела или файла задано капслоком (например, FILE.PDF), именно так стоит писать и в robots.txt.

- Все правила одной группы должны следовать без пропуска строк.

- Чтобы оставить комментарий, нужно прописать шарп (#) в начале строки.

Все правила в файле задаются через двоеточие. Например:

Где User-agent — команда (директива), а Googlebot — значение.

Основные директивы и их значения

User-agent — эта директива указывает, на каких поисковых роботов распространяются остальные правила в документе. Она может принимать следующие значения:

- User-agent: * — общее правило для всех поисковых систем;

- User-agent: Googlebot — робот Google;

- User-agent: Yandex — робот Яндекс;

- User-agent: Mai.ru — робот Mail.ru;

- User-agent: Yahoo Slurp — робот Yahoo и др.

У крупнейших поисковых систем Яндекс и Google есть десятки роботов, предназначенных для индексации конкретных разделов и элементов сайтов. Например:

- YandexBot — для органической выдачи;

- YandexDirect — для контекстной рекламы;

- YandexNews — для новостных сайтов и т. п.

Для решения некоторых специфических задач веб-разработчики могут обращаться к конкретным поисковым роботам и настраивать правила исключительно для них.

Disallow — это директива, которая указывает, какие разделы или страницы нельзя посещать поисковым роботам. Все значения задаются в виде относительных ссылок (то есть без указания домена). Основные правила запрета:

- Disallow: /wp-admin — закрывает админку сайта;

- Disallow: /cgi-bin — запрет индексации директории, в которой хранятся CGI-скрипты;

- Disallow: /*? или Disallow: /search — закрывает от индексации поиск на сайте;

- Disallow: *utm* — закрывает все страницы с UTM-метками;

- Disallow: */xmlrpc.php — закрывает файл с API WordPress и т. д.

Вариантов того, какие файлы нужно закрывать от индексации, очень много. Вносите значения аккуратно, чтобы по ошибке не указать контентные страницы, что повредит поисковой позиции сайта.

Allow — это директива, которая указывает, какие разделы и страницы должны проиндексировать поисковые роботы. Как и с директивой Disallow, в значении нужно указывать относительные ссылки:

- Allow: /*.css или Allow: *.css — индексировать все css-файлы;

- Allow: /*.js — обходить js-файлы;

- Allow: /wp-admin/admin-ajax.php — разрешает индексацию асинхронных JS-скриптов, которые используются в некоторых темах.

В директиве Allow не нужно указывать все разделы и файлы сайта. Проиндексируется всё, что не было запрещено директивой Disallow. Поэтому задавайте только исключения из правила Disallow.

Sitemap — это необязательная директива, которая указывает, где находится карта сайта Sitemap. Единственная директива, которая поддерживает абсолютные ссылки (то есть местоположение файла должно указываться целиком): Sitemap: https://site.ru/sitemap.xml , где site.ru — имя домена.

Также есть некоторые директивы, которые считаются уже устаревшими. Их можно удалить из кода, чтобы не «засорять» файл:

- Crawl-delay. Задает паузу в индексации для поисковых роботов. Например, если задать для Crawl-Delay параметр 2 секунды, то каждый новый раздел/файл будет индексироваться через 2 секунды после предыдущего. Это правило раньше указывали, чтобы не создавать дополнительную нагрузку на хостинг. Но сейчас мощности современных процессоров достаточно для любой нагрузки.

- Host. Указывает основное зеркало сайта. Например, если все страницы сайта доступны с www и без этого префикса, один из вариантов будет считаться зеркалом. Главное — чтобы на них совпадал контент. Раньше зеркало нужно было задавать в robots.txt, но сейчас поисковые системы определяют этот параметр автоматически.

- Clean-param. Директива, которая использовалась, чтобы ограничить индексацию совпадающего динамического контента. Считается неэффективной.

Пример robots.txt

Рассмотрим стандартный файл robots.txt, который можно скопировать и использовать для блога, заменив название домена в директиве Sitemap и убрав комментарии (текст справа, включая #):

User-agent: * # общие правила для всех поисковых роботов

Disallow: /wp-admin/ # запретить индексацию папки wp-admin (все служебные папки)

Disallow: /readme.html # закрыть доступ к стандартному файлу о программном обеспечении

Disallow: /*? # запретить индексацию результатов поиска по сайту

Disallow: /?s= # запретить все URL поиска по сайту

Allow: /wp-admin/admin-ajax.php # индексировать асинхронные JS-файлы темы

Allow: /*.css # индексировать CSS-файлы

Allow: /*.js # индексировать JS-скрипты

Sitemap: https://site.ru/sitemap.xml # указать местоположение карты сайтаКак редактировать robots.txt на WordPress?

Чтобы внести изменения в файл robots.txt, откройте его в панели управления хостингом. Используйте плагин Yoast SEO (или аналогичное решение в WordPress) для редактирования файлов:

Проверка работы файла robots.txt

Чтобы убедиться в корректности составленного файла, используйте стандартный инструмент Яндекс.Вебмастер:

- 1.

-

2.

Перейдите в раздел Инструменты → Анализ robots.txt.

-

3.

Содержимое robots.txt обновится автоматически. Нажмите Проверить:

Если в синтаксисе файла будут ошибки, Яндекс укажет, в каких строчках проблема и даст рекомендации по исправлению.

1. Что такое файл robots.txt

Файл robots.txt также известен как протокол или стандарт блокировки роботов – это текстовый файл, который говорит веб-роботам (обычно это поисковые системы), какие страницы можно сканировать. Он также говорит веб-роботам, какие страницы сканировать нельзя.

Например, поисковая система собирается посетить ваш сайт. Прежде чем она зайдет на целевую страницу, она должна ознакомиться с инструкциями в файле robots.txt.

Есть разные типы файлов robots.txt – давайте подробнее рассмотрим некоторых из них. Например, поисковая система находит вот такой файл robots.txt:

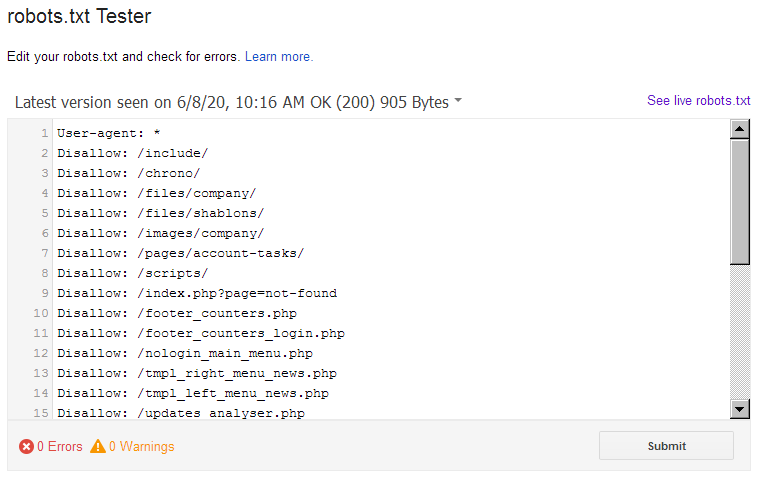

Рис. 1. Пример файла robots.txt

Это своего рода базовый скелет файла robots.txt.

- Звездочка после фразы user-agent означает, что файл robots.txt относится ко всем веб-роботам, посещающим сайт;

- слеш после слова Disallow (запретить) не разрешает роботу посещать определенные страницы сайта.

Тут же возникает вопрос: почему кто-то хочет запретить веб-роботам посещать сайт?

У вас на сайте, наверняка, много страниц. Даже если вам так не кажется. Вас даже может удивить их количество.

Если поисковая система сканирует сайт, она будет сканировать каждую страницу сайта.

А если страниц много, то у бота уйдет много времени на сканирование, а это может иметь плохие последствия для ранжирования.

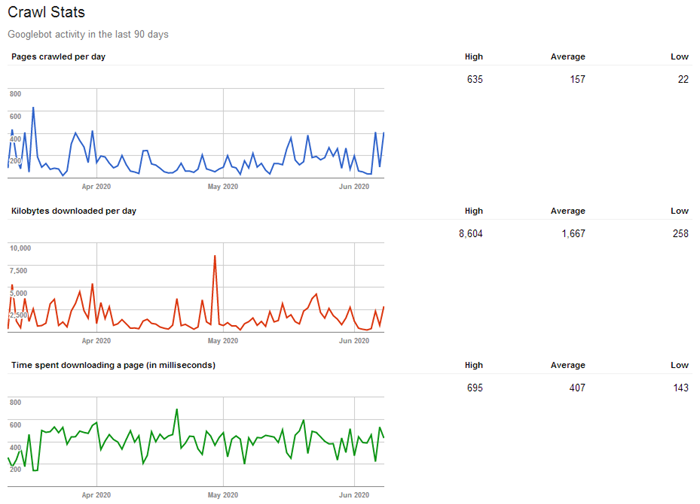

Так происходит, потому что у YandexBot и Googlebot (боты поисковых систем Яндекс и Google) есть так называемый «бюджет сканирования».

У него есть две важных составляющих:

- первая составляющая – это лимит уровня сканирования (краулинговый бюджет – это «количество URL-адресов, которые может и хочет сканировать робот поисковой системы);

- вторая составляющая – это спрос на сканирование.

Ваша цель – помочь YandexBot и Googlebot использовать свой бюджет на вашем сайте максимально эффективно. Другими словами, система должна сканировать ваши лучшие страницы.

Если создать правильный файл robots.txt, вы тем самым укажете ботам поисковой системы, какие страницы сканировать не надо.

Вот что по этому поводу говорит Google:

«Не стоит слишком перенагружать ваш сервер и впустую тратить бюджет сканирования на малозначительные страницы вашего сайта».

Правильно используя файл robots.txt, вы тем самым просите роботов поисковых систем разумно расходовать свой бюджет. Именно это и делает файл robots.txt полезным для SEO-оптимизации.

2. Как найти файл robots.txt

Все, что вам нужно сделать, это ввести основной URL-адрес сайта в панель поиска своего браузера (например, o-es.ru, seedu.ru и т. д.). В конце добавьте /robots.txt.

После этого может произойти следующее (есть три варианта):

- Вы найдете файл robots.txt.

Рис. 2. Как найти файл robots.txt

- Вы найдете пустой файл.

Например, на страничке Disney нет файла robots.txt:

Рис. На страничке Disney нет файла robots.txt

- Вы попадете на страницу 404.

На сайте Method вместо файла robots.txt появляется страница 404:

Рис. 3. Страница 404 вместо файла robots.txt

Теперь взгляните на свой собственный файл robots.txt.

- Если Вы увидите пустой файл или страничку 404, это нужно исправить.

- Если Вы нашли действительный файл, то для него, вероятно, установлены настройки по умолчанию еще со времен создания вашего сайта.

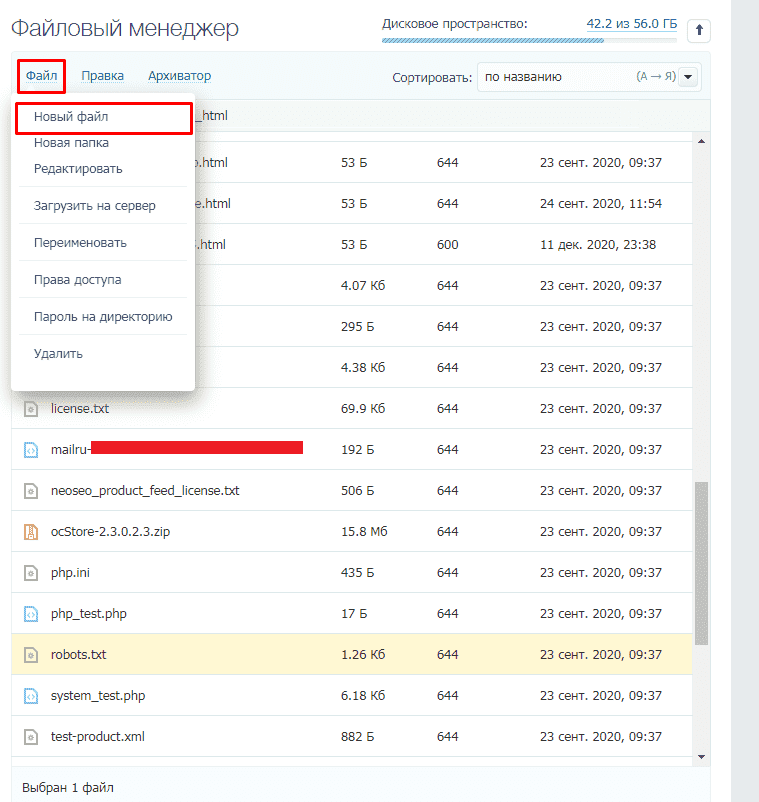

3. Как изменить файл robots.txt

- Если у вас нет файла robots.txt, вам нужно его создать. Откройте какой-нибудь текстовый редактор, например Notepad (Windows) или TextEdit (Mac). Главное использовать простой текстовый редактор. Программа Microsoft Word может вставлять в текст дополнительный код, поэтому в данном случае не стоит ее использовать.

- Если у вас есть файл robots.txt, нужно будет его найти в корневом каталоге вашего сайта.

- Если вы не привыкли работать с исходным кодом, вам может быть сложно отыскать редактируемую версию файла robots.txt.

Как правило, можно найти свой корневой каталог, перейдя на сайт хостинга аккаунта. Нужно войти в систему и перейти в раздел управления файлами или FTP вашего сайта.

Вы увидите что-то такое:

Рис. 4. Раздел управления сайтами

Найдите файл robots.txt и откройте его для редактирования.

4. Как создать файл robots.txt

Новый файл robots.txt можно создать с помощью обычного текстового редактора. (Помните, что главное использовать простой текстовый редактор.)

Если у вас уже есть файл robots.txt, убедитесь в том, что вы удалили текст (но не сам файл).

Во-первых, вам нужно ознакомиться с синтаксисом, используемым в файле robots.txt.

Начните с установки user-agent (пользовательского посредника). Мы установим его таким образом, чтобы он применялся по отношению ко всем веб-роботам.

Это можно сделать, используя звездочку после фразы user-agent. Это будет выглядеть вот так:

Затем нужно ввести слово Disallow: (запретить), но больше ничего не печатайте.

Поскольку после слова «Запретить» больше ничего нет, веб-роботы будут сканировать весь ваш сайт. В данный момент все на вашем сайте является мишенью.

Ваш файл robots.txt будет выглядеть вот так:

Выглядит просто, но эти две строчки уже выполняют очень важную работу.

Можно также оставить ссылку на XML sitemap, но это не обязательно. Если вы считаете, что это стоит сделать, – вот, что нужно напечатать:

Рис. 5. Как оставить ссылку на XML sitemap

Теперь давайте перейдем на новый уровень и превратим этот файл в по-настоящему эффективный инструмент в сфере SEO.

5. Как оптимизировать файл robots.txt

Оптимизация файла robots.txt зависит от контента на вашем сайте. Я расскажу вам о некоторых наиболее распространенных способах его использования.

Чтобы отрегулировать бюджет сканирования, нужно дать поисковой системе сигнал, что не следует сканировать те части вашего сайта, которые закрыты от общего доступа, – это можно сделать с помощью файла robots.txt.

Например, если вы посмотрите на файл robots.txt на этом сайте (neilpatel.com), то увидите, что страница регистрации не сканируется (wp-admin).

Рис. 6. Пример заблокированных страниц на сайте o-es.ru

Поскольку эта страница используется только для входа в систему управления сайтом – ее сканирование будет пустой тратой времени для ботов поисковых систем.

(Если у вас есть WordPress, можно использовать точно такую же строку.)

Вы можете использовать аналогичный указатель (или команду), чтобы не дать ботам сканировать определенные страницы. После слова disallow введите часть URL-адреса, которая находится после доменной зоны (.com, .ru и др.). Поместите ее между двумя слешами.

Если вы хотите запретить боту сканировать вашу страницу http://yoursite.com/page/, можно ввести следующее:

Рис. 7. Как запретить боту сканировать вашу страницу

6. Какие типы страниц стоит исключить из списка индексации:

1. Целенаправленное повторение контента. Обычно повторяющийся контент – это плохо, но есть несколько случаев, когда это приемлемо или даже необходимо.

Например, если у вас есть версия страницы для печати. Тогда по техническим причинам у вас будет повторяющийся контент. В этом случае можно попросить ботов сканировать только одну из этих страниц (обычно это версия для печати).

Это также удобно, если вы тестируете страницы с одинаковым контентом, но с разным дизайном.

2. Страницы благодарности. Страница благодарности – это одна из самых любимых страниц маркетолога, потому что она привлекает лиды.…

Правда?

Как оказалось, некоторые страницы благодарности доступны через Google. Это означает, что люди могут получить доступ к этим страницам, не проходя через процесс привлечения лидов, а это плохая новость.

Заблокируйте страницу благодарности, и ее смогут видеть только потенциальные клиенты.

Например, ваша страница благодарности находится на сайте https://yoursite.com/thank-you/. В файле robots.txt блокировка этой страницы будет выглядеть так:

Рис. Блокировка файла robots.txtна сайте https://yoursite.com/thank-you/

Нет универсальных правил касательно того, какие страницы блокировать, поэтому ваш файл robots.txt будет уникальным. Используйте здравый смысл.

7. Тестирование в Google Вебмастер

Наконец, пришло время протестировать файл robots.txt, чтобы убедиться, что все было сделано правильно и работает.

Существует бесплатный тестер robots.txt от Google в составе инструментов Webmaster.

Для начала войдите в свою учетную запись на Webmaster.

Рис. 8. Как использовать бесплатный тестер robots.txtот Google

Выберите необходимые свойства (например, веб-сайт) и нажмите кнопку «Сканировать» на левой боковой панели.

Рис. 9. Кнопка «Сканировать» на левой боковой панели

Вы увидите вкладку robots.txt Tester. Щелкните на нее.

Рис. 10. Вкладка robots.txtTester

Если в поле уже есть код, удалите его, заменив его новым файлом robots.txt.

Нажмите «Тестировать» в правой нижней части экрана.

Рис. 11. Функция «Тестировать»

Если текст «Тестировать» меняется на «Разрешено», это означает, что ваш robots.txt действителен.

В интернете можно найти более подробную информацию об этом инструменте.

Наконец, загрузите файл robots.txt в корневой каталог (или сохраните его, если он уже там). Теперь у вас есть мощный файл для улучшения видимости вашего сайта в результатах поиска.

8. Проверка файла robots.txt в Яндекс Вебмастер

9. Вывод

Если роботы поисковых систем разумно расходуют бюджет сканирования контента, они смогут лучше организовывать и отображать ваш контент в результатах поиска, а это означает, что вы будете более заметны.

Кроме того, настраивать файл robots.txt легко. По сути, это разовая настройка. Небольшие изменения можно вносить по мере необходимости.

Корректировка файла robots.txt входит в услугу – технический аудит сайта.

Источник: neilpatel.com

Файл robots.txt — это текстовый файл, в котором содержаться инструкции для поисковых роботов, в частности каким роботам и какие страницы допускается сканировать, а какие нет. В данной статье рассмотрим, где можно найти robots.txt, как его редактировать и какие правила по его использовать в SEO-продвижении.

- Где найти;

- Как создать;

- Инструкция по работе;

- Синтаксис;

- Директивы;

- Как проверить.

Где можно найти файл robots.txt и как его создать или редактировать

Чтобы проверить файл robots.txt сайта, следует добавить к домену «/robots.txt», примеры:

https://seopulses.ru/robots.txt

https://serpstat.com/robots.txt

https://netpeak.net/robots.txt

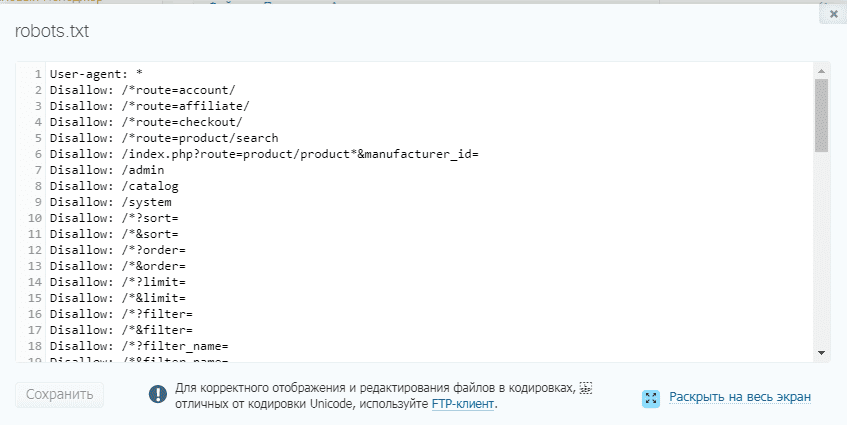

Как создать и редактировать robots.txt

Вручную

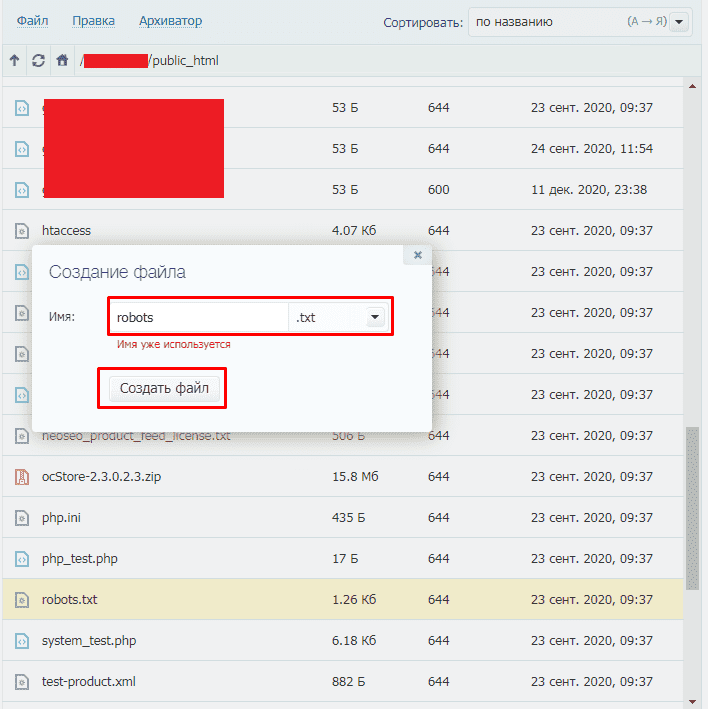

Данный файл всегда можно найти, подключившись к FTP сайта или в файлом редакторе хостинг-провайдера в корневой папке сайта (как правило, public_html):

Далее открываем сам файл и можно его редактировать.

Если его нет, то достаточно создать новый файл.

После вводим название документа и сохраняем.

Через модули/дополнения/плагины

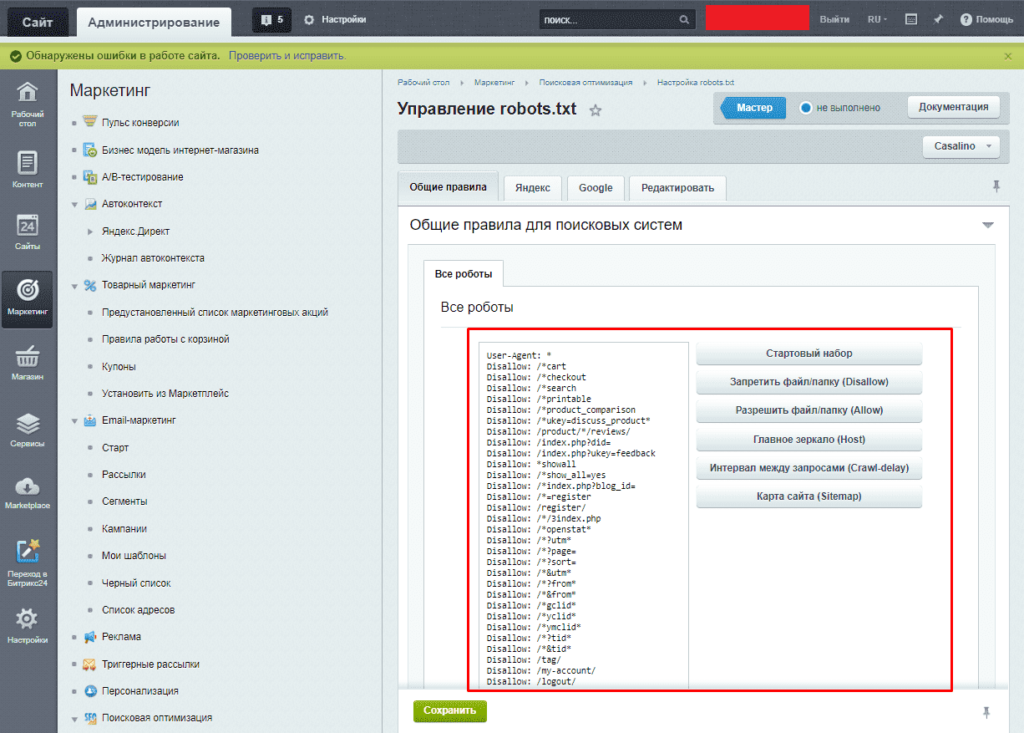

Чтобы управлять данный файлом прямо в административной панели сайта следует установить дополнительный модуль:

- Для 1С-Битрикс;

https://dev.1c-bitrix.ru/learning/course/?COURSE_ID=139&LESSON_ID=5814

- WordPress;

- Для Opencart;

https://opencartforum.com/files/file/5141-edit-robotstxt/

- Webasyst.

https://support.webasyst.ru/shop-script/149/shop-script-robots-txt/

Инструкция по работе с robots.txt

В первую очередь записывается User-Agent, указывая на то, к какому роботу идет обращение, например:

- User-agent: Yandex — для обращения к поисковому роботу Яндекса;

- User-agent: Googlebot — в случае с краулером Google;

- User-agent: YandexImages — при работе с ботом Яндекс.Картинок.

Полный список роботов Яндекс:

https://yandex.ru/support/webmaster/robot-workings/check-yandex-robots.html#check-yandex-robots

И Google:

https://support.google.com/webmasters/answer/1061943?hl=ru

Синтаксис в robots.txt

- # — отвечает за комментирование;

- * — указывает на любую последовательность символов после этого знака. По умолчанию указывается при любого правила в файле;

- $ — отменяет действие *, указывая на то что на этом элементе необходимо остановиться.

Директивы в Robots.txt

Disallow

Disallow запрещает индексацию отдельной страницы или группы (в том числе всего сайта). Чаще всего используется для того, чтобы скрыть технические страницы, динамические или временные страницы.

Пример #1

# Полностью закрывает весь сайт от индексации

User-agent: *

Disallow: /

Пример #2

# Блокирует для скачивания все страницы раздела /category1/, например, /category1/page1/ или caterogy1/page2/

Disallow: /category1/

Пример #3

# Блокирует для скачивания страницу раздела /category2/

User-agent: *

Disallow: /category1/$

Пример #4

# Дает возможность сканировать весь сайт просто оставив поле пустым

User-agent: *

Disallow:

Важно! Следует понимать, что регистр при использовании правил имеет значение, например, Disallow: /Category1/ не запрещает посещение страницы /category1/.

Allow

Директива Allow указывает на то, что роботу можно сканировать содержимое страницы/раздела, как правило, используется, когда в полностью закрытом разделе, нужно дать доступ к определенному документу.

Пример #1

# Дает возможность роботу скачать файл site.ru//feed/turbo/ несмотря на то, что скрыт раздел site.ru/feed/.

Disallow: */feed/*

Allow: /feed/turbo/

Пример #2

# разрешает скачивание файла doc.xml

# разрешает скачивание файла doc.xml

Allow: /doc.xml

Sitemap

Директива Sitemap указывает на карту сайта, которая используется в SEO для вывода списка URL, которые нужно проиндексировать в первую очередь.

Важно понимать, что в отличие от стандартных директив у нее есть особенности в записи:

- Следует указывать полный URL, когда относительный адрес использовать запрещено;

- На нее не распространяются остальные правила в файле robots.txt;

- XML-карта сайта должна иметь в URL-адресе домен сайта.

Пример

# Указывает карту сайта

Sitemap: https://serpstat.com/sitemap.xml

Clean-param

Используется когда нужно указать Яндексу (в Google она не работает), что страница с GET-параметрами (например, site.ru?param1=2¶m2=3) и метками (в том числе utm) не влияющие на содержимое сайта, не должна быть проиндексирована.

Пример #1

#для адресов вида:

www.example1.com/forum/showthread.php?s=681498b9648949605&t=8243

www.example1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: s /forum/showthread.php

Пример #2

#для адресов вида:

www.example2.com/index.php?page=1&sid=2564126ebdec301c607e5df

www.example2.com/index.php?page=1&sid=974017dcd170d6c4a5d76ae

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: sid /index.php

Подробнее о данной директиве можно прочитать здесь:

https://serpstat.com/ru/blog/obrabotka-get-parametrov-v-robotstxt-s-pomoshhju-direktivy-clean-param/

Crawl-delay

Важно! Данная директива не поддерживается в Яндексе с 22 февраля 2019 года и в Google 1 сентября 2019 года, но работает с другими роботами. Настройки скорости скачивания можно найти в Яндекс.Вебмастер и Google Search Console.

Crawl-delay указывает временной интервал в секундах, в течение которого роботу разрешается делать только 1 сканирование. Как правило, необходима лишь в случаях, когда у сайта наблюдается большая нагрузка из-за сканирования.

Пример

# Допускает скачивание страницы лишь раз в 3 секунды

Crawl-delay: 3

Как проверить работу файла robots.txt

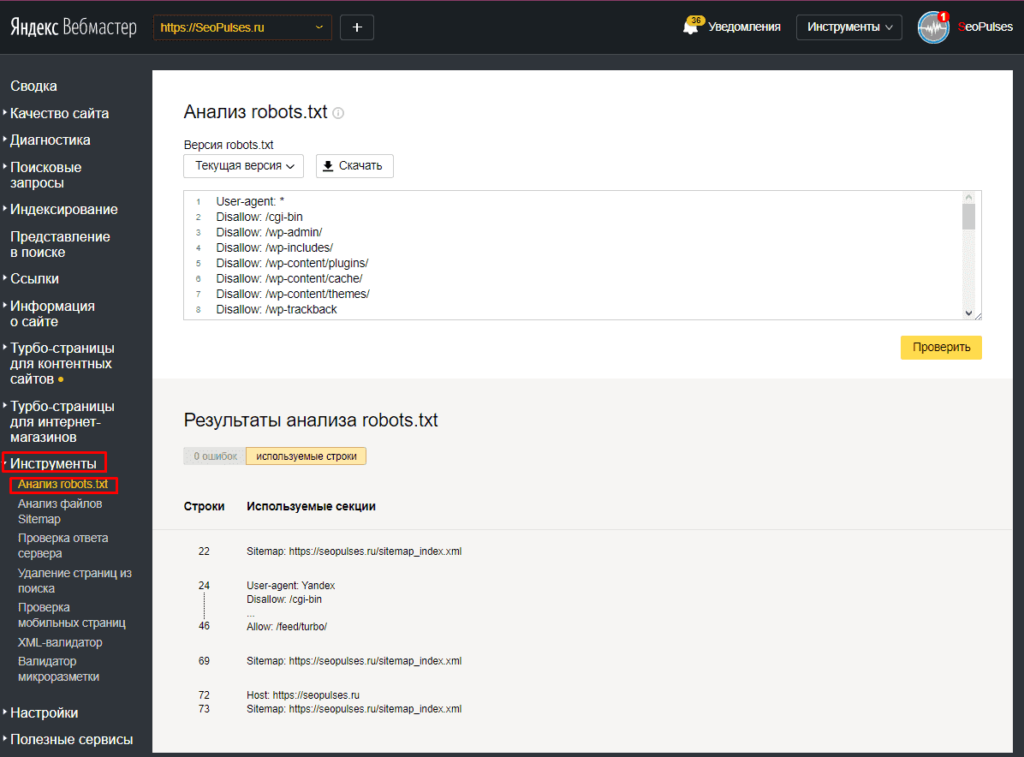

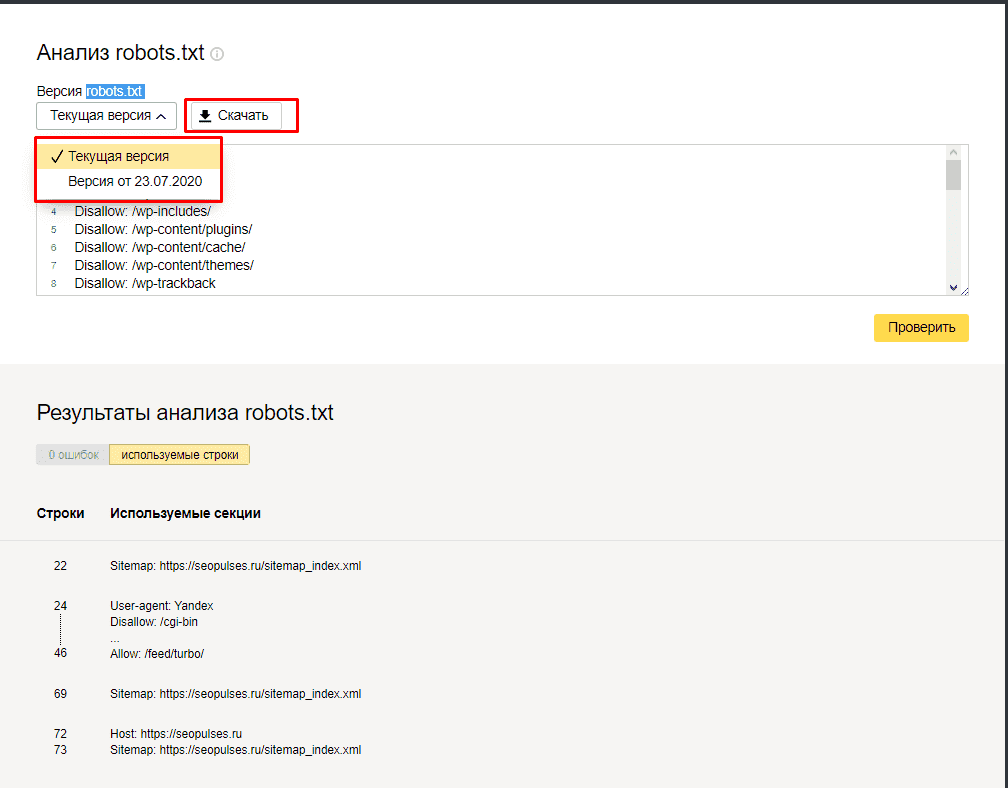

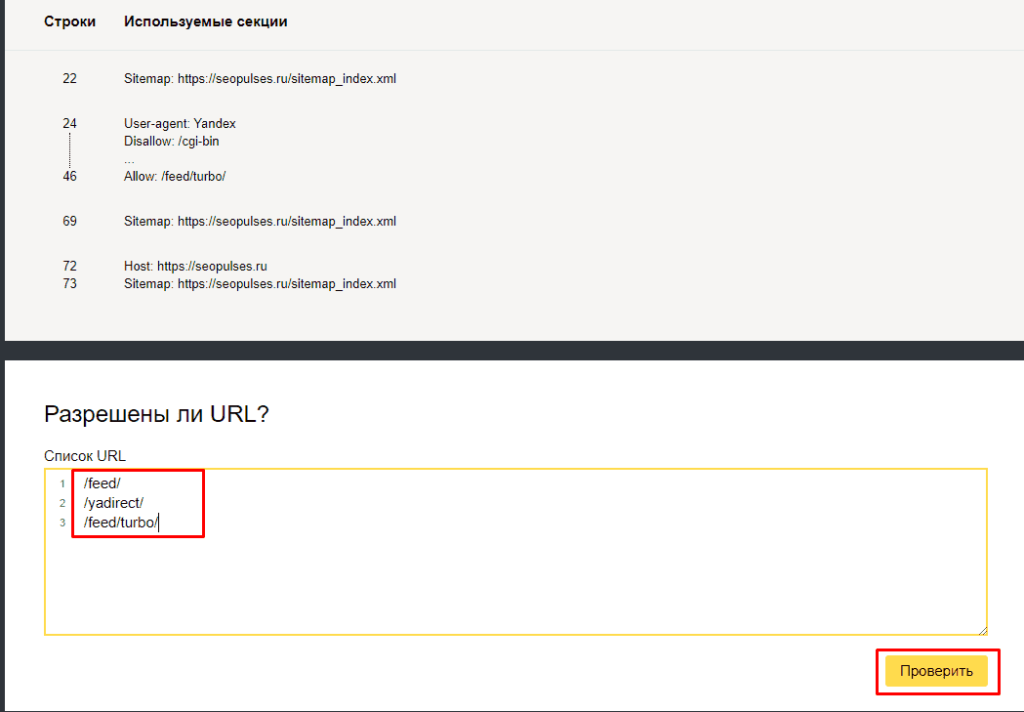

В Яндекс.Вебмастер

В Яндекс.Вебмастер в разделе «Инструменты→ Анализ robots.txt» можно увидеть используемый поисковиком свод правил и наличие ошибок в нем.

Также можно скачать другие версии файла или просто ознакомиться с ними.

Чуть ниже имеется инструмент, который дает возможно проверить сразу до 100 URL на возможность сканирования.

В нашем случае мы проверяем эти правила.

Как видим из примера все работает нормально.

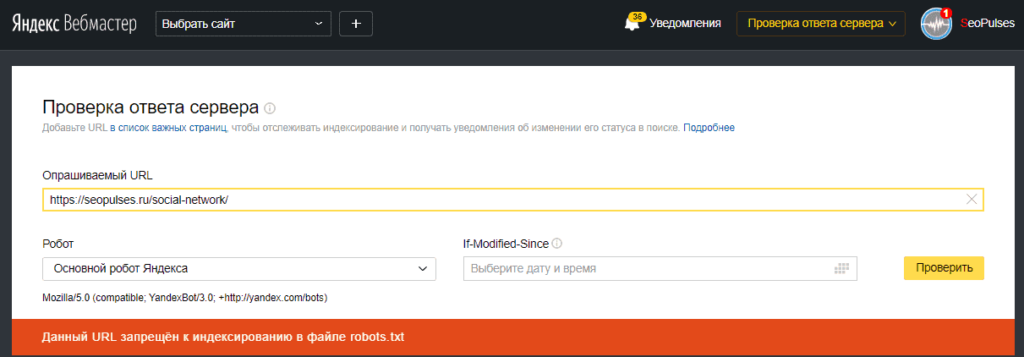

Также если воспользоваться сервисом «Проверка ответа сервера» от Яндекса также будет указано, запрещен ли для сканирования документ при попытке обратиться к нему.

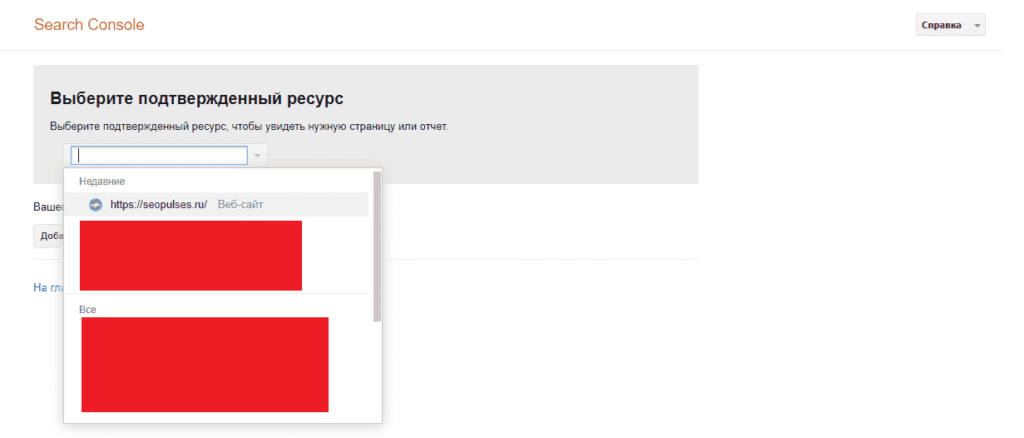

В Google Search Console

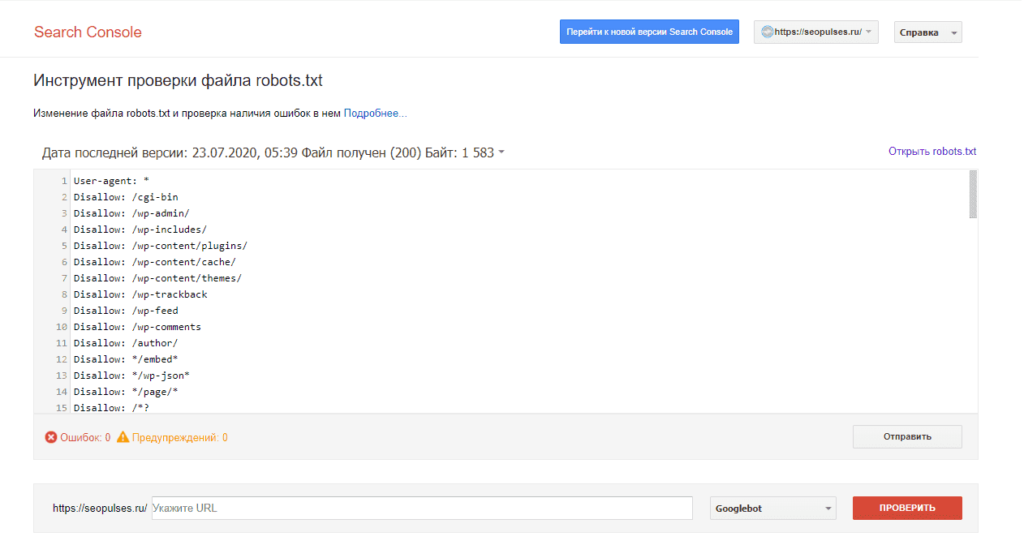

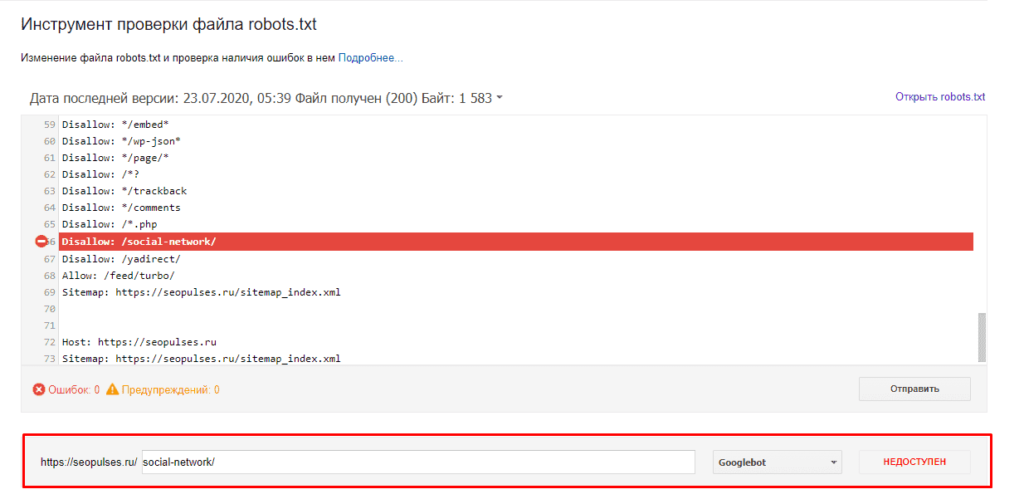

В случае с Google можно воспользоваться инструментом проверки Robots.txt, где потребуется в первую очередь выбрать нужный сайт.

Важно! Ресурсы-домены в этом случае выбирать нельзя.

Теперь мы видим:

- Сам файл;

- Кнопку, открывающую его;

- Симулятор для проверки сканирования.

Если в симуляторе ввести заблокированный URL, то можно увидеть правило, запрещающее сделать это и уведомление «Недоступен».

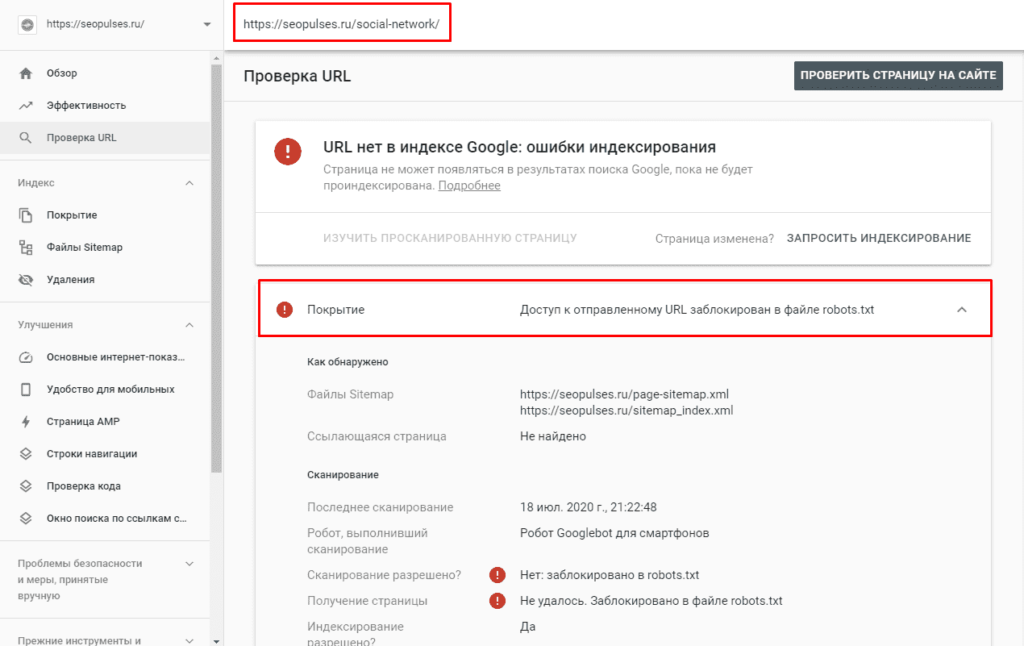

Однако, если ввести заблокированный URL в страницу поиска в новой Google Search Console (или запросить ее индексирование), то можно увидеть, что страница заблокирована в файле robots.txt.

Примерно 60% пользователей сталкивается с тем, что новый сайт имеет проблемы с продвижением в поиске из-за неправильно настроенного файла robots.txt. Поэтому не всегда стоит сразу после запуска вкладывать все ресурсы в SEO-тексты, ссылки или внешнюю рекламу, так как некорректная настройка одного единственного файла на сайте способна привести к фатальным результатам и полной потере трафика и клиентов. Однако, всего этого можно избежать, правильно настроив индексацию сайта, и сделать это можно даже не будучи техническим специалистом или программистом.

Что такое файл robots.txt?

Robots.txt это обычный текстовый файл, содержащий руководство для ботов поисковых систем (Яндекс, Google, etc.) по сканированию и индексации вашего сайта. Таким образом, каждый поисковый бот (краулер) при обходе страниц сайта сначала скачивает актуальную версию robots.txt (обновляет его содержимое в своем кэше), а затем, переходя по ссылкам на сайте, заносит в свой индекс только те страницы, которые разрешены к индексации в настройках данного файла.

User-agent: *

Disallow: /*?*

Disallow: /data/

Disallow: /scripts/

Disallow: /plugins/

Sitemap: https://somesite.com/sitemap.xml

При этом у каждого краулера существует такое понятие, как «краулинговый бюджет», определяющее, сколько страниц можно просканировать единоразово (для разных сайтов это значение варьируется: обычно в зависимости от объема и значимости сайта). То есть, чем больше страниц на сайте и чем популярнее ресурс, тем объемнее и чаще будет идти его обход краулерами, и тем быстрее эти данные попадут в поисковую выдачу (например, на крупных новостных сайтах поисковые боты постоянно сканируют контент на предмет поиска новой информации (можно сказать что «живут»), за счет чего поисковая система может выдавать пользователем самые актуальные новости уже через несколько секунд после их публикации на сайте).

Таким образом, из-за ограниченности краулингового бюджета рекомендуется отдавать поисковым ботам в приоритете только ту информацию, которая должна обновляться или появляться в индексе поисковиков наиболее быстро (например, важные, полезные и актуальные страницы сайта), а все прочее устаревшее и не нужное можно смело скрывать, тем самым не распыляя краулинговый бюджет на не имеющий ценности контент.

Вывод: для оптимизации индексирования сайта стоит исключать из сканирования дубликаты страниц, результаты локального поиска по сайту, личный кабинет, корзину, сравнения, сортировки и фильтры, пользовательские профили, виш-листы и всё, что не имеет ценности для обычного пользователя.

Как найти и просмотреть содержимое robots.txt?

Файл размещается в корне домена по адресу somesite.com/robots.txt.

Данный метод прост и работает для всех веб-ресурсов, на которых размещен robots.txt. Доступ у файла открытый, поэтому каждый может просмотреть файлы других сайтов и узнать, как они настроены. Просто допишите «/robots.txt» в конец адресной строки интересующего домена, и вы получите один из двух вариантов:

- Откроется страница с содержимым robots.txt.

- Вы получите ошибку 404 (страница не найдена).

Вывод: если на вашем ресурсе по адресу /robots.txt вы получаете ошибку 404, то этот момент однозначно стоит исправить (создать, настроить и добавить файл на сервер).

Создание и редактирование robots.txt

- Если у вас еще нет файла, то нужно создать его с нуля. Откройте самый простой текстовый редактор (но не MS Word, т.к. нам нужен именно простой текстовый формат), к примеру, Блокнот (Windows) или TextEdit (Mac).

- Если файл уже существует, отыщите его в корневом каталоге вашего сайта (предварительно, подключившись к сайту по FTP-протоколу, для этого я рекомендую бесплатный Total Commander), скопируйте его на жесткий диск вашего компьютера и откройте через Блокнот.

Примечания:

- Если, например, сайт реализован на CMS WordPress, то по умолчанию, вы не сможете найти его в корне сайта, так как «из коробки» его наличие не предусмотрено. Поэтому для редактирования его придется создать заново.

- Регистр имени файла важен! Название robots.txt указывается исключительно строчными буквами. Также убедитесь, что вы написали корректное название, НЕ «Robots» или «robot» – это наиболее частые ошибки при создании файла.

Структура и синтаксис robots.txt

Существуют стандартные директивы разрешения или запрета индексации тех ли иных страниц и разделов сайта:

User-agent: * Disallow: /

В данном примере всем поисковым ботам не разрешается индексировать сайт (слеш через : и пробел от директивы Disallow указывает на корень сайта, а сама директива – на запрет чего-либо, указанного после двоеточия). Звездочка говорит о том, что данная секция открыта для всех User-agent (у каждой поисковой машины есть свой юзер-агент, которым она идентифицируется. Например, у Яндекса это Yandex, а у Гугла – Googlebot).

А, например, такая конструкция:

User-agent: Googlebot Disallow:

Говорит о том, что роботам Гугл разрешено индексировать весь сайт (для остальных поисковых систем директив в данном примере нет, поэтому если для них не прописаны какие-либо запрещающие правила, значит индексирование также разрешено).

Еще пример:

# директивы для Яндекса User-agent: Yandex Disallow: /profile/

Здесь роботам Яндекса запрещено индексировать личные профили пользователей (папка somesite.com/profile/), все остальное на сайте разрешено. А, например, роботу гугла разрешено индексировать вообще все на сайте.

Как вы уже могли догадаться, знак решетка «#» используется для написания комментариев.

Пример для запрета индексации конкретной страницы, входящей в блок типовых страниц:

User-agent: * Disallow: /profile/$

Данная директива запрещает индексацию раздела /profile/, однако разрешает индексацию всех его подразделов и отдельных страниц:

- /profile/logo.png

- /profile/users/

- /profile/all.html

Директива User-agent

Это обязательное поле, являющееся указанием поисковым ботам для какого поисковика настроены данные директивы. Звездочка (*) означает то, что директивы указаны для всех сканеров от всех поисковиков. Либо на ее месте может быть вписано конкретное имя поискового бота.

User-agent: * # определяем, для каких систем даются указания

Это будет работать до тех пор, пока в файле не встретятся инструкции для другого User-agent, если для него есть отдельные правила.

User-agent: Googlebot # указали, что директивы именно для ботов Гугла Disallow: / User-agent: Yandex # для Яндекса Disallow:

Директива Disallow

Как мы писали выше, это директива запрета индексации страниц и разделов на вашем сайте по указанным критериям.

User-agent: * Disallow: /profile/ #запрет индексирования профилей пользователей

Пример запрета индексации PDF и файлов MS Word и Excel:

User-agent: * Disallow: *.pdf Disallow: *.doc* Disallow: *.xls*

В данном случае, звездочка играет роль любой последовательности символов, то есть к индексации будут запрещены файлы формата: pdf, doc, xls, docx, xlsx.

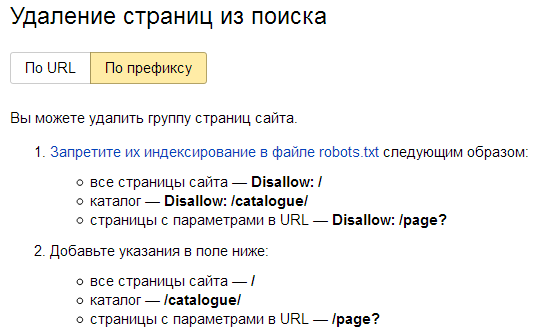

Примечание: для ускорения удаления из индекса недавно запрещенных к индексации страниц можно прибегнуть к помощи панели Яндекс Вебмастера: Удалить URL. Для группового удаления страниц и разделов нужно перейти в раздел «Инструменты» конкретного сайта и уже там выбрать режим «По префиксу».

Директивы Allow, Sitemap, Clean-param, Crawl-delay и другие

Дополнительные директивы предназначены для более тонкой настройки robots.txt.

Allow

Как противоположность Disallow, Allow дает указание на разрешение индексации отдельных элементов.

User-agent: Yandex Allow: / User-agent: * Disallow: /

Яндекс может проиндексировать сайт целиком, остальным поисковым системам сканирование запрещено.

Либо, к примеру, мы можем разрешить к индексации отдельные папки и файлы, запрещенные через Disallow.

User-agent: * Disallow: /upload/ Allow: /upload/iblock Allow: /upload/medialibrary

Sitemap.xml

Это файл для прямого указания краулерам списка актуальных страниц на сайте. Данная карта сайта предназначена только для поисковых роботов и оформлена специальным образом (XML-разметка). Файл sitemap.xml помогает поисковым ботам обнаружить страницы для дальнейшего индексирования и должен содержать только актуальные страницы с кодом ответа 200, без дублей, сортировок и пагинаций.

Стандартный путь размещения sitemap.xml – также в корневой папке сайта (хотя в принципе она может быть расположена в любой директории сайта, главное указать правильный путь к sitemap):

User-agent: Yandex Disallow: /comments/ Sitemap: https://smesite.com/sitemap.xml

Для крупных порталов карт сайта может быть даже несколько (Google допускает до 1000), но для большинства обычно хватает одного файла, если он удовлетворяет ограничениям:

- Не более 50 МБ (без сжатия) на один Sitemap.xml.

- Не более 50 000 URL на один Sitemap.xml.

Если ваш файл превышает указанный размер в 50 мегабайт, или же URL-адресов, содержащихся в нем, более 50 тысяч, то вам придется разбить список на несколько файлов Sitemap и использовать файл индекса для указания в нем всех частей общего Sitemap.

Пример:

User-agent: Yandex Allow: / Sitemap: https://project.com/my_sitemap_index.xml Sitemap: https://project.com/my_sitemap_1.xml Sitemap: https://project.com/my_sitemap_2.xml ... Sitemap: https://project.com/my_sitemap_X.xml

Примечание: параметр Sitemap – межсекционный, поэтому может быть указан в любом месте файла, однако обычно принято прописывать его в последней строке robots.txt.

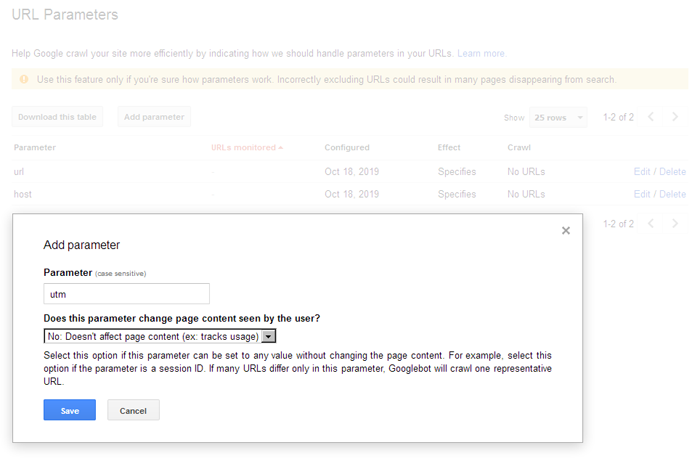

Clean-param

Если на страницах есть динамические параметры, не влияющие на контент, то можно указать, что индексация сайта будет выполняться без учета этих параметров. Таким образом, поисковый робот не будет несколько раз загружать одну и ту же информацию, что повышает эффективность индексации.

К примеру, «Clean-param: highlight /forum/showthread.php» преобразует ссылку «/forum/showthread.php?t=30146&highlight=chart» в «/forum/showthread.php?t=30146» и таким образом не будет добавлять дубликат страницы форума с параметром подсветки найденного текста в ветке форума.

User-Agent: * Clean-param: p /forum/showthread.php Clean-param: highlight /forum/showthread.php

Clean-param используется исключительно для Яндекса, Гугл же использует настройки URL в Google Search Console. У гугла это осуществляется намного проще, простым добавлением параметров в интерфейсе вебмастера:

Crawl-delay

Данная инструкция относится к поисковой системе Яндекс и указывает правила по интенсивности его сканирования поисковым роботом. Это бывает полезно, если у вас слабый хостинг и роботы сильно нагружают сервер. В таком случае, вы можете указать им правило сканировать сайт реже, прописав интервалы между запросами к веб-сайту.

К примеру, Crawl-delay: 10 – это указание сканеру ожидать 10 секунд между каждым запросом. 0.5 – пол секунды.

User-Agent: * Crawl-delay: 10 # Crawl-delay: 0.5

Robots.txt для WordPress

Ниже выложен пример robots.txt для сайта на WordPress. Стандартно у Вордпресс есть три основных каталога:

- /wp-admin/

- /wp-includes/

- /wp-content/

Папка /wp-content/ содержит подпапку «uploads», где обычно размещены медиа-файлы, и этот основной каталог целиком блокировать не стоит:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/ Allow: /wp-content/uploads/

Данный пример блокирует выбранные служебные папки, но при этом позволяет сканировать подпапку «uploads» в «wp-content».

Настройка robots.txt для Google и Яндекс

Желательно настраивать директивы для каждой поисковой системы отдельно, как минимум, их стоит настроить для Яндекса и Гугл, а для остальных указать стандартные значения со звездочкой *.

User-agent: * User-agent: Yandex User-agent: Googlebot

Настройка robots.txt для Яндекса

В некоторых роботс иногда можно встретить устаревшую директиву Host, предназначенную для указания основной версии (зеркала) сайта. Данная директива устарела, поэтому ее можно не использовать (теперь поисковик определяет главное зеркало по 301-м редиректам):

User-agent: Yandex Disallow: /search Disallow: /profile Disallow: */feed Host: https://project.com # необязательно

Воспользуйтесь бесплатным инструментом Яндекса для автоматической проверки корректности настроек роботса.

Настройка robots.txt для Google

Принцип здесь тот же, что и у Яндекса, хоть и со своими нюансами. К примеру:

User-agent: Googlebot Disallow: /search Disallow: /profile Disallow: */feed Allow: *.css Allow: *.js

Важно: для Google мы добавляем возможность индексации CSS-таблиц и JS, которые важны именно для этой поисковой системы (поисковик умеет рендерить яваскрипт, соответственно может получить из него дополнительную информацию, имеющую пользу для сайта, либо просто для понимания, для чего служит тот или ной скрипт на сайте).

По ссылке в Google Webmaster Tools вы можете убедиться, правильно ли настроен ваш robots.txt для Гугла.

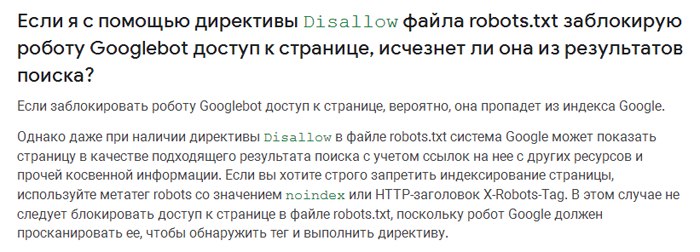

Запрет индексирования через Noindex и X-RobotsTag

В некоторых случаях, поисковая система Google может по своему усмотрению добавлять в индекс страницы, запрещенные к индексации через robots.txt (например, если на страницу стоит много внешних ссылок и размещена полезная информация).

Цитата из справки Google:

Для 100% скрытия нежелаемых страниц от индексации, используйте мета-тег NOINDEX.

Noindex – это мета-тег, который сообщает поисковой системе о запрете индексации страницы. В отличие от роботса, он является более надежным, поэтому для скрытия конфиденциальной информации лучше использовать именно его:

- <meta name=»robots» content=»noindex»>

Чтобы скрыть страницу только от Google, укажите:

- <meta name=»googlebot» content=»noindex»>

X-Robots-Tag

Тег x-robots позволяет вам управлять индексированием страницы в заголовке HTTP-ответа страницы. Данный тег похож на тег meta robots и также не позволяет роботам сканировать определенные виды контента, например, изображения, но уже на этапе обращения к файлу, не скачивая его, и, таким образом, не затрачивая ценный краулинговый ресурс.

Для настройки X-Robots-Tag необходимо иметь минимальные навыки программирования и доступ к файлам .php или .htaccess вашего сайта. Директивы тега meta robots также применимы к тегу x-robots.

<?

header("X-Robots-Tag: noindex, nofollow");

?>

Примечание: X-Robots-Tag эффективнее, если вы хотите запретить сканирование изображений и медиа-файлов. Применимо к контенту лучше выбирать запрет через мета-теги. Noindex и X-Robots Tag это директивы, которым поисковые роботы четко следуют, это не рекомендации как robots.txt, которые по определению можно не соблюдать.

Как быстро составить роботс для нового сайта с нуля?

Очень просто – скачать у конкурента! )

Просто зайдите на любой интересующий сайт и допишите в адресную строку /robots.txt, — так вы увидите, как это реализовано у конкурентов. При этом не стоит бездумно копировать их содержимое на свой сайт, ведь корректно настроенные директивы чужого сайта могут негативно подействовать на индексацию вашего веб-ресурса, поэтому желательно хотя бы немного разбираться в принципах работы роботс.тхт, чтобы не закрыть доступ к важным разделам.

И главное: после внесения изменений проверяйте robots.txt на валидность (соответствие правилам). Тогда вам точно не нужно будет опасаться за корректность индексации вашего сайта.

Другие примеры настройки Robots.txt

User-agent: Googlebot Disallow: /*?* # закрываем от индексации все страницы с параметрами Disallow: /users/*/photo/ # закрываем от индексации адреса типа "/users/big/photo/", "/users/small/photo/" Disallow: /promo* # закрываем от индексации адреса типа "/promo-1", "/promo-site/" Disallow: /templates/ #закрываем шаблоны сайта Disallow: /*?print= # версии для печати Disallow: /*&print=

Запрещаем сканировать сервисам аналитики Majestic, Ahrefs, Yahoo!

User-agent: MJ12bot Disallow: / User-agent: AhrefsBot Disallow: / User-agent: Slurp Disallow: /

Настройки robots для Opencart:

User-agent: * Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /download Disallow: /registration Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Allow: /catalog/view/theme/default/stylesheet/stylesheet.css Allow: /catalog/view/theme/default/css/main.css Allow: /catalog/view/javascript/font-awesome/css/font-awesome.min.css Allow: /catalog/view/javascript/jquery/owl-carousel/owl.carousel.css Allow: /catalog/view/javascript/jquery/owl-carousel/owl.carousel.min.js