Современные технологии позволяют вебмастерам использовать разные способы продвижения сайтов, в том числе – просроченные ресурсы сайты, то есть не имеющие владельца на момент покупки. Рассказываем, как найти дропа, проверить и как это может помочь в продвижении.

навигация по статье

- Что такое дропы

- Как искать дроп-домены

- Для чего нужны такие сайты

- Способы поиска дроп-доменов

- Поиск дропов с помощью изучения выдачи

- Поиск дроп-доменов с помощью сервисов

- Пошаговая инструкция самого простого варианта подборки от специалиста Rush Agency Захара Федоренко

- Возможные проблемы

- Какие параметры стоит проверить

- Как найти и перехватить хорошие дроп-домены с трафиком

- Как зарегистрировать дроп-домен

- Плюсы и минусы дроп-доменов

- Как заработать на дроп-доменах?

Что такое дропы

Термином называют сайт с закончившимся сроком регистрации. Практически во всех зонах минимальный срок составляет 1 год, максимальный – 10 лет. Если по истечении оплаченного срока он не был продлен, то он меняет статус:

- Льготный период – обычно в течение месяца после того, как истек срок. Сайт не работает, но домен можно продлить по обычной цене.

- Освобождение – запущен процесс удаления, но его можно остановить за дополнительную плату. В некоторых зонах эта стадия отсутствует.

- Удаление – если прошли периоды удержания и освобождения, а плата так и не была внесена, домен удаляется из реестра и становится доступным через 5-6 дней.

Как искать дроп-домены

Раньше это делалось вручную и занимало много времени. Приходилось отсортировывать их по определенным критериям, затем анализировать каждый домен. Сегодня появились сервисы, помогающие найти дроп-домен, это автоматизированные системы, значительно упрощающие задачу и позволяющие сэкономить массу времени.

Для чего нужны такие сайты

- Для успешного seo-продвижения сайта. Сейчас максимально действенно использовать данный тип сайта для “подклейки” к ресурсу у которого есть проблемы с ранжированием в google. С дроп домена настраивается 301 редирект на главную или внутреннюю страницу сайта, в результате владелец получает обратные ссылки, авторитет и другие положительные хостовые факторы.

- Для быстрого старта проекта. Молодой ресурс не имеет важных для ранжирования показателей, в то время как домен с историей имеет все необходимые метрики: возраст, трафик, наработанные внутренние и внешние поведенческие факторы. Если цель вебмастера – создание площадки для продажи ссылок, размещения рекламы или какой-либо другой монетизации — дроп поможет хорошо стартовать и поскорее получить заветную прибыль с сайта.

- Для развития PBN-сетки. Больше актуально для бурж проектов и высококонкурентных тематик.

Способы поиска дроп-доменов

Искать подходящие дропы можно как вручную, так и с помощью интернет-сервисов. Расскажем о самых популярных способах.

Поиск дропов с помощью изучения выдачи

Как найти старые дроп-домены высокого качества? Применить самостоятельный поиск. Для этого придется потратить время, но зато можно найти ресурсы, не представленные в автоматических сервисах или те, которые вот-вот освободятся от власти своих владельцев.

Чтобы найти вручную по ссылкам с топовых ресурсов, нужно собрать топ трастовых сайтов интересующей тематики (например, новостных или информационных). Список всех URL нужно вставить в любой парсер, в настройках оставить галочку только напротив графы «внешние ссылки». В итоге получится огромный список сайтов, на которые ведут ссылки с топовых площадок.

Следующий шаг – найти среди них дропнутые. Для этого также можно воспользоваться парсером, запустив поиск по IP. Если у сайта есть IP – значит, он работает. Если напротив URL указано NULL, нужно проверить этот домен сервисом Whois, который сразу продемонстрирует его доступность.

Поиск дроп-доменов с помощью сервисов

Как найти дроп быстрее, чем описанным выше ручным способом? Для этого надо воспользоваться автоматическими сервисами.

Rush Analytics

Инструмент для аналитики, который позволяет проверить на занятость тысячи доменов с помощью сканера Web Archive и через Whois. Поиск можно вести по ключевым словам, и выбрать брошенные сайты со ссылками и уникальным контентом. Система дает возможность выбрать, в каких доменных зонах покупать дропы, предполагает гибкие настройки, благодаря которым можно найти множество ресурсов, недоступных другим сервисам.

Аукционы GoDaddy

Аукцион предполагает, что дроп-домены выставляются на продажу, и по ним ведутся аукционные торги с повышением ставок. Чтобы понять, как выбрать дроп-домен, подходящий под определенные критерии, можно настроить фильтры. Например, можно выбрать только самые популярные лоты или с фиксированной ценой. Поиск платный: регистрация на платформе с доступом к поиску оплачивается на год.

ExpiredDomains.net

Сервис также предлагает фильтры для поиска по многим критериям. Например, чтобы найти тематические ресурсы, можно воспользоваться строкой «Domain Name Contains». Скажем, для поиска кулинарных сайтов используются слова «еда», «рецепты», recipe и другие. Фильтры можно установить по трафику, ссылочной массе и другим показателям. Площадка удобная и понятная: даже новичок легко разберется, как пользоваться ExpiredDomains и как скачать домен.

FreshDrop.com

Один из популярных среди вебмастеров сервисов, ищущий ресурсы в разных зонах. Узнать основные параметры и проанализировать его можно прямо из каталога. К сожалению, делать покупки на сайте нельзя: он является агрегатором, и при выборе подходящего варианта перенаправляет на аукцион.

Name.com

Проверенный и популярный, простой в использовании сервис. По принципу работы похож на GoDaddy, однако обладает ограниченным функционалом. Перед совершением покупки рекомендуется дополнительно проверить показатели на других ресурсах.

Flippa.com

Площадка, которой очень активно пользуются западные seo-специалисты. Здесь можно купить не только дропнутые домены, но и продать. База не слишком обширная, но это компенсируется наличием интересных вариантов, не представленных на других площадках. Подробную информацию о каждом ресурсе можно получить, кликнув на его название.

Dynadot.com

Основное направление работы сервиса – регистрация новых доменных имен. Параллельно он работает и как аукцион. По каждому ресурсу есть подробная информация – не только дата окончания регистрации, но и число ссылок, трафик, средний месячный доход.

Пошаговая инструкция самого простого варианта подборки от специалиста Rush Agency Захара Федоренко

- Регистрируемся на сервисе https://mydrop.io/

- Нажимаем на вкладку фильтров

3. Переходим в первую очередь на вкладку “Поиск по подстроке”.

В поле Title вводим несколько маркерных запросов через запятую (не менее 10, не более 20)

4. Переходим на вкладку “Дата освобождения и статус”. Ставим галочки напротив “Свободные” и “Освобождающиеся”. В полях “Дней до освобождения вводим диапазон 1-10.

5. На остальные поля фильтрации полагаться не стоит, так как они не всегда совпадают с действительностью (поля справа, такие как трафик, ссылочная масса и т.д.) и мы всё равно будем перепроверять их в ahrefs. Поэтому жмём кнопку “Применить фильтры”.

6. Копируем все найденные домены и переносим в таблицу Excel.

7. Переходим в пакетный анализ доменов ahrefs https://app.ahrefs.com/batch-analysis и вставляем туда все найденные варианты. Также меняем режим на без субдоменов.

8. Далее выбираем домены, у которых есть:

— домены-доноры;

— ключевые слова.

9. Обязательно доноров, анкоры (как входящие, так и исходящие). Если видим что-то плохое (порно, казино и т.д.), то такие сайты не нужны.

Переходим в инструмент Rush Analytics — Поиск спама в Webarchive

Ставим период проверки — 1 год

После сбора данных, проверяем, чтобы фильтров никаких не было

10. Переходим в инструмент Rush Analytics — спам в ссылках

Ничего не меняем, просто нажимаем кнопку “Следующий шаг” и в конце вставляем список на проверку.

После проверки обращаем внимание на те сайты, в которых был найден спам в ссылках. Желательно их отсечь.

Данный вариант поиска дропов является самым простым и быстрым. Однако его результативность также является самой низкой. Несмотря на это, пренебрегать им не стоит, так как иногда можно найти что-то подходящее.

Возможные проблемы

Мы перечислили способы, как найти свободный домен. Однако его покупка не означает, что бесперебойная работа сайта вам гарантирована. Не исключено, что уже после приобретения могут появиться следующие проблемы:

- На выбранный вами адрес наложены санкции со стороны поисковых систем. Например, домен ранее мог использоваться для размещения контента для взрослых или, например, поступали жалобы от пользователей на мошеннические действия со стороны администрации сайта. Не все наложенные фильтры можно снять, поэтому очень важно подробно проверить выбранный вами сайт перед покупкой.

- Негатив со стороны прошлого владельца сайта, который забыл продлить регистрацию на своё имя. Он может потребовать вернуть ему сайт. Главное помнить, что тут закон на нашей стороне.

Во всех перечисленных случаях склейка этого домена с собственным сайтом только навредит последнему, а адекватное эффективное продвижение будет невозможно. Чтобы этого избежать, покупку нужно проверять еще перед оплатой.

Какие параметры стоит проверить

Прежде чем покупать дроп-домен, важно убедиться, что это качественный ресурс, использование которого не станет источником проблем. Перечислим характеристики, на которые нужно обращать внимание при проверке кандидата и способы его проверки.

История

Проанализировать нужно не только последнюю версию сайта, но и все предыдущие. Поможет в этом Archive.org – это веб-архив, который бесперебойно собирает и хранит копии интернет-страниц в виде скриншотов. Не стоит брать в расчёт сайты, у которых в течение последнего года был следующие “симптомы”:

- 301 редирект на другой ресурс;

- Белые скриншоты, которые показывают, что сайт не работал.

- Запрещенный контент (тематики: датинг, гемблинг, бетинг, порно).

Выполнить эту задачу быстро и оперативно можно в специализированном сервисе от Rush Analytics.

Добавляете список сайтов на проверку, выставляете необходимый период и получаете результат.

Количество владельцев

Лучший выбор – сайт, у которого был один владелец. Убедиться в этом можно с помощью сервиса whoishistory.ru . При проверке нужно обращать внимание на графу «created»: если она отличается в разных записях – значит, домен передавался от одного хозяину к другому.

Трафик и ссылки

Узнать количество входящих и исходящих ссылок, анкор-лист сайта, количество органического и рекламного трафика можно с помощью различных автоматических сервисов — Аhrefs, Linkpad, Megaindex. Но всегда нужно помнить, что многие вебмастера намеренно скрывают ссылочную массу своего ресурса.

Склейка

Уже упоминалось, что одна из проблем, которые могут возникнуть при покупке домена – 301 редиректы, настроенные на него с других доменов. Если 301 редиректы с других доменов на дроп отвалятся, то он уже не будет так полезен. Такой «клей» нам не нужен.

Вирусы, спам и баны

Проверить сайт на вирусы и спам можно и до его покупки. К сожалению, относительно наличия того или иного бана от ПС на сайте дела обстоят сложнее. О применении санкций может свидетельствовать резкое падение трафика и видимости по поисковым запросам. После покупки домена, восстановления предыдущей версии, сайт необходимо добавить в сервисы Google Search Console и Яндекс Вебмастер. Далее в панелях вебмастеров можно выявить сообщения о критических ошибках на сайте и о наложенных санкциях.

Как найти и перехватить хорошие дроп-домены с трафиком

Опытные веб-мастера перехватывают дропы, отслеживая их на всех площадках и покупая подходящие сразу после их появления. Перечислим несколько способов такого перехвата.

Отслеживайте и делайте ставки на аукционах на разных площадках

Мониторить в поисках подходящих ресурсов можно все площадки сразу, но чаще достаточно двух-трех, подобранных опытным путем. Процесс пойдет быстрее, если есть возможность настроить автоматическое сканирование для поиска ресурсов с нужными параметрами.

Подбирайте и следите за 15-20 доменами единовременно

Необходимо помнить, что из 15-20 отобранных для отслеживания доменов в лучшем случае вы сможете выкупить 2-3 штуки.

Закиньте на счёт аукциона побольше кеша

Если домен действительно хорош, то может разгореться настоящая битва за его выкуп. Будьте готовы потратиться.

Присоединяйтесь к

Rush-Analytics уже сегодня

7-ми дневный бесплатный доступ к полному функционалу. Без привязки карты.

Попробовать бесплатно

Как зарегистрировать дроп-домен

Регистрация – стандартная процедура, которую можно пройти на любой специализированной площадке. В качестве примера коротко опишем процесс регистрации на Timeweb.

Покупка на хостинге Timeweb

Для этого нужно зайти в раздел «Домены», в поисковую строку ввести интересующее название. Если оно свободно, отразится актуальная стоимость регистрации, если занято – появится соответствующая информация. Выбрав свободный, нужно отправить заявку и оплатить, как только хостинг проверит его доступность.

Плюсы и минусы дроп-доменов

Плюсы:

- При подклейке к сайту дают значимый прирост трафика и рост позиций в Google.

- При запуске нового проекта на “старом” сайте с положительной историей сократит время простоя и старта получения прибыли.

Минусы:

Главный недостаток при работе с дропами — это высокая доля риска приобретения сайта под фильтром. При подборе и анализе необходимо быть предельно аккуратным. Кроме того, нет 100% уверенности, что показатели сайта не накручивались искусственно.

Как заработать на дроп-доменах

- Купить дешево — продать дорого. Многие владельцы сайтов забывают оплатить свой ресурс вовремя и платят за это своими нервами и звонкой монетой. Живой тому пример, сайт разработчиков компьютерной игры https://www.stalker-game.com/. Его несколько раз забывали оплачивать разработчики вовремя, и каждый раз платили кругленькую сумму за выкуп доменного имени.

- Запустить свой проект на сайте с хорошими хостовыми факторами. Монетизируйте свой проект — партнерские программы, арбитраж, продажа ссылок, размещение рекламных статей — всё это может приносить хорошие деньги.

Привет! Для начала короткое предисловие. Меня зовут Саша Плеханов, я руководитель отдела интернет-маркетинга Uplab. У нас накопился большой опыт по SEO и SERM, поэтому мы решили завести здесь свой блог. Писать статьи про свою работу — хороший способ расти как специалист.

Это помогает структурировать и дополнять знания в интернет-маркетинге, а общение в комментариях позволяет лучше погрузиться в индустрию, так что мы открыты для любого обмена опытом.

Автором здесь буду не только я, но и мои коллеги. Этот материал от нашего специалиста Александра Колганова. Его опыт в SEO 3 года. Передаю ему слово.

Всем привет! Это Саша Колганов. Свою первую статью я решил посвятить дроп-доменам. Расскажу, что это, в каких случаях их использовать и как найти хороший дроп.

Что такое дроп-домен?

Дроп-домен — это домен, у которого кончился срок регистрации. Причины могут быть совершенно разные: бизнес закрылся, и на сайт просто забили; владелец сайта забыл продлить регистрацию или просто не захотел этого делать; в конце концов, веб-мастера могли просто забрать в армию, и он не смог продлить регистрацию физически (такой случай приключился с моим другом). Но чем может быть полезен заброшенный домен с точки зрения продвижения?

- У дропа может быть просто красивое и звучное имя, которое можно оставить себе или использовать для перепродажи.

- Домен может обладать длительной историей регистрации и вашему сайту не придется сидеть в песочнице поисковой системы.

- У дропа может быть отличная ссылочная масса, а значит, его можно использовать как для основы вашего сайта, так и в качестве донора для своих или чужих сайтов (для продажи ссылок с дропа). Зачастую дропы используют для построения PBN сетей (сети сайтов сателлитов, основной целью которых служит передавать ссылочную массу на продвигаемый сайт), что особенно актуально для продвижения в англоязычном сегменте интернета.

- Из вышесказанного вытекает следующий сценарий — использование дропа для подклейки с основному домену. Представьте, что у вас молодой информационный сайт, который никак не хочет расти. Можно найти дроп-домен этой же тематики и сделать 301 редирект на свой сайт. В итоге вы получаете от дропа обратные ссылки, траст, авторитет и возраст. Таким способом мы имитируем переезд с хорошо ранжируемого домена на текущий.

Но в использовании заброшенных доменов есть и свои риски:

- На домен наложены санкции поисковых систем;

- На домене какое-то время мог быть запрещённый контент, спам или другие материалы, которые в итоге оставили «карму» домену;

- На дроп ведут некачественные ссылки;

- ИКС домена накручен.

Во всех случаях при подклейке такого домена вы сделаете своему сайту только хуже. Ссылки с него не дадут никакой пользы, а если на таком домене будет ваш сайт, вы не сможете его толком продвинуть. Поэтому крайне важно проверять дропы перед покупкой. О том, как это сделать, расскажу ниже.

Способы поиска дропов

Для чего нам может пригодиться дропнутый домен мы разобрались. Но как его найти? Существует несколько основных способов поиска, давайте их разберем.

1. Поиск через сервисы

Есть множество сервисов, в которых уже собрано огромное множество заброшенных доменов, или доменов, у которых кончается срок регистрации, и они скоро освободятся. Посмотрим на самые известные.

Здесь можно найти дропы во всех популярных доменных зонах. Есть удобный фильтр по множеству параметров.

Чаще всего для поиска здесь используется строка Domain Name Contains (в переводе: доменное имя содержит). По нему мы можем найти тематические домены. К примеру, нам нужен дроп для сайта рецептов: вбиваем recipe, eda, либо vkusno и смотрим, что нам предлагают. Для поиска качественного домена выставляем:

- Backlinks от 10

- Возраст от 5 лет

- Citation flow и Trust flow от 10

Стоит сказать, что в ряде случаев CF (поток цитирования) и TF (поток доверия) отображают неверные данные, поэтому сильно внимание на них не обращаем, смотрим домены, где есть хоть какое-то количество бэклинков, составляем список и дальше их анализируем отдельно с помощью сервисов Ahrefs и Majestic, как именно анализировать расскажу ниже.

Похожий функционал, отличается удобным меню при клике на домен, в котором можно сразу посмотреть число страниц в индексе Яндекса и Google, перейти в Вебархив, посмотреть ссылки в сервисах Linkpad и Megaindex.

Выбор доменов здесь меньше, чем в предыдущих сервисах, но порой попадаются отличные варианты. Если домен свободен можно сразу его зарегистрировать.

Что важно знать

Во всех этих сервисах есть уже свободные домены и домены, которые скоро освободятся. Как происходит освобождение домена? Домен, срок регистрации которого истек перестает быть доступным. Но есть небольшой период 30 дней с момента окончания срока регистрации до момента освобождения домена, так называемый период преимущественного продления текущим администратором. Это значит, что нынешний администратор может продлить срок в этот период и тогда домен вновь будет его. Лишь по истечении 30 дней, если владелец не продлил регистрацию, домен можно перекупить. Самые интересные дропы обычно перехватывают в момент освобождения, поэтому имеет место отслеживать именно освобождающиеся домены.

Итак, предположим мы нашли домен, который скоро освободится, как же лучше его перехватить? Для таких целей хорошо подойдет аукцион https://expired.ru/. Принцип работы аукциона следующий: вы делаете ставку, и сервис направляет заявки на все доступные регистраторы, если вашу ставку перебили, сервис информирует вас об этом. Хорошие дропы здесь уходят за десятки и сотни тысяч рублей.

Следует понимать, что даже если у вас самая высокая ставка, это не гарантирует вам победы. Сервис лишь увеличивает шансы перехвата, направляя больше своих мощностей для вашей заявки. В случае проигрыша все средства возвращаются на ваш счет.

2. Самостоятельный поиск

Этот способ позволяет нам найти более качественные домены. Зачастую их не будет в вышеописанных сервисах. Мы будем искать дропы по ссылкам с других сайтов. Предположим нам нужен домен, у которого есть ссылки с трастовых новостных или информационных ресурсов, или с трастовых сайтов определенной тематики. Что мы делаем?

- Берем список всех сайтов, ссылки с которых нас интересуют.

- Вставляем список URL в любой парсер, к примеру Netpeak Spider. Главное, в настройках отключить все галочки, кроме бэклинков. Начинаем парсить. В зависимости от количества загруженных сайтов этот процесс может затянуться на многие часы. В итоге мы получаем целую кучу сайтов, на которые ведут ссылки с ранее отобранных трастовых сайтов.

-

Из огромного списка полученных URL мы будем искать дропнутые. Например, когда-то трастовый сайт, к примеру BBC, сослался на статью другого сайта, но на данный момент он может быть заброшен.

- Нам надо найти этот дропнутый домен. Берем все уникальные домены из списка и загружаем в Netpeak Checker. Ставим галочку на DNS->ip, запускаем парсинг. Получаем таблицу, по которой видно: если у домена есть ip, то он живой; если значение NULL, проверяем этот домен через сервис Whois, который показывает доступность домена.

Этот способ трудозатратнее первого варианта по времени и необходимости пользоваться парсерами, но зато позволяет найти интересные варианты, о которых никто не знает. После того, как мы нашли интересные варианты любым из способов, нужно проверить домен перед покупкой.

Как проверить дроп

- В сервисе majestic смотрим Citation flow и Trust flow. Если TF низкий, а CF высокий, значит очень много ссылок с очень низким качеством, бывает наоборот TF высокий CF низкий, это значит, что ссылки очень качественные, но их мало. Из всех доменов мы должны найти те, у которых TF максимальный, а CF подтягивается к нему (в идеале соотношение стремится к 1). Выбираем домен с соотношением CF/TF в диапазоне от 0,6 до 1,5.

- В то же время смотрим Ahrefs Domain Rating. Но учитываем, что, когда долгое время не ставятся ссылки на сайт, DR по Ahrefs падает, а поскольку мы покупаем заброшенные домены, то такая ситуация здесь зачастую, и она может не показать реального положений дел. Смотрим число ссылающихся доменов, это число должно быть примерно равно бэклинкам. Если ссылок много, а доменов мало, стоит задуматься.

- В сервисе Ahrefs смотрим общую картину по ссылкам. Число ссылающихся доменов и страниц должно расти, ну или по крайней мере, не падать. Резкие всплески на графике тоже могут навести на мысль об отказе от покупки.

- Анкор лист должен быть органичным, без спама ключевыми словами. Хорошо, если анкор лист представляет собой название домена и такие общие слова, как «тут» и «здесь».

- Вручную проверяем качество бэклинков на домен. Смотрим чтобы DR (Домен Рейтинг) и UR (URL рейтинг) ссылки был максимально высокий: минимальное количество доменов-акцепторов с минимальным количеством ссылок и максимальное количество доноров, которые стоят на этот домен.

- Хорошо если органический трафик тоже растет.

- Необходимо проверить индексацию дропа. Если в одном поисковике в индексе есть страницы, а в другом нет, или число страниц в поисковиках сильно отличаются, значит домен проблемный и от его покупки стоит отказаться.

- После всех этих проверок идем в https://web.archive.org/ и смотрим, что вообще было на этом сайте.

На все отмеченные даты можно кликнуть и посмотреть слепок сайта. Важно прокликать все слепки, чтобы убедится, что на сайте не было дорвеев, левого контента, казино, порно и так далее.

И даже после всех этих проверок нельзя со 100% уверенностью сказать, что это качественный дроп. Но таким образом мы повышаем вероятность найти хороший домен.

Мы нашли подходящий вариант, купили, что дальше?

Если мы взяли домен с целью продажи с него ссылок, либо для своей PBN сети, его нужно восстановить с помощью данных с того же вебархива. После восстановления подключаем панели вебмастеров и смотрим, нет ли информации о каких-либо санкциях со стороны поисковых систем на домене. Далее нужно дать домену отстояться примерно месяц и понаблюдать, как индексируются страницы (если их не было в индексе на момент покупки), пойдет ли трафик. В идеале брать сразу штук 10 дропов и смотреть, какие поведут себя лучше. Обычно из 10 дропов только 2-3 домена показывают себя хорошо с точки зрения индексации и роста трафика. Вот с этими дропами мы и продолжаем работать в дальнейшем.

Если мы взяли дроп для подклейки к основному сайту, делаем то же самое и лишь после того, как убедились, что на дроп пошел какой-то трафик, подклеиваем его. После подклейки все равно внимательно наблюдаем, как поведет себя основной сайт. Если сайт начнет падать, придется отклеивать домен.

Когда же мы берем домен для дальнейшего наполнения контентом, следует так же отобрать самый качественный домен, на который пошел трафик, и продолжать заливать на него контент, иначе все старания по развитию такого дропа будут напрасны.

Как вы заметили работа с дропами весьма трудозатратна и кропотлива, а также полна рисков. Но в случае успеха вы сможете получить немало профита с такого сайта, чего я вам и желаю! Если у вас есть опыт по работе с дропами, прошу им поделится в комментариях, конструктивная критика также приветствуется.

Советы

5 причин, почему сайт не продвигается в топ

Разбираем возможные ошибки и варианты их решений

Привет, я Екатерина Хиндикайнен, руководитель Rookee — платформы для самостоятельной оптимизации сайта.

Если вы, как и многие наши клиенты, делаете SEO самостоятельно, и столкнулись с трудностями на этом пути — статья для вас. В ней я разобрала самые распространенные проблемы, которые мешают сайту попасть в топ поиска Яндекса/Google.

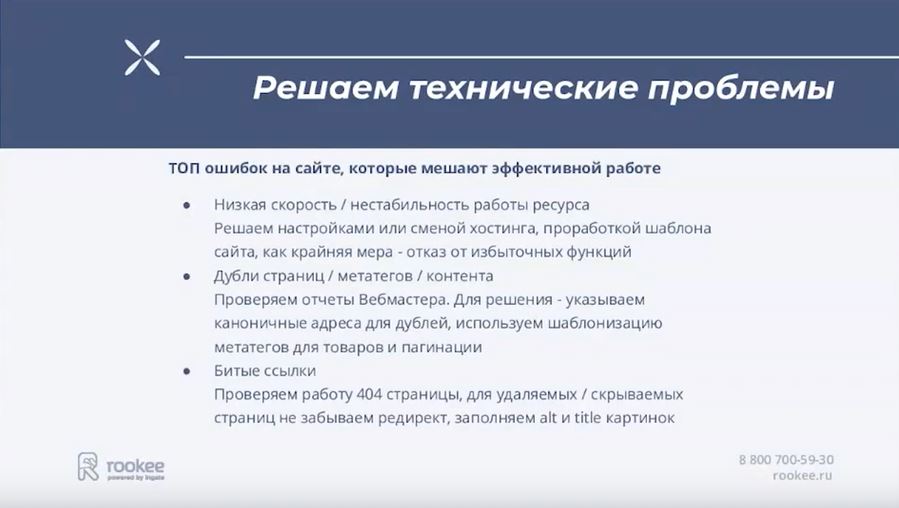

1. Технические ошибки

Сайт не всегда доступен

Если ресурс «падает» даже ненадолго, поисковики это замечают. Ситуация повторяется — теряете позиции в выдаче. Так что если ваш хостинг работает не очень стабильно, то переезжайте на другой.

Страницы не индексируются

Проверить, как поисковики сканируют сайт, можно в Яндекс Вебмастере («Индексирование» → «Страницы в поиске») и Google Search Console («Индекс» → «Покрытие»).

Или вбить в строку поиска «site:», затем без пробела указать URL вашего ресурса — посмотреть, сколько найденных страниц указано в правой части интерфейса. Оба поисковика должны «видеть» примерно одинаковое количество (но допустима разница в 50–100 при тысяче страниц).

Почему роботы могут «не видеть» страницы?

Проблемы с файлом robots.txt. Этот файл помогает поисковым ботам получать информацию о площадке. Он должен лежать в корневом каталоге сайта и включать инструкции о том, какие страницы индексировать, а какие нет, и где найти карту ресурса.

С индексацией будут проблемы, если файл некорректно сделан, не там расположен или его вообще нет. Проверить свой robots.txt на правильность можно в инструментах для вебмастеров Яндекса и Google.

Проблемы с картой сайта. Карта сайта — это список ссылок на страницы ресурса, разбитый по разделам. Может существовать в виде страницы на сайте или как отдельный файл sitemap.xml. (Страница открыта и для посетителей, и для поисковых роботов, а файл — только для вторых.)

Если у вашего сайта нет карты, поисковики не смогут корректно изучить ресурс. Если вы добавили новые страницы, но забыли обновить файл sitemap — боты их не проиндексируют. Если вы скрыли в карте удаленные страницы тегами, это тоже не понравится ботам — в отличие от файла robots.txt, там должны быть ссылки только на актуальный контент.

«Битые» ссылки, некорректная переадресация. «Битые» ссылки ведут на страницу с ошибкой 404 «Страница не найдена». Обычно они возникают из-за переезда ресурса или удаления страниц: в таких случаях настраивают переадресацию, но иногда делают это неправильно, или она со временем перестает работать.

Проверить сайт и устранить некоторые неисправности можно в Вебмастере и Search Console.

Как исправить ошибки со ссылками и редиректом?

- Заменить ссылки на страницы с 404-м ответом на актуальные.

- Заново настроить «отвалившуюся» переадресацию.

- Заменить временный редирект 302 на постоянный 301 там, где 302 был выбран неверно.

- На страницу 404 добавить ссылку на главную и строку поиска.

5. Для всех изображений на сайте заполнить alt и title, чтобы при проблемах с загрузкой отображался текст.

Сайт не нравится посетителям

Понять, насколько ресурс удобный и интересный, можно по различным показателям веб-аналитики, например, посещаемости, отказам, глубине просмотра (количеству страниц, посещенных за один сеанс) и времени, которое люди проводят на сайте. Посмотреть их можно в сервисах веб-аналитики: самые распространенные это Google Analytics и Яндекс.Метрика.

2. Проблемы с контентом

Переоптимизация и переспам

Проще говоря, это переизбыток ключевых слов в контенте страниц или в метатегах (обычно в title и description). Есть много фильтров, которые поисковики могут наложить за такое (не все из них отображаются на панелях Яндекса и Google для вебмастеров, особенно если в бан попал не весь сайт).

Проще ориентироваться на «проседаемость» страниц в выдаче и проверять тексты на «тошноту» (заспамленность ключевиками) — следить, чтобы она не превышала 5-15%. Для этого можно использовать сервисы вроде Text.ru или «Адвего».

Каннибализация запросов

Это когда сайт конкурирует в выдаче с самим собой — потому что разные страницы релевантны одним и тем же запросам (вероятно, потому что оптимизировались под одинаковые ключевые слова или близкие по смыслу). В результате поисковик часто показывает только одну из двух страниц, поэтому каннибализацию не всегда можно обнаружить, вбивая свои ключевики в поиск вручную. Лучше проверять с помощью SEO-сервисов — к примеру, PR-CY.

Если сервис нашел несколько страниц для одного ключевика, надо перенести полезную информацию с одной на другую и удалить лишний вариант. А с адреса удаленной страницы настроить переадресацию.

Дубли

В идеале никакой контент на сайте не должен повторяться. Проверить сайт на наличие любых копий можно в Яндекс Вебмастере (разделы «Диагностика» и «Индексирование», подразделы «Страницы в поиске» и «Заголовки и описания») и Google Search Console.

Что делать с дублями?

Настроить редиректы со страниц с www, если ваш сайт без www.

Указать главное зеркало, чтобы поисковики не путались: с www или без него, с http или c https.

Запретить индексировать тестовые домены и поддомены с помощью файла robots.txt.

В код копий страниц добавить атрибут rel=»canonical» в <head> со ссылкой на адрес той страницы, которая является основной.

Создать статические адреса, уникальные метатеги и сопровождающие тексты для каталожных страниц с фильтрами (иначе при фильтрации ассортимента страница меняет URL).

Для страниц навигации сделать шаблонные теги для пронумерованных страниц ассортимента, добавив тег вида «Страница №».

Самое важное: чтобы не было дублей у самого сайта и главной страницы, потому что именно с нее начинается путь многих клиентов и поисковых роботов. Остальные дубли менее критичны.

Заимствованный или устаревший контент

Поисковики любят оригинальные и актуальные тексты без «воды», которые к тому же легко читаются. Проверить содержимое своего сайта на уникальность, читабельность и «водность» можно в сервисах «Адвего», eTXT, Text.ru, Content Watch и подобных. Лучше сразу в нескольких: показатели разнятся.

Актуальность нужно оценивать самостоятельно. А также следить, чтобы уже опубликованная информация не устаревала. Например, из-за изменений в законодательстве, прекращения поддержки устройств провайдерами ПО, закрытия / открытия границ странами — все зависит от тематики. Если что-то важное изменилось, то контент лучше обновить.

Даже если изначально тексты и изображения были уникальными, позже их могли скопировать конкуренты. Если ранжирование страницы просело, стоит проверить, не своровали ли у вас контент. В таком случае можно потребовать от конкурента удалить информацию, пожаловаться на него в Google/Яндекс или даже обратиться в суд. Или подготовить новый уникальный контент.

3. Некачественные ссылки

Разбираемся, какие ссылки считают таковыми:

Ссылки от «плохих» сайтов-доноров

То есть сайтов, которые ссылаются на ваш.

Доноров нужно проверять прежде всего на качество, спамность (чем больше на сайте ссылок на другие ресурсы, тем больше спамность) и трастовость ( англ. «trust» — доверие). Чем качественнее сайт, тем больше ему доверяют поисковые системы.

Качество выражается в показателях ИКС (индекс качества сайта) Яндекса и PageRank Google, трастовость — в показателях Траст Яндекса и TrustRank Google соответственно. Спамность можно оценить по количеству исходящих ссылок и соотношению исходящих и входящих.

Узнать эти и другие показатели доноров можно с помощью SEO-сервисов: например, CheckTrust, RDS bar и PR-CY. Смотреть лучше в нескольких: как и в случае с проверкой текстов, данные будут отличаться.

Ссылки от доноров такой тематики, которая не коррелирует с вашей

Если тематика той страницы, где размещена ссылка на вас, совсем не соответствует тематике вашего сайта, то это выглядит странно. Хотя бы 30% ссылок должны быть с близких по смыслу страниц (сам сайт может быть другой тематики).

Ссылки со страниц с неуникальным контентом

Напомню, проверить уникальность можно с помощью «Адвего», eTXT, Text.ru, Content Watch и подобных сервисов.

Ссылки неестественного вида или размещенные в неестественных местах

Это может быть, например, ссылка, у которой цвет такой же, как у фона (в таком случае она скрыта от обычного пользователя, видна только для поискового робота). Или опубликованная в неудобном для пользователя месте.

Спамные или явно коммерческие гиперссылки с прямыми вхождениями ключевых запросов

Допустим, ссылка с текстом в духе «купить москва недорого».

Важно: даже если все ссылки качественные, — но их количество слишком быстро увеличивалось, — такое продвижение поисковики могут посчитать искусственным и понизить сайт в выдаче. Лучше наращивать объем с такой же скоростью, с какой это делали конкуренты.

Как улучшить ссылочную массу?

- Размещайтесь на ресурсах своего уровня (примерно такого же размера, качества и возраста).

- Не ставьте ссылки рядом со словами, которые могут указывать на платное размещение («реклама», «спонсор», «партнерский материал» и т.п.).

- Используйте в анкорах низкочастотные запросы: по ним легко поднять в выдаче даже не идеально оптимизированный сайт.

- Используйте разные виды ссылок — арендные, вечные покупные, бесплатные; размещайте их на разных типах страниц и в разных частях страниц; пусть они ссылаются на разные страницы вашего сайта

- Обеспечьте равномерность: примерная норма — 2-3 внешних ссылки, ссылающихся на одну вашу страницу.

4. EAT-факторы

EAT расшифровывается как expertise, authoritativeness, trustworthiness — экспертность, авторитетность и достоверность. Это критерии, по которым Google оценивает сайты. У Яндекса есть аналогичная метрика Proxima.

EAT и Proxima используются для оценки всех сайтов, но наибольшее значение имеют для тематик, где можно серьезно навредить людям. Google традиционно относил такие сайты к категории YMYL (Your Money or Your Life), то есть оказывающие влияние «на жизнь или финансовое благополучие человека». У Яндекса нет специального термина, но суть та же: для поисковика есть сайты серьезных тематик, которые он придирчиво проверяет.

YMYL — это, в первую очередь, медицина (а также все, что касается здоровья), финансы, недвижимость, электронная торговля — их проверяют строже всего. Во вторую — юриспруденция (включая госучреждения, ресурсы о законах, правах и обязанностях), наука (в т.ч. все о технологиях), услуги, новостные и общественно-политические СМИ, а также все остальное, что может повлиять на счастье или достаток.

Важно: в обновлении своего руководства от 28 июля 2022 года Google указал, что оценивает именно по EAT не только страницы YMYL-тематик, но и все другие, которые «с большой вероятностью могут навредить читателю».

Как оптимизировать сайт под EAT?

Покажите, что контент экспертный и подготовлен профессионалами. Опубликуйте лицензии, сертификаты, дипломы, награды, аккредитации компании и сотрудников, логотипы известных клиентов и партнеров, подпишите профильные статьи именами своих экспертов.

Покажите, что компания и сотрудники — авторитеты в своей сфере. В этом помогут обратные ссылки на сайтах, которые заслуживают доверие поисковиков, отзывы авторитетных клиентов, рейтинги бизнеса на картах, профили ваших специалистов, если они известны в сети (здорово, если человек ведет профильный блог / записывает подкаст, пишет статьи или книги, состоит в профессиональных сообществах, участвует в мероприятиях отрасли, особенно в качестве члена жюри).

Покажите, что вам можно доверять.

Во-первых, получите SSL-сертификат — он защищает информацию и подтверждает подлинность сайта. Если ваш сайт загружается, когда вы указываете https в URL, значит сертификат уже есть. Если не загружается — его нет или он неправильно установлен. Вероятно, его надо купить или получить от хостинга (они часто дают SSL базового уровня бесплатно на какой-то период).

Во-вторых, опубликуйте всю важную информацию об организации и о том, чем она занимается: наименование юрлица, адреса, реквизиты, контакты, максимально полные данные о продуктах / услугах (параметры товаров, условия обслуживания, гарантии, способы оплаты и доставки, условия возврата).

5. «Заброшенность» сайта

Как поисковики могут определять неактуальность:

Сайт не обновляется

Даже если опубликованный контент еще актуален, но на сайте нет новых материалов, никто не отвечает на комментарии пользователей, не добавляются новые товары / услуги — поисковики решат, что ресурс «забросили».

Стоит регулярно обновлять старые страницы и те, на которых «проседает» трафик: роботам будет достаточно даже добавления нескольких слов.

Сайт не соответствует современным требованиям поисковиков

Требования Google и Яндекса регулярно меняются: появляются обновления существующих метрик, создаются новые фильтры и алгоритмы, упраздняются одни показатели и вводятся другие. Если за всем этим не следить, можно оказаться в ситуации, когда привычный подход не дает результата или даже вредит.

Самостоятельно проверить свой сайт на вышеперечисленные проблемы (и не только) можно на нашей платформе Rookee. Аудит автоматический и бесплатный.

ЭКСКЛЮЗИВЫ ⚡️

Читайте только в блоге

Unisender

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

«Честно» — авторская рассылка от редакции Unisender

Искренние письма о работе и жизни. Свежие статьи из блога. Эксклюзивные кейсы

и интервью с экспертами диджитала.

Содержание

Частые причины: индексация, сильная фильтрация документов, аффилированность группы сайтов, смена CMS

ТОП-2: сильная фильтрация сайта/документа

ТОП-3: аффилированность сайтов [4]

ТОП-4: смена CMS или структуры URL на сайте

ТОП-5: смена типа поискового запроса и/или алгоритма поисковой системы

ТОП-7: Фильтр на одинаковые сниппеты

ТОП-8: некорректность файла robots.txt или meta-тегов

ТОП-10: Санкции за накрутку ПФ

С чего следует начинать любой анализ

Список ссылок и литературы

Введение

В случае потери позиции по одному или нескольким продвигаемым поисковым запросам, важно быстро и правильно диагностировать причину такого выпадения. Только после диагностики можно назначить «лечение» для каждого поискового запроса отдельно и вернуть сайт на лидирующие позиции Яндекса и Google.

В ряде случаев (даже в один апдейт выдачи Яндекса) могут быть найдены сразу несколько существенных причин, мешающих сайту продолжать занимать лидирующие позиции в ТОП-10 (ТОП-20) выдачи. Именно поэтому, не всегда можно одновариантно ответить на вопрос «Почему мой сайт выпал из ТОПа такого-то числа?».

Далее изложение будет вестись исходя из того, что продвигаемый сайт уже находился примерно в ТОП-20 выдачи по интересующему запросу и неожиданно полностью пропал (выпал на сотые места, ТОП-100). Давайте попробуем произвести систематическое изложение наиболее популярных (иногда и очевидных) для этого причин.

Сайты с вторконтентом, просто безумным количеством мешающей рекламы и дорвеи в рассмотрение браться не будут. Интерес представляют именно коммерческие сайты, созданные для людей.

Частые причины: индексация, сильная фильтрация документов, аффилированность группы сайтов, смена CMS

ТОП-1

ТОП-1 нашего импровизированного рейтинга «Причины выпадения» занимает индексация продвигаемого документа.

Симптом: сайт резко выпадает или теряет позиции со сменой релевантной страницы. Позиции теряются по всем запросам, ведущим на страницу.

Проверка: для проверки индексации документа в поисковой системе Яндекс достаточно ввести следующий запрос: [url:site.ru/catalog/page.php]. Если выдача пустая, значит, продвигаемый документ выпал из выдачи и в первую очередь требуется вернуть его в индекс поисковой системы [1]. В данном случае можно просто подождать следующего апдейта выдачи.

(!) Важно: правильно вводите URL документа, результат будет отличаться для доменного имени, введенного с www и без, со слешем на конце и без.

(!) Совет: быстрой индексации документа может существенно поспособствовать постановка нескольких ссылок из индексирующихся социальных медиа, таких как Twitter, FaceBook, LiveJournal и других (см. рисунок 1).

Рисунок 1. Наиболее свежие результаты по запросу [продвижение сайта самостоятельно] в Яндексе. Их появление обязано существованию быстрого робота и отдельной базы, предназначенной отдельно для свежих документов.

(!) Совет: осуществите поиск по сайту по интересующему поисковому запросу. В данном случае поможет запрос вида: [продвигаемый-запрос site:domain.ru]. Интересующий документ должен быть на 1 строчке в выдаче. Если его нет среди релевантных ответов, то это также свидетельствует о выпадении его из индекса.

ТОП-2: сильная фильтрация сайта/документа

Наиболее часто встречаемые текстовые фильтры (описанные в соседней статье) редко могут выбить коммерческий сайт из ТОП-10 сразу на сотые места [2]. В данном случае особое внимание следует уделить возможным сильным фильтрациям, таким как Adult-фильтр [3] и АГС.

Симптом Adult-фильтра: сайт почти полностью теряет входящий поисковый трафик. На нормальных позициях в выдаче остаются только запросы «взрослого характера». Сайт не ранжируется даже по кускам уникального текста. Трафик из других поисковых систем при этом остаётся на примерно постоянном уровне.

Симптом фильтра АГС: из видимой части индекса поисковой системы выпадет ряд содержательных страниц сайта (старые версии АГС) или обнуляется значение показателя тИЦ (новые версии). Читайте также: «Как отличить сайт под АГС от сайта с тИЦ=0».

Проверка Adult-фильтра:

- по запросу вида [site:domain.ru] количество документов осталось на прежнем уровне;

- сайт не ранжируется даже по уникальным фрагментам текста со страниц в индексе [url:domain.ru/dir/page.html];

- трафик с Яндекса по статистике падает в 2-30 раз;

- трафик с других поисковых систем остаётся на прежнем уровне;

- если ввести запрос относительно взрослого содержания, позиция сайта останется неизменной.

Проверка АГС:

- по запросу вида [host:site.ru] количество документов в выдаче не больше 100 (старые версии АГС);

- количество страниц в индексе других поисковых систем осталось на старом уровне и значительно превышает 30 (при их наличии на сервере, конечно);

- у сайта обнулилось значение показателя тИЦ и проверка на АГС подтверждает наличие фильтра.

Диагностировав, какая именно санкция была применена к вашему сайту, вы сможете направить все силы именно на её устранение.

(!) Важно: в случае с Adult-фильтром причиной может быть размещенная на сайте тизерная сеть или партнерка с «сомнительными» материалами. Иногда вам хватит и единственной ссылки на «взрослый» сайт, чтобы привлечь внимание фильтра.

(!) Важно: в случае АГС причиной служит содержимое низкого качества, дублированный контент, продажа ссылок. Особенно подвержены АГС молодые проекты.

(!) Совет: если вы сильно потеряли в трафике или в количестве страниц в выдаче, то можете смело писать вежливое письмо в техническую поддержу Яндекса для уточнения возможных причин. По обоим вышеперечисленным фильтрам сотрудники поддержки периодически подсказывают возможные причины наложения санкций (хотя и шаблонным образом).

(!) Совет: под АГС можно загнать и неплохой клиентский сайт, если бездумно плодить статьи. Желательно, чтобы каждый добавленный на сайт материал нёс смысловую нагрузку (решал какую-либо задачу пользователя) и был оптимизирован под 2-3 низкочастотных целевых поисковых запроса.

ТОП-3: аффилированность сайтов [4]

В 2011-2014 годах Яндекс более серьёзно взялся за проблему аффилированности двух и большего числа сайтов одной тематики (сайтов, принадлежащих одной компании). В результате чего, ряд сайтов ранее успешно уживавшихся одновременно в ТОП-10 или ТОП-20 выдачи — утратили свои позиции.

Симптом: сайт резко выпадает из ТОП-100 выдачи по запросу или некоторым запросам. Иногда, позиции могут менять скачком на протяжении нескольких апдейтов подряд (5 место — нет в сотне — 4 место — нет в сотне — …).

При аффилированности двух и большего числа сайтов — в выдаче по каждому запросу остаётся только один, как правило, более релевантный запросу. Остальные аффилиаты скрываются или существенно занижаются в занимаемых ими позициях [4].

Проверка: чтобы понять, что ваш сайт был признан аффилированным с другими, достаточно произвести следующую последовательность действий:

- задать поисковый запрос, по которому ваш сайт был в ТОП-10 выдачи до этого;

- последовательно исключить из выдачи каждый из сайтов в ТОП-20 и проследить за выдачей (см. рисунок 2). Запрос вида: [продвигаемый-запрос ~~ site:domain.ru];

- если вы исключили один из сайтов и ваш проект тут же начал ранжироваться высоко (появился в ТОПе), то это значит, что исключенный домен и ваш — являются аффилиатами;

- для уверенности, лучше проделать процедуру и для других продвигаемых фраз.

Автоматизация диагностики: доступна в соответствующем инструменте «Пиксель Тулс».

Рисунок 2. Пример продвигаемого поискового запроса и последовательное исключение подозрительных на аффилированность доменов для поиска своего проекта.

(!) Важно: не забывайте, что аффилированных сайтов может быть несколько и по разным запросам разные домены могут мешать вам в выдаче.

(!) Совет: можно резко сузить круг подозрительных доменов, если сравнить выдачу по двум и большему числу запросов и выявить сайты, присутствующие и там и там. Иногда это поможет сузить «круг претендентов» до 1-2 штук.

(!) Совет: аффилированность в большинстве случаев накладывается автоматически. То есть и снять её можно без обращения в службу поддержки — устранив все возможные причины. Пересекающиеся контактные данные, тексты, изображения, IP-адрес хостинга, схожесть названий компаний и доменных имен и другие факторы. Действуйте!

ТОП-4: смена CMS или структуры URL на сайте

Выпадение может произойти в случае смены URL-структуры на сайте. Требуется наиболее оперативно настроить 301-редиректы [11]. В отличие от простого выпадения документа из индекса, тут могут быть некоторые нюансы: текущий продвигаемый URL может находиться в индексе поисковой системы (пункт 1), в то время как старый URL будет отдавать 404 ошибку.

Симптом: вы недавно меняли CMS или некоторые из URL продвигаемых страниц, после чего (5-30 дней) позиции по целому ряду запросов резко ухудшились.

Проверка: обязательно посетите панель Вебмастера [8]. Сайт > Индексирование сайта > Исключенные страницы > HTTP-статус: Ресурс не найден (404) (см. рисунок 3). Если среди списка вы нашли URL адреса ранее находящиеся в ТОПе — это оно.

Рисунок 3. Поиск списка страниц на сайте, отдающих 404-ошибку. Для каждой страницы требуется предпринять меры: настроить 301-редирект, убрать ссылки, ведущие на страницу, или закрыть документ от индексации.

(!) Важно: при смене URL-структуры всегда настраиваете 301-редирект [11], это поможет избежать выпадений и сохранит ранее накопленную ссылочную массу и возраст документа.

(!) Совет: посещайте вкладку исключенных страниц не реже раза в 2-4 недели. Часто, естественные ссылки могут вести на не существующие страницы вида «site.ru/.» или «site.ru/-». Настройка сервера позволит преобразовать эту ссылочную массу в работающую на благо ресурса.

Из того, что встречается чуть реже: смена типа поискового запроса и алгоритма, вирусы, фильтр на одинаковые сниппеты (карточки), прочие опасности

ТОП-5: смена типа поискового запроса и/или алгоритма поисковой системы

Каждый запрос, который вводят в современную поисковую систему проходит определенную классификацию. Это значит, что в зависимости от определенных характеристик запроса — он будет по-разному обрабатываться поисковиком.

(!) Важно: Для разных классов запросов — применяются разные формулы. Ряд факторов — также принимают отличные значения для запросов разной классификации.

Полностью понять и проанализировать, как поисковая машина классифицирует тот или иной запрос для рядового пользователя — не представляется возможным. Но получить некоторые характеристики (по поведению поисковой системы) и применяя логику — возможно.

(!) Важно: Базовая характеристика запроса — его геозависимость (геонезависимость) [5].

Очевидно, что в случае смены классификации запроса с геозависимого на геонезависимый (и наоборот) — меняется формула ранжирования, и позиции сайтов в ТОПе изменяться кардинально. Схожие изменения могут наблюдаться и в случае изменения алгоритма ранжирования Яндекса.

Симптом: сайт по продвигаемому запросу резко меняет занимаемую позицию.

Проверка: чтобы отличить изменение классификации поискового запроса и смену алгоритма от других причин, требуется произвести следующую последовательность действий:

- проверить текущий тип запроса (геозависимый он или нет) [6];

- если известно, какой тип запроса был у него до апдейта и он поменялся в ближайший апдейт — значит, причина кроется в этом;

- если нет: проверить и выписать ТОП документов по интересующему запросу;

- сравнить этот список со списком сайтов находящихся там до выпадения (в предыдущую дату);

- произвести анализ: если ТОП поменялся крайне сильно (более 5-10 новых сайтов на лидирующих позициях, сильная тряска) — значит, произошло изменение алгоритма или типа поискового запроса;

- произвести анализ: если изменения носят локальный характер — выпало 1-2 сайта, среди которых оказался ваш — причина кроется в чём-то другом.

(!) Важно: старайтесь всегда анализировать выдачу комплексно, а не мониторить только подвижки одного проекта. Это позволит составить более правильно представление об апдейте. В этом поможет собственная система мониторинга выдачи или сторонний сервис [7].

ТОП-6: вирусы на сайте

Каждый из вебмастеров должен заботиться о продвигаемом им сайте. Причиной выпадения проекта может стать наличие вредоносного кода на сайте вкупе с длительным игнорированием этого факта.

Рекомендуется периодически просматривать выдачу руками на наличие специальной пометки страницы в результатах поиска Яндекса и наиболее оперативно реагировать на проблему. Специальные оповещения о заражении приходят также пользователям, подтвердившим права на сайт в панели Вебмастера [8].

(!) Важно: игнорирование специальной пометки в результатах поиска чрезвычайно негативно сказывается на позициях, так как у документа существенно снижаются значимые поведенческие факторы, такие как CTR по запросу, общее количество кликов и прочие.

(!) Важно: соблюдайте элементарные правила безопасности. Не храните пароли в FTP-клиентах, не используйте стандартные и популярные пароли, периодически меняйте доступы.

(!) Совет: оптимально устранять проблему заражения ещё на том этапе, когда пометка в выдаче не успела появиться. Это возможно, если регулярно посещать сайт с включенным антивирусом, следить за количество страниц в выдаче и незапланированными изменениями файлов на сервере (js ,php, .htaccess).

ТОП-7: Фильтр на одинаковые сниппеты

Поисковые системы сильно заботятся о своей выдаче, её полноте и разнообразии. Пользователь должен быть удовлетворён результатами по своему запросу, даже если ввёл весьма неоднозначный поисковый запрос. Яндекс решает эту задачу тремя основными приёмами:

- Поисковая технология «Спектр», внедренная в декабре 2010 года [9]. «Спектр» направлен на разнообразие результатов выдачи по неоднозначным поисковым запросам.

- Скрытие предложений товаров и услуг от «схожих» или одинаковых компаний (аффилированность, см. пункт 3).

- Фильтр на одинаковые сниппеты: скрытие результатов, которые по тем или иным причинам содержат повторяющийся сниппет (текстовое описание, анонс), см. рисунок 4.

Рисунок 4. Вывод полного списка релевантных сайтов с добавление параметра &rd=0 в URL позволяет проверить — попал ли продвигаемый сайт под фильтр Яндекса на одинаковые сниппеты или нет.

Фильтр на одинаковые сниппеты наиболее часто встречается при продвижении конкретных товарных позиций интернет-магазинов. Если анонс вашего документа полностью или почти полностью дублирует анонс другого сайта, то один из результатов будет скрыт для пользователей. Отобразить все релевантные сайты можно, если нажать на ссылку «Показать всё без исключения» после последнего результата или дописать в конце URL: &rd=0.

Симптом: сайт теряет позицию по одному или нескольким товарным запросам.

Проверка: при этом, позиции сильно улучшаются, если просмотреть выдачу с параметром &rd=0 в URL или нажать на ссылку «Показать всё без исключения».

(!) Важно: фильтр накладывается, если описание товаров или его характеристики не являются уникальными. И не уникальная фраза участвует в формировании сниппета. При этом ваш сайт не признаётся Яндексом автором контента.

(!) Совет: если попали под фильтр, добейтесь уникальности дополнительного описания товара. Заполните meta-тег description привлекательным и не спамным содержимым. Допишите в начале карточки 2-3 уникальных предложения с содержанием ключевой фразы.

(!) Совет: далеко не всегда 100% уникальность текста на странице даст весомый плюс в ранжировании карточки товара. Но, чтобы не попасть под фильтр (а в поисковой системе Google это может быть и Панда [10]), рекомендуется добавить на страницу уникальное содержимое: анонс, отзывы, обзоры, расширенные данные о продукте.

ТОП-8: некорректность файла robots.txt или meta-тегов

Часто причиной резкой потери позиции может быть некорректное содержание файла robots.txt, который отвечает на сканирование сайта пауками поисковых систем, а также наличие meta-тега robots, запрещающего индексацию документа.

То что страница разрешена к индексации, можно проверить с помощью сервиса ADD URL в Яндексе [1], просто введя интересующий адрес в форму, если документ запрещен к индексации посредством файла robots.txt или meta-тега, то выведется предупреждение свидетельствующее об этом (рисунок 5).

Рисунок 5. Вывод сообщения «Указанный URL запрещен к индексации в файле robots.txt» при добавлении документа в сервис ADD URL Яндекса.

Пример корректно составленного файла:

User-Agent: Yandex

Disallow: /papku-ne-nado-indeksirovat

Disallow: *?i-etot-get-parametr=*

Host: www.pixelplus.ru

User-Agent: *

Disallow: /papku-ne-nado-indeksirovat

Disallow: *?i-etot-get-parametr=*

Дополнительно стоит проверить наличие и корректность атрибута rel=»canonical» тега <link>. Его требуется использовать, если на сайте есть два и большее количество URL-адресов, по которым оказывается доступен один и тот же документ. Скажем:

- https://pixelplus.ru/samostoyatelno/stati/

- https://pixelplus.ru/samostoyatelno/stati/?from-email

- https://pixelplus.ru/samostoyatelno/stati-po-seo/

Тогда, чтобы избежать наличия дублей в индексе, на всей группе одинаковых страниц устанавливается тег, указывающий основной адрес (канонический). Если атрибут указан некорректно, то это может привести к выпадению нужных документов из индекса. Пример тега:

<link rel=»canonical» href=»https://pixelplus.ru/samostoyatelno/stati/» />

ТОП-9: Прочие опасности

Выше были рассмотрены наиболее частые причины выпадения коммерческих сайтов из ТОП-10 лидирующей поисковой системы рунета — Яндекса. Но в ряде случаев, SEO-специалиста могут подстегать и более редкие опасности. Обращать на них внимание можно, если ни один из описанных выше приёмов проверки не сработал.

Просто перечислим их, чтобы далее читатель понимал, куда можно двигаться в случае неудачи:

- Изменение региональной привязки сайта. При ранжировании по геозависимым поисковым запросам поисковая система Яндекс обращает пристальное внимание на совпадение региона пользователя и региональной привязки сайта. Если в какой-то момент у вас сменилась эта привязка — это станет причиной существенного изменения занимаемых позиций. Важно отслеживать привязку в панели Вебмастера (Сайт > География сайта > Регион сайта) и периодически проверять, что всё в порядке.

- Выпадение сайта в результате пересчета категорий ответов в поисковой технологии «Спектр». Требуется понять, мог ли выводиться ваш сайт, как примесь по одной из дополнительных категорий ответов «Спектра».

- Дубли страниц в рамках одного сайта. В случае нормально настройки работы сайта (CMS и хостинга) этой проблемы можно полностью избежать, однако в большинстве случаев, по разным URL адресам в рамках одного сайта — отдаётся одинаковое содержимое. Однажды это может сильно аукнуться, если в индекс попадёт сразу несколько полных копий продвигаемого документа. Для проверки осуществляйте поиск уникального фрагмента текста в рамках сайта. Здесь поможет поисковый запрос следующего вида: [«уникальный_текст_со_страницы» site:host.ru].

- Ваш ресурс содержит избыточное количество неуникальных текстов, это может сказаться и на позициях страниц, которые содержать уникальный материал.

- На сайте размещен Popunder или навязчивая реклама открывается при клике пользователя.

- Смена доменного имени: требуется чётко соблюдать последовательность действий. Сначала указываем главное зеркало в robots.txt в директиве Host и только после склейки/переклейки ставим 301-редирект, а не наоборот!

ТОП-10: Санкции за накрутку ПФ

В 2014 и 2015 годах, многие сайты стали подвергаться санкциям за накрутку кликовых поведенческих факторов.

По заверениям представителей поисковой системы Яндекс под пессимизацию попали несколько тысяч сайтов, которые имели отношение к накрутке и манипуляции действий пользователей.

При этом, сама санкция является очень сильной и длительной — от 6 календарных месяцев. Для диагностики факта наложения санкций за накрутку ПФ — рекомендуется написать соответствующий вопрос в службу поддержки Яндекса. Также, рекомендуются следующие действия для снятия санкций, в зависимости от срока их применения: ответ на вопрос.

С чего следует начинать любой анализ

Помните, анализ причины требуется начинать с полноценной оценки ТОПа и сравнению выдачи до и после апдейта. Это позволит вам быстро отделить локальные подвижки (изменение позиции 1-3 сайтов) от глобального апдейта алгоритма/классификации запроса и существенно сузить круг возможных причин.

Список ссылок и литературы

- Сообщить о новом сайте, Яндекс, http://webmaster.yandex.ru/addurl.xml

- Текстовые фильтры Яндекса: давайте различать, 19 ноября 2012.

- Поиск Яндекса и контент для взрослых, 29 июня 2009, http://company.yandex.ru/rules/filtration/

- Что такое аффилированные сайты? Как аффилированность двух сайтов сказывается на занимаемых ими позициях, 2011.

- Поиск с учётом региона, http://company.yandex.ru/technologies/regions/

- Сервис SEO hint, 2012, http://seohint.ru/

- Сервис MegaIndex, 2009, https://www.megaindex.ru/?tab=wordAnalyze&do=wordAnalyze

- Панель Вебмастера от Яндекса, http://webmaster.yandex.ru/

- Спектр, 2010, http://company.yandex.ru/technologies/spectrum/

- Нам не страшен злой Пингвин, 2012, http://www.seonews.ru/analytics/detail/125096.php

- Как правильно сделать 301-редирект.

В процессе продвижения сайта в поиске нужно постоянно отслеживать текущие позиции, чтобы понимать, всё ли правильно вы делаете или нужно скорректировать действия.

Для разового съема позиций подойдут бесплатные инструменты или ручная проверка. Для регулярного мониторинга – платные с более широким функционалом. Рассмотрим все способы в этой статье.

Проверка позиций вручную

Самый очевидный способ узнать, на какой позиции в естественной выдаче находится ваш сайт по определенному поисковому запросу.

Просто как дважды два: пишете запрос – находите в выдаче ваш и считаете позицию.

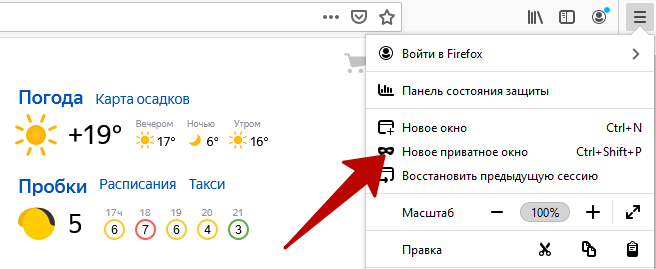

Важно: выполняйте такую проверку в приватном режиме (или режиме «Инкогнито»), так как иначе выдача будет персонализирована по интересам и истории посещения сайтов (она различается для каждого интернет-пользователя).

Второй момент: выдача может отличаться для разных людей по геозависимым запросам («фитнес рядом», «прокат авто» и другие, связанные с локальным бизнесом).

Поэтому чтобы получить более точные результаты, нужно снимать позиции отдельно по каждому городу, где живет ваша целевая аудитория – указывать его в настройках.

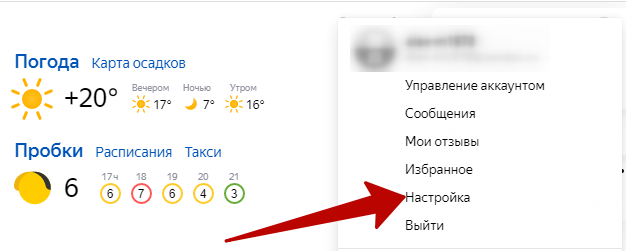

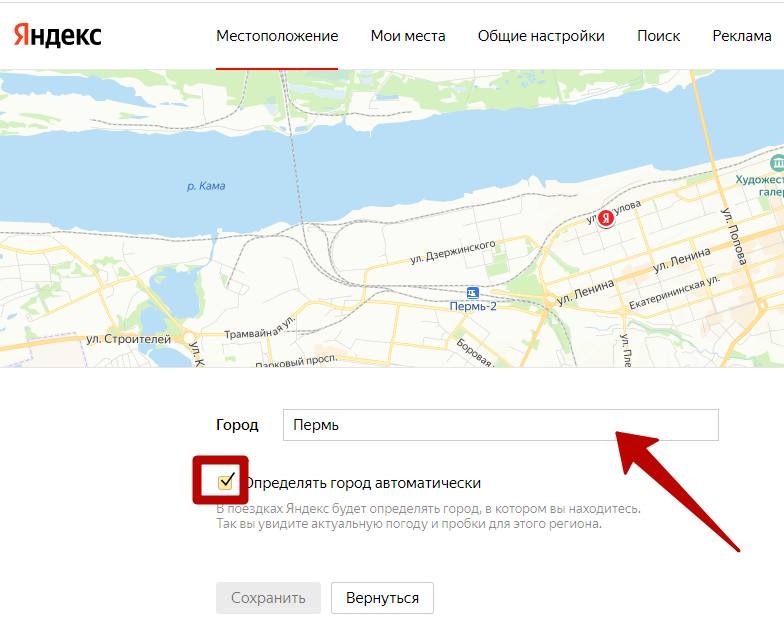

В Яндексе это делается так: кликните по аватарке аккаунта в Яндексе на главной странице, перейдите в настройки и кликните «Изменить город».

Отключите автоматическое определение города (уберите галочку) и впишите в поле нужный.

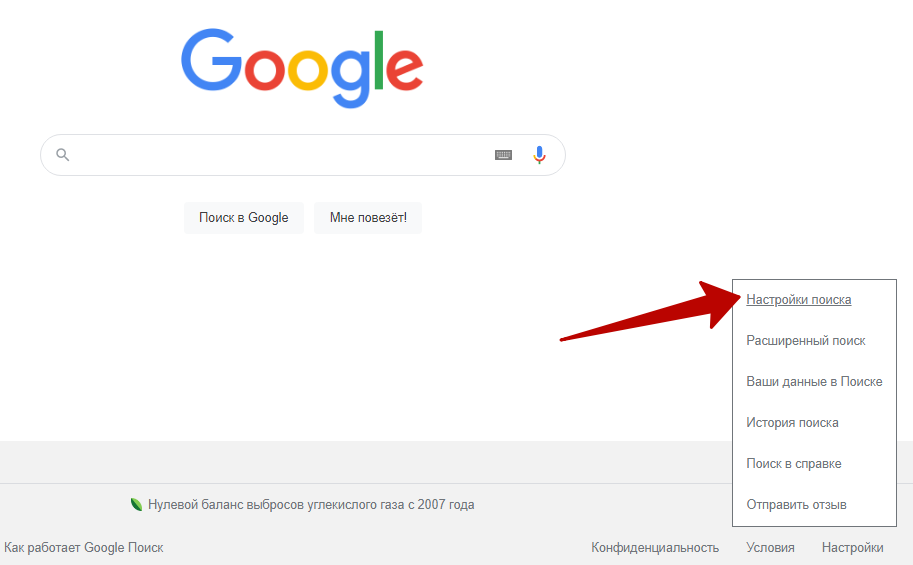

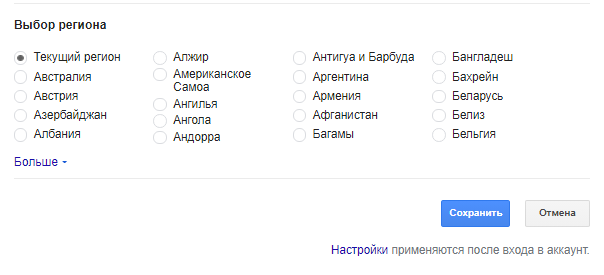

В Google можно уточнить выдачу только по стране. Для этого на главной странице нажмите «Настройки», затем «Настройки поиска».

В разделе «Выбор региона» укажите нужный и сохраните.

Плюс: вы получаете точные данные в режиме реального времени и ничего за это не платите.

На деле это монотонная работа, которая занимает много времени. Чем больше запросов – тем больше трудозатрат и выше риск допустить ошибки. Тем более – если придется каждый раз переключать местоположение.

Вывод: такой способ подойдет, если нужно узнать в короткое время, где показывается сайт по небольшому количеству запросов (1-5). В остальных случаях лучше автоматизировать процесс.

Яндекс.Вебмастер

Это сервис, в котором можно бесплатно посмотреть усредненные позиции сайта за неделю. Помимо этого в нем можно отслеживать всю техническую сторону сайта: все запросы, по которым вас ищут, показы, клики, CTR и т.д.

Все возможности и лайфхаки сервиса Яндекс.Вебмастер смотрите здесь.

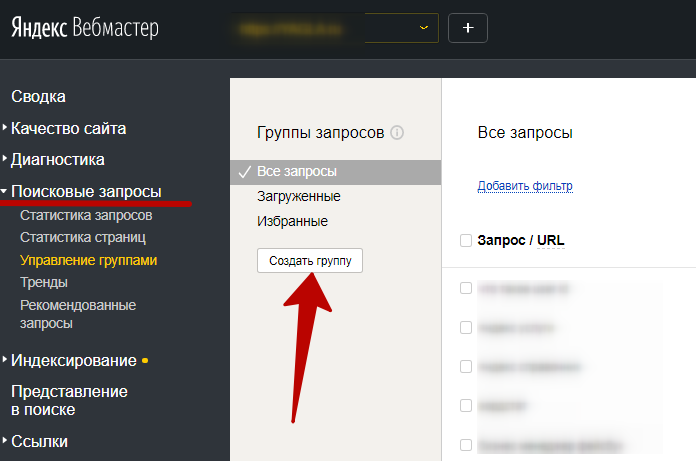

Где смотреть позиции? Раздел «Поисковые запросы», подраздел «Управление группами».

Создайте группу запросов, чтобы было удобно смотреть показатели только по релевантным запросам. Максимум, добавить в неё можно 500 запросов. Групп для одного сайта может быть до 100 штук.

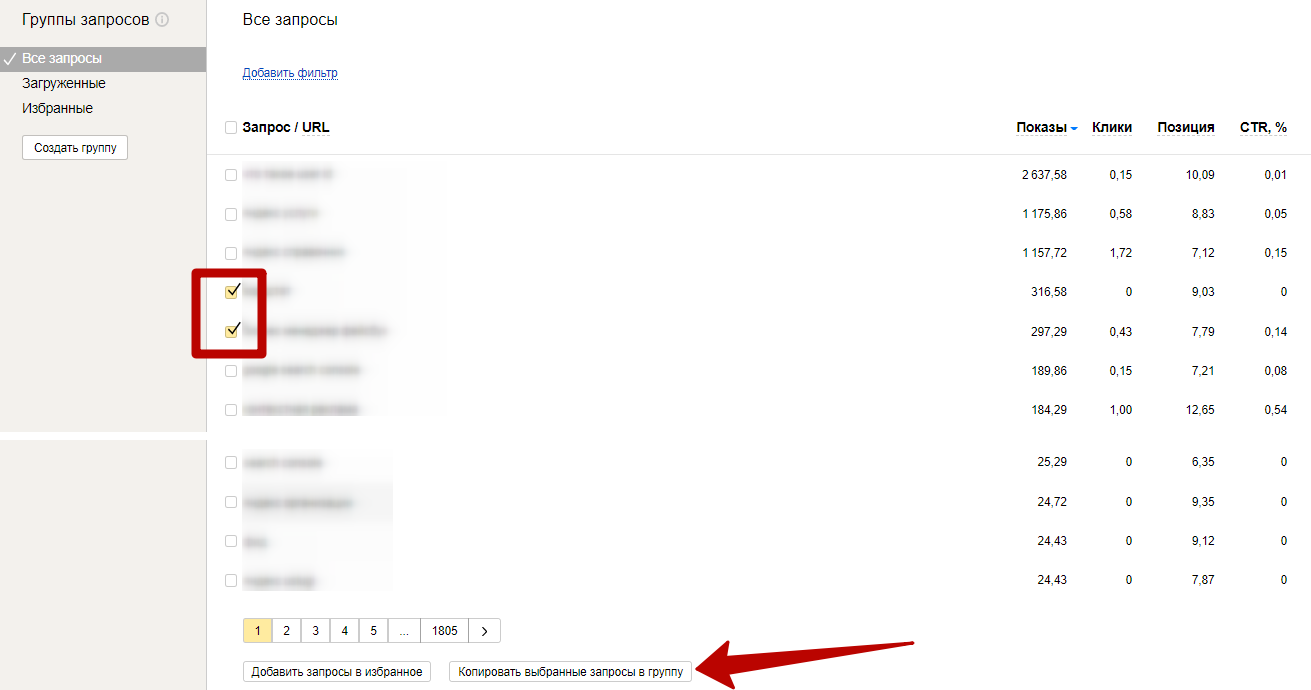

Добавить запросы в группу можно из отчета «Все запросы» (он сейчас открыт), выделив галочкой.

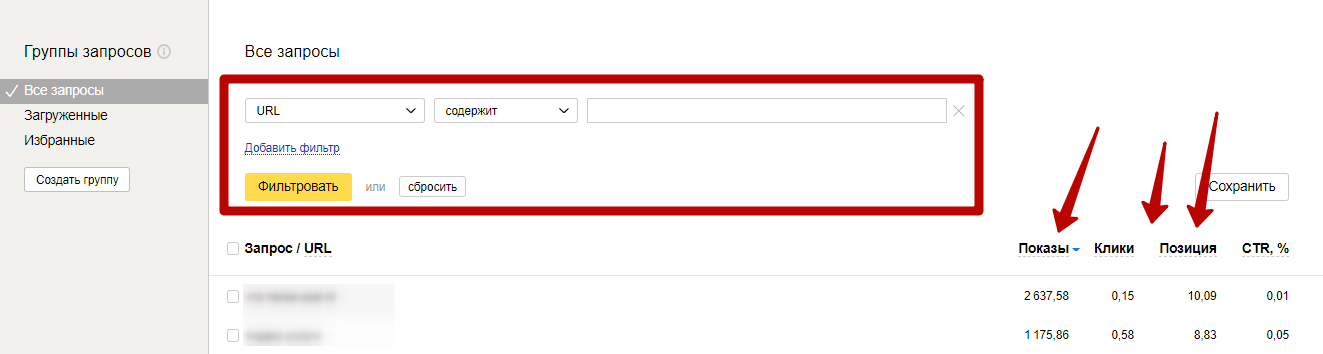

Можно воспользоваться фильтрами для быстрого поиска нужных ключей. Например, по URL, числу показов, числу кликов, средней позиции или тексту запроса. А также сортировкой по показателям в таблице (клик по названию столбца с нужным показателем).

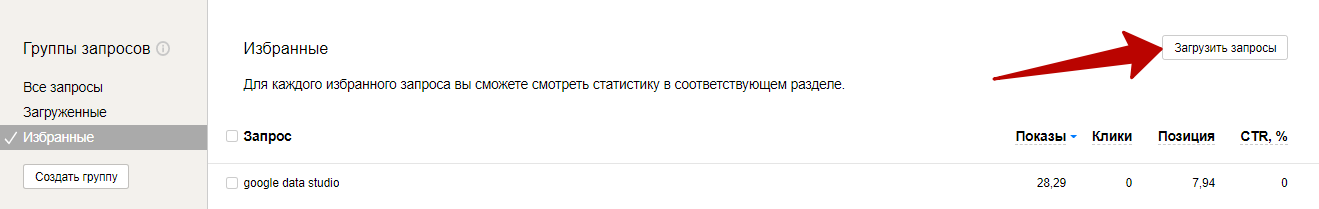

Также в группы можно загрузить свои ключевые запросы списком или в виде файла.

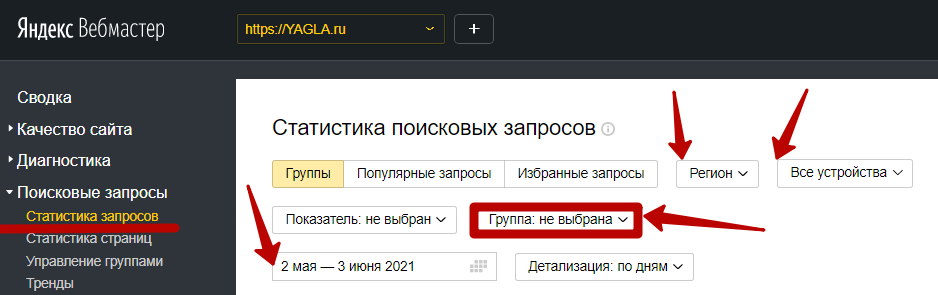

В дальнейшем регулярно отслеживать позиции по выбранным запросам можно в разделе «Статистика запросов». Выберите нужную группу и, если нужно, отфильтруйте данные по региону, типу устройств, периоду.

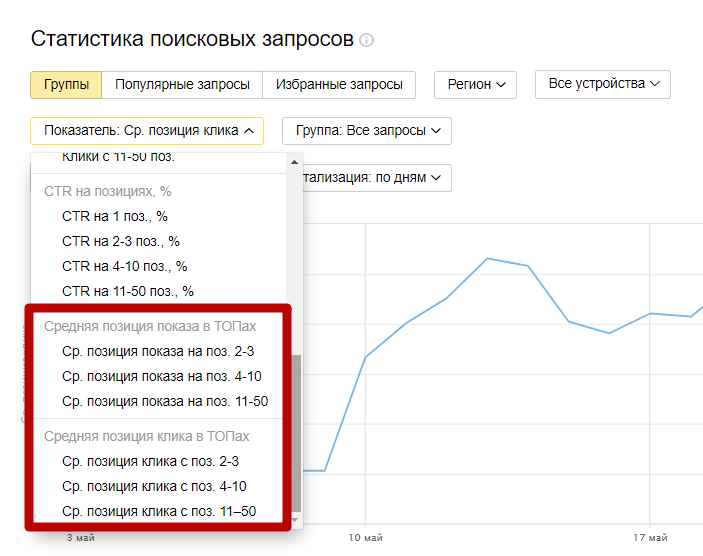

В Яндекс.Вебмастере есть разные показатели средней позиции – позиция показа и позиция клика. Соответственно, на какой позиции сайт чаще выходит в поиске по запросам и на какой на сайт переходят из поиска.

Почему в Яндекс.Вебмастере показаны усредненные значения? Причина – в персонализации поиска по интересам и региону. Из-за этого разные интернет-пользователи могут видеть один сайт на разных позициях в выдаче.

Так как позиция усредненная, в отчете она может быть дробным числом.

К сожалению, в сервисе нельзя посмотреть, какие позиции занимают ваши конкуренты. И в целом данные показываются с запаздыванием в 1-2 дня.

И основное ограничение Яндекс.Вебмастера – с помощью него отслеживать позиции можно только в поиске Яндекса.

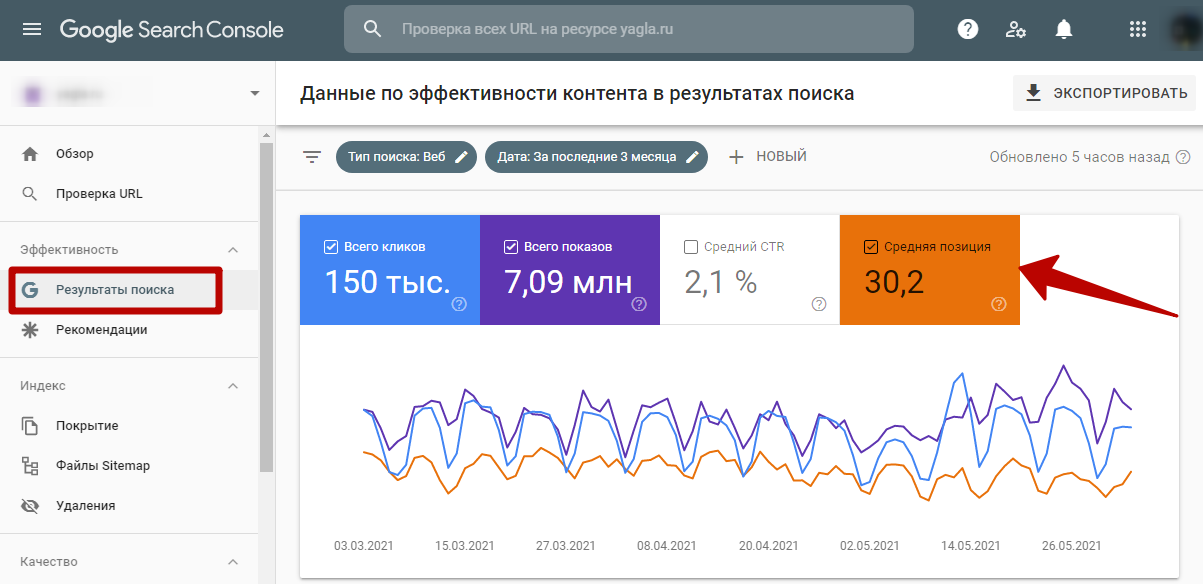

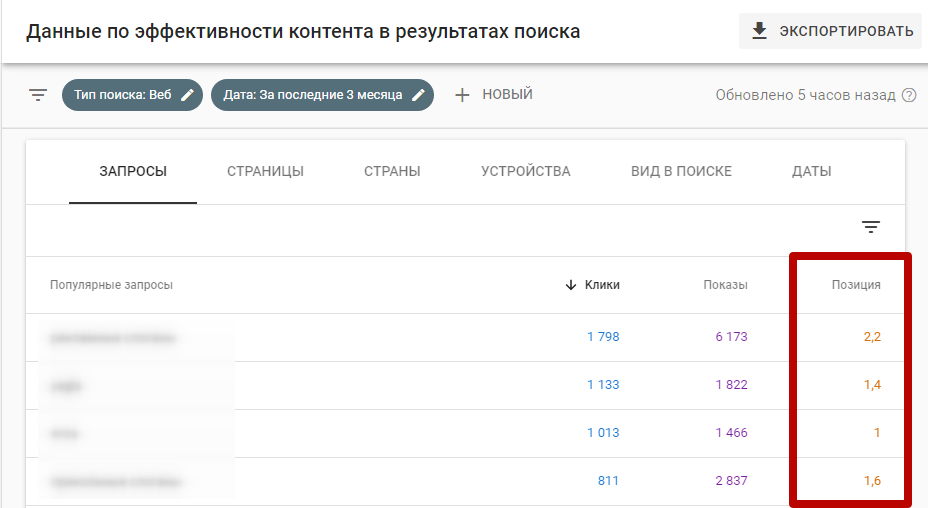

Google Search Console

У Google есть похожий сервис. Он показывает также усредненные позиции сайта по поисковым запросам.

Ищите их в разделе «Эффективность» / «Результаты поиска». Обязательно включите отображение показателя «Средняя позиция», чтобы он появился на графике (оранжевого цвета) и в таблице ниже.

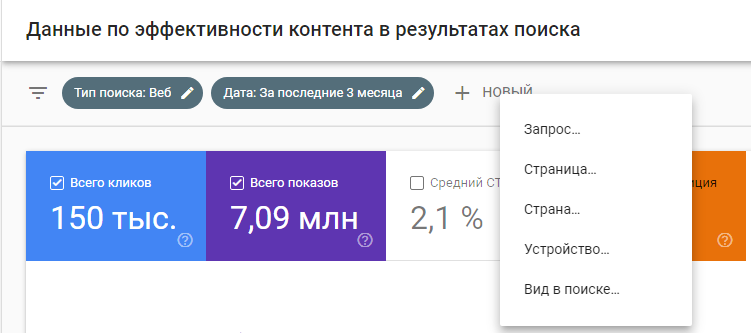

Под графиком – таблица с данными. Вам нужна вкладка «Запросы» и третий столбец. Здесь все запросы, по которым ваш сайт можно найти в Google, и среднее значение позиции по каждому.

При необходимости можно уточнить данные по дате поиска и основным фильтрам в Search Console (+ НОВЫЙ).

Полное руководство по работе с Google Search Console – по ссылке.

Главное преимущество у инструмента то же самое – он бесплатный.

Минусы – те же самые: данные только по одной поисковой системе, они неактуальные (отставание в 1-2 дня) и усредненные. И нет данных по прямым конкурентам.

Если вам нужна статистика по нескольким поисковикам одновременно, варианты с Яндекс.Вебмастер и Search Console не подходят. На этот случай есть специализированные сторонние сервисы – как платные, так и бесплатные.

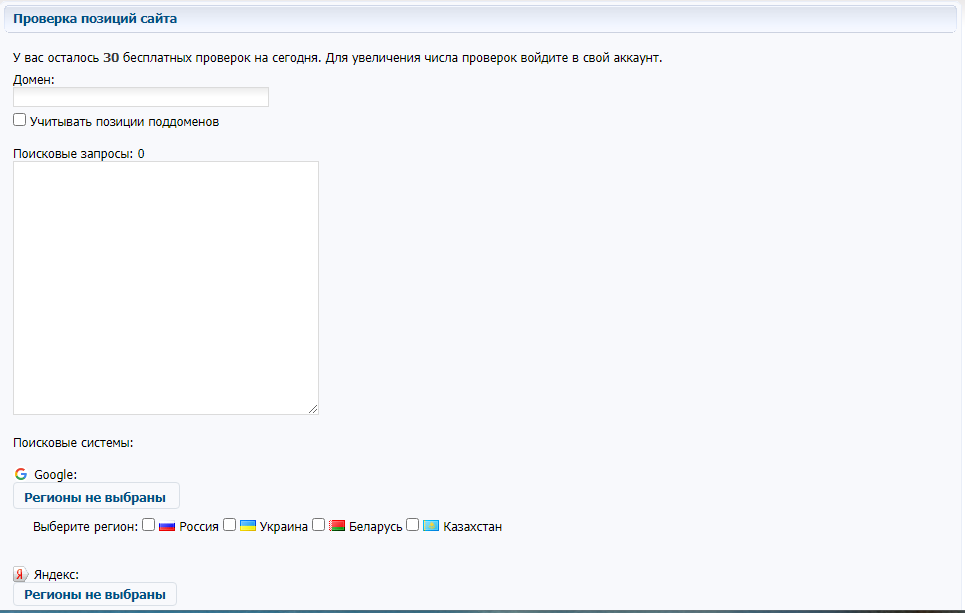

Бесплатные сервисы для проверки позиций

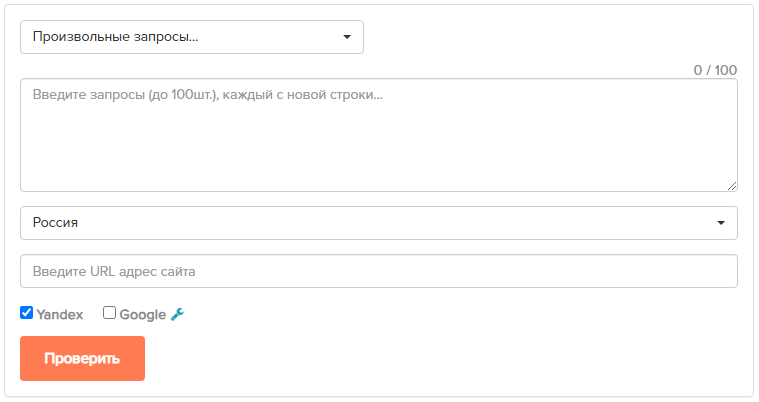

Один из популярных инструментов – CY-PR.com. В нем можно снимать позиции сайта бесплатно без регистрации по 30 поисковым запросам.

Укажите домен, сами запросы и регионы в Google и Яндексе.

Сервис обещает больше доступных проверок после регистрации и авторизации.

Посмотреть бесплатно позиции сайта можно и в чекере позиций от сервиса b1.ru. Здесь уже ограничение на количество запросов – 100 штук. Введите их списком (каждый с новой строки), укажите URL сайта и начните проверку.

Сервис проверяет запросы до 100-й позиции в выдаче.

Особенность: позиции кэшируются на сутки. То есть если вы сегодня делали проверку, до 00:00 сегодняшнего дня результаты не поменяются при попытке повторных проверок.

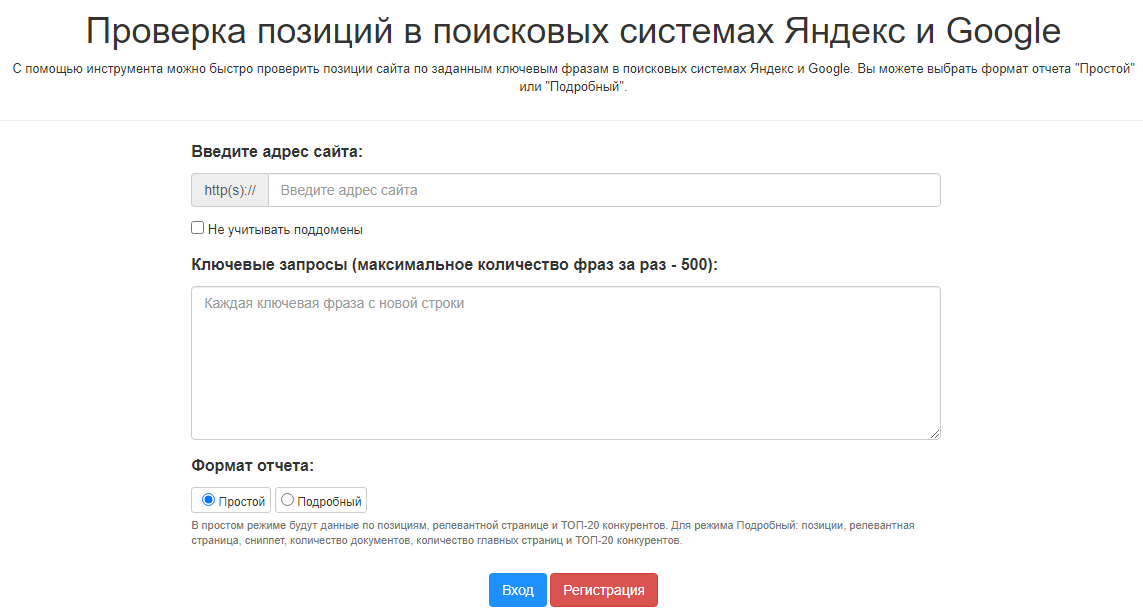

На сайте SEO-специалиста Александра Арсёнкина также есть инструмент для съема позиций. Чтобы им воспользоваться, нужно зарегистрироваться и войти в аккаунт.

Можно проверить максимум 500 поисковых фраз. Результаты проверки выдаются в виде отчета.

Вы выбираете, какой вам нужен – простой (краткий) или подробный. В простом показываются данные по позициям, релевантной странице и ТОП-20 конкурентов. В подробном – позиции, релевантная страница, сниппет, количество документов, количество главных страниц и ТОП-20 конкурентов.

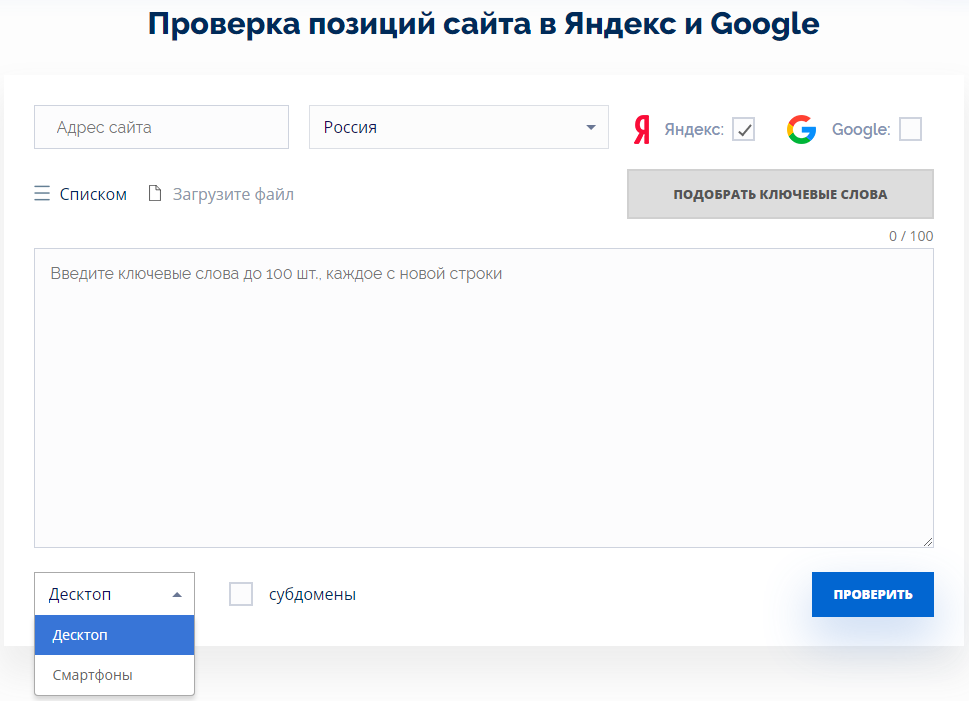

Похожий инструмент предлагает сервис Серпхант: проверка в Яндексе и Гугле, глубина – 100 позиций выдачи.

Алгоритм: вводите адрес сайта, регион для анализа, список запросов (до 100 штук), выбираете поисковые системы. Плюс можно отдельно посмотреть позиции в десктопе и на смартфонах.

На бесплатном тарифном плане можно проверять до 500 позиций в месяц, на платном – от 20 000 и больше.

Результат можно выгружать в файл xlsx или csv + на него будет ссылка, которую можно сохранить для себя.

Важный плюс бесплатных инструментов – в их бесплатности. В ряде из них даже регистрироваться не нужно. Это подойдет для быстрой разовой проверки, когда ключей не так много.

Из-за ограничений по количеству проверяемых запросов они неудобны для постоянного мониторинга позиций. В данном случае на помощь приходят платные сервисы.

Кстати, практически во всех есть бесплатные тарифы с ограничениями. Это значит, можно протестировать их функционал, прежде чем за него платить.

Платные инструменты для проверки позиций

Важное отличие платных сервисов – возможность не только проверки, но и мониторинга позиций на протяжении времени. То есть вы увидите, как меняются позиции сайта – как вашего, так и конкурентов – по определенных поисковым запросам. Можете оценить их динамику и проанализировать, почему она положительная или отрицательная.

Сервисов, предлагающих платную проверку, много. Для примера разберем некоторые из самых популярных.

Топвизор

С помощью этого сервиса вы можете мониторить позиции в таких поисковых системах, как Яндекс, Google, go.Mail.ru, Спутник, Bing, Yahoo, Seznam отдельно:

- По каждому типу устройств

- По регионам

- По доменам конкурентов, которые находятся в Топе выдачи (5 сайтов – бесплатно, до 250 сайтов – платно)

- По конкретным страницам сайта.

Сервис показывает динамику изменения позиций. Вы можете настроить свое расписание для проверок и делать их в режиме реального времени.

Фишки:

1) Для удобства анализа в Топвизоре можно группировать запросы.

2) Помимо страниц сайта Топвизор показывает позиции групп и страниц в ВКонтакте, Twitter, видеороликов и каналов на Youtube, а также приложений в App Store и Google Play.

3) Интеграция с Google Аналитикой и Google Search Console, Яндекс.Метрикой и Яндекс.Вебмастером. Благодаря этому в Топвизоре будет отображаться статистика переходов и другая аналитика.

4) Возможность подбирать слова из прямых источников и добавлять их в список мониторинга позиций.

Бесплатно можно получить 10 тестовых рублей (столько стоят 200 проверок позиций), чтобы протестировать сервис. Их сервис дает каждому новому пользователю после регистрации.

В дальнейшем проверка каждой позиции будет стоить 0,05 рублей. Если вам нужно регулярно мониторить позиции для большого количество поисковых запросов, выгоднее выбрать платный тариф от 999 рублей в месяц. Каждая отдельная проверка выйдет еще дешевле.

Rush Analytics

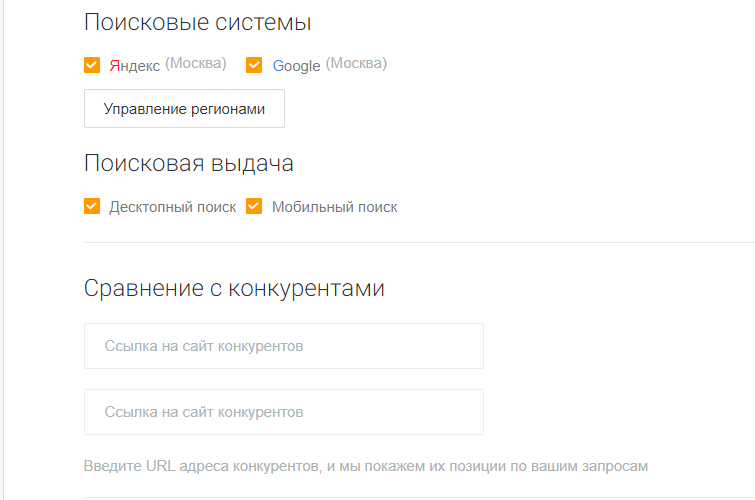

Функционал сервиса похож: также можно снимать позиции в выдаче десктопа и мобайла, смотреть позиции по конкурентам (уже 10 сайтов бесплатно!)

С помощью Rush Analytics можно отслеживать позиции в Google по всему миру, в Яндексе – только в России, Украине, Беларуси и Казахстане.

Визуализация результатов на высшем уровне: вы увидите на графике, как изменялись позиции и другие показатели (посещаемость, видимость сайтов). Вот пример из руководства Rush Analytics.

У сервиса есть 1-недельный тестовый период и 200 лимитов (внутренняя валюта), которые выдаются разово при регистрации.

Стоимость платных тарифов начинается от 500 рублей в месяц.

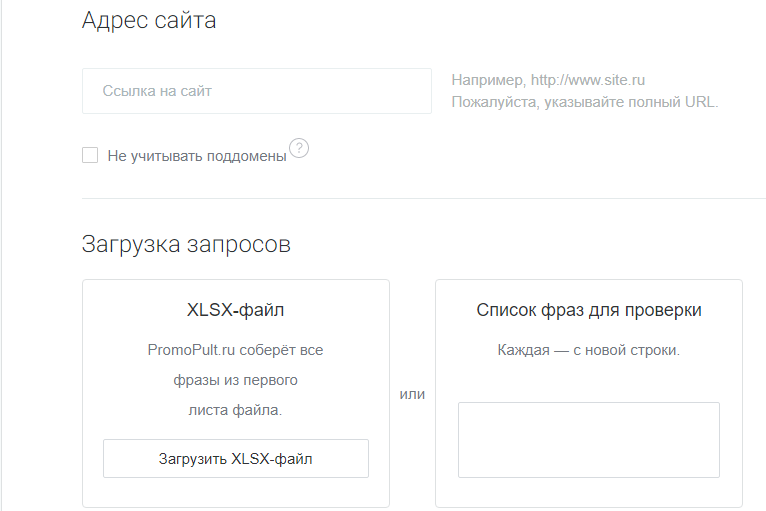

PromoPult

Инструмент от PromoPult парсит данные по позициям с глубиной 50 позиций поисковой выдачи.

Запросы для мониторинга можно загружать в XLSX-файле или копировать списком из текстового документа.

По поисковым системам, регионам и устройствам – аналогично, как и в других рассмотренных инструментах. Также можно мониторить позиции конкурентов – не более 2 сайтов бесплатно.

Помимо этого в инструменте доступны следующие бесплатные функции:

- Анализ сниппетов (заголовка, описания, быстрых ссылок и URL)

- Сбор подсветок и колдунщиков

- Сбор данных о количестве рекламных спецразмещений и гарантированных показов в Яндекс.Директе.

Отчеты выгружаются в XLSX, либо их можно просмотреть в браузере.

Периодичность проверки вы задаете сами (день, неделя, месяц).

При оплате действует условная внутренняя валюта – ТЗ. Это проверка позиции по одному запросу в одном регионе на одном типе устройств. Изначально после регистрации всем доступны 100 ТЗ. Потом 1 ТЗ = 0,05 рублей.

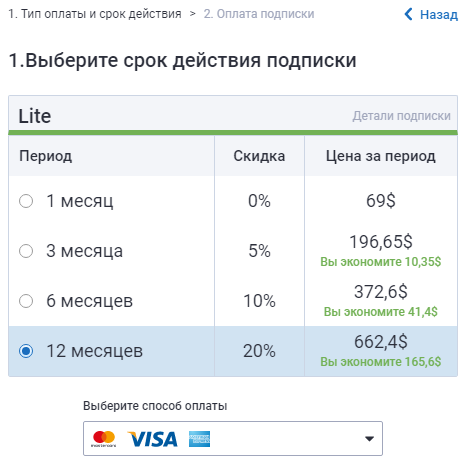

Serpstat

Serpstat собирает данные о позициях в Яндекс & Google для поисковой фразы всех доменов, которые на эти позиции попадают, а не по одному домену.

Вы увидите все 100 сайтов, которые показываются в выдаче по конкретному запросу. В бесплатном тарифе – 15 сайтов. Пример для запроса «Аренда авто»:

Вы получаете: возможность группировать поисковые запросы и смотреть аналитику по сформированным группам, гибкий график проверки, неограниченное количество регионов, автоподбор целевых ключей, возможность совместной работы с проектами.

Serpstat предлагает освоить функционал удобным для вас способом, есть 3 на выбор.

Кроме того, в вашем аккаунте будет храниться вся история по динамике позиций. То есть по каждому ключевому запросу данные по позиции, частотности, изменениях позиции, типам элементов выдачи.

Всё это доступно за 69 долларов в месяц. С увеличением периода тарифа эта сумма уменьшается.

P.S. Все способы – и платные, и бесплатные – довольно просты в освоении. Выбирайте те, которые подходят под ваши задачи и объем семантического ядра.

Хотите тоже написать статью для читателей Yagla? Если вам есть что рассказать про маркетинг, аналитику, бизнес, управление, карьеру для новичков, маркетологов и предпринимателей. Тогда заведите себе блог на Yagla прямо сейчас и пишите статьи. Это бесплатно и просто