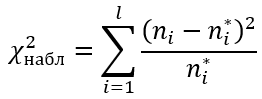

Критерий согласия Пирсона (или хи-квадрат) вычисляется по формуле:

ni – эмпирические частоты;

ni* – теоретические частоты;

l – количество интервалов (вариант)

Объем выборки по критерию Пирсона:

n>30

Теоретические частоты должны быть больше 5.

Распределение Пирсона с k степенями свободы рассчитывается по формуле:

k=l−r−1

r – число параметров предполагаемого распределения

Если предполагаемое распределение имеет нормальный закон распределения, то число степеней свободы оценивают по двум параметрам (математическое ожидание и СКО) и формула имеет вид:

k=l−3

Пример

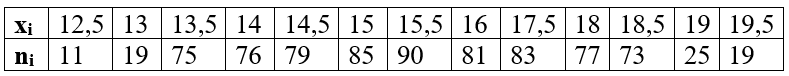

Проверить гипотезу о нормальном распределении по критерию Пирсона при уровне значимости 0,01. Дана выборка данных измерений в виде таблицы

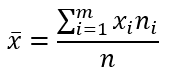

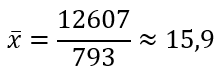

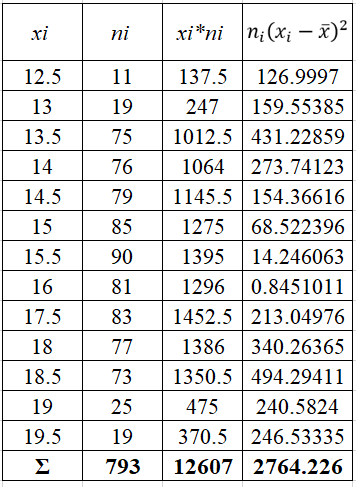

Найдем выборочное среднее по формуле:

Отсюда

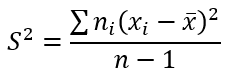

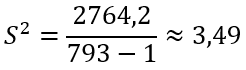

Формула выборочной исправленной дисперсии:

Тогда

Откуда получаем выборочную исправленную СКО:

Получаем параметры нормального распределения mx=15,9, σ=1,87.

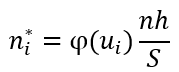

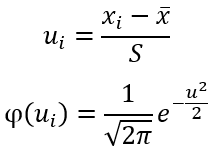

Найдем теоретические частоты по формуле:

h – шаг между вариантами, h=0,5

При уровне значимости α=0,01 и число степеней свободы k=13−3=10 по таблице Пирсона найдем критическое значение:

Наблюдаемое значение критерия равно:

Ввиду того, что

следовательно, нулевую гипотезу о нормальном распределении принимаем.

14704

Критерий Пирсона.

Достоинством

критерия Пирсона является его

универсальность: с его помощью можно

проверять гипотезы о различных законах

распределения.

1.

Проверка гипотезы о нормальном

распределении. Пусть

получена выборка достаточно большого

объема п

с большим количеством различных значений

вариант. Для удобства ее обработки

разделим интервал от наименьшего до

наибольшего из значений вариант на s

равных частей и будем считать, что

значения вариант, попавших в каждый

интервал, приближенно равны числу,

задающему середину интервала. Подсчитав

число вариант, попавших в каждый интервал,

составим так называемую сгруппированную

выборку:

варианты………..х1

х2

… хs

частоты………….п1

п2

… пs

,

где хi

– значения середин интервалов, а пi

– число вариант, попавших в i-й

интервал (эмпирические частоты). По

полученным данным можно вычислить

выборочное среднее

и выборочное среднее квадратическое

отклонение σВ.

Проверим предположение, что генеральная

совокупность распределена по нормальному

закону с параметрами M(X)

=

,

D(X)

=

.

Тогда можно найти количество чисел из

выборки объема п,

которое должно оказаться в каждом

интервале при этом предположении (то

есть теоретические частоты). Для этого

по таблице значений функции Лапласа

найдем вероятность попадания в i-й

интервал:

,

где аi

и bi

— границы

i-го

интервала. Умножив полученные вероятности

на объем выборки п, найдем теоретические

частоты: пi

=n·pi.

Наша цель –

сравнить эмпирические и теоретические

частоты, которые, конечно, отличаются

друг от друга, и выяснить, являются ли

эти различия несущественными, не

опровергающими гипотезу о нормальном

распределении исследуемой случайной

величины, или они настолько велики, что

противоречат этой гипотезе. Для этого

используется критерий в виде случайной

величины

(7)

Смысл ее очевиден:

суммируются части, которые квадраты

отклонений эмпирических частот от

теоретических составляют от соответствующих

теоретических частот. Можно доказать,

что вне зависимости от реального закона

распределения генеральной совокупности

закон распределения случайной величины

(7) при

стремится к закону распределения

с числом степеней свободы k

= s

– 1 – r,

где r

– число

параметров предполагаемого распределения,

оцененных по данным выборки. Нормальное

распределение характеризуется двумя

параметрами, поэтому k

= s

– 3. Для

выбранного критерия строится правосторонняя

критическая область, определяемая

условием

(8)

где α

– уровень значимости. Следовательно,

критическая область задается неравенством

а область принятия гипотезы —

.

Итак, для проверки

нулевой гипотезы Н0:

генеральная совокупность распределена

нормально – нужно вычислить по выборке

наблюдаемое значение критерия:

,

(7`)

а по таблице

критических точек распределения χ2

найти критическую точку

,

используя известные значения α и k

= s

– 3. Если

— нулевую гипотезу принимают, при

ее отвергают.

Пример.

Результаты исследования спроса на товар

представлены в таблице:

|

Стоимость, руб. |

120–160 |

160–180 |

180–200 |

200–220 |

220–280 |

|

Кол-во, шт. |

5 |

10 |

14 |

12 |

9 |

Выдвинуть

гипотезу о виде распределения и проверить

её на уровне значимости =0,01.

I. Выдвижение

гипотезы.

Для указания вида

эмпирического распределения построим

гистограмму

120

160 180 200 220 280

По

виду гистограммы можно сделать

предположение о нормальном законе

распределения изучаемого признака в

генеральной совокупности.

II.

Проверим выдвинутую гипотезу о нормальном

распределении, используя критерий

согласия Пирсона.

1.

Вычисляем

,

В.

В

качестве вариант возьмём среднее

арифметическое концов интервалов:

;

.

2.

Найдём интервалы (Zi;

Zi+1):

;

.

За

левый конец первого интервала примем

(-),

а за правый конец последнего интервала

— (+).

Результаты представлены в табл. 4.

3.

Найдем теоретические вероятности Рi

и теоретические частоты

(см. табл. 4).

Таблица

4

|

i |

Граница |

Ф(Zi) |

Ф(Zi+1) |

Pi= |

|

|||

|

xi |

xi+1 |

Zi |

Zi+1 |

|||||

|

1 |

120 |

160 |

- |

-1,14 |

-0,5 |

-0,3729 |

0,1271 |

6,36 |

|

2 |

160 |

180 |

-1,14 |

-0,52 |

-0,3729 |

-0,1985 |

0,1744 |

8,72 |

|

3 |

180 |

200 |

-0,52 |

0,11 |

-0,1985 |

0,0438 |

0,2423 |

12,12 |

|

4 |

200 |

220 |

0,11 |

0,73 |

0,0438 |

0,2673 |

0,2235 |

11,18 |

|

5 |

220 |

280 |

0,73 |

+ |

0,2673 |

0,5 |

0,2327 |

11,64 |

4.

Сравним эмпирические и теоретические

частоты. Для этого:

а)

вычислим наблюдаемое значение критерия

Пирсона.

Вычисления

представлены в табл.5.

Таблица

5

|

i |

|

|

|

|

|

|

1 |

5 |

6,36 |

-1,36 |

1,8496 |

0,291 |

|

2 |

10 |

8,72 |

1,28 |

1,6384 |

0,188 |

|

3 |

114 |

12,12 |

1,88 |

3,5344 |

0,292 |

|

4 |

12 |

11,18 |

0,82 |

0,6724 |

0,060 |

|

5 |

9 |

11,64 |

-2,64 |

6,9696 |

0,599 |

|

|

50 |

50 |

|

б) по

таблице критических точек распределения

2

при заданном уровне значимости =0,01

и числе степеней свободы k=m–3=5–3=2

находим критическую точку

;

имеем

.

Сравниваем

c

.

.

Следовательно,

нет оснований отвергать гипотезу о

нормальном законе распределения

изучаемого признака генеральной

совокупности. Т.е. расхождение между

эмпирическими и теоретическими частотами

незначимо (случайно). ◄

Замечание.

Интервалы, содержащие малочисленные

эмпирические частоты (ni<5),

следует объединить, а частоты этих

интервалов сложить. Если производилось

объединение интервалов, то при определении

числа степеней свободы по формуле K=m-3

следует в качестве m

принять число оставшихся после объединения

интервалов.

Пример.

По выборке из 24 вариант выдвинута

гипотеза о нормальном распределении

генеральной совокупности. Используя

критерий Пирсона при уровне значимости

среди заданных значений

= {34, 35, 36, 37, 38} указать: а) наибольшее, для

которого нет оснований отвергать

гипотезу; б) наименьшее, начиная с

которого гипотеза должна быть отвергнута.

Найдем число

степеней свободы

с помощью формулы:

,

где

—

число групп выборки (вариант),

— число параметров распределения.

Так как нормальное

распределение имеет 2 параметра (

и

),

получаем

.

По таблице

критических точек распределения

,

по заданному уровню значимости

и числу степеней свободы

определяем критическую точку

.

В случае а) для

значений

,

равных 34 и 35, нет оснований отвергать

гипотезу о нормальном распределении,

так как

.

А наибольшее среди этих значений

.

В случае б) для

значений 36, 37, 38 гипотезу отвергают, так

как

.

Наименьшее среди них

.◄

2.

Проверка гипотезы о равномерном

распределении.

При использовании критерия Пирсона для

проверки гипотезы о равномерном

распределении генеральной совокупности

с предполагаемой плотностью вероятности

необходимо, вычислив

по имеющейся выборке значение

,

оценить параметры а

и b

по формулам:

, (9)

где а*

и b*

— оценки а

и b.

Действительно, для равномерного

распределения М(Х)

=

,

,

откуда можно получить систему для

определения а*

и b*:

решением которой являются выражения

(9).

Затем, предполагая,

что

можно найти теоретические частоты по

формулам

Здесь s

– число интервалов, на которые разбита

выборка.

Наблюдаемое

значение критерия Пирсона вычисляется

по формуле (7`), а критическое – по таблице

с учетом того, что число степеней свободы

k

= s

– 3. После

этого границы критической области

определяются так же, как и для проверки

гипотезы о нормальном распределении.

3.

Проверка гипотезы о показательном

распределении. В

этом случае, разбив имеющуюся выборку

на равные по длине интервалы, рассмотрим

последовательность вариант

,

равноотстоящих друг от друга (считаем,

что все варианты, попавшие в i

– й интервал, принимают значение,

совпадающее с его серединой), и

соответствующих им частот ni

(число вариант

выборки, попавших в i

– й интервал). Вычислим по этим данным

и примем в качестве оценки параметра λ

величину

.

Тогда теоретические частоты вычисляются

по формуле

Затем сравниваются

наблюдаемое и критическое значение

критерия Пирсона с учетом того, что

число степеней свободы k

= s

– 2.

Пример.

Для выборки, интервальный статистический

ряд которой имеет вид

|

Номер |

Границы |

Эмпирические |

|

1 |

2 |

6 |

|

2 |

5 |

8 |

|

3 |

8 |

15 |

|

4 |

11 |

22 |

|

5 |

14 |

14 |

|

6 |

17 |

5 |

проверить при

уровне значимости α

= 0,05 гипотезу о:

а) показательном;

б) равномерном; в) нормальном законе

распределения генеральной совокупности

с помощью критерия Пирсона.

Объем выборки п

= 70. Будем считать вариантами середины

частичных интервалов: х1

= 3,5, х2

= 6,5,…, х6

= 18,5.

Найдем

= 11,43; σВ

= 4,03; s

= 4,05.

а) Вычислим

теоретические частоты в предположении

о показательном распределении генеральной

совокупности при

аналогично

Наблюдаемое значение критерия

Критическая точка χ2(0,05;4)=9,5;

и гипотеза о показательном распределении

отклоняется.

б) Для равномерного

распределения

теоретические

частоты:

Наблюдаемое значение критерия

Критическая

точка

и гипотеза о равномерном распределении

отклоняется.

в) Теоретические

частоты для нормального распределения:

Так же вычисляются

Наблюдаемое значение критерия

Критическая точка

Поскольку

гипотеза о нормальном распределении

генеральной совокупности принимается.

◄

Критерий

Колмогорова.

Этот критерий

применяется для проверки простой

гипотезы Н0

о том, что независимые одинаково

распределенные случайные величины Х1,

Х2,

…, Хп

имеют заданную непрерывную функцию

распределения F(x).

Найдем функцию

эмпирического распределения Fn(x)

и будем искать границы двусторонней

критической области, определяемой

условием

.

(10)

А.Н.Колмогоров

доказал, что в случае справедливости

гипотезы Н0

распределение статистики Dn

не зависит от функции F(x),

и при

где

—

(11)

— критерий

Колмогорова, значения которого можно

найти в соответствующих таблицах.

Критическое значение критерия λп(α)

вычисляется по заданному уровню

значимости α

как корень уравнения

.

Можно показать,

что приближенное значение вычисляется

по формуле

,

где z

– корень уравнения

На практике для

вычисления значения статистики Dn

используется то, что

,

где

а

— вариационный ряд, построенный по

выборке Х1,

Х2,

…, Хп.

Можно дать следующее геометрическое

истолкование критерия Колмогорова:

если изобразить на плоскости Оху

графики функций Fn(x),

Fn(x)

±λn(α)

(рис. 1), то гипотеза Н0

верна, если график функции F(x)

не выходит за пределы области, лежащей

между графиками функций Fn(x)

-λn(α)

и Fn(x)

+λn(α).

До конца XIX века нормальное распределение считалась всеобщим законом вариации данных. Однако К. Пирсон заметил, что эмпирические частоты могут сильно отличаться от нормального распределения. Встал вопрос, как это доказать. Требовалось не только графическое сопоставление, которое имеет субъективный характер, но и строгое количественное обоснование.

Так был изобретен критерий χ2 (хи квадрат), который проверяет значимость расхождения эмпирических (наблюдаемых) и теоретических (ожидаемых) частот. Это произошло в далеком 1900 году, однако критерий и сегодня на ходу. Более того, его приспособили для решения широкого круга задач. Прежде всего, это анализ категориальных данных, т.е. таких, которые выражаются не количеством, а принадлежностью к какой-то категории. Например, класс автомобиля, пол участника эксперимента, вид растения и т.д. К таким данным нельзя применять математические операции вроде сложения и умножения, для них можно только подсчитать частоты.

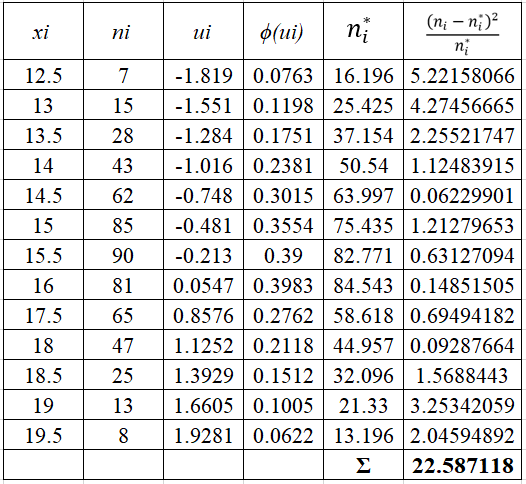

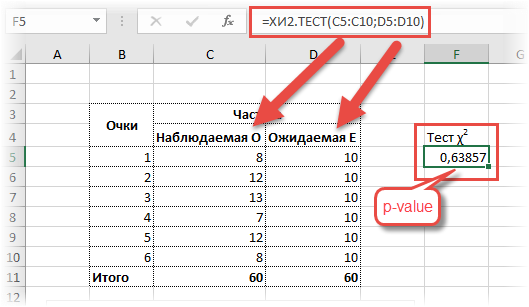

Наблюдаемые частоты обозначим О (Observed), ожидаемые – E (Expected). В качестве примера возьмем результат 60-кратного бросания игральной кости. Если она симметрична и однородна, вероятность выпадения любой стороны равна 1/6 и, следовательно, ожидаемое количество выпадения каждой из сторон равна 10 (1/6∙60). Наблюдаемые и ожидаемые частоты запишем в таблицу и нарисуем гистограмму.

Нулевая гипотеза заключается в том, что частоты согласованы, то есть фактические данные не противоречат ожидаемым. Альтернативная гипотеза – отклонения в частотах выходят за рамки случайных колебаний, расхождения статистически значимы. Чтобы сделать строгий вывод, нам потребуется.

- Обобщающая мера расхождения между наблюдаемыми и ожидаемыми частотами.

- Распределение этой меры при справедливости гипотезы о том, что различий нет.

Начнем с расстояния между частотами. Если взять просто разницу О — E, то такая мера будет зависеть от масштаба данных (частот). Например, 20 — 5 =15 и 1020 – 1005 = 15. В обоих случаях разница составляет 15. Но в первом случае ожидаемые частоты в 3 раза меньше наблюдаемых, а во втором случае – лишь на 1,5%. Нужна относительная мера, не зависящая от масштаба.

Обратим внимание на следующие факты. В общем случае количество категорий, по которым измеряются частоты, может быть гораздо больше, поэтому вероятность того, что отдельно взятое наблюдение попадет в ту или иную категорию, довольно мала. Раз так, то, распределение такой случайной величины будет подчинятся закону редких событий, известному под названием закон Пуассона. В законе Пуассона, как известно, значение математического ожидания и дисперсии совпадают (параметр λ). Значит, ожидаемая частота для некоторой категории номинальной переменной Ei будет являться одновременное и ее дисперсией. Далее, закон Пуассона при большом количестве наблюдений стремится к нормальному. Соединяя эти два факта, получаем, что, если гипотеза о согласии наблюдаемых и ожидаемых частот верна, то, при большом количестве наблюдений, выражение

имеет стандартное нормальное распределение.

Важно помнить, что нормальность будет проявляться только при достаточно больших частотах. В статистике принято считать, что общее количество наблюдений (сумма частот) должна быть не менее 50 и ожидаемая частота в каждой группе должна быть не менее 5. Только в этом случае величина, показанная выше, имеет стандартное нормальное распределение. Предположим, что это условие выполнено.

У стандартного нормального распределения почти все значение находятся в пределах ±3 (правило трех сигм). Таким образом, мы получили относительную разность в частотах для одной группы. Нам нужна обобщающая мера. Просто сложить все отклонения нельзя – получим 0 (догадайтесь почему). Пирсон предложил сложить квадраты этих отклонений.

Это и есть статистика для критерия Хи-квадрат Пирсона. Если частоты действительно соответствуют ожидаемым, то значение статистики Хи-квадрат будет относительно не большим (отклонения находятся близко к нулю). Большое значение статистики свидетельствует в пользу существенных различий между частотами.

«Большой» статистика Хи-квадрат становится тогда, когда появление наблюдаемого или еще большего значения становится маловероятным. И чтобы рассчитать такую вероятность, необходимо знать распределение статистики Хи-квадрат при многократном повторении эксперимента, когда гипотеза о согласии частот верна.

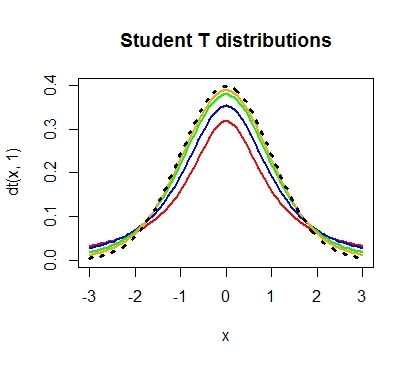

Как нетрудно заметить, величина хи-квадрат также зависит от количества слагаемых. Чем больше слагаемых, тем больше ожидается значение статистики, ведь каждое слагаемое вносит свой вклад в общую сумму. Следовательно, для каждого количества независимых слагаемых, будет собственное распределение. Получается, что χ2 – это целое семейство распределений.

И здесь мы подошли к одному щекотливому моменту. Что такое число независимых слагаемых? Вроде как любое слагаемое (т.е. отклонение) независимо. К. Пирсон тоже так думал, но оказался неправ. На самом деле число независимых слагаемых будет на один меньше, чем количество групп номинальной переменной n. Почему? Потому что, если мы имеем выборку, по которой уже посчитана сумма частот, то одну из частот всегда можно определить, как разность общего количества и суммой всех остальных. Отсюда и вариация будет несколько меньше. Данный факт Рональд Фишер заметил лет через 20 после разработки Пирсоном своего критерия. Даже таблицы пришлось переделывать.

По этому поводу Фишер ввел в статистику новое понятие – степень свободы (degrees of freedom), которое и представляет собой количество независимых слагаемых в сумме. Понятие степеней свободы имеет математическое объяснение и проявляется только в распределениях, связанных с нормальным (Стьюдента, Фишера-Снедекора и сам Хи-квадрат).

Чтобы лучше уловить смысл степеней свободы, обратимся к физическому аналогу. Представим точку, свободно движущуюся в пространстве. Она имеет 3 степени свободы, т.к. может перемещаться в любом направлении трехмерного пространства. Если точка движется по какой-либо поверхности, то у нее уже две степени свободы (вперед-назад, вправо-влево), хотя и продолжает находиться в трехмерном пространстве. Точка, перемещающаяся по пружине, снова находится в трехмерном пространстве, но имеет лишь одну степень свободы, т.к. может двигаться либо вперед, либо назад. Как видно, пространство, где находится объект, не всегда соответствует реальной свободе перемещения.

Примерно также распределение статистики может зависеть от меньшего количества элементов, чем нужно слагаемых для его расчета. В общем случае количество степеней свободы меньше наблюдений на число имеющихся зависимостей.

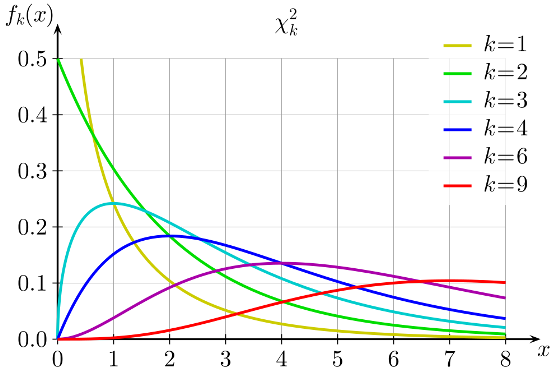

Таким образом, распределение хи квадрат (χ2) – это семейство распределений, каждое из которых зависит от параметра степеней свободы. Формальное определение следующее. Распределение χ2 (хи-квадрат) с k степенями свободы — это распределение суммы квадратов k независимых стандартных нормальных случайных величин.

Далее можно было бы перейти к самой формуле, по которой вычисляется функция распределения хи-квадрат, но, к счастью, все давно подсчитано за нас. Чтобы получить интересующую вероятность, можно воспользоваться либо соответствующей статистической таблицей, либо готовой функцией в Excel.

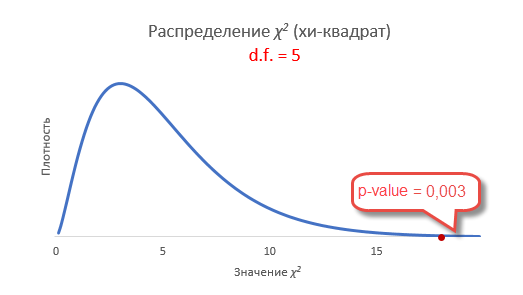

Интересно посмотреть, как меняется форма распределения хи-квадрат в зависимости от количества степеней свободы.

С увеличением степеней свободы распределение хи-квадрат стремится к нормальному. Это объясняется действием центральной предельной теоремы, согласно которой сумма большого количества независимых случайных величин имеет нормальное распределение. Про квадраты там ничего не сказано )).

Проверка гипотезы по критерию Хи квадрат Пирсона

Вот мы и подошли к проверке гипотез по методу хи-квадрат. В целом техника остается прежней. Выдвигается нулевая гипотеза о том, что наблюдаемые частоты соответствуют ожидаемым (т.е. между ними нет разницы, т.к. они взяты из той же генеральной совокупности). Если этот так, то разброс будет относительно небольшим, в пределах случайных колебаний. Меру разброса определяют по статистике Хи-квадрат. Далее либо полученную статистику сравнивают с критическим значением (для соответствующего уровня значимости и степеней свободы), либо, что более правильно, рассчитывают наблюдаемый p-value, т.е. вероятность получить такое или еще больше значение статистики при справедливости нулевой гипотезы.

Т.к. нас интересует согласие частот, то отклонение гипотезы произойдет, когда статистика окажется больше критического уровня. Т.е. критерий является односторонним. Однако иногда (иногда) требуется проверить левостороннюю гипотезу. Например, когда эмпирические данные уж оооочень сильно похожи на теоретические. Тогда критерий может попасть в маловероятную область, но уже слева. Дело в том, что в естественных условиях, маловероятно получить частоты, практически совпадающие с теоретическими. Всегда есть некоторая случайность, которая дает погрешность. А вот если такой погрешности нет, то, возможно, данные были сфальсифицированы. Но все же обычно проверяют правостороннюю гипотезу.

Вернемся к задаче с игральной костью. Рассчитаем по имеющимся данным значение статистики критерия хи-квадрат.

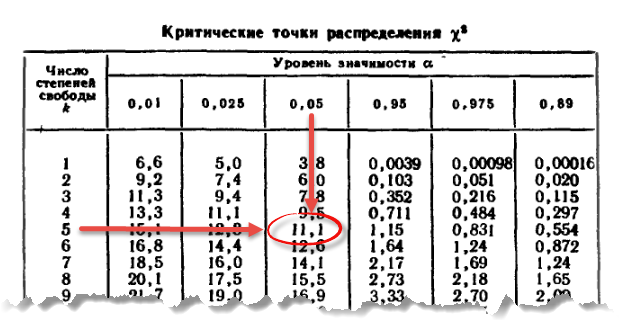

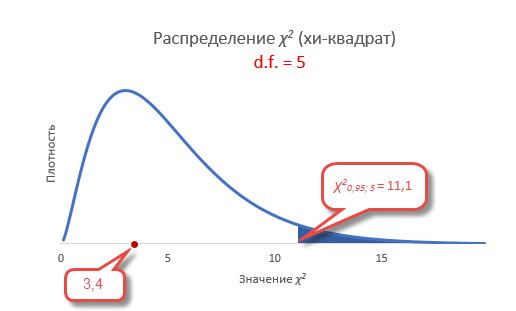

Теперь найдем критическое значение при 5-ти степенях свободы (k) и уровне значимости 0,05 (α) по таблице критических значений распределения хи квадрат.

То есть квантиль 0,05 хи квадрат распределения (правый хвост) с 5-ю степенями свободы χ20,05; 5 = 11,1.

Сравним фактическое и табличное значение. 3,4 (χ2) < 11,1 (χ20,05; 5). Расчетный значение оказалось меньшим, значит гипотеза о равенстве (согласии) частот не отклоняется. На рисунке ситуация выглядит вот так.

Если бы расчетное значение попало в критическую область, то нулевая гипотеза была бы отклонена.

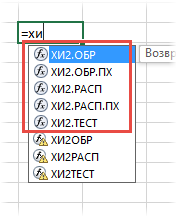

Более правильным будет рассчитать еще и p-value. Для этого нужно в таблице найти ближайшее значение для заданного количества степеней свободы и посмотреть соответствующий ему уровень значимости. Но это прошлый век. Воспользуемся ЭВМ, в частности MS Excel. В эксель есть несколько функций, связанных с хи-квадрат.

Ниже их краткое описание.

ХИ2.ОБР – критическое значение Хи-квадрат при заданной вероятности слева (как в статистических таблицах)

ХИ2.ОБР.ПХ – критическое значение при заданной вероятности справа. Функция по сути дублирует предыдущую. Но здесь можно сразу указывать уровень α, а не вычитать его из 1. Это более удобно, т.к. в большинстве случаев нужен именно правый хвост распределения.

ХИ2.РАСП – p-value слева (можно рассчитать плотность).

ХИ2.РАСП.ПХ – p-value справа.

ХИ2.ТЕСТ – по двум диапазонам частот сразу проводит тест хи-квадрат. Количество степеней свободы берется на одну меньше, чем количество частот в столбце (так и должно быть), возвращая значение p-value.

Давайте пока рассчитаем для нашего эксперимента критическое (табличное) значение для 5-ти степеней свободы и альфа 0,05. Формула Excel будет выглядеть так:

=ХИ2.ОБР(0,95;5)

Или так

=ХИ2.ОБР.ПХ(0,05;5)

Результат будет одинаковым – 11,0705. Именно это значение мы видим в таблице (округленное до 1 знака после запятой).

Рассчитаем, наконец, p-value для 5-ти степеней свободы критерия χ2 = 3,4. Нужна вероятность справа, поэтому берем функцию с добавкой ПХ (правый хвост)

=ХИ2.РАСП.ПХ(3,4;5) = 0,63857

Значит, при 5-ти степенях свободы вероятность получить значение критерия χ2 = 3,4 и больше равна почти 64%. Естественно, гипотеза не отклоняется (p-value больше 5%), частоты очень хорошо согласуются.

А теперь проверим гипотезу о согласии частот с помощью теста хи квадрат и функции Excel ХИ2.ТЕСТ.

Никаких таблиц, никаких громоздких расчетов. Указав в качестве аргументов функции столбцы с наблюдаемыми и ожидаемыми частотами, сразу получаем p-value. Красота.

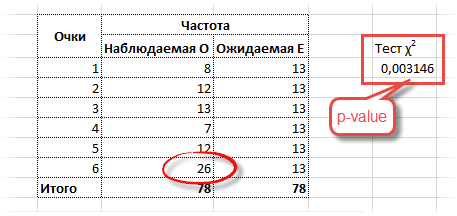

Представим теперь, что вы играете в кости с подозрительным типом. Распределение очков от 1 до 5 остается прежним, но он выкидывает 26 шестерок (количество всех бросков становится 78).

p-value в этом случае оказывается 0,003, что гораздо меньше чем, 0,05. Есть серьезные основания сомневаться в правильности игральной кости. Вот, как выглядит эта вероятность на диаграмме распределения хи-квадрат.

Статистика критерия хи-квадрат здесь получается 17,8, что, естественно, больше табличного (11,1).

Надеюсь, мне удалось объяснить, что такое критерий согласия χ2 (хи-квадрат) Пирсона и как с его помощью проверяются статистические гипотезы.

Напоследок еще раз о важном условии! Критерий хи-квадрат исправно работает только в случае, когда количество всех частот превышает 50, а минимальное ожидаемое значение для каждой группы не меньше 5. Если в какой-либо категории ожидаемая частота менее 5, но при этом сумма всех частот превышает 50, то такую категорию объединяют с ближайшей, чтобы их общая частота превысила 5. Если это сделать невозможно, или сумма частот меньше 50, то следует использовать более точные методы проверки гипотез. О них поговорим в другой раз.

Ниже находится видео ролик о том, как в Excel проверить гипотезу с помощью критерия хи-квадрат.

Скачать файл с примером.

Поделиться в социальных сетях:

О степенях свободы в статистике

Время на прочтение

8 мин

Количество просмотров 196K

В одном из предыдущих постов мы обсудили, пожалуй, центральное понятие в анализе данных и проверке гипотез — p-уровень значимости. Если мы не применяем байесовский подход, то именно значение p-value мы используем для принятия решения о том, достаточно ли у нас оснований отклонить нулевую гипотезу нашего исследования, т.е. гордо заявить миру, что у нас были получены статистически значимые различия.

Однако в большинстве статистических тестов, используемых для проверки гипотез, (например, t-тест, регрессионный анализ, дисперсионный анализ) рядом с p-value всегда соседствует такой показатель как число степеней свободы, он же degrees of freedom или просто сокращенно df, о нем мы сегодня и поговорим.

Степени свободы, о чем речь?

По моему мнению, понятие степеней свободы в статистике примечательно тем, что оно одновременно является и одним из самым важных в прикладной статистике (нам необходимо знать df для расчета p-value в озвученных тестах), но вместе с тем и одним из самых сложных для понимания определений для студентов-нематематиков, изучающих статистику.

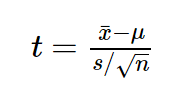

Давайте рассмотрим пример небольшого статистического исследования, чтобы понять, зачем нам нужен показатель df, и в чем же с ним такая проблема. Допустим, мы решили проверить гипотезу о том, что средний рост жителей Санкт-Петербурга равняется 170 сантиметрам. Для этих целей мы набрали выборку из 16 человек и получили следующие результаты: средний рост по выборке оказался равен 173 при стандартном отклонении равном 4. Для проверки нашей гипотезы можно использовать одновыборочный t-критерий Стьюдента, позволяющий оценить, как сильно выборочное среднее отклонилось от предполагаемого среднего в генеральной совокупности в единицах стандартной ошибки:

Проведем необходимые расчеты и получим, что значение t-критерия равняется 3, отлично, осталось рассчитать p-value и задача решена. Однако, ознакомившись с особенностями t-распределения мы выясним, что его форма различается в зависимости от числа степеней свобод, рассчитываемых по формуле n-1, где n — это число наблюдений в выборке:

Сама по себе формула для расчета df выглядит весьма дружелюбной, подставили число наблюдений, вычли единичку и ответ готов: осталось рассчитать значение p-value, которое в нашем случае равняется 0.004.

Но почему n минус один?

Когда я впервые в жизни на лекции по статистике столкнулся с этой процедурой, у меня как и у многих студентов возник законный вопрос: а почему мы вычитаем единицу? Почему мы не вычитаем двойку, например? И почему мы вообще должны что-то вычитать из числа наблюдений в нашей выборке?

В учебнике я прочитал следующее объяснение, которое еще не раз в дальнейшем встречал в качестве ответа на данный вопрос:

“Допустим мы знаем, чему равняется выборочное среднее, тогда нам необходимо знать только n-1 элементов выборки, чтобы безошибочно определить чему равняется оставшейся n элемент”. Звучит разумно, однако такое объяснение скорее описывает некоторый математический прием, чем объясняет зачем нам понадобилось его применять при расчете t-критерия. Следующее распространенное объяснение звучит следующим образом: число степеней свободы — это разность числа наблюдений и числа оцененных параметров. При использовании одновыборочного t-критерия мы оценили один параметр — среднее значение в генеральной совокупности, используя n элементов выборки, значит df = n-1.

Однако ни первое, ни второе объяснение так и не помогает понять, зачем же именно нам потребовалось вычитать число оцененных параметров из числа наблюдений?

Причем тут распределение Хи-квадрат Пирсона?

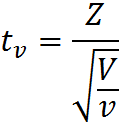

Давайте двинемся чуть дальше в поисках ответа. Сначала обратимся к определению t-распределения, очевидно, что все ответы скрыты именно в нем. Итак случайная величина:

имеет t-распределение с df = ν, при условии, что Z – случайная величина со стандартным нормальным распределением N(0; 1), V – случайная величина с распределением Хи-квадрат, с ν числом степеней свобод, случайные величины Z и V независимы. Это уже серьезный шаг вперед, оказывается, за число степеней свободы ответственна случайная величина с распределением Хи-квадрат в знаменателе нашей формулы.

Давайте тогда изучим определение распределения Хи-квадрат. Распределение Хи-квадрат с k степенями свободы — это распределение суммы квадратов k независимых стандартных нормальных случайных величин.

Кажется, мы уже совсем у цели, по крайней мере, теперь мы точно знаем, что такое число степеней свободы у распределения Хи-квадрат — это просто число независимых случайных величин с нормальным стандартным распределением, которые мы суммируем. Но все еще остается неясным, на каком этапе и зачем нам потребовалось вычитать единицу из этого значения?

Давайте рассмотрим небольшой пример, который наглядно иллюстрирует данную необходимость. Допустим, мы очень любим принимать важные жизненные решения, основываясь на результате подбрасывания монетки. Однако, последнее время, мы заподозрили нашу монетку в том, что у нее слишком часто выпадает орел. Чтобы попытаться отклонить гипотезу о том, что наша монетка на самом деле является честной, мы зафиксировали результаты 100 бросков и получили следующий результат: 60 раз выпал орел и только 40 раз выпала решка. Достаточно ли у нас оснований отклонить гипотезу о том, что монетка честная? В этом нам и поможет распределение Хи-квадрат Пирсона. Ведь если бы монетка была по настоящему честной, то ожидаемые, теоретические частоты выпадания орла и решки были бы одинаковыми, то есть 50 и 50. Легко рассчитать насколько сильно наблюдаемые частоты отклоняются от ожидаемых. Для этого рассчитаем расстояние Хи-квадрат Пирсона по, я думаю, знакомой большинству читателей формуле:

Где O — наблюдаемые, E — ожидаемые частоты.

Дело в том, что если верна нулевая гипотеза, то при многократном повторении нашего эксперимента распределение разности наблюдаемых и ожидаемых частот, деленная на корень из наблюдаемой частоты, может быть описано при помощи нормального стандартного распределения, а сумма квадратов k таких случайных нормальных величин это и будет по определению случайная величина, имеющая распределение Хи-квадрат.

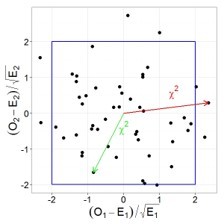

Давайте проиллюстрируем этот тезис графически, допустим у нас есть две случайные, независимые величины, имеющих стандартное нормальное распределение. Тогда их совместное распределение будет выглядеть следующим образом:

При этом квадрат расстояния от нуля до каждой точки это и будет случайная величина, имеющая распределение Хи-квадрат с двумя степенями свободы. Вспомнив теорему Пифагора, легко убедиться, что данное расстояние и есть сумма квадратов значений обеих величин.

Пришло время вычесть единичку!

Ну а теперь кульминация нашего повествования. Возвращаемся к нашей формуле расчета расстояния Хи-квадрат для проверки честности монетки, подставим имеющиеся данные в формулу и получим, что расстояние Хи-квадрат Пирсона равняется 4. Однако для определения p-value нам необходимо знать число степеней свободы, ведь форма распределения Хи-квадрат зависит от этого параметра, соответственно и критическое значение также будет различаться в зависимости от этого параметра.

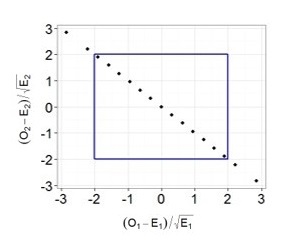

Теперь самое интересное. Предположим, что мы решили многократно повторять 100 бросков, и каждый раз мы записывали наблюдаемые частоты орлов и решек, рассчитывали требуемые показатели (разность наблюдаемых и ожидаемых частот, деленная на корень из ожидаемой частоты) и как и в предыдущем примере наносили их на график.

Легко заметить, что теперь все точки выстраиваются в одну линию. Все дело в том, что в случае с монеткой наши слагаемые не являются независимыми, зная общее число бросков и число решек, мы всегда можем точно определить выпавшее число орлов и наоборот, поэтому мы не можем сказать, что два наших слагаемых — это две независимые случайные величины. Также вы можете убедиться, что все точки действительно всегда будут лежать на одной прямой: если у нас выпало 30 орлов, значит решек было 70, если орлов 70, то решек 30 и т.д. Таким образом, несмотря на то, что в нашей формуле было два слагаемых, для расчета p-value мы будем использовать распределение Хи-квадрат с одной степенью свободы! Вот мы наконец-то добрались до момента, когда нам потребовалось вычесть единицу. Если бы мы проверяли гипотезу о том, что наша игральная кость с шестью гранями является честной, то мы бы использовали распределение Хи-квадрат с 5 степенями свободы. Ведь зная общее число бросков и наблюдаемые частоты выпадения любых пяти граней, мы всегда можем точно определить, чему равняется число выпадений шестой грани.

Все становится на свои места

Теперь, вооружившись этими знаниями, вернемся к t-тесту:

в знаменателе у нас находится стандартная ошибка, которая представляет собой выборочное стандартное отклонение, делённое на корень из объёма выборки. В расчет стандартного отклонения входит сумма квадратов отклонений наблюдаемых значений от их среднего значения — то есть сумма нескольких случайных положительных величин. А мы уже знаем, что сумма квадратов n случайных величин может быть описана при помощи распределения хи-квадрат. Однако, несмотря на то, что у нас n слагаемых, у данного распределения будет n-1 степень свободы, так как зная выборочное среднее и n-1 элементов выборки, мы всегда можем точно задать последний элемент (отсюда и берется это объяснение про среднее и n-1 элементов необходимых для однозначного определения n элемента)! Получается, в знаменателе t-статистики у нас спрятано распределение хи-квадрат c n-1 степенями свободы, которое используется для описания распределения выборочного стандартного отклонения! Таким образом, степени свободы в t-распределении на самом деле берутся из распределения хи-квадрат, которое спрятано в формуле t-статистики. Кстати, важно отметить, что все приведенные выше рассуждения справедливы, если исследуемый признак имеет нормальное распределение в генеральной совокупности (или размер выборки достаточно велик), и если бы у нас действительно стояла цель проверить гипотезу о среднем значении роста в популяции, возможно, было бы разумнее использовать непараметрический критерий.

Схожая логика расчета числа степеней свободы сохраняется и при работе с другими тестами, например, в регрессионном или дисперсионном анализе, все дело в случайных величинах с распределением Хи-квадрат, которые присутствуют в формулах для расчета соответствующих критериев.

Таким образом, чтобы правильно интерпретировать результаты статистических исследований и разбираться, откуда возникают все показатели, которые мы получаем при использовании даже такого простого критерия как одновыборочный t-тест, любому исследователю необходимо хорошо понимать, какие математические идеи лежат в основании статистических методов.

Онлайн курсы по статистике: объясняем сложные темы простым языком

Основываясь на опыте преподавания статистики в Институте биоинформатики , у нас возникла идея создать серию онлайн курсов, посвященных анализу данных, в которых в доступной для каждого форме будут объясняться наиболее важные темы, понимание которых необходимо для уверенного использования методов статистики при решении различного рода задача. В 2015 году мы запустили курс Основы статистики, на который к сегодняшнему дню записалось около 17 тысяч человек, три тысячи слушателей уже получили сертификат о его успешном завершении, а сам курс был награждён премией EdCrunch Awards и признан лучшим техническим курсом. В этом году на платформе stepik.org стартовало продолжение курса Основы статистики. Часть два, в котором мы продолжаем знакомство с основными методами статистики и разбираем наиболее сложные теоретические вопросы. Кстати, одной из главных тем курса является роль распределения Хи-квадрат Пирсона при проверке статистических гипотез. Так что если у вас все еще остались вопросы о том, зачем мы вычитаем единицу из общего числа наблюдений, ждем вас на курсе!

Стоит также отметить, что теоретические знания в области статистики будут определенно полезны не только тем, кто применяет статистику в академических целях, но и для тех, кто использует анализ данных в прикладных областях. Базовые знания в области статистики просто необходимы для освоения более сложных методов и подходов, которые используются в области машинного обучения и Data Mining. Таким образом, успешное прохождение наших курсов по введению в статистику — хороший старт в области анализа данных. Ну а если вы всерьез задумались о приобретении навыков работы с данными, думаем, вас может заинтересовать наша онлайн — программа по анализу данных, о которой мы подробнее писали здесь. Упомянутые курсы по статистике являются частью этой программы и позволят вам плавно погрузиться в мир статистики и машинного обучения. Однако пройти эти курсы без дедлайнов могут все желающие и вне контекста программы по анализу данных.

Критерий согласия Пирсона

Опр Критерий проверки гипотезы о предполагаемом законе неизвестного распределения называется критерием согласия.

Имеется несколько критериев согласия: $chi ^2$ { хи-квадрат } К. Пирсона, Колмогорова, Смирнова и др.

Обычно теоретические и эмпирические частоты различаются. Случай расхождения может быть не случайным, значит и объясняется тем, что не верно выбрана гипотеза. Критерий Пирсона отвечает на поставленный вопрос, но как любой критерий он ничего не доказывает, а лишь устанавливает на принятом уровне значимости её согласие или несогласие с данными наблюдений.

Опр Достаточно малую вероятность, при которой событие можно считать практически невозможным называют уровнем значимости.

На практике обычно принимают уровни значимости, заключённые между 0,01 и 0,05, $alpha =0,05$ — это $5 { % } $ уровень значимости.

В качестве критерия проверки гипотезы примем величину begin{equation} label { eq1 } chi ^2=sum { frac { ( { n_i -n_i’ } )^2 } { n_i’ } } qquad (1) end{equation}

здесь $n_i -$ эмпирические частоты, полученные из выборки, $n_i’ -$ теоретические частоты, найденные теоретическим путём.

Доказано, что при $nto infty $ закон распределения случайной величины { 1 } независимо от того, по какому закону распределена генеральная совокупность, стремится к закону $chi ^2$ { хи-квадрат } с $k$ степенями свободы.

Опр Число степеней свободы находят по равенству $k=S-1-r$ где $S-$ число групп интервалов, $r-$ число параметров.

1) равномерное распределение: $r=2, k=S-3 $

2) нормальное распределение: $r=2, k=S-3 $

3) показательное распределение: $r=1, k=S-2$.

Правило. Проверка гипотезы по критерию Пирсона.

- Для проверки гипотезы вычисляют теоретические частоты и находят $chi _ { набл } ^2 =sum { frac { ( { n_i -n_i’ } )^2 } { n_i’ } } $

- По таблице критических точек распределения $chi ^2$ по заданному уровню значимости $alpha $ и числу степеней свободы $k$ находят $chi _ { кр } ^2 ( { alpha ,k } )$.

- Если $chi _ { набл } ^2 <chi _ { кр } ^2 $ то нет оснований отвергать гипотезу, если не выполняется данное условие — то отвергают.

Замечание Для контроля вычислений применяют формулу для $chi ^2$ в виде $chi _ { набл } ^2 =sum { frac { n_i^2 } { n_i’ } -n } $

Проверка гипотезы о равномерном распределении

Функция плотности равномерного распределения величины $X$ имеет вид $f( x )=frac { 1 } { b-a } xin left[ { a,b }right]$.

Для того, чтобы при уровне значимости $alpha $ проверить гипотезу о том, что непрерывная случайная величина распределена по равномерному закону, требуется:

1) Найти по заданному эмпирическому распределению выборочное среднее $overline { x_b } $ и $sigma _b =sqrt { D_b } $. Принять в качестве оценки параметров $a$ и $b$ величины

$a = overline x _b -sqrt 3 sigma _b $, $b = overline x _b +sqrt 3 sigma _b $

2) Найти вероятность попадания случайной величины $X$ в частичные интервалы $( { x_i ,x_ { i+1 } } )$ по формуле $ P_i =P( { x_i <X<x_ { i+1 } } )=intlimits_ { x_i } ^ { x_ { i+1 } } { f( x )dx=left. { frac { 1 } { b-a } x }right| { begin{array} { c } { x_ { i+1 } } \ { x_i } \ end{array} } } =frac { x_ { i+1 } } { b-a } -frac { x_i } { b-a } . $

3) Найти теоретические { выравнивающие } частоты по формуле $n_i’ =np_i $.

4) Приняв число степеней свободы $k=S-3$ и уровень значимости $alpha =0,05$ по таблицам $chi ^2$ найдём $chi _ { кр } ^2 $ по заданным $alpha $ и $k$, $chi _ { кр } ^2 ( { alpha ,k } )$.

5) По формуле $chi _ { набл } ^2 =sum { frac { ( { n_i -n_i’ } )^2 } { n_i’ } } $ где $n_i -$ эмпирические частоты, находим наблюдаемое значение $chi _ { набл } ^2 $.

6) Если $chi _ { набл } ^2 <chi _ { кр } ^2 -$ нет оснований, отвергать гипотезу.

Проверим гипотезу на нашем примере.

1) $overline x _b =13,00,,,sigma _b =sqrt { D_b } = 6,51$

2) $a=13,00-sqrt 3 cdot 6,51=13,00-1,732cdot 6,51=1,72468$

$b=13,00+1,732cdot 6,51=24,27532$

$b-a=24,27532-1,72468=22,55064$

3) $P_i =P( { x_i <X<x_ { i+1 } } )=frac { x_ { i+1 } } { b-a } -frac { x_i } { b-a } $ $ P_1 =( { -1<X<3 } )=frac { 3 } { 22,55064 } -frac { -1 } { 22,55064 } =0,13303+0,04434=0,177375 $

$ P_2 =( { 3<X<7 } )=frac { 7 } { 22,55064 } -frac { 3 } { 22,55064 } =0,177375 $

$ P_3 =( { 7<X<11 } )=frac { 11 } { 22,55064 } -frac { 7 } { 22,55064 } =0,177375 $

$ P_4 =( { 11<X<15 } )=frac { 15 } { 22,55064 } -frac { 11 } { 22,55064 } =0,177375 $

$ P_5 =( { 15<X<19 } )=frac { 19 } { 22,55064 } -frac { 15 } { 22,55064 } =0,177375 $

$ P_6 =( { 19<X<23 } )=frac { 23 } { 22,55064 } -frac { 19 } { 22,55064 } =0,177375 $

В равномерном распределении если одинакова длина интервала, то $P_i -$ одинаковы.

4) Найдём $n_i’ =np_i $.

5) Найдём $sum { frac { ( { n_i -n_i’ } )^2 } { n_i’ } } $ и найдём $chi _ { набл } ^2 $.

Занесём все полученные значения в таблицу

begin{array} { |l|l|l|l|l|l|l| } hline i& n_i & n_i’ =np_i & n_i -n_i’ & ( { n_i -n_i’ } )^2& frac { ( { n_i -n_i’ } )^2 } { n_i’ } & Контроль~ frac { n_i^2 } { n_i’ } \ hline 1& 1& 4,43438& -3.43438& 11,7950& 2,659898& 0,22551 \ hline 2& 6& 4,43438& 1,56562& 2,45117& 0,552765& 8,11838 \ hline 3& 3& 4,43438& -1,43438& 2,05744& 0,471463& 2,0296 \ hline 4& 3& 4,43438& -1,43438& 2,05744& 0,471463& 2,0296 \ hline 5& 6& 4,43438& 1,56562& 2,45117& 0,552765& 8,11838 \ hline 6& 6& 4,43438& 1,56562& 2,45117& 0,552765& 8,11838 \ hline & & & & & sum = chi _ { набл } ^2 =3,261119& chi _ { набл } ^2 =sum { frac { n_i^2 } { n_i’ } -n } =3,63985 \ hline end{array}

$chi _ { кр } ^2 ( { 0,05,3 } )=7,8$

$chi _ { набл } ^2 <chi _ { кр } ^2 =3,26<7,8$

Вывод отвергать гипотезу нет оснований.