Из этой статьи Вы узнаете, как найти xml элемент по его атрибуту с помощью простого LINQ запроса. И так для начала создадим Windows Forms приложение и поместим на форму: два элемента управления textBox (txtAtrName и txtAtrValue), кнопку и один listBox. Затем добавим в наш проект xml файл, который содержит следующую структуру:

<root> <user id="1" age="20" name="Vasya"/> <user id="2" age="25" name="Ola"/> <user id="3" age="30" name="Petya"/> <user id="4" age="25" name="Vasya"/> </root>

Задача: найти все xml элементы, которые содержат атрибут «age» со значением 25. Надеюсь, Вы уже знаете, что такое XML и как с ним работать, поэтому сразу же переходим к решению задачи.

исходный код

using System.Xml.Linq; //добавить

try

{

XDocument xDoc = XDocument.Load("My.xml");

var elements = from elmts in xDoc.Descendants()

where elmts.Attribute(txtAtrName.Text).Value == txtAtrValue.Text

select elmts;

foreach (var element in elements)

{

listBox1.Items.Add(element);

}

}

catch (Exception ex)

{

MessageBox.Show(ex.Message);

}

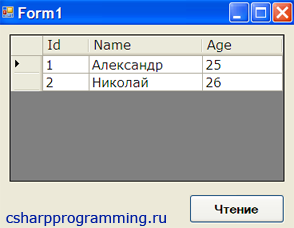

Результат

Всё работает, но если Вы сейчас попытаетесь найти XML элемент, у которого атрибут «age» не существует, то в результате Вы получите исключение. Например, не много изменим XML файл и удалим у четвертого элемента атрибут «age».

<root> ... <user id="4" name="Vasya"/> </root>

Выполним выше указанный код, в результате получаем исключение NullReferenceException.

Чтобы этого избежать нужно, добавить в Linq запрос проверку на null. То есть сначала мы должны убедиться, что XML атрибут существует, а только потом получить его значение.

var elements = from elmts in xDoc.Descendants() where elmts.Attribute(txtAtrName.Text) != null && elmts.Attribute(txtAtrName.Text).Value == txtAtrValue.Text select elmts;

Теперь всё в порядке.

Читайте также:

- Основные компоненты .NET Framework (CLR и Framework Class Library)

- Как разархивировать rar файл?

- WebBrowser работа с html атрибутами

Основные настройки сканирования сайта

Для большинства специалистов общий аудит сайта – непростая задача, однако с таким инструментом, как Screaming Frog SEO Spider (СЕО Паук), она может стать значительно более простой для профессионалов и даже для новичков. Удобный интерфейс Screaming Frog позволяет работать легко и быстро: с его помощью можно проверить позиции сайта, просканировать все страницы, найти внутренние ссылки и проблемы с контентом. Однако многообразие вариантов конфигурации, сложность в настройке и функциональности может усложнить знакомство с программой.

Инструкция ниже призвана продемонстрировать способы использования Screaming Frog как для аудита сайтов, так и других задач необходимых для продвижения сайта.

Важно! Скачивать лучше последнюю версию программы, регулярно обновляя ее. Данный гайд рассчитан на версию 16.7. Если у вас более старая версия или, наоборот, новая, вы можете столкнуться с неточностями в описании или другим видом интерфейса программы.

Настройки парсера

Перечень базовых настроек перед стартом работ

Memory

Здесь указываем предел оперативной памяти для парсинга. Опираемся на параметры своего ПК: учтите, что при запуске краулера этот объем RAM будет полностью зарезервирован и доступен только ему. Слишком маленький объем буфера может привести к зависанию паука при сканировании очень больших сайтов.

Storage

В данном разделе указывается, куда будут сохраняться отчеты – в папку «Программы» либо по указанному пути (по умолчанию в /User).

Proxy

Указывается прокси, с помощью которых будет происходить парсинг (используется, если выбран чекбокс).

Embedded Browser

Если чекбокс активен, парсер использует встроенный в программу браузер (на базе Chromium) для сканирования.

Режимы сканирования — Mode

Выбираем режимы сканирования сайта.

*Кстати, вы можете в любой момент приостановить сканирование, сохранить проект и закрыть программу, а при следующем запуске продолжить с того же места.

Spider – классический парсинг сайта по внутренним ссылкам, домен вводится в адресную строку.

List – парсим только предварительно собранный список URL-адресов. Указать последние можно разными способами:

- From a File – выгружаем URL-адреса из файла.

- Paste – выгружаем URL-адреса из буфера обмена.

- Enter Manually – вводим вручную в соответствующее поле.

- Download Sitemap – выгружаем их из карты сайта.

SERP Mode – режим не для сканирования: в нем можно загружать метаданные сайта, редактировать и тестировать.

Скорость парсинга

Еще одна основная настройка SEO Frog. При запуске парсинга внизу указывается средняя скорость и текущая. Если сайт не выдерживает большой нагрузки, то лучше в настройках задать другое значение.

Необходимо зайти в Configuration ➜ Speed и выставить более щадящие параметры.

Можно уменьшить кол-во потоков, а также максимальное количество обрабатываемых адресов в секунду.

Задаем параметры скорости анализа

Сканирование всего сайта

По умолчанию Screaming Frog сканирует лишь поддомен (или основной домен), на который вы заходите. Любой дополнительный поддомен, с которым сталкивается Spider, рассматривается как внешняя ссылка. Чтобы сканировать дополнительные поддомены, необходимо внести корректировки в меню конфигурации. Выбрав опцию «Crawl All Subdomains», вы можете быть уверены в том, что “паук” проанализирует любые ссылки, которые попадаются на поддоменах вашего сайта.

Заходим в настройки паука:

Переход к настройкам паука

Выставляем параметры:

Разрешение на анализ поддоменов

Чтобы ускорить сканирование, уберите чекбоксы на картинки, CSS, JavaScript, SWF или внешние ссылки.

Выключаем анализ медиафайлов

Парсинг только одного раздела

Если вы хотите ограничить сканирование конкретной папкой, просто введите URL.

Вставляем адрес сайта или раздела и нажимает “старт”

При этом убедитесь, что в настройках Configuration ➜ Spider ➜ Crawl убрана галочка с Crawl Outside of Start Folder

Запрещаем переход за рамки указанной папки

Если вы хотите начать сканирование с конкретной папки, а затем перейти к анализу оставшейся части поддомена, то перед тем, как начать работу с необходимым URL, перейдите сначала в раздел Spider под названием «Configuration» и выберите в нем опцию «Crawl Outside Of Start Folder».

Разрешаем переход за рамки указанной папки

Как сканировать список поддоменов или каталогов

Чтобы взять в работу или, напротив, исключить конкретный список поддоменов или подкаталогов, вы можете использовать RegEx, чтобы задать правила включения (Include settings — сканируем только заданные папки) или исключения (Exclude settings — сканируем все, кроме указанных папок) определенных элементов в меню «Configuration».

Добавляем не нужный раздел в список исключений

Как сканировать сайт, размещенный на старом сервере

В некоторых случаях старые серверы могут оказаться неспособны обрабатывать заданное количество URL-запросов в секунду. Чтобы изменить скорость сканирования, в меню «Configuration» откройте раздел «Speed» и во всплывающем окне выберите максимальное число потоков, которые должны быть задействованы одновременно. В этом меню также можно выбрать максимальное количество URL-адресов, запрашиваемых в секунду.

Если в результатах сканирования вы обнаружите большое количество ошибок сервера, перейдите во вкладку «Advanced» в меню конфигурации Паука и увеличите значение времени ожидания ответа (Response Timeout) и число новых попыток запросов (5xx Response Retries).

Настройка авторизации

Паук Screaming Frog заходит на страницу, запрашивающую идентификацию, а затем всплывает окно, в котором требуется ввести логин и пароль.

Переход на страницу авторизации

Для того, чтобы впредь обходиться без данной процедуры, в меню конфигурации заходим в раздел Configuration ➜ Authentication и снимаем флажок.

Отключение авторизации

Парсинг списка URL

Итак, вы собрали много URL, но вам необходима дополнительная информация о них? Установите режим List, затем загрузите список URL-адресов в формате .txt или .csv. После завершения процедуры вы сможете увидеть код состояния, исходящие ссылки, количество слов и, конечно, метаданные для каждой страницы в вашем списке.

Переход в режим List -работа по перечню URL

Внутренние и внешние ссылки

Если вам не требуется информация про JavaScript, CSS и flash файлы, отключите эти опции в меню настроек для экономии времени обработки и памяти.

Как только алгоритм закончит сканирование, используйте Bulk Export и соответствующие пункты меню «Links» для экспорта CSV. Вы узнаете про расположение всех ссылок вместе с соответствующими текстами анкоров, директивами и т. д.

Использование меню для выгрузки отчетов в формате CSV

Все ссылки с большого сайта могут представлять собой большой отчет. Помните об этом при экспорте. Для больших сайтов экспорт может занять некоторое время.

Использование SEO Spider при внутренней перелинковке

Внутренняя перелинковка может принести хороший ROI (окупаемость инвестиций), особенно когда у вас есть стратегия распределения PageRank, ранжирование по ключевым словам и анкорам, в которых есть ключевые слова.

Анализ перелинковки

Не будем подробно разбирать правила перелинковки, просто расскажем два важных правила:

- Важные для продвижения страницы должны быть как можно ближе к главной. Они должны иметь как можно больше входящих ссылок и меньше исходящих, чтобы у страницы был хороший внутри-ссылочный вес.

- Во вкладках external и Internal нужно найти inlinks и outlinks, а затем отсортировать по значению. Желательно найти все важные и продвигаемые разделы в списке, для этого можно воспользоваться поиском. Значения входящих и исходящих ссылок у каждого сайта будут разные. Поэтому стоит отталкиваться от размера сайта, общего количества страниц и средне-ссылочной массы каждой из них.

Изучение исходящих и входящих ссылок на страницах. Можно посмотреть какие страницы ссылаются на ту или иную страницу и наоборот.

Поиск битых ссылок на сайте

Screaming Frog Seo Spider позволяет найти битые ссылки. Как только алгоритм закончит проверку, отфильтруйте результаты во вкладке «Internal» по «Status Code». Все 404, 301 и страницы с другим статусом будут показаны.

Обратите внимание на код ответа

Кликнув по любому отдельному URL в результате проверки, вы увидите изменение информации внизу программного окна. Нажав на вкладку «In Links» внизу окна, вы найдете список страниц, которые привязаны к выбранным URL, вместе с анкорным текстом и директивами, использованными на этих ссылках. Вы можете использовать это для мониторинга страниц, на которых нужно обновить внутренние ссылки.

Если страница имеет 404 код ответа, можно узнать, какие еще страницы ссылаются на нее, чтобы заменить или удалить на них битую ссылку.

Для экспорта полного списка страниц с битыми или редиректными ссылками, перейдите в Bulk Export ➜ Response Codes (коды ответов) и выберите «Redirection (3xx) In Links», «Client Error (4xx) In Links» или «Server Error (5xx) In Links». Таким образом вы получите данные в файле CSV.

Прокрутите до кодов ответов и посмотрите на следующие отчеты:

- no response inlinks;

- redirection (3xx) inlinks;

- Redirection (JavaScript) inlinks;

- redirection (meta refresh) inlinks;

- client error (4xx) inlinks;

- server error (5xx) inlinks.

Как найти 301, 302, 307 редиректы

Для экспорта полного списка ссылок с редиректом перейдите в Bulk Export ➜ Response Codes ➜ Redirection (3xx) In Links.

Поиск страниц с очень длинными заголовками страниц, СЕО-тегами или URL-адресами

После завершения сканирования перейдите на вкладку Page Titles и отфильтруйте по Over 65 Characters, чтобы увидеть слишком длинные заголовки страниц. Вы можете сделать то же самое на вкладке Meta Description или на вкладке URI.

Работа по обнаружению проблем с мета-тегами

Поиск дублей SEO-тегов или URL

После того, как SEO Spider закончил сканировать, перейдите на вкладку Page Titles, затем выберите Duplicate. Вы можете сделать то же самое на вкладках Meta Description или URI.

Поиск дублей seo-тегов

Поиск страниц с директивами nofollow, noindex, canonical и т.д.

После того, как SEO Spider закончил проверку, нажмите на вкладку Directives. Чтобы увидеть тип директивы, просто прокрутите вправо или растяните окно программы, чтобы увидеть, какие столбцы заполнены, или используйте фильтр, чтобы найти любой из следующих тегов:

Выберите интересующую вас директиву для получения списка страниц, использующих ее.

- index;

- noindex;

- follow;

- nofollow;

- noarchive;

- nosnippet;

- noodp;

- noydir;

- noimageindex;

- notranslate;

- unavailable_after;

- refresh.

Проверка файла robots.txt

По умолчанию Screaming Frog будет выполнять требования robots.txt. В качестве приоритета он будет следовать директивам, сделанным специально для пользовательского агента (user agent) Screaming Frog. Если для агента пользователя Screaming Frog нет никаких директив, то SEO Spider будет следовать любым директивам для поискового робота Googlebot, а если нет специальных директив для робота Googlebot, он будет следовать глобальным директивам для всех пользовательских агентов.

Если вы хотите заблокировать определенные части сайта от SEO Spider, используйте обычный синтаксис robots.txt с пользовательским агентом Screaming Frog SEO Spider. Если вы хотите игнорировать robots.txt, просто выберите эту опцию в настройках Configuration ➜ Spider.

Настройка паука для работы с роботс

Configuration ➜ Robots.txt ➜ Settings

Переход в настройки

Подробнее про robots.txt вы можете узнать из другой статьи.

Проверка микроразметки Schema и других структурированных данных

Начиная с Screaming Frog 11.0, Spider SEO также предлагает нам возможность просканировать, извлекать и проверять структурированные данные непосредственно из сканирования. Проверяйте любые структурированные данные JSON-LD, Microdata или RDFa в соответствии с рекомендациями Schema.org и спецификациями Google в режиме реального времени во время сканирования. Чтобы получить доступ к инструментам проверки структурированных данных, выберите параметры в Config ➜ Spider ➜ Extraction.

Даем добро на извлечение данных о микроразметке

Теперь в главном интерфейсе есть вкладка Structured Data, которая позволит вам переключаться между страницами, содержащими структурированные данные, и которые могут иметь ошибки или предупреждения проверки:

Поиск микроразметки на страницах через фильтр

Подробнее про микроразметку в другой статье сайта.

Проверка контента сайта через Screaming Frog

Ищем страницы с не информативным контентом

Screaming Frog позволяет посмотреть несодержательные страницы, то есть с минимальным содержанием контента (или без него). Приводим инструкцию, как это сделать.

После того, как алгоритм закончит проверку, откройте вкладку «Internal», отсортируйте по HTML и прокрутите вправо до колонки «Word Count». Отсортируйте колонку «Word count» от наименьшего до наибольшего, чтобы найти страницы с маленьким количеством контента. Вы можете перетянуть колонку «Word Count» влево. Нажмите «Export» во вкладке «Internal», если вам удобнее работать с данными в формате CSV.

Отсортируйте колонку Word count по возрастанию

Поиск URL-адресов, которые необходимо переписать или добавить атрибут canonical

После того, как SEO Spider завершил сканирование, перейдите на вкладку URI, затем отфильтруйте по Underscores, Uppercase или Non ASCII Characters (список URI, который содержит символы, не включенные в схему кодирования ASCII символов), чтобы просмотреть URL, которые потенциально могут быть переписаны в более стандартную структуру.

Поиск страниц с нестандартными URL. Помните, что изменение URL приведет потере позиций в выдаче, если не будет настроен редирект со старого адреса на новый.

Выберите Duplicate и вы увидите все страницы с несколькими версиями URL. Отфильтруйте по Parameters, и вы увидите URL-адреса, содержащие параметры.

Как найти на сайте CSS-файл.

В меню Configuration ➜ Spider выберите «Crawl» и «Store» CSS перед проверкой.

После завершения отсортируйте результаты по «CSS» во вкладке «Internal».

Поиск css на страницах

Ищем файлы JavaScript.

В меню Configuration ➜ Spider выберите «Crawl» и «Store» для JavaScript перед проверкой

Отсортируйте результаты по «JavaScript» во вкладке «Internal» по завершении обхода

Как найти изображения без alt

Во-первых, вы должны убедиться, что в меню Spider ➜ Configuration выбран Check Images. После того, как SEO Spider закончил анализировать, перейдите на вкладку Images и отфильтруйте по Missing Alt Text (отсутствует Alt) или Alt Text Over 100 Characters. Вы можете найти страницы, где находится любое изображение, нажав на вкладку Image Info в нижнем окне. Страницы будут перечислены в столбце From.

Поиск изображений. Обратите внимание на изображения без Alt — поисковики этого не прощают.

Наконец, если вы предпочитаете CSV, используйте меню Bulk Export, чтобы экспортировать All Images или Images Missing Alt Text Inlinks, чтобы увидеть полный список изображений, где они находятся, и любой связанный с ним текст alt или проблемы с alt Text.

Экспорт данных в CSV в зависимости от того, какая проблема с изображениями вас интересует.

Необходимо проверить наличие атрибута alt на всех изображениях, которые используются на сайте. Большинство изображений выводятся циклами, поэтому рекомендуется искать закономерности. Очень важно заполнять теги картинок — Alt. Но на фоне фильтра Яндекс Noname категорически нельзя спамить ключевыми словами в пункты меню, хлебные крошки и теги картинок. Многие сайты попали под этот фильтр именно благодаря тегам картинок и долгие годы сидят под фильтром, ведь самая страшная особенность данного фильтра (отсюда и происходит его название) в том, что поддержка Яндекс не отвечает на запрос по этому фильтру и говорит, что с сайтом все хорошо, да только вот ранжирование сайта в Яндекс оставляет желать лучшего.

Поиск плагинов jQuery

Прежде всего, убедитесь, что в меню конфигурации выбрано «Check JavaScript». По завершении сканирования примените в панели «Internal» фильтр «JavaScript», а после сделайте поиск «jQuery». Это позволит вам получить список файлов с плагинами. Отсортируйте перечень по функции «Address» для более удобного просмотра. Затем просмотрите «InLinks» в нижнем окне или экспортируйте информацию в CSV. Чтобы найти страницы, на которых используются файлы, поработайте со столбиком «From».

Получение списка страниц с .JS на борту

Поиск flash на сайте

Перед сканированием в меню конфигурации выберите «Check SWF». А по завершении работы Паука отфильтруйте результаты в панели «Internal» по значению «Flash».

Как найти на сайте PDF-файлы

После завершения сканирования отфильтруйте результаты работы Spider при помощи опции «PDF» в панели «Internal».

Для отображения списка страниц с PDF и Flash

Проверка орфографии и грамматики

Как проверить орфографию и грамматику при помощи Screaming Frog? Новая вкладка «Content» содержит фильтры для «Spelling Errors» и «Grammar Errors» и отображает счетчики для каждой просканированной страницы.

Поиск страниц с грамматическими ошибками

Вы можете включить проверку орфографии и грамматики Configuration ➜ Content ➜ Spelling & Grammar.

Настройка словаря

Карта сайта

Создание XML Sitemap

После того, как паук закончил сканировать ваш ресурс, нажмите на «Sitemap» и выберите «XML Sitemap».

Сохраните вашу карту сайта в XML формате, а после откройте ее обычным блокнотом.

Генерация XML карты на основании полученного списка URL

После того, как карта сайта предстанет перед вами в табличной форме, вы с легкостью сможете изменить частоту, приоритет и прочие настройки. Обязательно убедитесь в том, что Sitemap содержит лишь один предпочитаемый (канонический) вариант каждого URL, без параметров и прочих дублирующих факторов.

После внесения каких-либо изменений пересохраните файл в формате XML.

Как найти страницы, которых нет в Sitemap.xml

Вы можете настроить параметры сканирования, чтобы обнаруживать и сравнивать URL-адреса в ваших XML-файлах сайта с URL-адресами в пределах вашего сайта.

Перейдите в Configuration ➜ Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле. *Important note – если ваш файл robots.txt не содержит правильных целевых ссылок на все XML-карты сайта, которые вы хотите сканировать, вы должны ввести их вручную.

Настройка позволит найти страницы, которых не в sitemap

После обновления настроек сканирования XML-файла Sitemap перейдите к пункту Crawl Analysis в навигации, затем нажмите Configure и убедитесь, что кнопка Sitemaps отмечена.

- Сначала запустите полное сканирование сайта

- Вернитесь к Crawl Analysis и нажмите Start.

Убедитесь, что чекбокс Sitemaps активен

Общие проблемы

Определение проблем с индексацией и ранжированием

Хотите знать, почему некоторые страницы закрыты от индексации? Во-первых, стоит убедиться, что они не были случайно помещены в файл robots.txt или помечены как noindex. Затем нужно проверить, что SEO Spider может добраться до страниц, проверив ваши внутренние ссылки. Страницу, которая не имеет внутренних ссылок на вашем сайте, часто называют «сиротами» (Orphaned Page).

Чтобы выявить потерянные страницы, выполните следующие действия:

Перейдите в Configuration ➜ Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле.

Перейдите в Configuration ➜ API Access ➜ Google Analytics – используя API, вы можете получить аналитические данные для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы из органического поиска, убедитесь, что они разделены на органический трафик.

Переход к настройкам Google Analytics

Вы также можете перейти к разделу Configuration ➜ API Access ➜ Google Analytics ➜ General ➜ Crawl New URLs Discovered In Google Analytics, если вы хотите, чтобы URL-адреса, обнаруженные в GA, были включены в ваш полный обход сайта. Если это не включено, вы сможете просматривать только новые URL-адреса, извлеченные из GA, в отчете Orphaned Pages.

Включение обхода новых URL, обнаруженных в GA

Перейдите в Configuration ➜ API Access ➜ Google Search Console – используя API, вы можете получить данные GSC для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы, вы можете искать URL-адреса, на которых получены клики и показы, которые не включены в ваш просмотр. Вы также можете перейти к разделу General ➜ Crawl New URLs Discovered In Google Search Console, если вы хотите, чтобы URL-адреса, обнаруженные в GSC, были включены в ваш полный обход сайта. Если этот параметр не включен, вы сможете просматривать только новые URL-адреса, извлеченные из GSC, в отчете Orphaned Pages.

Просканируйте весь сайт. После завершения сканирования перейдите в Crawl Analysis ➜ Start и дождитесь его завершения.

Просмотрите потерянные URL-адреса на каждой из вкладок или выполните Bulk Expor всех потерянных URL-адресов, перейдя в Reports ➜ Orphan Pages.

Получение списка страниц-сирот

Как найти медленные страницы

После того, как SEO Spider завершил сканирование, перейдите на вкладку Response Codes и отсортируйте по столбцу Response Time по возрастанию, чтобы найти страницы, которые могут страдать от низкой скорости загрузки.

Сортируем колонку по возрастанию. Время указано в секундах

Поиск вредоносного ПО и спама

Вам необходимо идентифицировать след вредоносного ПО или спама. Далее в меню Configuration нажмите Custom ➜ Search и введите искомый элемент, который вы ищете.

Настройка условий поиска

Вы можете ввести до 10 различных фильтров для сканирования.

В заключение

Если вы не SEO-специалист, то решение провести самостоятельный технический аудит сайта своей компании похвально. Такая программа, как Screaming Frog Spider SEO, может очень помочь вам в этом деле, но для полной оптимизации сайта этого все же недостаточно. Существует множество сервисов, которые помогают проанализировать проблемы, но данная программа имеет самый обширный арсенал возможностей. И помните главное правило — лучше делать долго, но качественно, чем быстро и почти никак.

Поиск в файлах XML онлайн

Loading…

Обработка Пожалуйста, подождите…

Копировать ссылку

Обработка Пожалуйста, подождите…

Файл отправлен на

Ваше мнение важно для нас, пожалуйста, оцените это приложение.

★

★

★

★

★

Спасибо за оценку нашего приложения!

XML search

Conholdate XML Search — это бесплатное онлайн-приложение, позволяющее выполнять поиск в XML файлах и других документах без установки какого-либо программного обеспечения. Conholdate.Search чистый, быстрый, безопасный и поддерживает все современные веб-браузеры. Всего одним щелчком мыши вы можете выполнять поиск в XML файлах с различными параметрами на вашем собственном веб-сайте, в блоге и т. д.

Скоро будет

Как Поиск XML

- Щелкните внутри области перетаскивания или перетащите файл.

- Дождитесь завершения загрузки и обработки.

- После завершения загрузки и обработки файла вы увидите страницу результатов.

- На странице результатов нажмите кнопку «Поиск», чтобы начать полнотекстовый поиск в вашем файле.

- Вы также можете поделиться своим файлом с помощью ссылки для копирования или электронной почты.

часто задаваемые вопросы

Q: Как искать в файле XML?

A: Во-первых, вам нужно загрузить файл: перетащите файл или щелкните внутри белой области, чтобы выбрать файл и начать индексирование документа. Когда индексирование будет завершено, вы сможете нажать кнопку «Поиск», чтобы открыть приложение «Поиск», или скопировать ссылку, которой вы можете поделиться с друзьями для просмотра файла.

Q: Сколько времени требуется для индексации файла XML?

A: Скорость индексации документов зависит от сложности файла, однако обычно все документы индексируются в течение 5-10 секунд.

Q: Какой браузер мне следует использовать для поиска в файлах XML?

A: Вы можете использовать любой современный браузер для поиска в документе. Мы поддерживаем все новейшие браузеры, такие как Chrome, Safari, Opera, Firefox, Edge и Tor.

Q: Безопасно ли искать в XML файлах с помощью бесплатного Conholdate.Search?

A: Да, это абсолютно безопасно. Ваши файлы хранятся на нашем защищенном сервере и защищены от любого несанкционированного доступа. Через 24 часа все файлы удаляются безвозвратно.

Q: Возможен ли поиск в файлах XML в ОС Linux, Mac или Android?

A: Конечно, Conholdate Search – это полностью облачная служба, которая не требует установки какого-либо программного обеспечения и может использоваться в любой операционной системе с веб-браузером.

Q: Как искать в публичной библиотеке?

A: Перейдите в Общедоступную библиотеку и введите текст поиска в поле поиска. Также вы можете использовать дополнительные параметры поиска, чтобы улучшить поисковый запрос.

Еще приложений

Еще search приложений

Выбрать язык

Screaming Frog SEO Spider – один из наиболее важных инструментов в арсенале оптимизатора. Этот сервис просто незаменим при анализе интернет-ресурса, так как позволяет автоматизировать сбор и структурирование самых важных данных о сайте, тем самым сильно ускоряя работу.

Если вы занимаетесь развитием собственного веб-проекта, или продвижением сайтов клиентов, то Screaming Frog наверняка вам знаком. Но используете ли вы доступные возможности на 100%? В этой статье мы подготовили максимально подробное руководство по использованию данного инструмента. Надеемся, вы сможете найти здесь много нового и полезного.

Базовое сканирование сайта

Как сканировать весь сайт

Приступая к сканированию сайта, важно наперед определить, какую информацию вы хотите получить, насколько велик сайт, и какую часть сайта вам нужно сканировать, чтобы получить доступ к нужным данным.

Примечание: Иногда для масштабных ресурсов лучше ограничить сканер подразделом URL-адресов, чтобы получить хороший репрезентативный образец данных. Это делает размеры файлов и экспорт данных более управляемыми. Мы рассмотрим это более подробно ниже.

Для сканирования всего сайта, включая все дочерние домены, вам нужно внести небольшие изменения в конфигурацию spider, чтобы начать.

По умолчанию Screaming Frog сканирует только субдомен, который вы ввели. Любые дополнительные субдомены, с которыми сталкивается spider, будут рассматриваться, как внешние ссылки. Для обхода дополнительных поддоменов, необходимо изменить настройки в меню Spider Configuration. Отметив Crawl All Subdomains, вы убедитесь, что SEO Spider сканирует любые ссылки, которые он встречает, на другие поддомены на вашем сайте.

Шаг 1:

Шаг 2:

Если вы запускаете сканирование из определенной подпапки или подкаталога и по-прежнему хотите, чтобы Screaming Frog сканировал весь сайт, установите флажок Crawl Outside of Start Folder.

По умолчанию SEO Spider настроен только на сканирование подпапки или подкаталога, который вы сканируете. Если вы хотите сканировать весь сайт и запускать из определенного подкаталога, убедитесь, что для конфигурации задан обход за пределами начальной папки.

Совет: Чтобы сэкономить время и место на диске, помните о ресурсах, которые могут вам не понадобиться при сканировании. Снимите флажки с изображения, CSS, JavaScript и SWF-ресурсов, чтобы уменьшить размер обхода.

Как сканировать один подкаталог

Если вы хотите ограничить сканирование одной папкой, просто введите URL-адрес и нажмите Start, не изменяя никаких настроек по умолчанию. Если вы перезаписали исходные настройки по умолчанию, сбросьте настройки по умолчанию в меню File.

Если вы хотите начать сканирование в определенной папке, но нужно продолжить сканирование в остальных частях субдомена, обязательно выберите Crawl Outside Of Start Folder в настройках Spider Configuration, прежде, чем вводить ваш конкретный стартовый URL.

Как сканировать определенный набор поддоменов или подкаталогов

Чтобы ограничить просмотр определенным набором поддоменов или подкаталогов, вы можете использовать RegEx, чтобы установить эти правила в параметрах Include или Exclude в меню Configuration.

Exclusion (Исключение)

В этом примере мы просмотрели каждую страницу на elit-web.ru, исключая страницы blog на каждом поддомене.

Шаг 1:

Перейдите в Configuration > Exclude, используйте подстановочные регулярные выражения для определения URL или параметров, которые вы хотите исключить.

Шаг 2:

Проверьте свое регулярное выражение, чтобы убедиться, что оно исключает ожидаемые страницы до начала сканирования:

Include (Включение)

В приведенном ниже примере мы хотели просмотреть только подпапку команды на elit-web.ru. Опять же, используйте закладку Test, чтобы протестировать несколько URL и убедиться, что RegEx правильно настроен для вашего правила inclusion.

Это отличный способ сканирования больших сайтов. На самом деле, Screaming Frog рекомендует этот метод, если вам нужно разделить и сканировать сайт с большим числом обратных ссылок.

Как получить список всех страниц на моем сайте

По умолчанию, Screaming Frog настроен на сканирование всех изображений, JavaScript, CSS и флэш-файлов, с которыми сталкивается SEO Spider. Чтобы сканировать (crawl) только HTML, вам придется снять выделение с пунктов Check Images, Check CSS, Check JavaScript и Check SWF в меню Spider Configuration.

Запуск SEO Spider с этими настройками без галочки, по сути, предоставит вам список всех страниц вашего сайта, на которые есть внутренние ссылки, указывающие на них.

После завершения сканирования перейдите на вкладку Internal и отфильтруйте результаты по HTML. Нажмите кнопку Export, и у вас будет полный список в формате CSV.

Совет: Если вы склонны использовать одни и те же настройки для каждого сканирования, Screaming Frog теперь позволяет вам сохранить настройки конфигурации:

Как получить список всех страниц в определенном подкаталоге

В дополнение к снятию флажка Check Images, Check CSS, Check JavaScript и Check SWF, вы также захотите снять флажок Check Links Outside Folder в настройках Spider Configuration. Запуск SEO Spider с этими настройками без флажка, даст вам список всех страниц в вашей стартовой папке (если они не являются страницами, на которые нет внутренних или внешних ссылок).

Как найти все субдомены на сайте и проверить внутренние ссылки

Есть несколько разных способов найти все поддомены на сайте.

Способ 1

Используя Screaming Frog для идентификации всех поддоменов на данном сайте, перейдите в Configuration > Spider и убедитесь, что выбрана опция Crawl all Subdomains. Как и при сканировании всего сайта, это поможет сканировать любой поддомен, связанный с обходом сайта. Тем не менее, это не найдет поддоменов, которые не связаны ссылками.

Способ 2

Используйте Google, (расширение для браузера Scraper Chrome) для идентификации всех проиндексированных поддоменов, мы можем найти все индексируемые субдомены для данного домена.

Шаг 1:

Начните вводить в поисковике: site: оператор поиска в Google, чтобы ограничить результаты для вашего конкретного домена. Затем используйте оператор поиска -inurl, чтобы сузить результаты поиска, удалив основной домен. Появится список поддоменов, которые были проиндексированы в Google, в котором не будет основного домена.

Шаг 2:

Используйте расширение Scraper, чтобы извлечь все результаты в Google Sheet. Просто щелкните правой кнопкой мыши URL-адрес в поисковой выдаче, нажмите Scrape Similar и экспортируйте в Google Doc.

Шаг 3:

В вашем Документе Google Doc используйте следующую функцию, чтобы обрезать URL-адрес до субдомена:

=LEFT(A2,SEARCH («/»,A2,9))

По сути, приведенная выше формула должна помочь удалить любые подкаталоги, страницы или имена файлов в конце сайта. Эта формула, позволяет не экспортировать в Excel то, что находится слева от конечной косой черты. Стартовое число 9 является важным, потому что мы просим его начать искать косую черту «/» после 9-го символа. Это составляет протокол: https://, длиной в 8 символов.

Дублируйте список и загрузите его в Screaming Frog в режиме списка (List Mode) – вы можете вручную вставить список доменов, использовать функцию вставки (paste) или загрузить (upload) CSV.

Способ 3

Введите URL-адрес корневого домена в инструменты (tools), чтобы найти сайты, которые могут существовать на том же IP-адресе. Также вы можете воспользоваться поисковыми системами, специально предназначенными для поиска поддоменов, например FindSubdomains. Создайте бесплатную учетную запись для входа и экспорта списка поддоменов. Затем загрузите список в Screaming Frog, используя режим списка (List Mode).

Как только SEO Spider закончит работу, вы сможете увидеть код состояния, а также любые ссылки на домашних страницах поддоменов, текст привязки и дубликаты заголовков страниц, среди прочего.

Как сканировать интернет-магазин или другой большой сайт

Изначально Screaming Frog не был создан для сканирования сотен тысяч страниц, но благодаря некоторым обновлениям он становится многофункциональнее с каждым днем.

Последняя версия Screaming Frog была обновлена, чтобы полагаться на хранилище базы данных для обходов. В версии 11.0 Screaming Frog позволял пользователям сохранять все данные на диске в базе данных, а не просто хранить их в оперативной памяти. Это открыло возможность сканирования очень больших сайтов в один клик.

В версии 12.0 сканирование автоматически сохраняет обходы в базе данных. Это позволяет получить к ним доступ и открыть с помощью File > Crawls в меню верхнего уровня (на случай, если вы удивляетесь, куда пошла команда open?)

Хотя использование обхода базы данных помогает Screaming Frog лучше управлять большими объемами информации, это, конечно, не единственный способ сканирования большого сайта.

Во-первых, вы можете увеличить выделение памяти в SEO Screaming Frog.

Во-вторых, вы можете разбить сканирование по подкаталогу или сканировать только определенные части сайта, используя настройки Include / Exclude.

В-третьих, вы можете не сканировать изображения, JavaScript, CSS и flash. Отменив выбор этих параметров в меню Configuration, сэкономив тем самым память, сканируя только HTML.

Совет: До недавнего времени Screaming Frog SEO Spider мог приостанавливаться или зависать при сканировании большого сайта. Теперь, когда хранилище базы данных является настройкой по умолчанию, вы можете восстановить обходы, чтобы выбрать, где вы остановились. Кроме того, вы также можете получить доступ к URL-адресам в очереди. Это может дать вам представление о любых дополнительных параметрах или правилах, которые вы можете исключить для сканирования большого сайта.

Как сканировать сайт, размещенный на старом сервере, или как сканировать сайт без сбоев

В некоторых случаях старые серверы могут не обрабатывать количество URL-запросов по умолчанию в секунду. Мы рекомендуем включить ограничение на количество сканируемых URL-адресов в секунду, чтобы на всякий случай не усложнять работу сервера сайта. Лучше всего, чтобы клиент знал, когда вы планируете сканировать сайт, на случай, если у него может быть защита от неизвестных пользовательских агентов. С одной стороны, им может понадобиться внести в белый список ваш IP или пользовательский агент (User-Agent), прежде, чем вы будете сканировать сайт. В худшем случае вы можете отправить слишком много запросов на сервер и непреднамеренно завершить работу сайта.

Чтобы изменить скорость сканирования, выберите Speed в меню Configuration и во всплывающем окне выберите максимальное количество потоков, которые должны работать одновременно. В этом меню вы также можете выбрать максимальное количество URL-адресов, запрашиваемых в секунду.

Совет: Если вы обнаружите, что при сканировании возникает много ошибок сервера, перейдите на вкладку Advanced в меню Spider Configuration и увеличьте значение Response Timeout и 5xx Response Retries, чтобы получить лучшие результаты.

Как сканировать сайт, который требует куки

Хотя поисковые роботы не принимают файлы cookie, если вы сканируете сайт и хотите разрешить использование файлов cookie, просто выберите Allow Cookies на вкладке Advanced в меню Spider Configuration.

Как сканировать, используя другой пользовательский агент (User-Agent)

Чтобы сканировать с использованием другого пользовательского агента, выберите User Agent в меню Configuration, затем выберите поискового бота из выпадающего списка или введите нужные строки пользовательского агента.

Поскольку Google теперь ориентирован на мобильные устройства, попробуйте просканировать сайт как смартфон Googlebot или измените User-Agent, чтобы он был как смартфон Googlebot. Это важно по двум причинам:

- Сканирование сайта, имитирующее пользовательского агента (user-agent) смартфон Googlebot, может помочь определить любые проблемы, возникающие у Google при сканировании и отображении контента вашего сайта.

- Использование модифицированной версии пользовательского агента смартфона Googlebot поможет вам различать ваши обходы и обходы Google при анализе журналов сервера.

Как сканировать страницы, требующие аутентификации

Когда Screaming Frog встречает страницу, защищенную паролем, появляется всплывающее окно, в котором вы можете ввести требуемое имя пользователя и пароль.

Аутентификация на основе форм является очень мощной функцией и может потребовать рендеринга JavaScript для эффективной работы.

Примечание: проверку подлинности на основе форм следует использовать экономно и только опытным пользователям. Сканер запрограммирован так, что он кликает каждую ссылку на странице, это может привести к появлению ссылок для выхода из системы, создания сообщений или даже удаления данных.

Чтобы управлять аутентификацией, перейдите к Configuration > Authentication.

Чтобы отключить запросы на аутентификацию, отмените выбор Authentication на основе стандартов в окне Authentication в меню Configuration.

Внутренние ссылки

Как получить информацию обо всех внутренних и внешних ссылках на моем сайте (якорный текст, директивы, ссылки на страницу и т. д.)

Если вам не нужно проверять изображения, JavaScript, Flash или CSS на сайте, отмените выбор этих параметров в меню Spider Configuration, чтобы сэкономить время и память.

Как только SEO Spider завершит сканирование, используйте меню Bulk Export, чтобы экспортировать CSV All Links. Это предоставит вам все ссылки, а также соответствующий якорный текст, директивы и т. д.

Все ссылки могут быть в большом отчете. Помните об этом при экспорте. Для большого сайта этот экспорт может занять несколько минут.

Для быстрого подсчета количества ссылок на каждой странице перейдите на вкладку Internal и отсортируйте по Outlinks. Страницы, где более 100 ссылок, возможно, потребуется пересмотреть.

Как найти неработающие внутренние ссылки на странице или сайте

Как и в предыдущем пункте, отмените выбор JavaScript, Flash или CSS сайта в меню Spider Configuration, если вам не нужно проверять изображения.

После того, как SEO Spider завершит сканирование, отсортируйте результаты вкладки Internal по Status Code. Любой 404, 301 или другой код состояния будут легко доступны для просмотра.

Нажав на любой отдельный URL в результатах сканирования, вы увидите изменение информации в нижнем окне программы. Нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые ссылаются на выбранный URL, а также якорный текст и директивы, используемые в этих ссылках. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить внутренние ссылки.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, выберите Redirection (3xx) In Links или Client Error (4xx) In Links или Server Error (5xx) In Links в меню Advanced Export, и вы получите CSV-экспорт данных.

Чтобы экспортировать полный список страниц, которые содержат неработающие или перенаправленные ссылки, посетите меню Bulk Export. Прокрутите вниз до кода ответов и посмотрите следующие отчеты:

- No Response Inlinks;

- Redirection (3xx) Inlinks;

- Redirection (JavaScript) Inlinks;

- Redirection (Meta Refresh) Inlinks;

- Client Error (4xx) Inlinks;

- Server Error (5xx) Inlinks.

Просмотр всех этих отчетов должен дать вам адекватное представление о том, какие внутренние ссылки следует обновить, чтобы они указывали на каноническую версию URL и эффективно распределяли качественные ссылки.

Как найти неработающие исходящие ссылки на странице или сайте (или все исходящие ссылки в целом)

После отмены выбора Check Images, Check CSS, Check JavaScript и Check SWF в настройках Spider Configuration убедитесь, что Check External Links остается выбранной.

После того, как SEO Spider завершит сканирование, нажмите на вкладку External в верхнем окне, отсортируйте по Status Code Вы легко сможете найти URL с кодом состояния, отличными от 200. После нажатия на любой отдельный URL, просканируйте результаты, а затем, нажав на вкладку In Links в нижнем окне, вы увидите список страниц, которые указывают на выбранный URL-адрес. Вы можете использовать эту функцию для определения страниц, на которых необходимо обновить исходящие ссылки.

Чтобы экспортировать полный список исходящих ссылок, нажмите External Links на вкладке Bulk Export.

Для получения полного списка всех местоположений и текста привязки исходящих ссылок выберите All Outlinks в меню Bulk Export. Отчет All Outlinks также будет включать исходящие ссылки на ваши субдомены. Если вы хотите исключить свой домен, воспользуйтесь отчетом External Links, упомянутым выше.

Как найти ссылки, которые перенаправляются

После завершения сканирования выберите вкладку Response Codes в основном пользовательском интерфейсе и выполните фильтрацию по коду состояния. Поскольку Screaming Frog использует регулярные выражения для поиска, отправьте в качестве фильтра следующие критерии: 301 | 302 | 307. Это должно дать вам довольно солидный список всех ссылок, которые возвращались с каким-либо перенаправлением, независимо от того, был ли контент постоянно перемещен, найден и перенаправлен, или временно перенаправлен из-за настроек HSTS (это вероятная причина 307 перенаправлений в Screaming Frog ).

Сортируйте по Status Code, и вы сможете разбить результаты по типу. Нажмите на вкладку In Links в нижнем окне, чтобы просмотреть все страницы, на которых используется ссылка для перенаправления.

Если вы экспортируете напрямую из этой вкладки, то увидите только те данные, которые отображаются в верхнем окне (оригинальный URL, код состояния и куда он перенаправляется).

Чтобы экспортировать полный список страниц, содержащих перенаправленные ссылки, вам нужно будет выбрать Redirection (3xx) In Links в меню Advanced Export. Это вернет CSV, который включает в себя местоположение всех ваших перенаправленных ссылок. Чтобы показать только внутренние перенаправления, отфильтруйте столбец Destination в CSV, чтобы включить только ваш домен.

Совет: Используйте функцию VLOOKUP (ВПР) между двумя вышеупомянутыми файлами экспорта, чтобы сопоставить столбцы Source и Destination с окончательным расположением URL-адреса.

Пример формулы:

= ВПР ([@ Destination], ‘response_codes_redirection_ (3xx) .csv’ $ A $ 3: $ F $ 50,6, FALSE)

Где response_codes_redirection_ (3xx) .csv – это файл CSV, содержащий URL-адреса перенаправления, а 50 – количество строк в этом файле.

Для чего нужны данные о ссылках

Грамотное распределение внутренних ссылок может повысить эффективность поискового продвижения, особенно когда вы занимаетесь стратегическим подходом к распределению PageRank и качественных ссылок, ранжирование ключевых слов и привязки к ключевым словам.

Контент сайта

Как определить страницы с неинформативным контентом

После завершения сканирования SEO Spider перейдите на вкладку Internal, отфильтруйте их по HTML, затем прокрутите вправо до столбца Word Count. Сортируйте столбец Word Count по убыванию, чтобы найти страницы с низким содержанием текста. Вы можете перетащить столбец Word Count влево, чтобы лучше сопоставить значения низкого количества слов с соответствующими URL-адресами. Нажмите Export на вкладке Internal, если вы предпочитаете вместо этого управлять данными в CSV.

Как получить список ссылок на изображения на определенной странице

Если вы уже просмотрели весь сайт или подпапку, просто выберите страницу в верхнем окне, а затем нажмите вкладку Image Info в нижнем окне, чтобы просмотреть все изображения, найденные на этой странице. Изображения будут перечислены в столбце To.

Совет: Щелкните правой кнопкой мыши любую запись в нижнем окне, чтобы скопировать или открыть URL-адрес.

Кроме того, вы также можете просматривать изображения на одной странице, сканируя только этот URL. Убедитесь, что в настройках конфигурации SEO Spider задана глубина сканирования 1, затем после сканирования страницы перейдите на вкладку Images, и вы увидите все изображения, найденные screaming frog.

Как найти изображения, в которых отсутствует текст alt или изображения с длинным текстом alt

Во-первых, вы должны убедиться, что в меню Spider Configuration выбран Check Images. После того, как SEO Spider закончил анализировать, перейдите на вкладку Images и отфильтруйте по Missing Alt Text или Alt Text Over 100 Characters. Вы можете найти страницы, где находится любое изображение, нажав на вкладку Image Info в нижнем окне. Страницы будут перечислены в столбце From.

Наконец, если вы предпочитаете CSV, используйте меню Bulk Export, чтобы экспортировать All Images или Images Missing Alt Text Inlinks, чтобы увидеть полный список изображений, где они находятся, и любой связанный с ним текст alt или проблемы с alt Text.

Кроме того, используйте правую боковую панель, чтобы перейти к разделу изображений для обхода. Здесь вы можете легко экспортировать список всех изображений, пропущенным текстом alt.

Как найти каждый файл CSS на моем сайте

В меню Spider Configuration выберите Crawl и Store CSS перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal с помощью CSS.

Как найти каждый файл JavaScript на сайте

В меню Spider Configuration выберите Check JavaScript перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по JavaScript.

Как определить все плагины jQuery, используемые на сайте, и на каких страницах они используются

Во-первых, убедитесь, что в меню Spider Configuration выбран Check JavaScript. После того, как SEO Spider завершил сканирование, отфильтруйте вкладку Internal по JavaScript, затем найдите jquery. Это предоставит вам список файлов плагинов. Сортируйте список по Address для более удобного просмотра при необходимости, затем просмотрите InLinks в нижнем окне или экспортируйте данные в CSV, чтобы найти страницы, где используется файл. Они будут в столбце From.

Кроме того, вы можете использовать меню Advanced Export, чтобы экспортировать CSV All Links и отфильтровать столбец Destination, чтобы отображались только URL-адреса с jquery.

Совет: Не все плагины jQuery вредны для SEO. Если вы видите, что сайт использует jQuery, лучше всего убедиться, что контент, который вы хотите проиндексировать, включен в источник страницы и обслуживается при загрузке страницы, а не после. Если вы все еще не уверены, установите плагин Google для получения дополнительной информации о том, как он работает.

Как определить места со встроенным flash

В меню Spider Configuration выберите Check SWF перед сканированием, затем, когда сканирование завершится, отфильтруйте результаты на вкладке Internal по Flash.

Это становится все более важным, чтобы находить и идентифицировать контент, который поставляется Flash, и предлагать альтернативный код для него. Flash постепенно устаревает для Chrome. Потому этот функционал действительно нужно использовать, чтобы определить, если есть проблемы с критическим контентом и Flash на сайте.

Примечание: этот метод находит только файлы .SWF, которые связаны на странице. Если флэш-память загружается через JavaScript, вам нужно использовать пользовательский фильтр.

Как найти любые внутренние PDF-файлы

После завершения сканирования в Screaming Frog отфильтруйте результаты на вкладке Internal по PDF.

Как понять сегментацию контента внутри сайта или группы страниц

Если вы хотите найти на своем сайте страницы с определенным типом контента, установите специальный фильтр для HTML-кода, уникального для этой страницы. Это следует сделать перед запуском screaming frog.

Как найти страницы с кнопками социальных сетей

Чтобы найти страницы, содержащие кнопки социальных сетей, вам нужно установить собственный фильтр перед запуском. Чтобы установить пользовательский фильтр, перейдите в меню Configuration и нажмите Custom. Оттуда введите любой фрагмент кода из исходного кода страницы.

В приведенном выше примере фильтр для facebook.com/plugins/like.php.

Как найти страницы, которые используют iframes

Чтобы найти страницы, которые используют iframe, установите пользовательский фильтр для < iframe перед запуском.

Как найти страницы, которые содержат встроенный видео или аудио контент

Чтобы найти страницы, содержащие встроенное видео или аудиоконтент, установите специальный фильтр для фрагмента кода встраивания для Youtube или любого другого медиаплеера, используемого на сайте.

Метаданные и директивы

Как идентифицировать страницы с длинными заголовками страниц, метаописаниями или URL-адресами

После завершения сканирования, перейдите на вкладку Page Titles и отфильтруйте по Over 65 Characters, чтобы увидеть слишком длинные заголовки страниц. Вы можете сделать то же самое на вкладке Meta Description или на вкладке URI.

Как найти повторяющиеся заголовки страниц, метаописания или URL

После того, как SEO Spider закончил сканировать, перейдите на вкладку Page Titles, затем выберите Duplicate. Вы можете сделать то же самое на вкладках Meta Description или URI.

Как найти дублированный контент или URL-адреса, которые необходимо переписать / перенаправить / канонизировать

После того, как SEO Spider завершил сканирование, перейдите на вкладку URI, затем отфильтруйте по Underscores, Uppercase или Non ASCII Characters, чтобы просмотреть URL, которые потенциально могут быть переписаны в более стандартную структуру. Выберите Duplicate, и вы увидите все страницы с несколькими версиями URL. Отфильтруйте по Parameters, и вы увидите URL-адреса, содержащие параметры.

Кроме того, если вы перейдете на вкладку Internal, отфильтруете по HTML и прокрутите столбец Hash в крайнем правом углу, вы увидите уникальные серии букв и цифр для каждой страницы. Если вы нажмете Export, вы можете использовать условное форматирование в Excel, чтобы выделить дублирующиеся значения в этом столбце, в конечном счёте, будут вам показаны страницы, которые идентичны и требуют решения.

Как определить все страницы, содержащие мета-директивы, например: nofollow / noindex / noodp / canonical и т. д.

После того, как SEO Spider закончил проверку, нажмите на вкладку Directives. Чтобы увидеть тип директивы, просто прокрутите вправо, чтобы увидеть, какие столбцы заполнены, или используйте фильтр, чтобы найти любой из следующих тегов:

- index;

- noindex;

- follow;

- nofollow;

- noarchive;

- nosnippet;

- noodp;

- noydir;

- noimageindex;

- notranslate;

- unavailable_after;

- refresh.

Как проверить корректность работы файла robots.txt

По умолчанию Screaming Frog будет выполнять требования robots.txt. В качестве приоритета он будет следовать директивам, сделанным специально для пользовательского агента (user agent) Screaming Frog. Если для пользовательского агента (user-agent) Screaming Frog нет никаких директив, то SEO Spider будет следовать любым директивам для робота Googlebot, а если нет специальных директив для робота Googlebot, он будет следовать глобальным директивам для всех пользовательских агентов.

SEO Spider будет следовать только одному набору директив, поэтому, если существуют правила, установленные специально для Screaming Frog, он будет следовать только этим правилам, а не правилам для робота Google или каких-либо глобальных правил. Если вы хотите заблокировать определенные части сайта от SEO Spider, используйте обычный синтаксис robots.txt с пользовательским агентом Screaming Frog SEO Spider. Если вы хотите игнорировать robots.txt, просто выберите эту опцию в настройках Spider Configuration.

Configuration > Robots.txt > Settings

Как найти или проверить разметку схемы или другие микроданные на моем сайте

Чтобы найти каждую страницу, содержащую разметку схемы или любые другие микроданные, вам нужно использовать пользовательские фильтры. Просто нажмите Custom → Search в меню конфигурации и введите нужный элемент footprint.

Чтобы найти каждую страницу, содержащую разметку схемы, просто добавьте следующий фрагмент кода в пользовательский фильтр: itemtype = http://schema.org

Чтобы найти конкретный тип разметки, вам нужно быть более конкретным. Например, с помощью пользовательского фильтра для ‹span itemprop = ratingValue› вы получите все страницы, содержащие разметку схемы для оценок.

Начиная с Screaming Frog 11.0, Spider SEO также предлагает нам возможность сканировать, извлекать и проверять структурированные данные непосредственно из сканирования. Проверяйте любые структурированные данные JSON-LD, Microdata или RDFa в соответствии с рекомендациями Schema.org и спецификациями Google в режиме реального времени во время сканирования. Чтобы получить доступ к инструментам проверки структурированных данных, выберите параметры в Config > Spider > Advanced.

Теперь в главном интерфейсе есть вкладка Structured Data, которая позволит вам переключаться между страницами, которые содержат структурированные данные, и которые могут иметь ошибки или предупреждения проверки:

Вы также можете выполнить массовый экспорт проблем со структурированными данными, посетив Reports> Structured Data > Validation Errors & Warnings.

Карта сайта

Как создать XML Sitemap

После того, как SEO Spider завершит сканирование вашего сайта, нажмите меню Siteamps и выберите XML Sitemap.

Открыв настройки конфигурации XML-карты сайта, вы можете включать или исключать страницы по коду ответов, последним изменениям, приоритетам, частоте изменений, изображениям и т. Д. По умолчанию Screaming Frog включает только 2xx URL-адресов, но это правило можно исправить.

В идеале, ваша карта сайта XML должна содержать только 200 статусных, единичных, предпочтительных (канонических) версий каждого URL-адреса, без параметров или других дублирующих факторов. После внесения любых изменений нажмите ОК. Файл XML-файла сайта будет загружен на ваше устройство и позволит вам редактировать соглашение об именах по вашему усмотрению.

Создание XML-файла Sitemap путем загрузки URL-адресов

Вы также можете создать карту сайта XML, загрузив URL-адреса из существующего файла или вставив вручную в Screaming Frog.

Измените Mode с Spider на List и нажмите на выпадающий список Upload, чтобы выбрать любой из вариантов.

Нажмите кнопку Start и Screaming Frog будет сканировать загруженные URL-адреса. После сканирования URL вы будете следовать тому же процессу, который указан выше.

Как проверить мой существующий XML Sitemap

Вы можете легко загрузить существующую XML-карту сайта или индекс карты сайта, чтобы проверить наличие ошибок или несоответствий при сканировании.

Перейдите в меню Mode в Screaming Frog и выберите List. Затем нажмите Upload в верхней части экрана, выберите Download Sitemap или Download Sitemap Index, введите URL-адрес карты сайта и начните сканирование. Как только SEO Spider закончит сканирование, вы сможете найти любые перенаправления, 404 ошибки, дублированные URL-адреса и многое другое. Вы можете легко экспортировать и выявленные ошибки.

Определение отсутствующих страниц в XML Sitemap

Вы можете настроить параметры сканирования, чтобы обнаруживать и сравнивать URL-адреса в ваших XML-файлах сайта с URL-адресами в пределах вашего сайта.

Перейдите в Configuration -> Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле. *Important note – если ваш файл robots.txt не содержит правильных целевых ссылок на все XML-карты сайта, которые вы хотите сканировать, вы должны ввести их вручную.

После обновления настроек сканирования XML-файла Sitemap перейдите к пункту Crawl Analysis в навигации, затем нажмите Configure и убедитесь, что кнопка Sitemaps отмечена. Сначала запустите полное сканирование сайта, затем вернитесь к Crawl Analysis и нажмите Start.

После завершения анализа сканирования вы сможете увидеть любые расхождения при сканировании, такие как URL-адреса, обнаруженные в рамках полного сканирования сайта, которые отсутствуют в карте сайта XML.

Общие проблемы

Как определить, почему определенные разделы сайта не индексируются или не ранжируются

Хотите знать, почему некоторые страницы не индексируются? Во-первых, убедитесь, что они не были случайно помещены в файл robots.txt или помечены как noindex. Затем вы должны убедиться, что SEO Spider может добраться до страниц, проверив ваши внутренние ссылки. Страницу, которая не имеет внутренних ссылок на вашем сайте, часто называют «сиротами» (Orphaned Page).

Чтобы выявить потерянные страницы, выполните следующие действия:

Перейдите в Configuration -> Spider в главной навигации, и внизу есть несколько опций для XML-карт сайтов – Auto discover XML sitemaps через ваш файл robots.txt или вручную введите ссылку XML-карты сайта в поле. *Important note – если ваш файл robots.txt не содержит правильных целевых ссылок на все XML-карты сайта, которые вы хотите сканировать, вы должны ввести их вручную.

Перейдите в Configuration → API Access → Google Analytics – используя API, вы можете получить аналитические данные для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы из органического поиска, убедитесь, что они разделены на органический трафик.

Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Analytics, если вы хотите, чтобы URL-адреса, обнаруженные в GA, были включены в ваш полный обход сайта. Если это не включено, вы сможете просматривать только новые URL-адреса, извлеченные из GA, в отчете Orphaned Pages.

Перейдите в Configuration → API Access → Google Search Console – используя API, вы можете получить данные GSC для конкретной учетной записи и просмотра. Чтобы найти бесхозные страницы, вы можете искать URL-адреса, на которых получены клики и показы, которые не включены в ваш просмотр. Вы также можете перейти к разделу General → Crawl New URLs Discovered In Google Search Console, если вы хотите, чтобы URL-адреса, обнаруженные в GSC, были включены в ваш полный обход сайта. Если этот параметр не включен, вы сможете просматривать только новые URL-адреса, извлеченные из GSC, в отчете Orphaned Pages.

Просканируйте весь сайт. После завершения сканирования перейдите в Crawl Analysis -> Start и дождитесь его завершения.

Просмотрите потерянные URL-адреса на каждой из вкладок или выполните Bulk Expor всех потерянных URL-адресов, перейдя в Reports → Orphan Pages.

Если у вас нет доступа к Google Analytics или GSC, вы можете экспортировать список внутренних URL-адресов в виде файла .CSV, используя фильтр HTML на вкладке Internal.

Откройте файл CSV и на втором листе вставьте список URL-адресов, которые не индексируются или плохо ранжируются. Используйте VLOOKUP, чтобы увидеть, были ли URL-адреса в вашем списке на втором листе найдены при сканировании.

Как найти медленные страницы на моем сайте

После того, как SEO Spider завершил сканирование, перейдите на вкладку Response Codes и отсортируйте по столбцу Response Time по возрастанию, чтобы найти страницы, которые могут страдать от медленной скорости загрузки.

Как найти вредоносное ПО или спам на моем сайте

Во-первых, вам необходимо идентифицировать след вредоносного ПО или спама. Далее в меню Configuration нажмите Custom → Search и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных фильтров для сканирования. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц.

Когда SEO Spider завершит сканирование, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

PPC и аналитика

Как проверить список URL-адресов PPC навалом

Сохраните список в формате .txt или .csv, затем измените настройки Mode на List.

Затем выберите файл для загрузки и нажмите Start или вставьте свой список вручную в Screaming Frog. Посмотрите код состояния каждой страницы, перейдя на вкладку Internal.

Зачистка

Как очистить метаданные для списка страниц

Итак, вы собрали множество URL, но вам нужна дополнительная информация о них? Установите режим List, затем загрузите список URL-адресов в формате .txt или .csv. После того, как SEO Spider будет готов, вы сможете увидеть код состояния, исходящие ссылки, количество слов и, конечно же, метаданные для каждой страницы в вашем списке.

Как очистить сайт для всех страниц, которые содержат определенный размер?

Во-первых, вам нужно определить след. Затем в меню Configuration нажмите Custom → Search или Extraction и введите искомый элемент, который вы ищете.

Вы можете ввести до 10 различных следов на сканирование. Наконец, нажмите OK и продолжайте сканирование сайта или списка страниц. В приведенном ниже примере я хотел найти все страницы с надписью УСЛУГИ в разделе цен, поэтому я нашел и скопировал HTML-код из исходного кода страницы.

Когда SEO Spider завершит проверку, выберите вкладку Custom в верхнем окне, чтобы просмотреть все страницы, содержащие ваш отпечаток. Если вы ввели более одного пользовательского фильтра, вы можете просмотреть каждый, изменив фильтр по результатам.

Ниже приведены некоторые дополнительные общие следы, которые вы можете почерпнуть с веб-сайтов, которые могут быть полезны для ваших аудитов SEO:

- http://schema.org – найти страницы, содержащие schema.org;

- youtube.com/embed/|youtu.be|<video|player.vimeo.com/video/|wistia.(com|net)/embed|sproutvideo.com/embed/|view.vzaar.com|dailymotion.com/ embed / | Players.brightcove.net/ | play.vidyard.com/ | kaltura.com/ (p | kwidget) / – найти страницы, содержащие видеоконтент.

Совет: Если вы извлекаете данные о продукте с клиентского сайта, вы можете сэкономить некоторое время, попросив клиента извлечь их непосредственно из его базы данных. Описанный выше метод предназначен для сайтов, к которым у вас нет прямого доступа.

Перезапись URL

Как найти и удалить идентификатор сеанса или другие параметры из моих просканированных URL

Чтобы идентифицировать URL с идентификаторами сеансов или другими параметрами, просто просмотрите ваш сайт с настройками по умолчанию. Когда SEO Spider закончил анализировать, нажмите на вкладку URI и выберите Parameters, чтобы просмотреть все URL-адреса, содержащие параметры.

Чтобы удалить параметры, отображаемые для просматриваемых URL-адресов, выберите URL Rewriting в меню конфигурации, затем на вкладке Remove Parameters нажмите Add, чтобы добавить все параметры, которые вы хотите удалить из URL-адресов, и нажмите OK. Вам придется снова запустить Screaming Frog с этими настройками, чтобы произошла перезапись.

Как переписать просканированные URL-адреса (например, заменить .com на .co.uk или написать все URL-адреса строчными буквами)

Чтобы переписать любой URL, который вы сканируете, выберите URL Rewriting в меню Configuration, затем на вкладке Regex Replace нажмите Add, чтобы добавить RegEx для того, что вы хотите заменить.

После того, как вы добавили все нужные правила, вы можете проверить их на вкладке Test, введя тестовый URL в поле URL before rewriting. URL after rewriting будет автоматически обновляться в соответствии с вашими правилами.

Если вы хотите установить правило, согласно которому все URL-адреса возвращаются в нижнем регистре, просто выберите Lowercase discovered URLs на вкладке Options. Это удалит любое дублирование URL-адресами с заглавными буквами при сканировании.

Помните, что вам придется запустить SEO Spider с этими настройками, чтобы перезапись URL произошла.

Исследование ключевых слов

Как узнать, какие страницы мои конкуренты ценят больше всего

Конкуренты будут пытаться распространить популярность ссылок и привлечь трафик на свои наиболее ценные страницы, ссылаясь на них внутри. Любой SEO-ориентированный конкурент, вероятно, также будет ссылаться на важные страницы из блога своей компании. Найдите ценные страницы вашего конкурента, просканировав их сайт, а за тем отсортировав вкладку Internal по столбцу Inlinks по возрастанию, чтобы увидеть, какие страницы имеют больше внутренних ссылок.

Чтобы просмотреть страницы, ссылки на которые есть в блоге вашего конкурента, отмените выбор Check links outside folder в меню Spider Configuration и просмотрите папку / поддомен блога. Затем на вкладке External отфильтруйте результаты с помощью поиска по URL основного домена. Прокрутите до крайнего правого края и отсортируйте список по столбцу Inlinks, чтобы увидеть, какие страницы связаны чаще всего.

Совет: Перетащите столбцы влево или вправо, чтобы улучшить просмотр данных.

Как узнать, какой якорный текст используют мои конкуренты для внутренних ссылок

В меню Bulk Export выберите All Anchor Text, чтобы экспортировать CSV-файл, содержащий весь текст привязки на сайте, где он используется и с чем он связан.

Как узнать, какие метатеги keywords (если они есть) конкуренты добавили на свои страницы

После того, как SEO Spider закончил сканировать, посмотрите на вкладку Meta Keywords, чтобы увидеть их, найденные для каждой страницы. Сортируйте по столбцу Meta Keyword 1, чтобы расположить алфавитный список и визуально отделить пустые записи или просто экспортировать весь список.

Создание ссылок

Как проанализировать список предполагаемых ссылок

Если вы создали список URL-адресов, которые необходимо проверить, вы можете загрузить и отсканировать их в режиме List, чтобы собрать больше информации о страницах. После завершения сканирования, проверьте коды состояния на вкладке Response Codes и просмотрите исходящие ссылки, типы ссылок, текст привязки и директивы nofollow на вкладке Outlinks в нижнем окне. Это даст вам представление о том, на какие сайты ссылаются эти страницы и как. Чтобы просмотреть вкладку Outlinks, убедитесь, что в верхнем окне выбран интересующий вас URL.

Конечно, вы захотите использовать пользовательский фильтр, чтобы определить, ссылаются ли эти страницы уже на вас.

Вы также можете экспортировать полный список выходных ссылок, нажав All Outlinks в Bulk Export Menu. Это не только предоставит вам ссылки на внешние сайты, но также покажет все внутренние ссылки на отдельных страницах вашего списка.

Как найти неработающие ссылки для расширения возможностей

Итак, вы нашли сайт, с которого хотите получить ссылку? Используйте Screaming Frog, чтобы найти неработающие ссылки на нужной странице или на сайте в целом, затем обратитесь к владельцу сайта, предложив свой сайт в качестве замены неработающей ссылки, где это применимо, или просто укажите на неработающую ссылку в качестве знака доброй воли.

Как проверить мои обратные ссылки и просмотреть текст привязки

Загрузите свой список обратных ссылок и запустите SEO Spider в режиме List. Затем экспортируйте полный список исходящих ссылок, нажав All Out Links в Advanced Export Menu. Это предоставит вам URL-адреса и анкорный текст / текст alt для всех ссылок на этих страницах. Затем вы можете использовать фильтр в столбце Destination CSV, чтобы определить, связан ли ваш сайт и какой текст привязки / текст alt включен.

Как убедиться, что ссылки удаляются по запросу в процессе очистки

Установите пользовательский фильтр, содержащий URL-адрес вашего корневого домена, затем загрузите список обратных ссылок и запустите SEO Spider в режиме List. Когда SEO Spider завершит сканирование, выберите вкладку Custom, чтобы просмотреть все страницы, которые все еще ссылаются на вас.

Дополнительная информация

Знаете ли вы, что, щелкнув правой кнопкой мыши по любому URL в верхнем окне ваших результатов, вы можете выполнить любое из следующих действий?

- Скопировать или открыть URL;

- Повторно сканировать URL или удалить его из своего сканирования;

- Экспортировать информацию об URL, в ссылках, выходных ссылках или информации об изображении для этой страницы

- Проверить индексацию страницы в Google;

- Проверить обратные ссылки на страницу в Majestic, OSE, Ahrefs и Blekko.

- Посмотреть на кэшированную версию / дату кеша страницы;

- Смотреть старые версии страницы;

- Проверить HTML-код страницы

- Открыть robots.txt для домена, на котором находится страница;

- Поиск других доменов на том же IP.

Аналогично, в нижнем окне, щелкнув правой кнопкой мыши, вы можете скопировать или открыть URL-адрес в столбце To для From выбранной строки.

Как редактировать метаданные

Режим SERP позволяет вам просматривать фрагменты SERP на устройстве, чтобы визуально показать, как ваши метаданные будут отображаться в результатах поиска.

-

Загрузите URL, заголовки и метаописания в Screaming Frog, используя документ .CSV или Excel.

Если вы уже провели сканирование своего сайта, то можете экспортировать URL-адреса, перейдя в Reports → SERP Summary. Это легко отформатирует URL и мета, которые вы хотите загрузить и отредактировать.

- Mode → SERP → Upload File.

- Редактируйте метаданные в Screaming Frog.

Массовый экспорт обновленных метаданных для отправки напрямую разработчикам для обновления.

Как сканировать JavaScript-сайта

Все чаще веб-сайты создаются с использованием таких JavaScript-фреймворков, как Angular, React и т. д. Google настоятельно рекомендует использовать решение для рендеринга, поскольку робот Googlebot все еще пытается сканировать содержимое JavaScript. Если вы определили сайт, созданный с использованием JavaScript, следуйте приведенным ниже инструкциям, чтобы сканировать сайт.

Configuration → Spider → Rendering → JavaScript

Измените настройки рендеринга в зависимости от того, что вы ищете. Вы можете настроить время ожидания, размер окна (мобильный, планшет, рабочий стол и т. д.)

Нажмите OK и сканируйте веб-сайт.

В нижней части навигации щелкните вкладку Rendered Page, чтобы увидеть, как страница отображается. Если ваша страница не отображается должным образом, проверьте наличие заблокированных ресурсов или увеличьте лимит времени ожидания в настройках конфигурации. Если ни один из вариантов не поможет решить, как ваша страница отображается, возможно, возникнет более серьезная проблема.

Вы можете просмотреть и массово экспортировать любые заблокированные ресурсы, которые могут повлиять на сканирование и визуализацию вашего сайта, перейдя в Bulk Export → Response Codes.

Просмотр оригинального HTML и визуализированного HTML

Если вы хотите сравнить необработанный HTML и визуализированный HTML, чтобы выявить какие-либо несоответствия или убедиться, что важный контент находится в DOM, перейдите в Configuration → Spider -> Advanced и нажмите hit store HTML и store rendered HTML.

В нижнем окне вы сможете увидеть необработанный и визуализированный HTML. Это может помочь выявить проблемы с тем, как ваш контент отображается и просматривается сканерами.

В заключение

Мы надеемся, что это руководство даст вам лучшее представление о том, какие возможности вам доступны в Screaming Frog, а также поможет сэкономить часы работы.

Оригинал статьи взят с сайта Elit-Web

За последние 24 часа нас посетили 10064 программиста и 1019 роботов. Сейчас ищут 540 программистов …

-

- С нами с:

- 9 сен 2016

- Сообщения:

- 26

- Симпатии:

- 3

Вводные данные.

Есть архив номеров журнала. Данные представляют собой исходный PDF, откомпилированные PDF страницы вёрстки в SFW-формате и разметки XML для поиска. На том же SWF есть форма поиска, данные запрашиваются из соответствующего индекса, скомпилированного из PDF в XML.

Для наглядности — рассматриваю конкретный пример с сайта http://ogni-sochi.ru/archs.php

При нажатии на конкретный выпуск открываются SWF-страницы. В форме поиска запрос осуществляется к индекс-XML, имеющий разметку статья-страница журнала.

Выглядит searchtext.xml подобным образом:-

<?xml version=«1.0» encoding=«utf-8» ?>

-

<Page Number=«1»>1 огни сочи большого для всех 78 (76) июль август 2016 рубрика константин затулин: сочи нужна отдельная строка в федеральном бюджете 7 8 (76) июль август 20 16 журнал для тех, кто любит наш город к ипотечным сделкам с через партнерские каналы продаж единство наций с сила россии. 30 июля с день дружбы все хоры в гости к нам! лидер предпринимательства сочи 2016 спецпроект константин затулин: сочи нужна отдельная строка в федеральном бюджете

-

<Page Number=«2»>2 78 (76) июль август 2016 огни сочи большого для всех рубрика отель «жасмин» – отдых в удовольствие! отдых абхазия агурское ущелье аквапарк лоо сплав по реке «33 водопада» вечерний сочи красная поляна мацестинский чай змейковские водопады изумрудная долина «в гостях у пасечника» женский монастырь дельфинарий дача сталина дерево дружбы обезьяний питомник в гостях у шапсугов воронцовские пещеры экскурсии трансфер (10 комфортабельных автобусов) комбинированные экскурсии перевозки рабочего персонала наш транспорт ооо «виктория» сочи, пос. кудепста, сухумское шоссе, 50/2, тел. 8-918-101-80-01, 8-800-222-70-80 (бесплатный звонок) www.viktoriasochi.ru e-mail: tcakunova@yandex.ru

-

<Page Number=«NN»>NN www.ogni-sochi.ru 78 (76) июль — август 2016 огни сочи большого для всех рубрика

Имеются файлы (как понимаю) с данными о вхождениях слов для каждой страницы search1.xml … searchNN.xml

Пример:

search2.xml

…

абхазия:729:2835:0:127:65;125;172;231;285;345;400

агурское:729:2984:0:127:65;108;158;220;273;329;387;446

ущелье:1195:2984:0:127:50;135;193;249;303;361

…Возникла необходимость организовать аналогичный поиск, только уже среди всех загруженных на сайт выпусков журнала.

Т.е. искать будем не в одном searchtext.xml, а во всех. В общем виде структура такова:- Адрес_сайта.ru/Архив_номеров/Номер_001/searchtext.xml

- … (Структура 1)

- Адрес_сайта.ru/Архив_номеров/Номер_NNN/searchtext.xml

Вопрос и мысли к решению, но пока не давшие ответа.

1. Ставим в любое место на сайте форму ввода запроса на поиск — тут всё понятно.

2. По нажатию кнопки «ОК» отправляем строку запроса обработчику search.php.

3. Этот search.php проверят введенную строку, режет лишние знаки «пробел», приводит буквы к строчным и т.д.

4. Сам поиск. (Тут у меня и начинаются вопросы)…

Где искать? В Структуре 1, описанной выше?

Или всё-таки необходимо при выпуске каждого очередного номера, пополнять Индекс-индексов, в котором будет храниться сбор из ~NN/searchtext.xml с дополнительным тегом, сообщающем о NN-номере издания?

5. Что искать?

Я понимаю как в файле строковыми функциями найти первое вхождение субстроки в строку, но как быть с последовательностью слов — остается «белое пятно». В особенности касается семантики с использованием регулярных выражений.

Если запрос будет, например, «Марию Иванову назначили директором», то регулярное выражение + строковая функция должны порезать фразу на массив из нескольких слов с неопределенными окончаниями? — Верно ли понимаю, что искаться будет каждое слово по-отдельности, но не фраза? Либо фраза, но при полном соответствии субстроки из всего текста индекс-документа строке запроса? Разумеется все символы верхнего регистра и там, и там приведены к строчным.