Как обнаружить дубли страниц на сайте

Дубли — это страницы сайта с одинаковым или практически полностью совпадающим контентом. Наличие таких страниц может негативно сказаться на взаимодействии сайта с поисковой системой.

Чем вредны дубли?

Негативные последствия от дублей могут быть такими:

- Замедление индексирования нужных страниц. Если на сайте много одинаковых страниц, робот будет посещать их все отдельно друг от друга. Это может повлиять на скорость обхода нужных страниц, ведь потребуется больше времени, чтобы посетить именно нужные страницы.

- Затруднение интерпретации данных веб-аналитики. Страница из группы дублей выбирается поисковой системой автоматически, и этот выбор может меняться. Это значит, что адрес страницы-дубля в поиске может меняться с обновлениями поисковой базы, что может повлиять на страницу в поиске (например, узнаваемость ссылки пользователями) и затруднит сбор статистики.

Если на сайте есть одинаковые страницы, они признаются дублями, и в поиске тогда будет показываться по запросу только одна страница. Но адрес этой страницы в выдаче может меняться по очень большому числу факторов. Данные изменения могут затруднить сбор аналитики и повлиять на поисковую выдачу.

Как могут появиться дубли?

Дубли могут появиться на сайт в результате:

- Автоматической генерации. Например, CMS сайта создает ссылки не только с ЧПУ, но и техническим адресом: https://site.ru/noviy-tovar и https://site.ru/id279382.

- Некорректных настроек. К примеру, при неправильно настроенных относительных ссылках на сайте могут появляться ссылки по адресам, которых физически не существует, и они отдают такой же контент, как и нужные страницы сайта. Или на сайте не настроена отдача HTTP-кода ответа 404 для недоступных страниц — от них приходит «заглушка» с сообщением об ошибке, но они остаются доступными для индексирования.

- Ссылок с незначащими GET-параметрами. Зачастую GET-параметры не добавляют никакого контента на страницу, а используются, к примеру, для подсчета статистики по переходам — из какой-нибудь определенной социальной сети. Такие ссылки тоже могут быть признаны дублями (и недавно мы добавили специальное уведомление для таких ссылок, подробнее посмотреть можно тут).

- Ссылок со слешем на конце и без. Для поисковой системы сайты https://site.ru/page и https://site.ru/pages/ — это разные страницы (исключение составляет только главная страница, между https://site.ru/ и https://site.ru разницы нет).

Как обнаружить дубли

Теперь находить одинаковые страницы стало проще: в разделе «Диагностика» появилось специальное уведомление, которое расскажет про большую долю дублей на вашем сайте. Алерт появляется с небольшой задержкой в 2-3 дня — это обусловлено тем, что на сбор достаточного количества данных и их обработку требуется время. С этим может быть связано появление в нем исправленных страниц. Подписываться на оповещения не нужно, уведомление появится само.

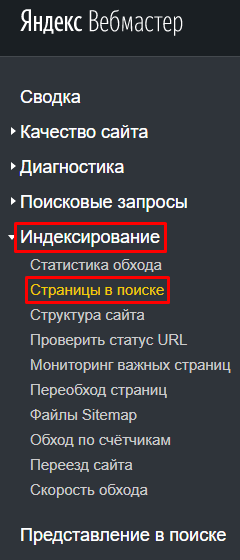

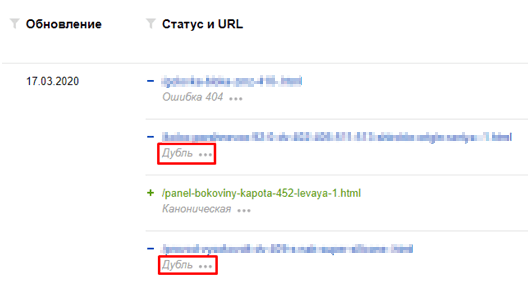

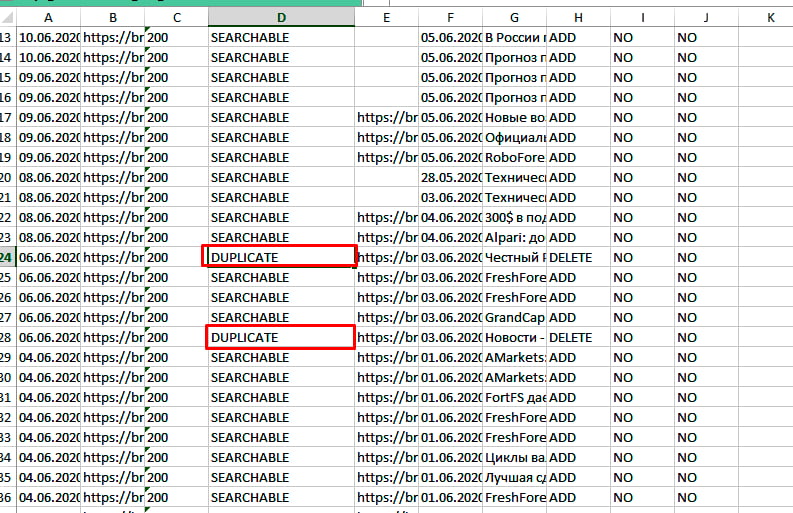

А если вы хотите найти дубли вручную, перейдите в Вебмастер, во вкладке «Индексирование» откройте «Страницы в поиске», нажмите на «Исключённые» в правой части страницы. Прокрутите вниз, в правом нижнем углу вы увидите опцию «Скачать таблицу». Выберите подходящий формат и загрузите архив. Откройте скачанный файл: у страниц-дублей будет статус DUPLICATE.

Обратите внимание, что ссылки на сайте с одинаковым контентом не всегда признаются дублирующими. Это может быть связано с тем, что поисковая система еще не успела проиндексировать дубли, или на момент их индексирования содержимое несколько различалось. Такое бывает, если страницы, к примеру, динамически обновляют часть контента, из-за чего поисковая система каждый раз получает немного разные версии, хотя по факту содержимое очень похоже. Например, когда на странице есть лента похожих товаров, которая постоянно обновляется. Если вы точно знаете, что такие страницы являются дублями, то необходимо оставить в поиске только нужные страницы.

Как оставить в поиске нужную страницу в зависимости от ситуации

В случае с «мусорными» страницами воспользуйтесь одним из способов:

- Добавьте в файл robots.txt директиву Disallow, чтобы запретить индексирование страницы-дубля;

- Если вы не можете ограничить такие ссылки в robots.txt, запретите их индексирование при помощи мета-тега noindex. Тогда поисковой робот сможет исключить страницы из базы по мере их переобхода;

- Если такой возможности нет, можно настроить HTTP-код ответа 403/404/410. Данный метод менее предпочтителен, так как показатели недоступных страниц не будут учитываться, и если где-то на сайте или в поиске еще есть ссылки на такие страницы, пользователь попадет на недоступную ссылку.

В случае со страницами-дублями воспользуйтесь одним из способов:

- Для дублей с незначащими GET-параметрами рекомендуем добавить в файл robots.txt директиву Clean-param. Директива Clean-param — межсекционная. Это означает, что она будет обрабатываться в любом месте файла robots.txt. Указывать ее для роботов Яндекса при помощи User-Agent: Yandex не требуется. Но если вы хотите указать директивы именно для наших роботов, убедитесь, что для User-Agent: Yandex указаны и все остальные директивы — Disallow и Allow. Если в robots.txt будет указана директива User-Agent: Yandex, наш робот будет следовать указаниям только для этой директивы, а User-Agent: * будет проигнорирован;

- Вы можете установить редирект с HTTP-кодом 301 с одной дублирующей страницы на другую. В этом случае в поиске будет участвовать цель установленного редиректа. Укажите предпочитаемый (канонический) адрес страницы, который будет участвовать в поиске;

- Также можно использовать атрибут rel=«canonical». При работе с атрибутом rel=«canonical» стоит учитывать, что если содержимое дублей имеет некоторые отличия или очень часто обновляется, то такие страницы все равно могут попасть в поиск из-за различий в этом содержимом. В этом случае рекомендуем использовать другие предложенные варианты.

Для страниц со слешем на конце и без рекомендуем использовать редирект 301. Можно выбрать в качестве доступной как ссылку со слешем, так и без него — для индексирования разницы никакой нет.

В случае с важными контентыми страницами для их индексирования и представления в поиске важно использовать:

- Файлы Sitemap;

- Метрику;

- Установку счётчика;

- Настройку обхода страниц роботами.

Подробные рекомендации о работе со страницами-дублями читайте в Справке.

P. S. Подписывайтесь на наши каналы

Блог Яндекса для Вебмастеров

Канал Яндекса о продвижении сайтов на YouTube

Канал для владельцев сайтов в Яндекс.Дзен

- Почему дубли страниц — это плохо?

- Как найти дубли страниц?

- Как убрать дубли страниц на сайте?

Почему дубли страниц — это плохо?

Дубли — это страницы с одинаковым содержимым, т.е. они дублируют друг друга.

Причины, по которым страницы дублируются, могут быть разными:

- автоматическая генерация;

- ошибки в структуре сайта;

- некорректная разбивка одного кластера на две страницы и другие.

Дубли страниц — это плохо для продвижения и раскрутки сайта, даже несмотря на то, что они могут появляться по естественным причинам. Дело в том, что поисковые роботы хуже ранжируют страницы, контент которых мало чем отличается от других страниц. И чем больше таких страниц, тем больше сигналов поисковым ботам, что это сайт не достоин быть в топе выдачи.

Что происходит с сайтом, у которого есть дубликаты страниц?

- Снижается его релевантность. Обе страницы с одинаковым контентом пессимизируются в выдаче, теряют позиции и трафик.

- Снижается процент уникальности текстового контента. Из-за этого понизится уникальность всего сайта.

- Снижается вес URL-адресов сайта. По каждому запросу в выдачу поиска попадает только одна страница, а если таких одинаковых страниц несколько, все теряют в весе.

- Увеличивается время на индексацию. Чем больше страниц, тем больше времени нужно боту, чтобы индексировать ваш сайт. Для крупных сайтов проблемы с индексацией могут сильно сказаться на трафике из поиска.

- Бан от поисковых систем. Можно вообще вылететь из выдачи на неопределенный срок.

В общем, становится понятно, что дубли никому не нужны. Давайте разбираться, как найти и обезвредить дублирующиеся страницы на сайте.

Как найти дубли страниц?

Кирилл Бузаков,

SEO-оптимизатор компании SEO.RU:

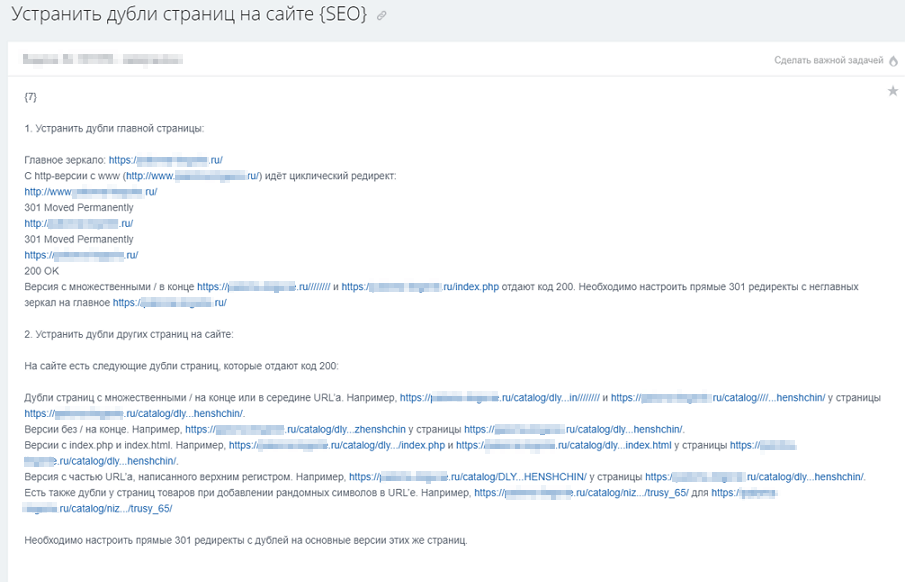

«Когда мы получаем в работу сайт, мы проверяем его на наличие дублей страниц, отдающих код 200. Разберем, какие это могут быть дубли.

Возможные типы дублей страниц на сайте

-

Дубли страниц с протоколами http и https.

Например: https://site.ru и http://site.ru

-

Дубли с www и без.

Например: https://site.ru и https://www.site.ru

-

Дубли со слешем на конце URL и без.

Например: https://site.ru/example/ и https://site.ru/example

-

Дубли с множественными слешами в середине либо в конце URL.

Например: https://site.ru/////////, https://site.ru/////////example/

-

Прописные и строчные буквы на различных уровнях вложенности в URL.

Например: https://site.ru/example/ и https://site.ru/EXAMPLE/

-

Дубли с добавлением на конце URL:

- index.php;

- home.php;

- index.html;

- home.html;

- index.htm;

- home.htm.

Например: https://site.ru/example/ и https://site.ru/example/index.html

-

Дубли с добавлением произвольных символов либо в качестве нового уровня вложенности (в конце или середине URL), либо в существующие уровни вложенности.

Например: https://site.ru/example/saf3qA/, https://site.ru/saf3qA/example/ и https://site.ru/examplesaf3qA/

-

Добавление произвольных цифр в конце URL в качестве нового уровня вложенности.

Например: https://site.ru/example/ и https://site.ru/example/32425/

-

Дубли с добавлением «звездочки» в конце URL.

Например: https://site.ru/example/ и https://site.ru/example/*

-

Дубли с заменой дефиса на нижнее подчеркивание или наоборот.

Например: https://site.ru/defis-ili-nizhnee-podchyorkivanie/ и https://site.ru/defis_ili_nizhnee_podchyorkivanie/

-

Дубли с некорректно указанными уровнями вложенности.

Например: https://site.ru/category/example/ и https://site.ru/example/category/

-

Дубли с отсутствующими уровнями вложенности.

Например: https://site.ru/category/example/ и https://site.ru/example/

Как обнаружить дубли страниц?

Поиск дублей страниц можно произвести разными способами. Если вы хотите собрать все-все дубли и ничего не упустить, лучше использовать все нижеперечисленные сервисы совместно. Но для поиска основных достаточно какого-то одного инструмента, выбирайте, какой вам ближе и удобнее.

-

Парсинг сайта в специализированной программе

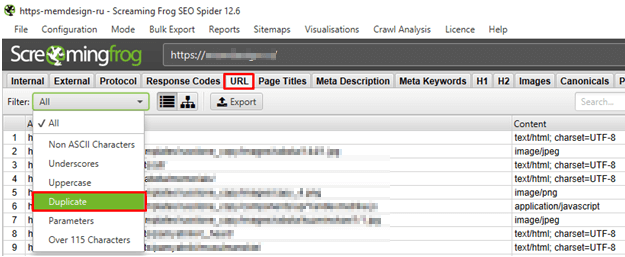

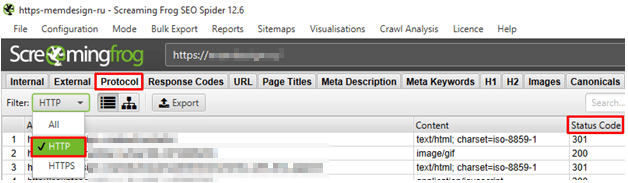

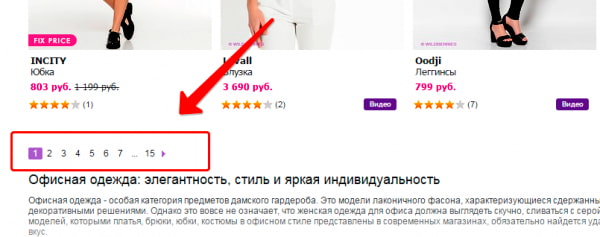

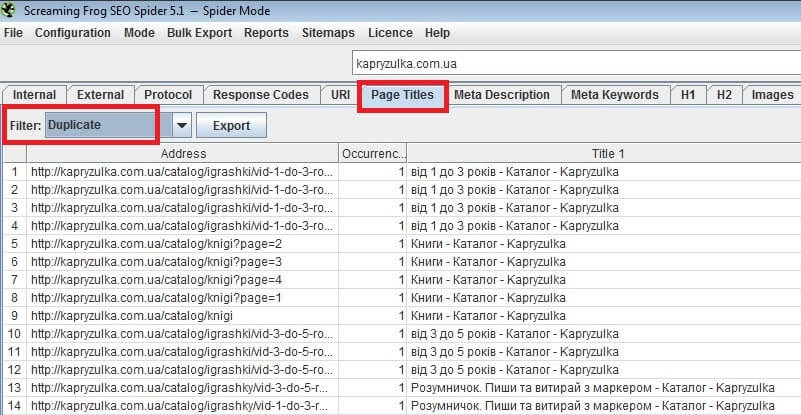

Для поиска дубликатов подходит программа Screaming Frog SEO Spider. Запускаем сканирование, а после него проверяем дубли в директории URL → Duplicate:

Кроме того, в директории Protocol → HTTP проверяем страницы с протоколом http — есть ли среди них те, у которых Status Code равен 200:

-

Онлайн-сервисы.

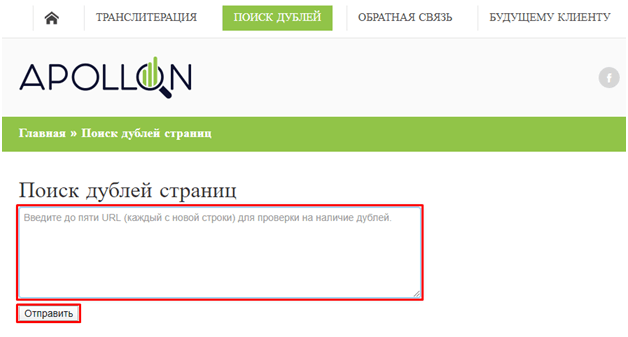

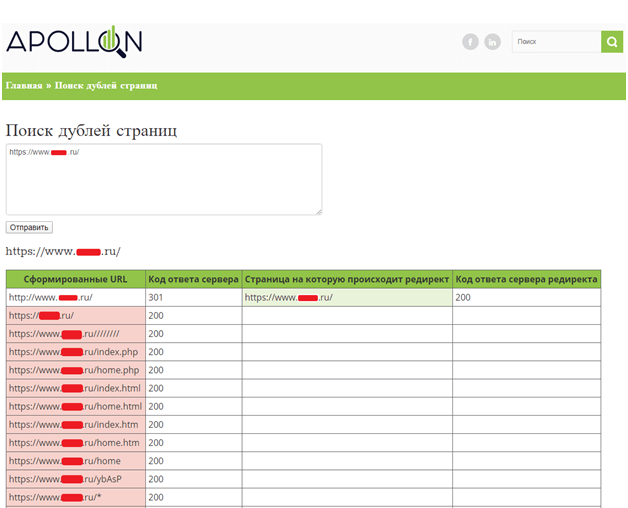

Первый, подходящий нашим целям сервис, — это ApollonGuru.

- Выбираем 5-7 типовых страниц сайта. Например, набор может быть таким: главная, разводящая, карточка товара/страница услуги, статья в блоге, а также другие важные страницы в зависимости от типа сайта.

- Вносим их в поле «Поиск дублей страниц» и нажимаем кнопку «Отправить»:

- Дубли с 200 кодом ответа сервера (смотрим столбец «Код ответа сервера») берем в работу:

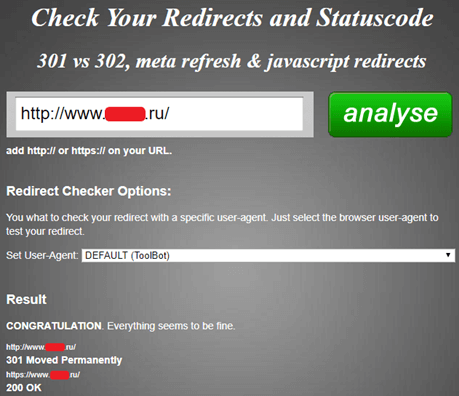

Кроме того, необходимо проверять, что с дублей настроены прямые 301 редиректы на основные версии этих же страниц.

Также проверка дублей сайта возможна онлайн-сервисом Check Your Redirects and Statuscode, но он подходит только в том случае, если нужно проанализировать один URL-адрес:

-

Панели веб-мастеров Яндекса и Google.

Найти дублирующиеся страницы можно с помощью собственных инструментов поисковиков — Яндекс.Вебмастера и Google Search Console.

В Яндекс.Вебмастере анализируем раздел «Индексирование», далее — «Страницы в поиске»:

Там можно увидеть текущую индексацию сайта и искомые дубли страниц:

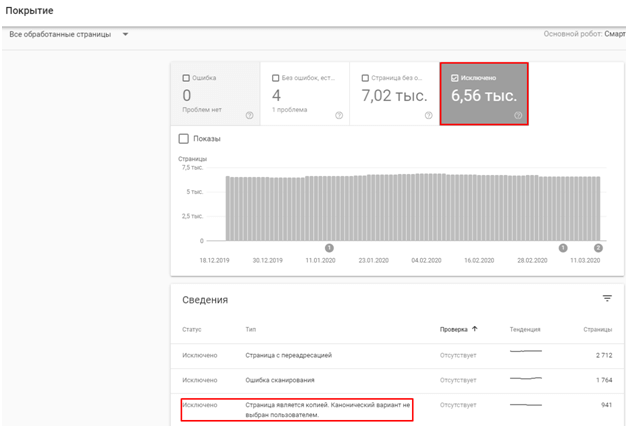

В Search Console анализируем раздел «Покрытие», а именно пункт с исключенными из индекса страницами:

Собираем все дубли в одну таблицу или документ. Затем отправляем их в работу программисту:

Старайтесь подробнее объяснить программисту задачу, так как адресов может быть много».

Как убрать дубли страниц на сайте?

Евгений Костырев,

веб-программист компании SEO.RU:

«С дублирующимися страницами бороться можно разными способами. Если есть возможность, стоит использовать ручной метод. Но такая возможность есть не всегда, потому что здесь нужны серьезные навыки программирования: как минимум, нужно хорошо разбираться в особенностях CMS своего сайта.

Другие же методы не требуют специализированных знаний и тоже могут дать хороший результат. Давайте разберем их.

301 редирект

301 редирект — это самый надежный способ избавления от дублей, но при этом самый требовательный к профессиональным навыкам программиста.

Как это работает: если сайт использует сервер Apache, то нужные правила в файле .htaccess с помощью регулярных выражений.

Самый простой вариант 301 редиректа с одной страницы на другую:

Redirect 301 /test-1/ http://site.ru/test-2/

Устанавливаем 301 редирект со страницы с www на страницу без www (главное зеркало — домен без www):

RewriteCond %{HTTP_HOST} ^www.(.*)$

RewriteRule^(.*)$ http://%1/$1 [L,R=301]

Организуем редирект с протокола http на https:

RewriteCond %{HTTPS} !=on

RewriteRule^(.*)$ https://%{HTTP_HOST}/$1 [R=301,L]

Прописываем 301 редирект для index.php, index.html или index.htm (например, в Joomla), массовая склейка:

RewriteCond %{THE_REQUEST} ^[A-Z]{3,9} /index.(php|html|htm) HTTP/

RewriteRule^(.*)index.(php|html|htm)$ http://site.ru/$1 [R=301,L]

Если же сайт использует Nginx, то правила прописываются в файле nginx.conf. Для перенаправления также нужно прописывать правила с помощью регулярных выражений, например:

location = /index.html {

return 301 https://site.com

}

Вместо index.html можно указать любой другой URL-адрес страницы вашего сайта, с которого нужно сделать редирект.

На этом этапе важно следить за корректностью новой части кода: если в ней будут ошибки, исчезнут не только дубли, но и вообще весь сайт из всего интернета.

Создание канонической страницы

Использование canonical указывает поисковому пауку на ту единственную страницу, которая является оригинальной и должна быть в поисковой выдаче.

Чтобы выделить такую страницу, нужно на всех URL дублей прописать код с адресом оригинальной страницы:

<link rel= “canonical” href= «http://www.site.ru/original-page.html”>

Можно прописывать их вручную, но это займет много времени, поэтому есть смысл использовать плагины. Например, в WordPress это YoastSEO или AllinOneSEOPack.

В 1С-Битрикс это делается с помощью языка программирования PHP в соответствующих файлах. Такая же история и с CMS Joomla: без вмешательства программиста или собственных навыков программирования здесь не обойтись.

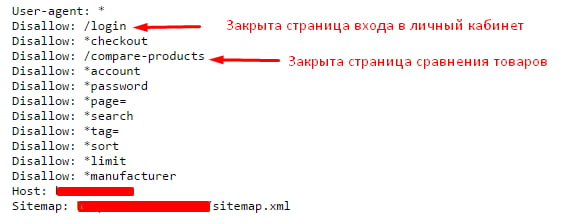

Директива Disallow в robots.txt

В файле robots.txt содержатся инструкции для поисковых краулеров, как именно индексировать сайт.

Читать по теме: Как правильно заполнить файл robots.txt: критически важные моменты

Если на сайте есть дубли, можно запретить краулеру их индексировать с помощью директивы:

User-agent: *

Disallow: site.ru/contacts.php?work=225&s=1

Такой способ практически не требует навыков программиста, однако он не подходит, если дублей много: очень много времени уйдет на изменение robots.txt каждого дубля».

Выбирайте способ, исходя из собственных навыков программирования и личных предпочтений, и не давайте поисковикам повод сомневаться в релевантности и качестве вашего сайта.

В статье про технический аудит сайта мы упомянули, что среди прочего SEO-специалисту важно проверить, а есть ли дубли страниц на продвигаемом им веб-ресурсе. И если они найдутся, то нужно немедленно устранить проблему. Однако там в рамках большого обзора я не хотел обрушивать на голову читателя кучу разнообразной информации, поэтому о том, что такое дубликаты страниц сайта, как их находить и удалять, мы вместе с вами детальнее рассмотрим здесь.

Почему и как дубли страниц мешают поисковому продвижению

Для начала отвечу на вопрос «Как?». Дубликаты страниц сильно затрудняют SEO, т. к. поисковые системы не могут понять, какую из веб-страниц им нужно показывать в выдаче по релевантным запросам. Поэтому чаще всего, чтобы не путаться, они понижают сайт в ранжировании или даже банят его, если проблема имеет массовый характер. После этого должно быть понятно, насколько важно сразу проверить продвигаемый ресурс на дубликаты.

Теперь давайте посмотрим, почему так получается, что дубли создают проблему? Для этого рассмотрим такой простой пример. Взгляните на следующее изображение и определите, какой из овощей наиболее точно соответствует запросу «спелый помидор»?

Хотя овощи немного отличаются размером, но все три из них подходят под категорию «спелого помидора». Поэтому сделать выбор в пользу одно из них довольно сложно.

Такая же дилемма встает перед поисковыми алгоритмами, когда они видят на сайте несколько одинаковых (полных) или почти одинаковых (частичных) копий одной и той же страницы.

Как наличие дублей сказывается на продвижении:

- Чаще всего падает релевантность основной продвигаемой страницы и, соответственно, снижаются позиции по используемым ключевым словам.

- Также могут «прыгать» позиции по ключам из-за того, что поисковик будет менять страницу для показа в поисковой выдаче.

- Если проблема не ограничивается несколькими урлами, а распространяется на весь сайт, то в таком случае Яндекс и Google могут наказать неприятным фильтром.

Понимая теперь, насколько серьезными могут быть последствия, рассмотрим виды дубликатов.

SEO-шников много, профессионалов — единицы. Научитесь технической и поведенческой оптимизации, создавайте семантические ядра и продвигайте проекты в ТОП!

Получить скидку →

Ежедневные советы от диджитал-наставника Checkroi прямо в твоем телеграме!

Подписывайся на канал

Подписаться

Виды дублей

Выше мы уже выяснили, что дубли бывают идентичными (полными) и частичными. Полным называют такой дубликат, когда одну и ту же веб-страницу поисковик находит по различным адресам.

Когда появляются полные дубли:

- Зачастую это происходит, если забыли указать главное зеркало, и весь сайт может показываться в поиске с www и без него, c http и с https. Чтобы устранить эту проблему, читайте здесь детальнее о том, что такое зеркало сайта.

- Кроме того, бывают ситуации, когда возникают дубли главной страницы ввиду особенностей движка или проведенной веб-разработчиком работы. Тогда, к примеру, главная может быть доступна со слешем «/» в конце и без него, с добавлением слов home, start, index.php и т. п.

- Нередко дубли возникают, когда в индекс попадают страницы с динамичными адресами, появляющиеся обычно при использовании фильтров для сортировки и сравнения товаров.

- Часть движков (WordPress, Joomla, Opencart, ModX) сами по себе генерируют дубли. К примеру, в Joomla по умолчанию часть страниц доступна к отображению с разными урлами: mysite.ru/catalog/17 и mysite.ru/catalog/17-article.html и т. п.

- Если для отслеживания сессий применяют специальные идентификаторы, то они также могут индексироваться и создавать копии.

- Иногда в индекс также попадают страницы по адресам, к которым добавлены utm-метки. Такие метки вставляют, чтобы отслеживать эффективность проводимых рекламных кампаний, и по-хорошему они не должны быть проиндексированы. Однако на практике подобные урлы часто можно видеть в поисковой выдаче.

Когда возникают частичные дубли

Полные дубли легко найти и устранить, а вот с частичными уже придется повозиться. Поэтому на рассмотрении их видов стоит остановиться детальнее.

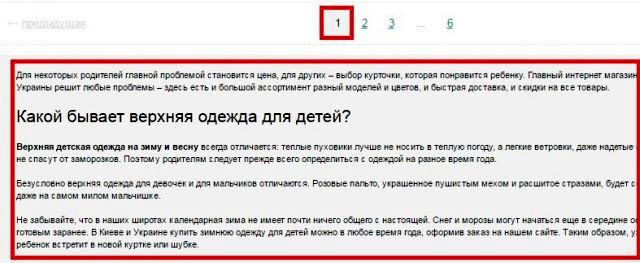

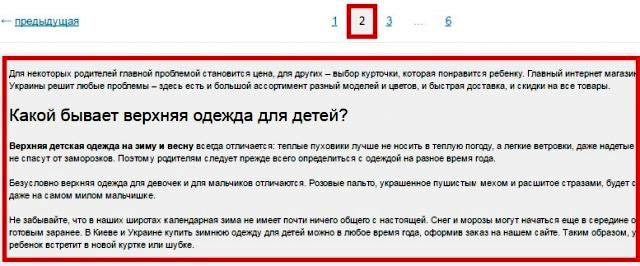

Пагинация страниц

Используя пагинацию страниц, владельцы сайтов делают навигацию для посетителей более простой, но вместе с тем создают проблему для поискового продвижения. Каждая страница пагинации – это фактически дубль зачастую с теми же мета-данными, СЕО-текстом.

К примеру, основная страница имеет вид https://mysite.ru/women/clothes, а у страницы пагинации адрес будет https://mysite.ru/women/clothes/?page=2. Адреса получаются разные, а содержимое будет почти одинаковым.

Блоки новостей, популярных статей и комментариев

Чтобы удержать пользователя на сайте, ему часто предлагают ознакомиться с наиболее интересными новостями, комментариями и статьями. Название этих объектов с частью содержимого обычно размещают по бокам или снизу от основного материала. Если эти куски будут проиндексированы, то поисковик определит, что на некоторых страницах одинаковый контент, а это очень плохо.

На скриншоте видно, как внизу главной страницы сайта размещаются три блока с последними статьями, новостями и отзывами. То есть текстовое содержимое есть в соответствующих разделах сайта, и здесь на главной оно повторяется, создавая частичные дубли.

Версии страниц для печати

Некоторые веб-страницы сайта доступны в обычном варианте и в версии для печати, которая отличается от основной адресом и отсутствием значительной части строк кода, т. к. для печатаемой страницы не нужна значительная часть функционала.

Обычная страница может открываться, например, по адресу https://my-site.ru/page, а у варианта для печати адрес немного изменится и будет похож на такой: https://my-site.ru/page?print.

Сайты с технологией AJAX

На некоторых сайтах, применяемых технологию AJAX, возникают так называемые html-слепки. Сами по себе они не опасны, если нет ошибок в имплантации способа индексирования AJAX-страниц, когда поисковых ботов направляют не на основную страницу, а на html-слепок, где робот индексирует одну и ту же страницу по двум адресам:

- основному;

- адресу html-слепка.

Для нахождения таких html-слепков стоит в основном адресе заменить часть «!#» на такой код: «?_escaped_fragment_=».

Частичные дубли опасны тем, что они не вызывают значительного снижения позиций в один момент, а понемногу портят картину, усугубляя ситуацию день за днем.

Как происходит поиск дублей страниц на сайте

Существует несколько основных способов, позволяющих понять, как найти дубли страниц оптимизатору на сайте:

Вручную

Уже зная, где стоит искать дубликаты, SEO-специалист без особого труда может найти значительную часть копий, попробовав различные варианты урлов.

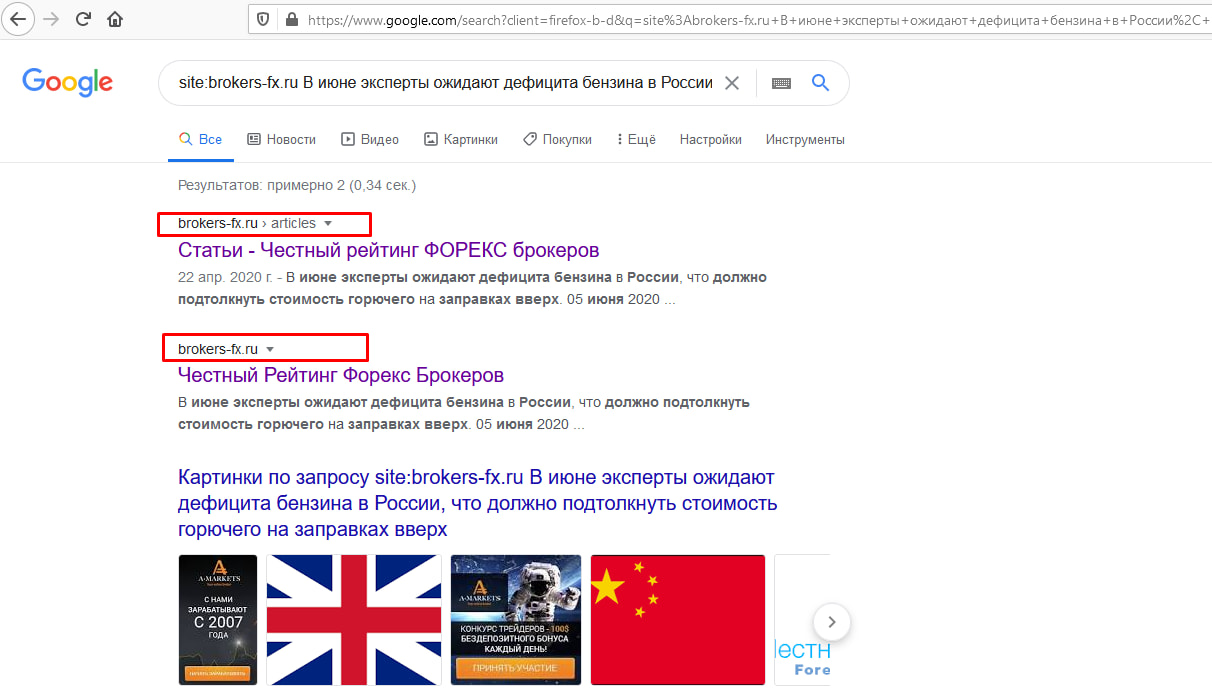

С применением команды site

Вставляем в адресную строку команду «site:», вводим после нее домен и часть текстового содержания, после чего Google сам выдаст все найденные варианты. На скриншоте ниже видно, что мы ввели первое предложение свежей статьи после команды «site:», и Google показывает, что у основной страницы с материалом есть частичный дубль на главной.

С использованием программ и онлайн-сервисов

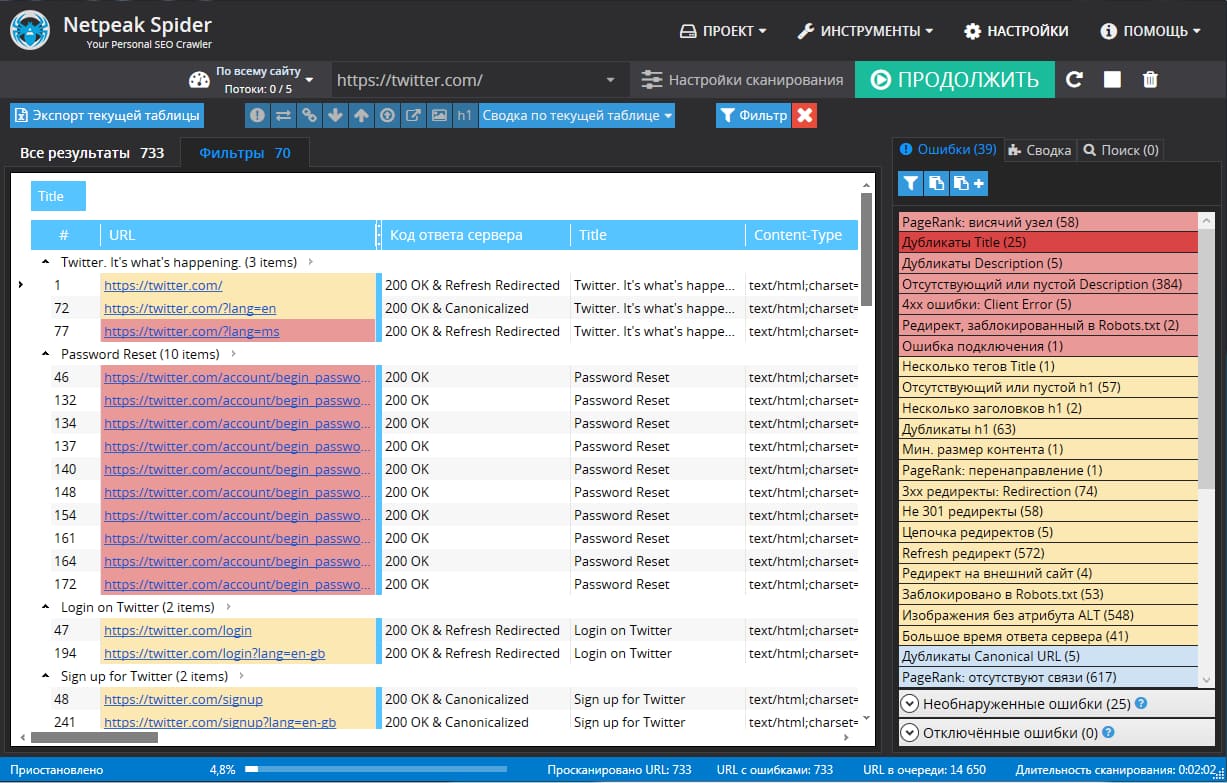

Для поиска дублей часто применяют три популярные программы на ПК:

- Xenu – бесплатная;

- NetPeak – от $15 в месяц, но есть 14-дневный trial;

- Screaming Frog – платная (149 фунтов за год), но есть ограниченная бесплатная версия, которой хватает для большинства нужд.

Вот пример того, как ищет дубликаты программа Screaming Frog:

А вот как можно проверить дубли страниц в NetPeak:

Для онлайн-поиска дублей страниц можно использовать специальные веб-сервисы наподобие Serpstat.

Использование Google Search Console и Яндекс Вебмастер

В обновленной версии Google Search Console для поиска дублей смотрим «Предупреждения» и «Покрытие». Там поисковая система сама сообщает о проблемных, на ее взгляд, страницах, которым нужно уделить внимание.

Что касается Yandex, то здесь все намного удобнее. Для поиска дублей заходим в Яндекс Вебмастер, открыв раздел «Индексирование» – «Страницы в поиске». Опускаемся в самый низ, выбираем справа удобный формат файла – XLS или CSV, скачиваем его и открываем. В этом документе все дубликаты в строке «Статус» будут иметь обозначение DUPLICATE.

Как убрать дубли?

Чтобы удалить дубли страниц на сайте, можно использовать разные приемы в зависимости от ситуации. Давайте же с ними познакомимся:

При помощи noindex и nofollow

Самый простой способ – закрыть от индексации, используя метатег <meta name=”robots” content=”noindex,nofollow”/>, который помещают в шапку между открывающим тегом <head> и закрывающим </head>. Попав на страницу с таким метатегом, поисковые алгоритмы не станут ее индексировать и учитывать ссылки, находящиеся здесь.

При добавлении метатега «noindex,nofollow» на страницу, крайне важно, чтобы для нее не была запрещена индексация через файл robots.txt.

При помощи robots.txt

Индексирование отдельных дублей можно запретить в файле robots.txt, используя директиву Disallow. В таком случае примерный вид кода, добавляемого в robots.txt, будет таким:

User-agent: *

Disallow: /dublictate.html

Host: mysite.ru

Через robots.txt удобно запрещать индексацию служебных страниц. Выглядит это следующим образом:

Этот вариант зачастую применяют, если невозможно использовать предыдущий.

При помощи canonical

Еще один удобный способ – применить метатег canonical, который говорит поисковым роботам, что они попали на страницу-дубликат, а заодно указывает, где находится основная страница. Этот метатег помещают в шапку между открывающим тегом <head> и закрывающим </head>, и выглядит он так:

<link rel=”canonical” href=”адрес основной страницы” />

Как убрать дубликаты на страницах с пагинацией

В случае присутствия на сайте многостраничного каталога, на второй и последующих страницах могут возникать частичные дубли. Смотрим, как это может быть:

Выше на скрине 1-я страница каталога, а вот вторая:

В таких случаях SEO-специалисту нужно добиться, чтобы:

- текст отображался только на 1-й странице;

- Title и Description были уникальными для каждой страницы, хотя их можно сделать шаблонными с минимальными отличиями;

- в адресах страниц пагинации должны отсутствовать динамические параметры.

Понимая теперь, что такое дубликаты страниц сайта, и как бороться с дублями, вы сможете не допустить попадания в индекс копий, которые будут препятствовать продвижению в поисковых системах. Если после прочтения статьи у вас остались вопросы, или вы хотите дополнить материал своими ценными замечаниями, то обязательно сделайте это в комментариях ниже.

Дубли — это страницы с одинаковым контентом. Они могут появиться при автогенерации, некорректных настройках, вследствие изменения структуры сайта или при неправильной кластеризации. Дубликаты негативно влияют на SEO-продвижение, так как поисковые системы хуже ранжируют страницы с похожим контентом. Кроме того, большое количество слабых, несодержательных или пустых страниц понижают оценку всего сайта. Поэтому важно своевременно отслеживать и устранять подобные проблемы.

В данной статье подробно рассмотрим, как найти и удалить дубли, а также предотвратить их появление.

Содержание

- 1 Виды дублей

- 1.1 Полные

- 1.2 Частичные

- 1.2.1 Характеристики в карточке товара

- 1.2.2 Пагинация

- 1.2.3 Подстановка контента

- 1.2.4 Версия для печати

- 1.3 Смысловые

- 2 Варианты устранения дубликатов

- 2.1 Физическое удаление

- 2.2 Настройка 301 редиректа

- 2.3 Создание канонической страницы

- 2.4 Запрет индексации файла Robots.txt

- 3 Причины возникновения

- 4 Как дубликаты влияют на позиции сайта

- 5 Инструменты для поиска

- 5.1 Яндекс.Вебмастер

- 5.2 Netpeak Spider

- 5.3 Xenu

- 5.4 Screaming Frog Seo Spider

- 5.5 Сервис-лайфхак

- 6 Вывод

Виды дублей

Дубликаты бывают 3-х видов:

- Полные — с полностью одинаковым контентом;

- Частичные — с частично повторяющимся контентом;

- Смысловые, когда несколько страниц несут один смысл, но разными словами.

Зачастую при анализе обращают внимание лишь на полные совпадения, но не стоит забывать про частичные и смысловые, так как к ним поисковики тоже относятся критично.

Полные

Полные дубли ухудшают хостовые факторы всего сайта и осложняют его продвижение в ТОП, поэтому от них нужно избавиться сразу после обнаружения.

К ним относятся:

- Версия с/без www. Возникает, если пользователь не указал зеркало в панели Яндекса и Google.

- Различные варианты главной страницы:

- site.net;

- site.net/index;

- site.net/index/;

- site.net/index.html;

- Страницы, появившиеся вследствие неправильной иерархии разделов:

- site.net/products/gift/

- site.net/products/category/gift/

- site.net/category/gift/

- UTM-метки. Метки используются, чтобы передавать данные для анализа рекламы и источника переходов. Обычно они не индексируются поисковиками, но бывают исключения.

- GET-параметры в URL. Иногда при передаче данных GET-параметры попадают в адрес страницы:

- site.net/products/gift/page.php?color=red

- Страницы, сгенерированные реферальной ссылкой. Обычно они содержат специальный параметр, который добавляется к URL. С такой ссылки должен стоять редирект на обычный URL, однако часто этим пренебрегают.

- Неправильно настроенная страница с ошибкой 404, которая провоцирует бесконечные дубли. Любой случайный набор символов в адресе сайта станет ссылкой и без редиректа отобразится как страница 404.

Избавиться от полных дубликатов можно, поставив редирект, убрав ошибку программно или закрыв документы от индексации.

Частичные

Частичные дубликаты оказывают не такое сильное влияние на сайт, как полные. Однако если их много — это ухудшает ранжирование веб-ресурса. Кроме того, они могут мешать продвижению и по конкретным ключевым запросам. Разберем в каких случаях они возникают.

Характеристики в карточке товара

Нередко, переключаясь на вкладку в товарной карточке, например, на отзывы, можно увидеть, как это меняет URL-адрес. При этом большая часть контента страницы остаётся прежней, что создает дубль.

Пагинация

Если CMS неправильно настроена, переход на следующую страницу в категории меняет URL, но не изменяет Title и Description. В итоге получается несколько разных ссылок с одинаковыми мета-тегами:

- site.net/category/notebooks/

- site.net/category/notebooks/?page=2

Такие URL-адреса поисковики индексируют как отдельные документы. Чтобы избежать дублирования, проверьте техническую реализацию вывода товаров и автогенерации.

Также на каждой странице пагинации необходимо указать каноническую страницу, которая будет считаться главной. Как указать этот атрибут, будет рассмотрено ниже.

Подстановка контента

Часто для повышения видимости по запросам с указанием города в шапку сайта добавляют выбор региона. При нажатии которого на странице меняется номер телефона. Бывают случаи, когда в адрес добавляется аргумент, например «wt_city_by_default=..». В результате, у каждой страницы появляется несколько одинаковых версий с разными ссылками. Не допускайте подобной генерации или используйте 301 редирект.

Версия для печати

Версии для печати полностью копируют контент и нужны для преобразования формата содержимого. Пример:

- site.net/blog/content

- site.net/blog/content/print – версия для печати;

Поэтому необходимо закрывать их от индексации в robots.txt.

Смысловые

Смысловые дубли — это статьи, написанные под запросы из одного кластера. Чтобы их обнаружить, нужно воспользоваться результатом парсинга сайта, выполненного, например, программой Screaming Frog. Затем скопировать заголовки всех статей и добавить их в любой Hard-кластеризатор с порогом группировки 3,4. Если несколько статей попали в один кластер – оставьте наиболее качественную, а с остальных поставьте 301 редирект.

Варианты устранения дубликатов

При дублировании важно не только избавиться от копий, но и предотвратить появление новых.

Физическое удаление

Самым простым способом было бы удалить повторяющиеся страницы вручную. Однако перед удалением нужно учитывать несколько важных моментов:

- Источник возникновения. Зачастую физическое удаление не решает проблему, поэтому ищите причину;

- Страницы можно удалять, только если вы уверены, что на них не ссылаются другие ресурсы. Проверить это можно с помощью условно-бесплатного инструмента.

Настройка 301 редиректа

Если дублей не много или на них есть ссылки, настройте редирект на главную или продвигаемую страницу. Настройка осуществляется через редактирование файла .htaccess либо с помощью плагинов. Старый документ со временем выпадет из индекса, а весь ссылочный вес перейдет новой странице.

Создание канонической страницы

Указав каноническую страницу, вы показываете поисковым системам, какой документ считать основным. Этот способ используется для того, чтобы показать, какую страницу нужно индексировать при пагинации, сортировке, попадании в URL GET-параметров и UTM-меток. Для этого на всех дублях в теге <head></head> прописывается следующая строчка со ссылкой на оригинальную страницу:

<link rel= «canonical» href= «http://site.net/original.html»>

Например, на странице пагинации главной должна считаться только одна страница: первая или «Показать все». На остальных необходимо прописать атрибут rel=»canonical», также можно использовать теги rel=prev/next.

Например

Для 1-ой страницы:

- <link rel=’next’ href=’https://altblog.ru/page/2/’ />

- <link rel=»canonical» href=»https://altblog/» />

Для второй и последующей:

- <link rel=’prev’ href=’https://altblog.ru/’ />

- <link rel=’next’ href=’https://altblog.ru/page/3/’ />

- <link rel=»canonical» href=»https://altblog.ru/» />

Для решения этой задачи на сайтах WordPress используйте плагины Yoast SEO или All in One SEO Pack. Чтобы все заработало просто зайдите в настройки плагина и отметьте пункт «Канонические URL».

Запрет индексации файла Robots.txt

Файле robots.txt — это своеобразная инструкция по индексации для поисковиков. Она подойдёт, чтобы запретить индексацию служебных страниц и дублей.

Для этого нужно воспользоваться директивой Disallow, которая запрещает поисковому роботу индексацию.

Disallow: /dir/ – директория dir запрещена для индексации

Disallow: /dir – директория dir и все вложенные документы запрещены для индексации

Disallow: *XXX – все страницы, в URL которых встречается набор символов XXX, запрещены для индексации.

Внимательно следите за тем какие директивы вы прописываете в robots. При некорректном написании можно заблокировать не те разделы либо вовсе закрыть сайт от поисковых систем.

Запрет индексировать страницы действует для всех роботов. Но каждый из них реагирует на директиву Disallow по-разному: Яндекс со временем удалит из индекса запрещенные страницы, а Google может проигнорировать правило, если на данный документ ведут ссылки.

Причины возникновения

Обычно при взгляде на URL-адрес можно сразу определить причину возникновения дубля. Но иногда нужен более детальный анализ и знание особенностей CMS. Ниже приведены 6 основных причин, почему они могут появляться:

- ID-сессии, которые нужны, чтобы контролировать действия юзеров или анализировать данные о товарах в корзине.

- Особенности CMS. Joomla создаёт большое количество дублей, в отличие, например, от WordPress.

- Ссылки с GET-параметрами.

- Страницы комментариев.

- Документы для печати.

- Документы с www и без www.

Некоторые ошибки могут появиться и по другим причинам, например, если не указан редирект со старой страницы на новую или из-за особенностей конкретных скриптов и плагинов. С каждой такой проблемой нужно разбираться индивидуально.

Отдельным пунктом можно выделить страницы, дублирующиеся по смыслу. Такая ошибка часто встречается при неправильной разгруппировке. Подробнее о том как ее не сделать читайте по ссылке.

Как дубликаты влияют на позиции сайта

Дубли существенно затрудняют SEO-продвижение и могут стать препятствием для выхода запросов в ТОП поисковой выдачи.

Чем же они так опасны:

- Снижают релевантность страниц. Если поисковик замечает несколько url-ов с одинаковым контентом, их релевантность снижается и оба документа начинают ранжироваться хуже.

- Уменьшают процент уникальности текстов. Уникальность будет разделена между дублирующими документами, а значит копия будет неуникальной по отношению к основной странице. В итоге общая уникальность сайта понизится.

- Разделяют вес. Поисковик показывает по одному запросу только 1 станицу сайта (если он не витальный), поэтому наличие нескольких документов снижает вес каждого урла.

- Увеличивают время индексации. Поисковый робот дольше сканирует веб-ресурс из-за большого количества документов.

Инструменты для поиска

Как найти дублирующиеся документы? Это можно сделать с помощью программ и онлайн-сервисов. Часть из них платные, другие – бесплатные, некоторые – условно-бесплатные (с пробной версией или ограниченным функционалом).

Яндекс.Вебмастер

Чтобы посмотреть наличие дубликатов в панели Яндекса, необходимо:

- выбрать вкладку «Индексирование»;

- открыть раздел «Страницы в поиске»;

- посмотреть количество «Исключенных страниц».

Страницы исключаются из индекса по разным причинам, в том числе из-за повторяющегося контента. Обычно конкретная причина прописана под ссылкой.

Netpeak Spider

Netpeak Spider – платная программа с 14-дневной пробной версией. Если провести поиск по заданному сайту, программа покажет все найденные ошибки и дубликаты.

Xenu

Бесплатным аналогом этих программ является Xenu, где можно проанализировать даже не проиндексированный сайт.

При сканировании программа найдет повторяющиеся заголовки и мета-описания.

Screaming Frog Seo Spider

Screaming Frog Seo Spider является условно-бесплатной программой. До 500 ссылок можно проверить бесплатно, после чего понадобится платная версия. Наличие дублей программа определяет так же, как и Xenu, но быстрее и эффективнее. Если нет денег на покупку рабочий ключ можно найти в сети.

Сервис-лайфхак

Для тех кто не хочет осваивать программы, рекомендую воспользоваться техническим анализом от Wizard.Sape. Аудит делается в автоматическом режиме в среднем за 2-4 часа. Цена вопроса — 690 рублей. В течении 30 дней бесплатно можно провести повторную проверку.

Помимо дублированного контента и мета-тегов инструмент выдает много полезной информации:

- показывает все 301 редиректы;

- обрабатку заранее ошибочных адресов;

- страницы на которых нет контента;

- битые внешние и внутренние ссылки и картинки.

Вывод

Полные и частичные дубли значительно осложняют продвижение сайта. Поэтому обязательно проверяйте ресурс на дубликаты, как сгенерированные, так и смысловые и применяйте описанные в статье методы для их устранения.

Дубли страниц — документы, имеющие одинаковый контент, но доступные по разным адресам. Наличие таких страниц в индексе негативно сказывается на ранжировании сайта поисковыми системами.

Какой вред они могут нанести

- Снижение общей уникальности сайта.

- Затрудненное определение релевантности и веса страниц (поисковая система не может определить, какую страницу из дубликатов необходимо показывать по запросу).

- Зачастую дубли страниц имеют одинаковые мета-теги, что также негативно сказывается на ранжировании.

Как появляются дубликаты

Технические ошибки

К ним относят доступность страниц сайта:

- по www и без www;

- со слэшем на конце и без;

- с index.php и без него;

- доступность страницы при добавлении различных GET-параметров.

Особенности CMS

- страницы пагинации сайта;

- страницы сортировки, фильтрации и поиска товаров;

- передача лишних параметров в адресе страницы.

Важно! Также дубли страниц могут появляться за счет доступности первой страницы пагинации по двум адресам: http://site.ru/catalog/name/?PAGEN_1=1 и http://site.ru/catalog/name/.

Дубликаты, созданные вручную

Один из наиболее частых примеров дублирования страниц — привязка товаров к различным категориям и их доступность по двум адресам. Например: http://site.ru/catalog/velosiped/gorniy/stern-bike/ и http://site.ru/catalog/velosiped/stern-bike/.

Также страницы могут повторяться, если структура сайта изменилась, но старые страницы остались.

Поиск дублей страниц сайта

Существует большое количество методов нахождения дубликатов страниц на сайте. Ниже описаны наиболее популярные способы:

- программа Screaming Frog;

- программа Xenu;

- Google Webmaster: «Вид в поиске» -> «Оптимизация HTML»;

- Google Webmaster: «Сканирование» -> «Оптимизация HTML».

Для программы Screaming Frog и Xenu указывается адрес сайта, и после этого робот собирает информацию о нем. После того, как робот просканирует сайт, выбираем вкладку Page Title — Duplicate, и анализируем вручную список полученных страниц.

С помощью инструмента «Оптимизация HTML» можно выявить страницы с одинаковыми description и title. Для этого в панели Google Webmaster надо выбрать необходимый сайт, открыть раздел «Вид в поиске» и выбрать «Оптимизация HTML».

C помощью инструмента «Параметры URL» можно задать параметры, которые необходимо индексировать в адресах страниц.

Для этого надо выбрать параметр, кликнуть на ссылку «Изменить» и выбрать, какие URL, содержащие данный параметр, необходимо сканировать.

Также, найти все индексируемые дубли одной страницы можно с помощью запроса к поиску Яндекса. Для этого в поиске Яндекса необходимо ввести запрос вида site:domen.ru «фраза с анализируемой страницы», после чего проанализировать вручную все полученные результаты.

Как правильно удалить дубли

Чтобы сайт открывался лишь по одному адресу, например «http://www.site.ru/catalog/catalog-name/», а не по «http://site.ru/catalog/catalog-name/index.php», необходимо корректно настроить 301 редиректы в файле htaccess:

- со страниц без www, на www;

- со страниц без слэша на конце, на «/»;

- со страниц с index.php на страницы со слэшем.

Если вам необходимо удалить дубликаты, созданные из-за особенностей системы управления сайтом, надо правильно настроить файл robots.txt, скрыв от индексации страницы с различными GET-параметрами.

Для того чтобы удалить дублирующие страницы, созданные вручную, нужно проанализировать следующую информацию:

- их наличие в индексе;

- поисковый трафик;

- наличие внешних ссылок;

- наличие внутренних ссылок.

Если неприоритетный документ не находится в индексе, то его можно удалять с сайта.

Если же страницы находятся в поисковой базе, то необходимо оценить, сколько поискового трафика они дают, сколько внешних и внутренних ссылок на них проставлено. После этого остается выбрать наиболее полезную.

После этого необходимо настроить 301-редирект со старой страницы на актуальную и поправить внутренние ссылки на релевантные.

Ждите новые заметки в блоге или ищите на нашем сайте.