Что сделать, чтобы мой сайт видели поисковые системы

В этой статье мы расскажем, как добавить сайт в поисковые системы: как проиндексировать сайт в Яндексе и добавить сайт в поиск Google.

После публикации сайта позаботьтесь о том, чтобы пользователи могли найти его в Интернете. Если пользователь знает URL-адрес сайта, сделать это легко. Сложнее сделать так, чтобы сайт быстро находился через поисковые системы.

Возникает закономерный вопрос: «Я уже создал сайт, как его разместить в Интернете?». Это связано с индексацией сайта. Прежде чем понять, как добавить свой сайт в поисковики Яндекс и Google, разберемся, что такое индексация.

Бесплатный SSL-сертификат

Поисковые системы больше доверяют сайтам с SSL. Получите в подарок SSL-сертификат начального уровня на 1 год и хостинг на 2 месяца бесплатно при регистрации нового домена на сайте REG.RU.

Зарегистрировать

Что такое индексация

Индексация сайта — это добавление его страниц в базу поисковых систем (поиск в Яндекс, Google, Рамблер, Yahoo, Mail, Bing и т.д.). Чтобы проиндексировать веб-страницы, поисковики отправляют на обход специальных роботов. Они анализируют HTML-код сайтов, учитывая:

- правильное наполнение страниц метатегами (description, title, keywords, h1, p) и их соответствие стандартам вёрстки;

- грамотное расположение текста;

- перелинковку;

- наличие карты сайта (sitemap);

- микроразметку.

В результате проверки роботы индексируют сайт, и он начинает отображаться в поисковой выдаче. Как добавить сайт на индексацию в поисковики, читайте ниже.

Почему сайта нет в Yandex и Google

Процесс индексации может занимать несколько недель. Представьте, какое количество новых сайтов нужно обойти роботам. Кроме того, не все страницы одного сайта индексируются одновременно. А если в коде есть то, что не удовлетворяет требованиям поисковых систем, индексация затянется.

Если вы только что разместили сайт в Интернете, он не будет сразу же отображаться в Яндекс и Google. Если вам нужно, чтобы сайт как можно быстрее отображался в поисковой выдаче, ускорьте индексацию вручную.

Ниже рассмотрим, как бесплатно добавить сайт на индексацию в поисковики.

Как ускорить процесс индексации сайта

Как сделать так, чтобы сайт стал быстрее видимым для поисковых систем? Нужно самому указать на свой сайт Яндекс и Google. Это делается через специальные панели, предназначенные для разработчиков сайтов: Яндекс.Вебмастер и Google Search Console. Прежде чем следовать инструкции о том, как разместить сайт в Гугл и в Яндекс, авторизуйтесь в нужной системе.

Как добавить сайт в Яндекс.Вебмастер

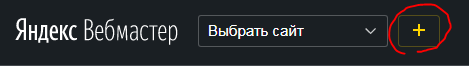

Чтобы добавить сайт в поисковую систему Яндекс, следуйте инструкции ниже:

-

1.

Перейдите на страницу Яндекс.Вебмастера.

-

2.

Перейдите по ссылке Добавить сайт.

-

3.

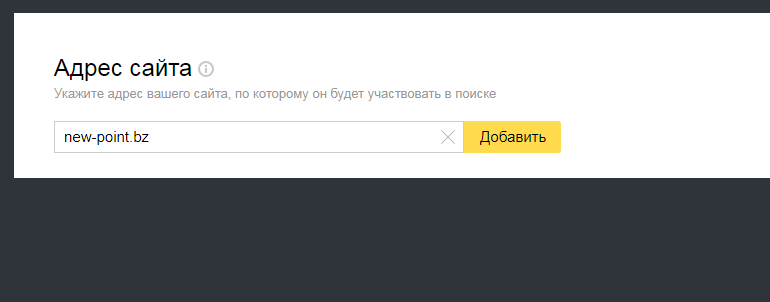

Введите адрес сайта (доменное имя) и нажмите Добавить:

Размещение сайта в Яндекс.Webmaster

-

4.

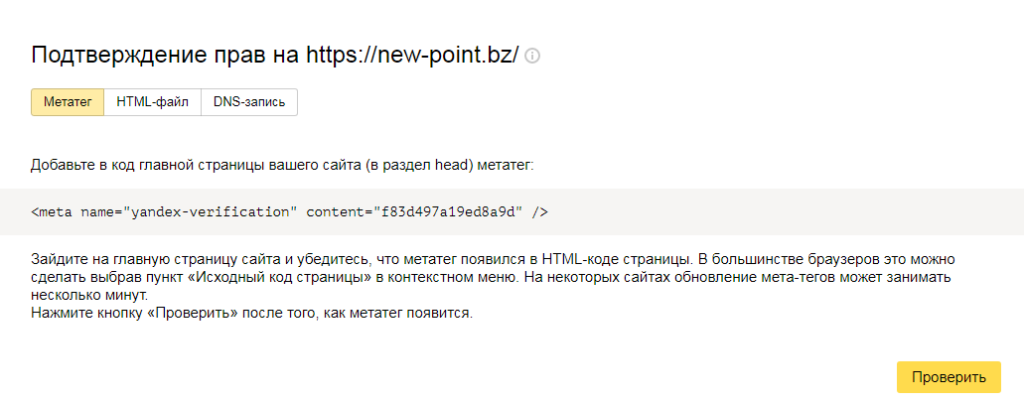

Подтвердите права на сайт. Сделать это можно через:

- код-страницы (Метатег);

- загрузку файла на хостинг (HTML-файл);

- или добавление TXT-записи (DNS-запись).

Мы рекомендуем добавить DNS-запись, так как это наиболее простой способ.

Как добавить DNS-запись для подтверждения прав

Кликните по вкладке «DNS-запись» и скопируйте значение TXT, которое нужно добавить:

Яндекс.Вебмастер: подтверждение прав на сайт

Определите, какие DNS-серверы прописаны для домена, по инструкции. От этого будет зависеть, где добавить TXT-запись:

- если для домена указаны ns1.reg.ru и ns2.reg.ru, воспользуйтесь пошаговой инструкцией раздела «Помощь»;

- если для домена указаны ns1.hosting.reg.ru и ns2.hosting.reg.ru, воспользуйтесь статьей.

Дождитесь обновления зоны домена.

Готово, вы добавили TXT-запись для подтверждения права на домен.

-

5.

После подтверждения прав нажмите Проверить. Если права подтверждены корректно, вы увидите следующее:

как добавить сайт в поиск яндекса

После мы рекомендуем воспользоваться инструментом Переобход страниц. Через него можно задать, какие страницы сайта стоит проиндексировать в первую очередь.

Готово, вы ускорили индексацию сайта. Теперь вы знаете, как добавить сайт в Вебмастер.

Обратите внимание

Описанный способ не требует технических навыков и знания SEO-оптимизации, но не гарантирует, что сайт сразу появится в поисковой выдаче. Если вы технически подкованы, воспользуйтесь другим способом: Как добавить сайт в поиск Яндекса.

Как добавить сайт в поиск Google

Как разместить сайт в Гугле, вы узнаете по инструкции:

-

1.

Перейдите на страницу Google Search Console.

-

2.

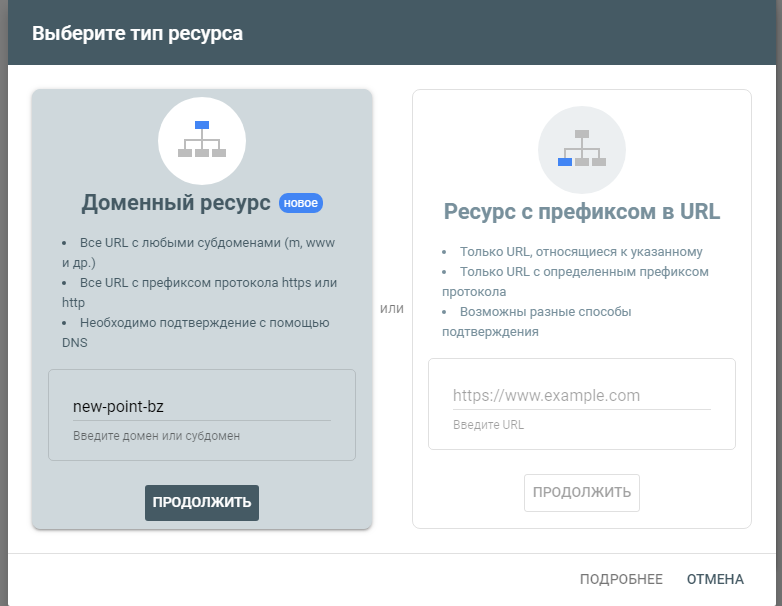

Введите адрес сайта в первом блоке и нажмите Продолжить:

Как добавить url в поисковые системы

-

3.

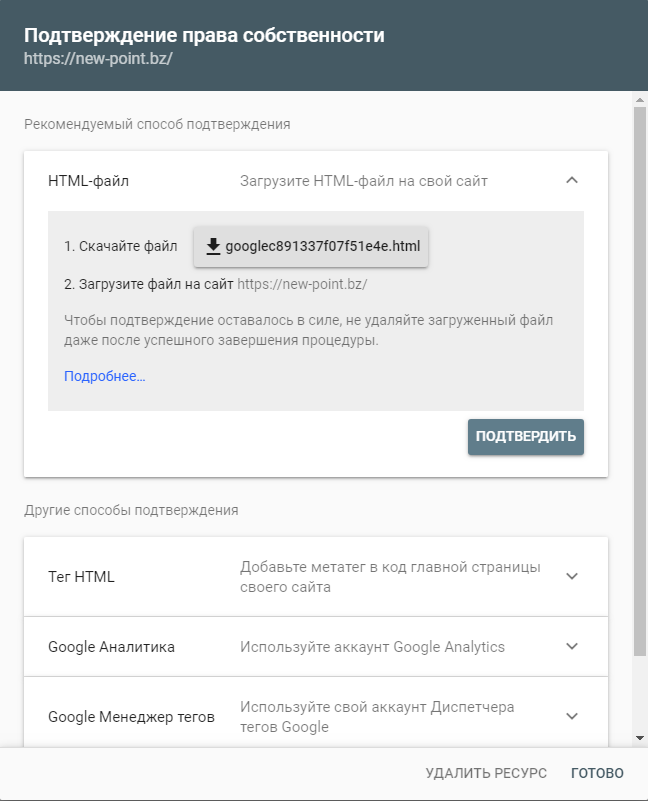

Добавьте нужную запись в зону домена по инструкции ниже и нажмите Подтвердить.

Как добавить DNS-запись для подтверждения прав

Скопируйте значение TXT-записи.

Определите, какие DNS-серверы прописаны для домена, по инструкции. От этого будет зависеть, где добавить TXT-запись:

- если для домена указаны ns1.reg.ru и ns2.reg.ru, воспользуйтесь пошаговой инструкцией раздела «Помощь»;

- если для домена указаны ns1.hosting.reg.ru и ns2.hosting.reg.ru, воспользуйтесь статьей.

Дождитесь обновления зоны домена.

Готово, вы добавили TXT-запись для подтверждения права на домен.

-

4.

Если права подтверждены корректно, вы увидите уведомление. Нажмите Готово:

Готово, вы ускорили индексацию сайта. Теперь вы знаете, как добавить сайт в поисковики.

Обратите внимание

Описанный способ не требует технических навыков и знания SEO-оптимизации, но не гарантирует, что сайт сразу появится в поисковой выдаче. Если вы технически подкованы, воспользуйтесь другим способом: Как добавить сайт в Google?.

Мы рассказали о том, как зарегистрировать сайт в Яндексе и Гугле и добавить сайт в поисковые системы бесплатно. Это поможет вам на начальном этапе. Если вы хотите продвигать свой ресурс, рекомендуем также подключить SSL-сертификат. Он поможет в SEO-продвижении проекта: позволит занять более высокую позицию в поисковой выдаче. В REG.RU вы можете заказать бесплатный SSL-сертификат для домена на 1 год: Как заказать бесплатный SSL-сертификат?

Как найти свой сайт в поисковой системе

На первый взгляд, проблема поиска своего сайта в интернете кажется бессмысленной. Однако это не так, ведь от позиции сайта в поисковых системах по определенным ключевыми словам определяется авторитетность сайта и количество пользователей сети интернет, переходящих на ваш сайт.

Инструкция

Поисковые системы индексируют, т.е. добавляют в свой каталог, как одностраничные статические сайты, так и огромные порталы и динамические форумы и интернет-магазины. Для того чтобы поисковая система заметила новый адрес в интернете – домен, его необходимо добавить в поисковую машину через так называемую Add Url.Google: http://www.google.com/addurl/Яндекс: http://webmaster.yandex.ru/addurl.xmlRambler: http://www.rambler.ru/doc/add_site_form.shtmlАпорт: http://catalog.aport.ru/rus/add/AddUrl.aspxYahoo!: http://siteexplorer.search.yahoo.com/submitBing! (MSN, Live Search Microsoft): http://www.bing.com/docs/submit.aspxПосле того, как домен был добавлен в Add Url, поисковой машине потребуется от нескольких часов до 2-3 недель, чтобы принять сайт и начать его индексацию. При этом, на сайте, конечно же, должен быть какой-либо текстовый контент.

Если вы хотите анализировать позиции сайта по ключевым словам и фразам и узнать, на какой странице в выдаче находится ваш ресурс при вводе пользователем того или иного запроса, необходимо воспользоваться специальным сервисом. Один из них — «Сеумка» — вычисляет позицию вашего домена в выбранной поисковой системе по заданным ключевикам. «Сеумка» находится по адресу: http://seumka.ru/. Данный сервис, как и многие качественные сервисы по предоставлению SEO-информации, является платным.

Еще один интересный сервис под названием SetLinks является биржой ссылок, которая бесплатно предоставляет услугу мониторинга позиций интернет-ресурса в поисковых машинах. Сайт SEMRush также может показать вам положение страниц вашего сайта в популярных поисковых системах. Сервис расположен по ссылке: http://ru.semrush.com/ru/?db=ru

Некоторую информацию о позициях сайта в поисковых системах по сильным запросам предоставляет сервис Cy-Pr.com: http://www.cy-pr.com/analysis/. Часть информации по сайту предоставляется бесплатно, часть – за деньги.

Войти на сайт

или

Забыли пароль?

Еще не зарегистрированы?

This site is protected by reCAPTCHA and the Google Privacy Policy and Terms of Service apply.

Главная задача поисковых машин ― дать наиболее полный и развернутый ответ на запрос посетителя, введенный в строку поиска. Точнее, дать список сайтов, на которых есть информация по этому запросу. Чем точнее ответ он получит, тем чаще будет возвращаться на сайт поисковой системы для получения ответов по интересующим его темам.

Поисковая строка Yandex.ru

Цель коммерческого сайта ― обращения (лиды), которые отдел продаж превращает в сделки.

Что нужно сделать, чтобы получить с сайта обращения? Например, у вас есть детские автокресла, которые нужно продать. Каким образом их продать через интернет?

Это можно сделать таким образом:

- Разместить на сайте все имеющиеся автокресла и информацию о них для покупателей.

- Привлечь из поисковых систем посетителей, которые заинтересованы в данной продукции.

- С определенной долей вероятности они, попав на ваш сайт, обратятся.

Как клиенты, заинтересованные в покупке автокресла, узнают про ваш сайт? Один из путей может быть таким:

- Пользователи зайдут на сервисы поиска «Яндекс», «Гугл».

- В поисковой строке они набирают запросы, например: «детское автокресло», «кресло для детей в машину», «детское кресло для авто».

- Получают результат ― список сайтов, на которых можно найти интересующую информацию.

- При оптимизации вашего сайта под данные запросы, он окажется в выдаче, а значит получит целевых, то есть заинтересованных в вашей продукции или услугах, посетителей.

Получается такая схема: поисковик ― запрос ― выдача ― ваш сайт.

Из схемы получается, для результата нужно, чтобы ваш сайт оказался в выдаче поисковика на запрос. То есть оптимизировать сайт под поисковые фразы.

Как сайты попадают в результат выдачи поисковиков

Если упростить, то поисковые системы работают по такой схеме:

- Специальные программы собирают информацию по всем сайтам, которые они находят в сети интернет.

- Попадая на сайт, они его полностью копируют в свою базу данных для предварительного анализа.

- Затем полученный массив данных при помощи специальных алгоритмов анализируется на предмет тематики, его региона, содержания.

- Если на сайте не выявлено каких-либо нарушений, то он попадает в базу поисковика, которая участвует в результате поисковой выдачи.

- Далее сайт начинает участвовать в процессе ответов на запросы пользователей.

- Посетитель набирает запрос, поисковик по алгоритму находит в базе информацию, соответствующую запросу, и списком выдает ссылки на сайты, где эта информация им обнаружена.

Поисковик ищет ответ на запрос не в интернете среди сайтов, а в своей базе, которую он периодически обновляет.

Как поисковые системы выдают ответ на запрос посетителя?

По какому принципу происходит отбор сайтов из базы поисковика в десятку первой страницы? Одним из признаков, что по данному запросу можно показать тот или иной сайт, является наличие такой же фразы на сайте. Например, запрос «ветеринарные клиники в Балашихе» и результат выдачи:

Верхний блок в красном квадрате ― это отображение контекстной рекламы, в которой вы оплачиваете переходы на сайт по запросам, которые вам интересны, и сервиса «Яндекс.Карты». Это рекламные ссылки, обычно они наверху результатов выдачи. Ниже идет список поисковой выдачи, то есть результат из списка сайтов в базе поисковой системы, которые являются ответом на заданную фразу.

Если перейти по ссылкам, то на сайтах обнаружим, что они содержат фразу из запроса, например:

Это и является признаком релевантности (соответствия) сайта запросу. Наличие фразы на странице сайта, которая полностью повторяет запрос в поисковой строке, даёт сигнал поисковой системе, что данная страница, скорее всего, содержит информацию по этому запросу и, возможно, даст развернутый ответ по нему. На позиции также влияет:

- как часто запрос упоминается в тексте;

- в каких местах текста (начало, середина, конец);

- какой объем текста;

- какова структура текста ― абзацы, подзаголовки, списки, графические материалы, картинки.

- какие слова из этой отрасли упоминаются в тексте и в каком количестве: специфические термины, отраслевой сленг и т.д.

- уникальность текста.

Соблюдение всех этих условий ― важно, но не гарантирует попадание в первую десятку выдачи. Так как в действие вступают дополнительные условия поисковиков, которые также нужно предусмотреть.

Требования и правила поисковиков

При создании сайта и его последующем продвижении важно соблюсти ряд требований поисковых систем. Например, «Яндекс» свои требования разместил на страницах помощи:

- Чем отличается качественный сайт от некачественного с точки зрения Яндекса?

- Как сделать сайт эффективнее.

Если их подытожить, то можно выделить из этих перечней следующее:

- Оригинальный контент. Информация на сайте должна быть уникальной. Если она дублируется с других сайтов, то поисковики не спешат его добавлять в свою базу, так как данная информация у них уже есть.

- Полезность информации. Наполнение страницы должно быть структурировано, интересно посетителю и отвечать на его конкретные вопросы.

- Удобство для пользователей. Что подразумевает понятную структуру сайта. Информация, которую посетитель искал, должна быть видна сразу, не стоит ее помещать в труднодоступный блок страницы или скрывать.

- Скорость загрузки. Сайт должен быстро загружаться. Это важно как для поисковиков (тогда им проще копировать сайт), так и для посетителей, у которых может быть медленный интернет.

- Регулярное обновление сайта. Желательно, чтобы информация на сайте обновлялась и дополнялась. В этом могут помочь: новостная лента, фотогалереи, блог, раздел статей с полезной информацией, пресс-релизы и т.д.

Также сайт должен быть технически грамотно сделан, чтобы упростить его копирование поисковиками в свою базу. На нем желательно предусмотреть:

- карта сайта в формате XML;

- настройка файла robots.txt;

- удобные адреса страниц и разделов;

- грамотная простановка основных тэгов страниц Title, H1, p, ul;

- добавление описаний к картинкам, чтобы поисковики понимали их содержание;

- настройка мета-тэгов на сайте;

- микроразметка содержания на страницах;

- настройка страниц ошибок;

- хлебные крошки;

- настроенный 301 редирект, в случае наличия дублей страниц;

- добавление счетчиков на сайт и настройка на них целей.

Как поиск находит страницу сайта? Описание процесса индексации страниц сайта

- 05.03.2018

-

Eye

3 464 -

Chatbubbles

0 -

Categories

SEO, Яндекс

Интересные факты

В поисковой базе индексирующего робота на текущий момент содержатся триллионы адресов различных сайтов, ежедневно из этого триллиона робот скачивает миллиарды документов. И во всем этом большом и постоянном процессе очень важно то, как индексирующий робот проиндексирует именно ваш сайт, и как он включит его в результаты поиска.

Что такое индексирование?

Что такое процесс индексирования сайтов? Это процесс получения информации о какой-либо странице, процесс получения контента, и включение этих данных в результаты поиска.

Процесс индексирования

Первый этап – это создание вашего сайта. Вы создали сайт, разместили его на сервере, заполнили каким-либо контентом, сделали ваш сайт доступным для посетителей и для индексирующего робота. Для того, чтобы ваш сайт начал индексироваться, робот прежде всего должен узнать о его существовании.

После того, как появилась информация о том, что в Интернете разместили новый сайт, робот планирует посещение вашего сайта, отправляет определенные запросы к вашему серверу, получает контент от сервера и полученный контент в будущем добавляет в поисковую базу и в результаты поиска. Давайте рассмотрим более подробно.

Откуда робот узнает о страницах:

- с ссылок на других страницах в Интернете;

- с сайта Я.Вебмастер (webmaster.yandex.ru);

- с внутренних ссылок;

- с карты сайта (sitemap);

- с других источников, например, Я.Метрики.

Во-первых, откуда индексирующий робот узнает о страницах, о сайте в целом. Если ваш сайт существует уже некоторое время, уже давно, скорее всего на него присутствуют какие-либо ссылки в Интернете. Например, пользователи часто на форумах обмениваются мнением о покупках в интернет-магазине, еще что-то, пересылают ссылки между собой. Если робот обнаружит такие ссылки, он начнет индексировать ваш сайт.

Но если ваш сайт был создан совсем недавно, скорее всего ссылки на него отсутствуют и поэтому робот не знает о его существовании. Для таких случаев есть сервис Яндекс.Вебмастер, в частности инструмент «сообщить о новом сайте», в который можно добавить адрес вашего нового сайта, и робот начнет его индексировать.

Если мы говорим о внутренних страницах какого-либо ресурса, то естественным считается процесс обнаружения доступных ссылок на те или иные страницы. В частности, робот посещает главную страницу вашего сайта, обнаруживает какие-то доступные ссылки на внутренние страницы и добавляет так же информацию о них в свою базу и начинает также их индексировать.

Существует специальный файл, файл sitemap, который позволяет передавать роботу информацию о страницах вашего сайта.

Так же робот может получать информацию о страницах из других источников. Например, если в Яндекс.Метрике разрешили роботу Метрики передавать индексирующему роботу какие-либо данные, робот может получать информацию, например, о новых страницах, и так же добавлять их в свою базу, индексировать, включать в поиск.

От чего зависит скорость индексирования

От чего зависит то, насколько быстро индексирующий робот включит вашу страницу поисковую выдачу? На самом деле, весь процесс индексирования полностью автоматически проходит, и робот посещает все страницы вашего сайта, каждую отдельную страничку в соответствии со своими внутренними политиками планирования.

Эти политики планирования строятся на основании машинного обучения и зависят от различных факторов. Со временем эти политики в отношении определенного сайта или определенной страницы могут меняться, также основываясь на показаниях q-факторов.

Несколько факторов, которые мне бы хотелось для вас выделить.

Во-первых, это загруженность сервера, на котором находится ваш конкретный сайт. Если на вашем сайте находится большое количество других ресурсов, если сервер не справляется со всеми запросами индексирующего робота, робот начинает посещать ваш сайт реже, поэтому времени потребуется больше для включения страницы в результаты поиска.

Второй фактор, который хочется отметить – это частота обновления вашего сайта в целом и конкретных каких-либо страниц, разделов. Что подразумевается здесь? Если индексирующий робот видит, что на вашем сайте часто добавляется какой-либо новый контент, то есть информация обновляется регулярно, робот начинает посещать эти страницы чаще, потому что считает, что сейчас, спустя какое-то время, он придет опять на сайт и опять контент будет обновлен.

И обратное действие, если какая-либо страница на вашем сайте не менялась уже несколько лет, скорее всего она будет посещаться роботом реже, потому что он приходит один, два, три, несколько раз, видит, что контент совсем не изменился, изменяет политики планирования и к этой страничке вернется уже не через месяц, через неделю, а вернется через полгода, может быть больше, в зависимости от того сколько времени прошло.

Еще один фактор, который мне хотелось бы здесь выделить – это интерес посетителей вашего сайта к материалу, который вы размещаете на нем. Если новости или какие-либо страницы, информационные статьи, которые вы размещаете, интересны посетителям, то они задерживаются на вашем сайте, просматривают материал, продолжают переходить дальше по каким-либо внутренним страницам, робот тоже обращает на это внимание и так же может пересмотреть политики планирования, которые использует при посещении вашего ресурса.

Запрос и получение контента

Мы узнали о вашей странице, положили информацию о ней, о ее существовании в свою базу, запланировали ее, теперь нужно получить ее с сервера. Во-первых, перед началом каждого индексирования робот запрашивает файл robots.txt. Обычно это происходит, примерно, один-два раза в сутки.

По какой причине? Как правило, этот файл нечасто меняется, обновлять его чаще не нужно. Зачем нужно скачивать его каждые десять минут перед загрузкой каких-то страниц? После чего происходит запрос уже конкретной страницы. Это видно по определенным заголовкам, которые отсылает индексирующий робот, среди них хочется выделить несколько.

Это Accept-Language, который указывает на то, какие языки поддерживает индексирующий робот.

Accept-Encoding, который указывает на поддерживаемые форматы сжатия.

User-Agent – это заголовок, который показывает какой именно индексирующий робот к вам пришел. Это может быть обычный индексирующий робот, как в данном случае, это может быть робот-зеркальщик, робот картинок.

Практически у каждого сервиса есть свой робот, их очень много. Именно этот заголовок User-Agent и покажет вам какой робот пришел и запросил эту страницу.

После того, как мы отправили запрос на ваш сервер, сервер возвращает какой-либо ответ. Начинается этот ответ с таких же HTTP заголовков. В зависимости от настроек сервера их может быть больше или меньше. Хочется выделить несколько обязательных.

Во-первых, это HTTP код ответа, который показывает роботу на то, в каком статусе находится запрашиваемая страница. Content-Type покажет роботу на то, какой документ, какой тип будет сейчас передаваться документа, и Content-Encoding, собственно, сжатие страниц, которые используются.

Распространенные HTTP-коды

Помимо HTTP-200 существуют еще и другие HTTP-коды.

Давайте рассмотрим их более подробно.

- HTTP-200 покажет роботу, что страница доступна, можно индексировать, включать в результаты поиска.

- HTTP-301 прямо укажет роботу на то, что страница переехала по какому-либо адресу и необходимо включать именно страницу по новому адресу в результаты поиска.

- Существует близкий по смыслу, но немножко отличается в обработке робота – это HTTP-302, временный редирект. Такое же временное перенаправление 303, они обрабатываются немножко роботом иначе. Если в 301 редиректе робот включает у нас конечную цель, то в данном случае робот будет включать наиболее короткий адрес из всей этой пары редиректов. Если окажется, что, например, старый адрес короче, чем новый адрес, на который происходит перенаправление, робот включит именно страницу по старому адресу.

- HTTP-304, 304 код ответа покажет роботу, что страница не менялась с момента последнего обращения к ней, и контент передаваться не будет, то есть робот получит только HTTP-ответ.

- HTTP-404 говорит о том, что страница была удалена с сайта, больше ее посещать не нужно.

- HTTP-503 сообщает о недоступности сервера в определенный момент времени. Например, если вы проводите какие-то профилактические работы, обновляете CMS, то есть ваш сайт в настоящий момент не доступен.

Добавление контента в базу

Помимо HTTP-ответа, возвращаемого вашим сервером, естественно, сервер должен вернуть еще и содержимое самой страницы. Так страница выглядит для обычного посетителя.

Красивенько, картиночки, какой-то текст, но в глазах робота все выглядит иначе.

Это начало контента, примерно маленькая часть, мы даже до текстового содержимого здесь не дошли. Видно, что куча скриптов находится, различных мета-тегов, информации. Из всего этого робот делает определенную выжимку и забирает только то, что необходимо ему, и что будет использоваться при ранжировании вашего сайта и отображении его в результатах поиска.

Робот получает HTTP-код, чтобы узнать, в каком статусе находится страница, получает текстовое содержимое, выделяет из этого содержимого различные мета-теги и получает так же дополнительные исходящие ссылки на какие-то внутренние и внешние страницы, которые так же нужно будет индексировать, если робот о них только узнал.

Индексирующий робот

После того, как получили контент от вашего сервера, его нужно включить в результаты поиска. В зависимости от того, какой индексирующий робот посещает ваш сайт, ваш сайт или ваша страница могут появиться в разное время. Здесь зависит от типа робота.

Условно можно разделить этих роботов на два типа:

- Быстрый индексирующий робот, который посещает страницы, как правило, новостных ресурсов, ресурсов, у которых информация быстро теряет свою актуальность, то есть те страницы, которые нужно проиндексировать именно сейчас и включить их в результаты поиска. Быстрый робот обходит не все ресурсы, не все страницы и не все страницы попадают в поисковую выдачу, но, если страница была проиндексирована быстрым роботом, как правило, она попадает в поиск в течение от нескольких минут до нескольких часов.

- Основной индексирующий робот посещает все страницы, которые ему известны, запрашивает весь контент и включает эти странички в результаты поисковой выдачи. Единственное, что это происходит медленнее и это происходит с обновлениями поисковой базы, как правило, на это требуется около двух недель.

Два робота, в зависимости от того, кто посетил, ваша страничка появилась в результатах поиска.

Как узнать, что страница в поиске

Как узнать, что та или иная страница появилась в поисковой выдаче? Лично я рекомендую использовать сервис Яндекс.Вебмастер, в частности инструмент «Проверить URL». Потому что помимо данных о том, что страница находится в выдаче, можно получить информацию и о том, когда робот последний раз посещал эту страницу, какой документ находится в результатах поиска, если страница отсутствует в выдаче, а также узнать по каким причинам она отсутствует в выдаче, будут ли какие-то рекомендации как ускорить процесс обхода и обновления данных.

Так же можно использовать несколько операторов для поисковой выдачи.

Первый оператор – это оператор url:, с помощью которого можно узнать, находится та или иная страница в результатах поиска. То есть сделали запрос вида url:*адрес страницы*, вставили в поисковую строку, нажали кнопочку «поиск» и получили результат. Если есть страница, значит страница находится в поиске. Все просто.

Так же есть оператор site:, с помощью которого можно узнать сколько страниц вообще вашего ресурса проиндексировано, какие страницы находятся в поиске. Здесь все то же самое. Вставили адрес сайта и оператор site:, ввели в строку запроса, нажали кнопку «поиск» и посмотрели результаты поисковой выдачи.

Источник — Александр Смирнов.

Сегодня я Вам расскажу о проблемах связанных с индексацией сайта и постараюсь помочь их решить. Приятного прочтения!

Почему не виден сайт в поиске?

Начинающие веб-мастера сталкиваются с проблемой: сайт создан и наполнен, а поисковик будто и не заметил новый ресурс. В таких случаях не стоит бить тревогу раньше времени, поисковым системам в любом случае необходимо время, чтобы увидеть сайт, начать его индексацию и внести его в свою базу.

Однако, если с момента запуска сайта прошло больше месяца, стоит задуматься о других причинах. Рекомендую сразу проверить сайт по чек-листу Яндекса, который поможет в индексировании и лучшем ранжировании ресурса.

17 причин того, что сайт не отображается

1. Время размещения сайта

Любой поисковой системе необходимо время, чтобы обнаружить новый сайт и запустить индексацию его содержимого. Чтобы помочь поисковикам быстрее заметить Ваш сайт, добавьте его самостоятельно:

Инструкция для Яндекс.Вебмастер:

Инструкция для Google Search Console:

2. Медленная индексация

Иногда положение в поисковой выдаче напрямую зависит от скорости индексации страниц, особенно с конкурентным контентом. Поэтому необходимо сразу устранять возможные задержки, которые могут быть вызваны следующими причинами:

- некорректная структура сайта;

- нарушенная навигация между страницами;

- отсутствие карты сайта;

- большой уровень вложенности страниц;

- некачественный хостинг.

Также на скорость индексации влияет наличие внешних ссылок на ресурс. Чтобы поисковые системы скорее нашли Ваш сайт, можно добавить на его новые страницы ссылки из часто обновляемых страниц в социальных сетях. Социальные ресурсы крайне динамичны, поэтому роботы поисковики практически не покидают их.

Статья по теме: «Как продвигать сайт с помощью ссылок»

3. Скрытость от поисковых систем

Иногда веб-мастера забывают об отключенной индексации в структуре кода сайта или в файлах, которые приложены к нему.

Файл robots.txt

Файл robots.txt располагается в корневом каталоге Вашего сайта и необходим, чтобы регулировать работу поисковых роботов. В этом файле Вы можете скрыть от них страницы сайта на время работы с ними, чтобы остановить процесс индексации.

Если в файле robots.txt есть строка:

Disallow: /blog/То содержимое данного раздела (в нашем случае раздела /blog) недоступно для роботов-индексаторов.

Для запуска индексации необходимо удалить из файла данную строку или заменить тег Disallow на обратный ему — Allow:

Allow: /blog/Блокировка в html-коде

Если html-коде страницы указан тег <noindex>, атрибут rel = “nofollow”

или мета-тег <meta name = “robots” content = “noindex, nofollow”>, то индексация страниц отключена.

- Тег <noindex> необходим, чтобы скрыть лишь часть содержимого, которое заключили внутрь него. При этом, этот тег виден только Яндексу и Рамблеру, Google не распознает этот тег, поэтому содержимое будет индексироваться;

- Атрибут rel = “nofollow” дает указание поисковому роботу не индексировать ссылку для которой он прописан.

- Мета-тег <meta name = “robots” content = “noindex, nofollow” / > располагается внутри тега <head> той страницы, которая должна быть недоступна для индексации.

Блокировка ресурса в CMS

Если Вы используете систему управления, в ее настройках есть пункт, который отвечает за скрытие ресурса от поисковых систем. Такая функция нужна для того, чтобы исключить индексацию страниц, пока сайт находится в разработке. Поэтому убедитесь, что Вы отключили этот атрибут перед запуском проекта и индексация началась.

Настройка сервера

Этот служебный файл располагается в корневом каталоге Вашего сайта .htaccess и может быть скрыт из-за пустого названия. Поэтому необходимо включить поиск скрытых файлов для его обнаружения. Если внутри файла прописаны строчки типа:

SetEnvIfNoCase User-Agent "^Googlebot" search_botТо содержимое скрыто от поисковых роботов. Удалив эти строчки, Вы разрешите доступ.

Заголовок X-Robots-Tag

X-Robots-Tag используется в качестве элемента http-ответа для заданного url. У этого заголовка есть те же атрибуты, что и у мета-тега robots, то есть noindex, nofollow.

Если в html-коде прописана строка:

X-Robots-Tag: noindexЗначит страница не доступна для роботов-индексаторов. Соответственно, чтобы открыть доступ необходимо удалить эту строчку кода.

В большинстве случаев исправление этих ошибок запускает процесс индексации, и сайт появляется в поисковой выдаче.

4. Плохая навигация на страницах

Сайт может плохо ранжироваться и индексироваться в поисковой выдаче по причине сложной структуры и вложенности страниц. Для избежания подобной ситуации рекомендуется сразу создать html карту сайта, чтобы поисковые системы смогли распознать структуру сайта и индексировать его содержимое.

5. Технические неполадки

Технические неполадки чаще всего возникают из-за невнимательности. Решить их легко, но не всегда просто заметить. Ошибки технического характера могут возникнуть из-за неправильной кодировки, неправильных редиректов, наличия ненужных символов в DOCTYPE, ошибки http-заголовка.

Статья по теме: «Как найти ошибки на сайте»

6. Блокировка ресурса государственными органами

Размещая на сайте запрещенную информацию, в том числе распространение пиратских материалов, нелицензионного программного обеспечения и контрафакта, будьте готовы к тому, что ресурс могут заблокировать.

Роскомнадзор, Прокуратура, Министерство Внутренних Дел, Федеральная Налоговая Служба, Генеральная Прокуратура и Роспотребнадзор в праве заблокировать Ваш сайт, если на нем будет размещена информация с сомнительным содержимым, например, призыв к суициду, экстремизм, рецепты запрещенных веществ и так далее. Также блокируются ресурсы с пропагандой или осуществлением противозаконной деятельности. Например, азартные игры, продажа наркотиков, оружия, санкционных товаров.

Чтобы узнать о блокировке, достаточно перейти на сайт: вместо содержимого будет стоять заглушка со ссылкой на документ.

7. Наличие большого количества рекламы

Наличие блоков с навязчивой рекламой в большом количестве, может спровоцировать рост отказов и снижение среднего времени пребывания на сайте. В дальнейшем из-за ухудшения поведенческих факторов сайт падает в выдаче.

На сайте рекомендуется размещать рекламные объявления от двух компаний — Яндекс Директ и Google Adsense. Скорее всего, поисковые системы не тронут такую рекламу и сайт останется в поисковой выдаче.

Статья по теме: «7 методов воздействия на поведенческие факторы для продвижения сайта»

8. Фильтр поисковых систем

С помощью фильтров поисковые системы оценивают соответствие сайта их правилам. На основании этой оценки сайты ранжируются в поисковой выдаче. У двух главных поисковых систем — Яндекс и Google, таких фильтров много. Они встроены в алгоритм поисковой системы и дают сигнал, если сайт не соответствует требованиям. После этого принимается решение о наложении санкций: снижение позиции ресурса в выдаче или его блокировка.

Рекомендуется подключать свой сайт к сервисам типа Яндекс.Вебмастера. Они позволят Вам следить за изменениями, которые связаны с посещаемостью, статусом индексирования и другими полезными данными.

9. Низкий процент уникальности материалов на сайте

Если на Вашем сайте расположен материал, который частично или полностью скопирован с других источников, поисковая система считает, что Ваш ресурс не несет пользы для людей. Как следствие, Ваш сайт либо теряет позиции в поисковой выдаче, либо блокируется.

Для разных типов текста поисковыми системами допускается разная уникальность:

- уникальность объемных текстов должна быть 80-100%;

- для коротких текстов, например, новостных записей и дублирующихся описаний товаров, допускается уникальность 50%.

Проверить уникальность текста можно с помощью антиплагиата на бирже Text.ru.

Статья по теме: «Как продвигать сайт с помощью статей»

10. Наличие множества страниц-клонов

Роботы поисковых систем не очень любят дублирующийся контент. Поэтому, сайты, которые пренебрегают этим и создают копии страниц, чтобы создать видимость наполненности, чаще всего не выходят в ТОП поисковой выдачи.

11. Низкая посещаемость и небольшой объем информации на сайте

Отсутствие на сайте набора ключевых фраз, качественного и достаточного наполнения его контентом, а также плохая реализация проекта в целом провоцирует низкую посещаемость ресурса, из-за которой он не может подняться в поисковой выдаче среди конкурентов. Чтобы исправить эту ситуацию, необходимо проанализировать поисковые запросы пользователей по Вашей тематике. Сделать это можно с помощью сервиса Яндекс Wordstat, который предоставит все запросы пользователей, включающих заданное слово или словосочетание.

Статья по теме: «Как продвигать сайт в поисковых системах»

12. Большая конкуренция

Когда Вы заполняете сайт, используя только высокочастотные запросы, то скорее всего Вам придется конкурировать за место в ТОПе. Это связано прежде всего с тем, что Ваши конкуренты уже использовали этот ключ ранее. В результате их ресурс выше, если пользователи чаще его посещают.

13. Нет мобильной версии ресурса

Невозможно отрицать, что за последние годы трафик с мобильных устройств увеличился. Исследование компании MediaScope подтверждает это, говоря об использовании мобильного интернета в 61% случаев. Чтобы удовлетворить запросы большей аудитории был создан поисковый алгоритм, который называется Mobile-first indexing. Новые изменения направлены на приоритетную выдачу сайтов, которые оптимизированы под мобильные устройства.

14. Низкая скорость загрузки страниц

От скорости загрузки страницы также зависит позиция сайта в поиске. Логика поисковых систем проста: если пользователи долго ждут загрузку и покидают страницу, так и не дождавшись — ресурс плохой и необходимо понизить его в выдаче.

Оптимальной скоростью принято считать время загрузки не более 3-х секунд.

15. Содержимое не соответствует заявленному

Если на ресурсе располагается материал, который не относится к заголовку страницы — Вероятнее всего сайт даже не попадет в топ, если заголовки нерелевантны содержанию.

16. Переоптимизация

Ваш сайт может упасть в поисковой выдаче из-за высокой плотности вхождения ключевых слов. Такое случается, когда Ваш сайт попадает под алгоритм Яндекса Баден-Баден. Он следит за качеством SEO-текста, если тот плохой, то позиции сайта в поисковой выдаче ухудшаются.

Итог

Алгоритмы поисковых систем постоянно совершенствуются, поэтому необходимо проводить тщательную работу с ресурсом, чтобы он оказался в поисковой выдаче:

- Проверьте файлы robots.txt, htaccess, sitemap.xml на наличие блокировки, а также проверьте код страниц на наличие мета-тега NOINDEX и атрибут сокрытия ресурса в CMS;

- Для решения технических неполадок обратитесь к специалистам, которые смогут грамотно оптимизировать сайт;

- Если сайт попал под фильтр, выясните под какой именно и устраните причину. Например, откажитесь от изобилия рекламы или снизьте количество ключей на странице:

- Если сайт находится в поисковой выдаче слишком глубоко, начните комплексную работу по продвижению ресурса;

- Постоянно анализируйте и оценивайте состояние сайта с помощью Яндекс.Вебмастер, Google Search Console, а также Яндекс.Метрика и Google Analytics.

Общая оценка

/ 5. Всего проголосовало