Екатерина Владимировна Мосина

Эксперт по предмету «Физика»

Задать вопрос автору статьи

Понятие энтропии ввел Р. Клаузиус в 1865 г.

Энтропия – функция состояния

Для того чтобы выяснить в чем состоит физический смысл энтропии, рассмотрим изотермический процесс и приведенное количество теплоты в этом процессе на очень малом участке этого процесса -$frac{delta Q}{T}$, где $delta Q$ – количество теплоты, которое получает тело, $T$ – температура тела.

Приведенное количество теплоты, которое сообщается телу в любом обратимом круговом процессе:

$oint {frac{delta Q}{T}=0left( 1 right).}$

Равенство нулю левой части выражения (1), который берут по замкнутому контуру, означает, что отношение δQ/T – это полный дифференциал некоторой функции состояния системы, которая не зависит от формы пути перехода системы из начального состояния в конечное.

Введем следующее обозначение:

$frac{delta Q}{T}=dSleft( 2 right)$.

Сдай на права пока

учишься в ВУЗе

Вся теория в удобном приложении. Выбери инструктора и начни заниматься!

Получить скидку 3 000 ₽

Определение 1

Энтропией ($S$) называют функцию состояния, дифференциал которой равен приведенному количеству тепла на малом участке термодинамического процесса, которое передано системе в этом процессе.

Для обратимых процессов изменение энтропии равно нулю:

$Delta S=0left( 3 right)$.

Если выполняется необратимый процесс, то энтропия системы увеличивается:

$Delta S$>$0, left( 4 right)$.

Все реальные процессы являются необратимыми, поэтому в реальности энтропия изолированной системы способна только расти. Она становится максимальной в состоянии термодинамического равновесия.

Замечание 1

Формулы (3) и (4) выполняются только в том случае, если система замкнута. В том случае, если термодинамическая система может обмениваться теплом с внешней средой, то поведение энтропии может быть любым.

«Энтропия простыми словами с формулами» 👇

Неравенство Клаузиуса

Выражения (3) и (4) объединяются в неравенство, которое называется неравенством Клаузиуса:

$Delta Sge left( 5 right)$.

Неравенство Клаузиуса означает, что для замкнутой системы энтропия способна увеличиваться (если процесс необратим), или не изменяется (процесс обратим).

Неравенство Клаузиуса является математической записью второго начала термодинамики.

Знак изменения энтропии указывает направление течения процесса в обратимом процессе.

Во всех ординарных термодинамических системах при стремлении температуры к бесконечности, внутренняя энергия системы безгранично растет. Абсолютная температура при равновесных процессах может только большей нуля, следовательно, если система подвергается нагреву, то:

$dS$>$0.$

При уменьшении температуры системы имеем:

$dS$

Изменение энтропии в равновесном процессе

Допустим, что термодинамическая система совершает равновесный переход из состояния 1 в состояние 2, тогда изменение энтропии найдем как:

$Delta S=S_{2}-S_{1}=intlimits_1^2 {frac{delta Q}{T}=intlimits_1^2{frac{dU+delta A}{T}left( 6 right),} }$

где $dU$ – изменение внутренней энергии в рассматриваемом процессе; $delta A$ – работа, выполняемая в этом процессе.

Выражение (6) способно определить энтропию с точностью до аддитивной константы. Это означает то, что физическим смыслом обладает не энтропия, а ее разность.

$S=intlimits_{обр} {frac{delta Q}{T}+const, left( 7 right).}$

Свойства энтропии

Замечание 2

Энтропия – аддитивная величина. Это означает, что энтропию системы можно найти как сумму энтропий тел, которые эту систему образуют.

Свойство аддитивности имеют:

- масса;

- внутренняя энергия;

- количество теплоты.

Аддитивными не являются:

- объем,

- температура,

- давление.

Определение 2

Термодинамический процесс, в котором энтропия остается постоянной, называется изоэнтропийным процессом.

Так, при обратимом адиабатном процессе мы имеем:

$delta Q=0to S=const.$

Энтропия однородной термодинамической системы – это функция пары независимых параметров, характеризующих ее состояние, например, $ p,V$ или $ T,V$ при $ m=const$.

В этой связи можно записать, что:

$left( V,T right)=intlimits_0^T {C_{V}frac{dT}{T}+S_{01, }left( 8right).}$

или

$Sleft( p,T right)=intlimits_0^T {C_{p}frac{dT}{T}+S_{02, }left( 9right),}$

где $intlimits_0^T {C_{V}frac{dT}{T},}$ – находят для обратимого изобарного процесса; $intlimits_0^T {C_{p}frac{dT}{T}}$ – вычисляют для обратимого изохорного процесса, при изменении температуры от 0К до $T$; $C_V$ – теплоемкость изохорного процесса; $C_p$ – теплоемкость при изобарном процессе; $S_{01 }=S(V,0)$ ; $S_{02 }=S(p,0).$

Статистический смысл энтропии

Допустим, что энтропия в обратимом процессе претерпевает изменения под воздействием внешних условий, которые оказывают влияние на систему. Механизм действия этих условий на энтропию можно сформулировать так:

- Внешние условия определяют микросостояния, которые доступны системе, а также их количество.

- В рамках доступных для системы микросостояний, она приходит в состояние равновесия.

- Энтропия получает соответствующее значение. Получается, что величина энтропии идет за изменением внешних условий, принимая наибольшую величину, совместимую с внешними условиями.

Глубокий смысл энтропии раскрывается в статистической физике. Энтропия связана с термодинамической вероятностью состояния системы.

Определение 3

Термодинамическая вероятность ($W$) – количество способов, реализации данного состояния термодинамической системы. Или иначе, это число микросостояний, реализующих данное макросостояние.

Термодинамическая вероятность всегда больше или равна единице.

Энтропия системы и термодинамическая вероятность связаны между собой формулой Больцмана:

$S=k ln(W) (10),$

где $k$ – постоянная Больцмана.

- Формула (10) означает, что энтропия определена натуральным логарифмом количества микросостояний, которые реализуют рассматриваемое макросостояние.

- Согласно формуле Больцмана, энтропия – это мера вероятности состояния термодинамической системы.

- Говорят, что энтропия – мера беспорядка системы. Это статистическая интерпретация энтропии. Большее количество микросостояний, которое осуществляет макросостояние, соответствует большей энтропии.

- Если система находится в состоянии термодинамического равновесия, что соответствует наиболее вероятному состоянию системы, количество микросостояний наибольшее, энтропия в этом случае максимальна.

- Поскольку при необратимых процессах энтропия увеличивается, при статистическом толковании это значит, процессы в замкнутой системе проходят в направлении роста количества микросостояний. Это означает, что процессы идут от менее вероятных к более вероятным, до достижения вероятностью максимальной величины.

Замечание 3

Все статистические законы справедливы для систем, которые составлены из огромного количества частиц. Но эти законы могут нарушаться с небольшим числом частиц. Для систем с малым количеством частиц возможны флуктуации, это значит, что энтропия и термодинамическая вероятность состояний замкнутой системы на некотором временном отрезке могут убывать, а не расти или не изменяться.

Находи статьи и создавай свой список литературы по ГОСТу

Поиск по теме

Понятие

об энтропии

можно ввести термодинамически,

если связывать рассеивание энергии с

количеством теплоты, поступившей в

систему, или статистически,

если придерживаться точки зрения, что

рассеивание энергии среди компонентов

системы может быть вычислено.

Энтропия

(от греческого

entropia – поворот, превращение) – понятие,

впервые введенное в термодинамике для

определения

меры необратимости рассеивания энергии.

В статистической

физике энтропия

– мера

вероятности осуществления какого-либо

макроскопического состояния.

В

термодинамике понятие «энтропия»

введено Р. Клаузиусом в 1865 году.

Клаузиус показал, что процесс превращения

теплоты в работу подчиняется второму

закону термодинамики, который можно

сформулировать строго математически,

если ввести новую

функцию

состояния – энтропию S.

Энтропия была введена на основе

доказательства теоремы Карно о

независимости термического КПД обратимого

цикла Карно от природы рабочего тела.

Здесь напомним, что КПД тепловой машины

при работе по

обратимому циклу

определяется выражением (3.1), которое

можно записать в таком виде

. (3.6)

По

принятой в термодинамике системе знаков

Q2 < 0,

поэтому уравнение (3.6) можно записать

. (3.7)

Для

элементарного

цикла Карно,

осуществляемого между температурами

Т1

и Т2,

получим

.

Величину

δQ/T

называют

приведенной

теплотой.

Любой обратимый

цикл можно заменить бесконечно большим

числом бесконечно малых (элементарных)

циклов Карно.

Суммирование этих циклов дает

.

Если

i → ∞,

то суммирование превращается в интеграл

по замкнутому контуру

, (3.8)

т.е.

алгебраическая

сумма приведенных теплот любого

обратимого кругового процесса равна

нулю. Но если

интеграл по замкнутому контуру равен

нулю, то подынтегральное выражение есть

полный

дифференциал

некоторой

функции состояния системы. Итак,

,

где

S – функция

состояния системы – энтропия.

Приведенные

рассуждения применимы к любому веществу

и к любому обратимому циклу. Поэтому

каждая система

в любом ее состоянии имеет определенное

значение энтропии.

Можно рассуждать

и так: для простой системы, совершающей

только работу расширения, справедливо:

.

Если

система – 1 моль идеального газа, то

,

.

Если T

и V

– независимые параметры, то можно найти

перекрестные проиводные и убедиться в

том, что они равны:

,

Следовательно,

для идеального газа приведенная теплота

обладает свойствами

полного дифференциала и, значит, энтропия

есть функция состояния.

Распространение последнего выражения

на все системы можно рассматривать как

второй закон термодинамики.

Далее,

разность энтропий системы в двух

произвольных состояниях 1 и 2 равна

. (3.9)

Интегрирование

ведется вдоль пути любого обратимого

процесса, связывающего состояния 1 и 2,

при этом приращение энтропии ∆S

не зависит от пути интегрирования.

Таким

образом, существует

однозначная функция состояния S –

энтропия, которая при обратимых

адиабатических процессах (Q = 0)

остается постоянной.

Процессы, в

которых энтропия остается постоянной,

называются

изоэнтропийными.

Для

необратимых

процессов

интеграл от приведенной теплоты δQ/T

по замкнутому контуру отрицателен

. (3.10)

Тогда справедливо,

что

, (3.11)

поэтому

энтропия

адиабатически изолированной системы

при необратимых процессах может только

возрастать.

Таким образом, энтропия

определяет характер процессов в

адиабатических условиях:

возможны

только такие процессы, при которых

энтропия либо остается неизменной

(обратимые процессы), либо

возрастает

(необратимые процессы). При этом не

обязательно, чтобы возрастала энтропия

каждого из тел, участвующих в процессе.

Увеличивается общая сумма энтропий

участвующих в процессе тел:

.

В общем виде

второй закон термодинамики записывается

, (3.12)

где

знак равенства относится к обратимым

процессам, а знак неравенства – к

необратимым процессам.

Напомним, что в

обратимых процессах система выполняет

максимальную работу, а потерянная работа

в реальных процессах всегда больше

нуля:

. (3.13)

Из

закона сохранения энергии следует, что

энергетический эквивалент «потерянной»

работы не может исчезнуть совсем. Опыт

показывает, что «потерянная»

работа чаще всего переходит в теплоту.

Тогда в балансе теплоты и работы при

необратимых процессах следует учитывать

дополнительный внутренний источник

теплоты:

(3.14)

Величину

δQ*

называют некомпенсированной

теплотой

независимо

от физической природы работы.

Переход

потерянной работы в теплоту

– это

особеность теплоты как микроскопически

неупорядоченной формы передачи энергии.

Поэтому строго неравенство (3.12) следует

записывать так:

, (3.15)

где

δQe

– теплота, которой система обменивается

с окружающей средой.

Особенность

теплообмена при необратимых процессах

состоит в появлении нового источника

теплоты – некомпенсированной теплоты.

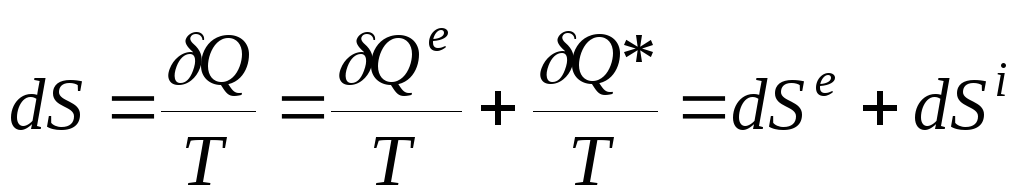

Уравнение

баланса энтропии можно выразить

равенством

, (3.16)

или

где

вклад dSe

связан с переносом тепла извне (из

окружающей среды), а вклад dSi

обусловлен необратимыми изменениями

внутри системы:

dS i

> 0 для необратимых процессов и dS i

= 0 для обратимых процессов.

Статистическая

физика связывает энтропию с вероятностью

осуществления данного макроскопического

состояния системы. Энтропия определяется

через логарифм статистического веса Ω

(термодинамическая вероятность) данного

равновесного состояния:

, (3.18)

где

Ω(ε,N)

– число квантовомеханических уровней

энергии в узком интервале энергии Δε

вблизи значения энергии ε

системы из

N

частиц; в классической статистической

физике Ω

– величина объема в фазовом пространстве

системы при заданных ε

и N.

Впервые связь энтропии с вероятностью

состояния системы установил

Л. Больцман

в 1872 году:

возрастание

энтропии системы обусловлено ее переходом

из менее вероятного состояния в более

вероятное.

Изолированная система эволюционирует

в направлении наиболее вероятного

распределения энергии по отдельным

подсистемам.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

From Wikipedia, the free encyclopedia

In classical thermodynamics, entropy (from Greek τρoπή (tropḗ) ‘transformation’) is a property of a thermodynamic system that expresses the direction or outcome of spontaneous changes in the system. The term was introduced by Rudolf Clausius in the mid-19th century to explain the relationship of the internal energy that is available or unavailable for transformations in form of heat and work. Entropy predicts that certain processes are irreversible or impossible, despite not violating the conservation of energy.[1] The definition of entropy is central to the establishment of the second law of thermodynamics, which states that the entropy of isolated systems cannot decrease with time, as they always tend to arrive at a state of thermodynamic equilibrium, where the entropy is highest. Entropy is therefore also considered to be a measure of disorder in the system.

Ludwig Boltzmann explained the entropy as a measure of the number of possible microscopic configurations Ω of the individual atoms and molecules of the system (microstates) which correspond to the macroscopic state (macrostate) of the system. He showed that the thermodynamic entropy is k ln Ω, where the factor k has since been known as the Boltzmann constant.

Concept[edit]

Figure 1. A thermodynamic model system

Differences in pressure, density, and temperature of a thermodynamic system tend to equalize over time. For example, in a room containing a glass of melting ice, the difference in temperature between the warm room and the cold glass of ice and water is equalized by energy flowing as heat from the room to the cooler ice and water mixture. Over time, the temperature of the glass and its contents and the temperature of the room achieve a balance. The entropy of the room has decreased. However, the entropy of the glass of ice and water has increased more than the entropy of the room has decreased. In an isolated system, such as the room and ice water taken together, the dispersal of energy from warmer to cooler regions always results in a net increase in entropy. Thus, when the system of the room and ice water system has reached thermal equilibrium, the entropy change from the initial state is at its maximum. The entropy of the thermodynamic system is a measure of the progress of the equalization.

Many irreversible processes result in an increase of entropy. One of them is mixing of two or more different substances, occasioned by bringing them together by removing a wall that separates them, keeping the temperature and pressure constant. The mixing is accompanied by the entropy of mixing. In the important case of mixing of ideal gases, the combined system does not change its internal energy by work or heat transfer; the entropy increase is then entirely due to the spreading of the different substances into their new common volume.[2]

From a macroscopic perspective, in classical thermodynamics, the entropy is a state function of a thermodynamic system: that is, a property depending only on the current state of the system, independent of how that state came to be achieved. Entropy is a key ingredient of the Second law of thermodynamics, which has important consequences e.g. for the performance of heat engines, refrigerators, and heat pumps.

Definition[edit]

According to the Clausius equality, for a closed homogeneous system, in which only reversible processes take place,

With T being the uniform temperature of the closed system and delta Q the incremental reversible transfer of heat energy into that system.

That means the line integral

A state function S, called entropy, may be defined which satisfies

Entropy measurement[edit]

The thermodynamic state of a uniform closed system is determined by its temperature T and pressure P. A change in entropy can be written as

The first contribution depends on the heat capacity at constant pressure CP through

This is the result of the definition of the heat capacity by δQ = CP dT and T dS = δQ. The second term may be rewritten with one of the Maxwell relations

and the definition of the volumetric thermal-expansion coefficient

so that

With this expression the entropy S at arbitrary P and T can be related to the entropy S0 at some reference state at P0 and T0 according to

In classical thermodynamics, the entropy of the reference state can be put equal to zero at any convenient temperature and pressure. For example, for pure substances, one can take the entropy of the solid at the melting point at 1 bar equal to zero. From a more fundamental point of view, the third law of thermodynamics suggests that there is a preference to take S = 0 at T = 0 (absolute zero) for perfectly ordered materials such as crystals.

S(P, T) is determined by followed a specific path in the P-T diagram: integration over T at constant pressure P0, so that dP = 0, and in the second integral one integrates over P at constant temperature T, so that dT = 0. As the entropy is a function of state the result is independent of the path.

The above relation shows that the determination of the entropy requires knowledge of the heat capacity and the equation of state (which is the relation between P,V, and T of the substance involved). Normally these are complicated functions and numerical integration is needed. In simple cases it is possible to get analytical expressions for the entropy. In the case of an ideal gas, the heat capacity is constant and the ideal gas law PV = nRT gives that αVV = V/T = nR/p, with n the number of moles and R the molar ideal-gas constant. So, the molar entropy of an ideal gas is given by

In this expression CP now is the molar heat capacity.

The entropy of inhomogeneous systems is the sum of the entropies of the various subsystems. The laws of thermodynamics hold rigorously for inhomogeneous systems even though they may be far from internal equilibrium. The only condition is that the thermodynamic parameters of the composing subsystems are (reasonably) well-defined.

Temperature-entropy diagrams[edit]

Fig.2 Temperature–entropy diagram of nitrogen. The red curve at the left is the melting curve. The red dome represents the two-phase region with the low-entropy side the saturated liquid and the high-entropy side the saturated gas. The black curves give the TS relation along isobars. The pressures are indicated in bar. The blue curves are isenthalps (curves of constant enthalpy). The values are indicated in blue in kJ/kg.

Entropy values of important substances may be obtained from reference works or with commercial software in tabular form or as diagrams. One of the most common diagrams is the temperature-entropy diagram (TS-diagram). For example, Fig.2 shows the TS-diagram of nitrogen,[3] depicting the melting curve and saturated liquid and vapor values with isobars and isenthalps.

Entropy change in irreversible transformations[edit]

We now consider inhomogeneous systems in which internal transformations (processes) can take place. If we calculate the entropy S1 before and S2 after such an internal process the Second Law of Thermodynamics demands that S2 ≥ S1 where the equality sign holds if the process is reversible. The difference Si = S2 − S1 is the entropy production due to the irreversible process. The Second law demands that the entropy of an isolated system cannot decrease.

Suppose a system is thermally and mechanically isolated from the environment (isolated system). For example, consider an insulating rigid box divided by a movable partition into two volumes, each filled with gas. If the pressure of one gas is higher, it will expand by moving the partition, thus performing work on the other gas. Also, if the gases are at different temperatures, heat can flow from one gas to the other provided the partition allows heat conduction. Our above result indicates that the entropy of the system as a whole will increase during these processes. There exists a maximum amount of entropy the system may possess under the circumstances. This entropy corresponds to a state of stable equilibrium, since a transformation to any other equilibrium state would cause the entropy to decrease, which is forbidden. Once the system reaches this maximum-entropy state, no part of the system can perform work on any other part. It is in this sense that entropy is a measure of the energy in a system that cannot be used to do work.

An irreversible process degrades the performance of a thermodynamic system, designed to do work or produce cooling, and results in entropy production. The entropy generation during a reversible process is zero. Thus entropy production is a measure of the irreversibility and may be used to compare engineering processes and machines.

Thermal machines[edit]

Figure 3: Heat engine diagram. The system, discussed in the text, is indicated by the dotted rectangle. It contains the two reservoirs and the heat engine. The arrows define the positive directions of the flows of heat and work.

Clausius’ identification of S as a significant quantity was motivated by the study of reversible and irreversible thermodynamic transformations. A heat engine is a thermodynamic system that can undergo a sequence of transformations which ultimately return it to its original state. Such a sequence is called a cyclic process, or simply a cycle. During some transformations, the engine may exchange energy with its environment. The net result of a cycle is

- mechanical work done by the system (which can be positive or negative, the latter meaning that work is done on the engine),

- heat transferred from one part of the environment to another. In the steady state, by the conservation of energy, the net energy lost by the environment is equal to the work done by the engine.

If every transformation in the cycle is reversible, the cycle is reversible, and it can be run in reverse, so that the heat transfers occur in the opposite directions and the amount of work done switches sign.

Heat engines[edit]

Consider a heat engine working between two temperatures TH and Ta. With Ta we have ambient temperature in mind, but, in principle it may also be some other low temperature. The heat engine is in thermal contact with two heat reservoirs which are supposed to have a very large heat capacity so that their temperatures do not change significantly if heat QH is removed from the hot reservoir and Qa is added to the lower reservoir. Under normal operation TH > Ta and QH, Qa, and W are all positive.

As our thermodynamical system we take a big system which includes the engine and the two reservoirs. It is indicated in Fig.3 by the dotted rectangle. It is inhomogeneous, closed (no exchange of matter with its surroundings), and adiabatic (no exchange of heat with its surroundings). It is not isolated since per cycle a certain amount of work W is produced by the system given by the first law of thermodynamics

We used the fact that the engine itself is periodic, so its internal energy has not changed after one cycle. The same is true for its entropy, so the entropy increase S2 − S1 of our system after one cycle is given by the reduction of entropy of the hot source and the increase of the cold sink. The entropy increase of the total system S2 — S1 is equal to the entropy production Si due to irreversible processes in the engine so

The Second law demands that Si ≥ 0. Eliminating Qa from the two relations gives

The first term is the maximum possible work for a heat engine, given by a reversible engine, as one operating along a Carnot cycle. Finally

This equation tells us that the production of work is reduced by the generation of entropy. The term TaSi gives the lost work, or dissipated energy, by the machine.

Correspondingly, the amount of heat, discarded to the cold sink, is increased by the entropy generation

These important relations can also be obtained without the inclusion of the heat reservoirs. See the article on entropy production.

Refrigerators[edit]

The same principle can be applied to a refrigerator working between a low temperature TL and ambient temperature. The schematic drawing is exactly the same as Fig.3 with TH replaced by TL, QH by QL, and the sign of W reversed. In this case the entropy production is

and the work needed to extract heat QL from the cold source is

The first term is the minimum required work, which corresponds to a reversible refrigerator, so we have

i.e., the refrigerator compressor has to perform extra work to compensate for the dissipated energy due to irreversible processes which lead to entropy production.

See also[edit]

- Entropy

- Enthalpy

- Entropy production

- Fundamental thermodynamic relation

- Thermodynamic free energy

- History of entropy

- Entropy (statistical views)

References[edit]

- ^ Lieb, E. H.; Yngvason, J. (1999). «The Physics and Mathematics of the Second Law of Thermodynamics». Physics Reports. 310 (1): 1–96. arXiv:cond-mat/9708200. Bibcode:1999PhR…310….1L. doi:10.1016/S0370-1573(98)00082-9. S2CID 119620408.

- ^ Notes for a «Conversation About Entropy»

- ^ Figure composed with data obtained with RefProp, NIST Standard Reference Database 23

Further reading[edit]

- E.A. Guggenheim Thermodynamics, an advanced treatment for chemists and physicists North-Holland Publishing Company, Amsterdam, 1959.

- C. Kittel and H. Kroemer Thermal Physics W.H. Freeman and Company, New York, 1980.

- Goldstein, Martin, and Inge F., 1993. The Refrigerator and the Universe. Harvard Univ. Press. A gentle introduction at a lower level than this entry.