From Wikipedia, the free encyclopedia

The sample mean (or «empirical mean») and the sample covariance are statistics computed from a sample of data on one or more random variables.

The sample mean is the average value (or mean value) of a sample of numbers taken from a larger population of numbers, where «population» indicates not number of people but the entirety of relevant data, whether collected or not. A sample of 40 companies’ sales from the Fortune 500 might be used for convenience instead of looking at the population, all 500 companies’ sales. The sample mean is used as an estimator for the population mean, the average value in the entire population, where the estimate is more likely to be close to the population mean if the sample is large and representative. The reliability of the sample mean is estimated using the standard error, which in turn is calculated using the variance of the sample. If the sample is random, the standard error falls with the size of the sample and the sample mean’s distribution approaches the normal distribution as the sample size increases.

The term «sample mean» can also be used to refer to a vector of average values when the statistician is looking at the values of several variables in the sample, e.g. the sales, profits, and employees of a sample of Fortune 500 companies. In this case, there is not just a sample variance for each variable but a sample variance-covariance matrix (or simply covariance matrix) showing also the relationship between each pair of variables. This would be a 3×3 matrix when 3 variables are being considered. The sample covariance is useful in judging the reliability of the sample means as estimators and is also useful as an estimate of the population covariance matrix.

Due to their ease of calculation and other desirable characteristics, the sample mean and sample covariance are widely used in statistics to represent the location and dispersion of the distribution of values in the sample, and to estimate the values for the population.

Definition of the sample mean[edit]

The sample mean is the average of the values of a variable in a sample, which is the sum of those values divided by the number of values. Using mathematical notation, if a sample of N observations on variable X is taken from the population, the sample mean is:

Under this definition, if the sample (1, 4, 1) is taken from the population (1,1,3,4,0,2,1,0), then the sample mean is

If the statistician is interested in K variables rather than one, each observation having a value for each of those K variables, the overall sample mean consists of K sample means for individual variables. Let

column vectors, each with K entries, with the K×1 column vector giving the i-th observations of all variables being denoted

The sample mean vector

Thus, the sample mean vector contains the average of the observations for each variable, and is written

Definition of sample covariance[edit]

The sample covariance matrix is a K-by-K matrix ![textstyle mathbf{Q}=left[ q_{jk}right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/08114250f024d29a873000449af7b9964afd2234)

where

variable and the kth variable of the population underlying the data.

In terms of the observation vectors, the sample covariance is

Alternatively, arranging the observation vectors as the columns of a matrix, so that

,

which is a matrix of K rows and N columns.

Here, the sample covariance matrix can be computed as

,

where

If the observations are arranged as rows instead of columns, so

in the appropriate places yields

Like covariance matrices for random vector, sample covariance matrices are positive semi-definite. To prove it, note that for any matrix

Unbiasedness[edit]

The sample mean and the sample covariance matrix are unbiased estimates of the mean and the covariance matrix of the random vector

using the population mean, has

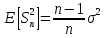

The maximum likelihood estimate of the covariance

for the Gaussian distribution case has N in the denominator as well. The ratio of 1/N to 1/(N − 1) approaches 1 for large N, so the maximum likelihood estimate approximately equals the unbiased estimate when the sample is large.

Distribution of the sample mean[edit]

For each random variable, the sample mean is a good estimator of the population mean, where a «good» estimator is defined as being efficient and unbiased. Of course the estimator will likely not be the true value of the population mean since different samples drawn from the same distribution will give different sample means and hence different estimates of the true mean. Thus the sample mean is a random variable, not a constant, and consequently has its own distribution. For a random sample of N observations on the jth random variable, the sample mean’s distribution itself has mean equal to the population mean

The arithmetic mean of a population, or population mean, is often denoted μ.[2] The sample mean

and the variance of the sample mean is

If the samples are not independent, but correlated, then special care has to be taken in order to avoid the problem of pseudoreplication.

If the population is normally distributed, then the sample mean is normally distributed as follows:

If the population is not normally distributed, the sample mean is nonetheless approximately normally distributed if n is large and σ2/n < +∞. This is a consequence of the central limit theorem.

Weighted samples[edit]

In a weighted sample, each vector

(If they are not, divide the weights by their sum).

Then the weighted mean vector

and the elements

[3]

If all weights are the same,

Criticism[edit]

The sample mean and sample covariance are not robust statistics, meaning that they are sensitive to outliers. As robustness is often a desired trait, particularly in real-world applications, robust alternatives may prove desirable, notably quantile-based statistics such as the sample median for location,[4] and interquartile range (IQR) for dispersion. Other alternatives include trimming and Winsorising, as in the trimmed mean and the Winsorized mean.

See also[edit]

- Estimation of covariance matrices

- Scatter matrix

- Unbiased estimation of standard deviation

References[edit]

- ^ Richard Arnold Johnson; Dean W. Wichern (2007). Applied Multivariate Statistical Analysis. Pearson Prentice Hall. ISBN 978-0-13-187715-3. Retrieved 10 August 2012.

- ^ Underhill, L.G.; Bradfield d. (1998) Introstat, Juta and Company Ltd. ISBN 0-7021-3838-X p. 181

- ^ Mark Galassi, Jim Davies, James Theiler, Brian Gough, Gerard Jungman, Michael Booth, and Fabrice Rossi. GNU Scientific Library — Reference manual, Version 2.6, 2021.

Section Statistics: Weighted Samples - ^ The World Question Center 2006: The Sample Mean, Bart Kosko

Сейчас Вы научитесь находить числовые характеристики статистического распределения выборки. Примеры подобраны на основании индивидуальных заданий по теории вероятностей, которые задавали студентам ЛНУ им. И. Франка. Ответы послужат для студентов математических дисциплин хорошей инструкцией на экзаменах и тестах. Подобные решения точно используют в обучении экономисты , поскольку именно им задавали все что приведено ниже. ВУЗы Киева, Одессы, Харькова и других городов Украины имеют подобную систему обучения поэтому много полезного для себя должен взять каждый студент. Задачи различной тематики связаны между собой линками в конце статьи, поэтому можете найти то, что Вам нужно.

Индивидуальное задание 1

Вариант 11

Задача 1. Построить статистическое распределение выборки, записать эмпирическую функцию распределения и вычислить такие числовые характеристики:

- выборочное среднее;

- выборочную дисперсию;;

- подправленную дисперсию;

- выборочное среднее квадратичное отклонение;

- подправленное среднее квадратичное отклонение;

- размах выборки;

- медиану;

- моду;

- квантильное отклонение;

- коэффициент вариации;

- коэффициент асимметрии;

- эксцесс для выборки:

Выборка задана рядом 11, 9, 8, 7, 8, 11, 10, 9, 12, 7, 6, 11, 8, 7, 10, 9, 11, 8, 13, 8.

Решение:

Запишем выборку в виде вариационного ряда (в порядке возрастания):

6; 7; 7; 7; 8; 8; 8; 8; 8; 9; 9; 9; 10; 10; 11; 11; 11; 11; 12; 13.

Далее записываем статистическое распределение выборки в виде дискретного статистического распределения частот:

Эмпирическую функцию распределения определим по формуле

Здесь nx – количество элементов выборки которые меньше х. Используя таблицу и учитывая что объем выборки равен n = 20, запишем эмпирическую функцию распределения:

Далее вычислим числовые характеристики статистического распределения выборки.

Выборочное среднее вычисляем по формуле

Выборочную дисперсию находим по формуле

Выборочное среднее, что фигурирует в формуле дисперсии в квадрате найдено выше. Остается все подставить в формулу

Подправленную дисперсию вычисляем согласно формулы

Выборочное среднее квадратичное отклонение вычисляем по формуле

Подправленное среднее квадратичное отклонение вычисляем как корень из подправленной дисперсии

Размах выборки вычисляем как разность между наибольшим и наименьшим значениями вариант, то есть:

Медиану находим по 2 формулам:

если число n — нечетное.

Здесь берем индексы в xi согласно нумерации варианта в вариационном ряду.

В нашем случае n = 20, поэтому

Мода – это варианта которая в вариационном ряду случается чаще всего, то есть

Квантильное отклонение находят по формуле

где – первый квантиль,

– третий квантиль.

Квантили получаем при разбивке вариационного ряда на 4 равные части.

Для заданного статистического распределения квантильное отклонения примет значение

Коэффициент вариации равный процентному отношению подправленного среднего квадратичного к выборочному среднему

Коэффициент асимметрии находим по формуле

Здесь

Подставляем в формулу коэффициента асимметрии

Эксцессом статистического распределения выборки называется число, которое вычисляют по формуле:

Здесь m4 центральный эмпирический момент 4-го порядка. Находим момент

а далее эксцесс

Теперь Вы имеете все необходимые формулы чтобы найти числовые характеристики статистического распределения. Как найти моду, медиану и дисперсию должен знать каждый студент, который изучает теорию вероятностей.

Готовые решения по теории вероятностей

- Следующая статья — Построение уравнения прямой регрессии Y на X

Вы́борочное

(эмпири́ческое) сре́днее —

это приближение теоретического среднего

распределения, основанное на выборке

из него.

Определение:

Пусть

вероятности,

определённая на некотором вероятностном

пространстве (Ω,F,P).

Тогда её выборочным средним

называется случайная

величина.

Свойства

выборочного среднего :

Пусть

функция распределения данной

выборки. Тогда для любого

фиксированного ω

(неслучайной)функцией дискретного

распределения.

Тогда математическое

ожидание этого

распределения равно

Выборочное

среднее — несмещённая

оценка теоретического

среднего:

Выборочное

среднее — сильно

состоятельная оценка теоретического

среднего:

наверное при

Выборочное

среднее — асимптотически

нормальная оценка.

Пусть дисперсия случайных

величин

и ненулевая, то есть

Тогда

распределению при

где

распределение со

средним 0 и

дисперсией

Выборочное

среднее из нормальной выборки — эффективная

оценка её

среднего

20. Выборочная дисперсия, её свойства.

Выборочная

дисперсия в математической

статистике —

это оценка теоретической дисперсии

распределения на основе выборки.

Различают выборочную дисперсию и

несмещённую, или исправленную, выборочные

дисперсии.

Определения

Пусть

вероятности.

Тогда

Выборочная

дисперсия — это случайная

величина

где

символ обозначаетвыборочное

среднее.

Несмещённая

(исправленная) дисперсия — это случайная

величина

Замечание

Очевидно,

Свойства

выборочных дисперсий

Выборочная

дисперсия является

теоретической дисперсией выборочного

распределения.

Более точно, пусть

функция распределения данной

выборки. Тогда для любого фиксированного ω

функция

(неслучайной)функцией дискретного

распределения.

Дисперсия этого распределения равна

Обе

выборочные дисперсии являются состоятельными

оценками теоретической

дисперсии. Если ,

где

по вероятности.

Выборочная

дисперсия является смещённой

оценкой теоретической

дисперсии, а исправленная выборочная

дисперсия несмещённой:

Выборочная

дисперсия нормального

распределения имеет распределение

хи-квадрат.

Пусть .

Тогда

21. Статистические оценки: несмещенные, эффективные, состоятельные

Состоятельной

называют такую точечную статистическую

оценку, которая при n стрем к бесконечн

стремится по вероятности к оцениваемому

параметру. В частности, если дисперсия

несмещенной оценки при n стр к беск

стремится к нулю, то такая оценка

оказывается и состоятельной.

Рассмотрим

оценку θn числового

параметра θ, определенную при n =

1, 2, … Оценка θnназывается состоятельной,

если она сходится по вероятности к

значению оцениваемого параметра θ при

безграничном возрастании объема

выборки. Выразим сказанное более

подробно. Статистика θn является

состоятельной оценкой параметра θ

тогда и только тогда, когда для любого

положительного числа ε справедливо

предельное соотношение

Пример

3. Из закона

больших чисел следует, что θn = является

состоятельной оценкой θ =М(Х) (в

приведенной выше теореме Чебышёва

предполагалось существование

дисперсии D(X); однако,

как доказал А.Я. Хинчин [6], достаточно

выполнения более слабого условия –

существования математического

ожидания М(Х)).

Пример

4. Все

указанные выше оценки параметров

нормального распределения являются

состоятельными.

Вообще,

все (за редчайшими исключениями) оценки

параметров, используемые в

вероятностно-статистических методах

принятия решений, являются состоятельными.

Пример

5. Так, согласно

теореме В.И. Гливенко, эмпирическая

функция распределенияFn(x) является

состоятельной оценкой функции

распределения результатов наблюденийF(x)

Несмещенной

называют такую точечную статистическую

оценку Q*математическое

ожидание которой равно оцениваемому

параметру: M(Q*)=Q

Второе

важное свойство оценок – несмещенность.

Несмещенная оценка θn –

это оценка параметра θ, математическое

ожидание которой равно значению

оцениваемого параметра: М(θn)

= θ.

Пример

6. Из

приведенных выше результатов следует,

что и

являются

несмещенными оценками

параметровm и σ2 нормального

распределения. Поскольку М()

= М(m**)

= m,

то выборочная медиана и

полусумма крайних членов вариационного

рядаm** —

также несмещенные оценки математического

ожидания mнормального

распределения. Однако

поэтому

оценки s2 и

(σ2)**

не являются состоятельными оценками

дисперсии σ2нормального

распределения.

Оценки,

для которых соотношение М(θn)

= θ неверно, называются смещенными. При

этом разность между математическим

ожиданием оценки θn и

оцениваемым параметром θ, т.е. М(θn)

– θ, называется смещением оценки.

Пример

7. Для

оценки s2,

как следует из сказанного выше, смещение

равно

М(s2)

— σ2 =

— σ2/n.

Смещение

оценки s2 стремится

к 0 при n →

∞.

Оценка,

для которой смещение стремится к 0,

когда объем выборки стремится к

бесконечности, называется асимптотически

несмещенной.

В примере 7 показано, что оценка s2 является

асимптотически несмещенной.

Практически

все оценки параметров, используемые в

вероятностно-статистических методах

принятия решений, являются либо

несмещенными, либо асимптотически

несмещенными. Для несмещенных оценок

показателем точности оценки служит

дисперсия – чем дисперсия меньше, тем

оценка лучше. Для смещенных оценок

показателем точности служит математическое

ожидание квадрата оценки М(θn –

θ)2.

Как следует из основных свойств

математического ожидания и дисперсии,

(3)

т.е.

математическое ожидание квадрата

ошибки складывается из дисперсии оценки

и квадрата ее смещения.

Для

подавляющего большинства оценок

параметров, используемых в

вероятностно-статистических методах

принятия решений, дисперсия имеет

порядок 1/n,

а смещение – не более чем 1/n,

где n –

объем выборки. Для таких оценок при

больших n второе

слагаемое в правой части (3) пренебрежимо

мало по сравнению с первым, и для них

справедливо приближенное равенство

(4)

где с –

число, определяемое методом вычисления

оценок θn и

истинным значением оцениваемого

параметра θ.

Эффективной

называют такую точечную статистическую

оценку, которая при фиксированном n

имеет наименьшую дисперсию.

С

дисперсией оценки связано третье важное

свойство метода оценивания –эффективность.

Эффективная оценка – это несмещенная

оценка, имеющая наименьшую дисперсию

из всех возможных несмещенных оценок

данного параметра.

Доказано

[11], что и

являются

эффективными оценками

параметровm и σ2нормального

распределения. В то же время для

выборочной медианы справедливо

предельное соотношение

Другими

словами, эффективность выборочной

медианы, т.е. отношение дисперсии

эффективной оценки параметраm к

дисперсии несмещенной оценки этого

параметра при больших n близка к 0,637.

Именно из-за сравнительно низкой

эффективности выборочной медианы в

качестве оценки математического

ожидания нормального распределения

обычно используют выборочное среднее

арифметическое.

Понятие

эффективности вводится для несмещенных

оценок, для которых М(θn)

= θ для всех возможных значений параметра

θ. Если не требовать несмещенности, то

можно указать оценки, при некоторых θ

имеющие меньшую дисперсию и средний

квадрат ошибки, чем эффективные.

Пример

8. Рассмотрим

«оценку» математического ожидания m1 ≡

0. Тогда D(m1) =

0, т.е. всегда меньше дисперсии D()

эффективной оценки.

Математическое ожидание среднего

квадрата ошибкиdn(m1)

= m2,

т.е. при имеемdn(m1)

< dn().

Ясно, однако, что статистикуm1 ≡

0 бессмысленно рассматривать в качестве

оценки математического ожидания m.

Пример

9. Более

интересный пример рассмотрен американским

математиком Дж. Ходжесом:

Ясно,

что Tn –

состоятельная, асимптотически несмещенная

оценка математического ожидания m,

при этом, как нетрудно вычислить,

Последняя

формула показывает, что при m ≠

0 оценка Tn не

хуже (при

сравнении по среднему квадрату

ошибки dn),

а при m =

0 – в четыре раза лучше.

Подавляющее

большинство оценок θn,

используемых в вероятностно-статистических

методах, являются асимптотически

нормальными, т.е. для них справедливы

предельные соотношения:

для

любого х,

где Ф(х) –

функция стандартного нормального

распределения с математическим ожиданием

0 и дисперсией 1. Это означает, что для

больших объемов выборок (практически

— несколько десятков или сотен наблюдений)

распределения оценок полностью

описываются их математическими

ожиданиями и дисперсиями, а качество

оценок – значениями средних квадратов

ошибок dn(θn).

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #