Если робот Google не сможет получить доступ к вашей странице из-за правила в файле robots.txt, то она, скорее всего, не появится в результатах поиска Google, а если и появится, то без описания.

1. Проверьте, заблокирована ли страница в файле robots.txt

Если вы подтвердили право собственности на сайт в Search Console, сделайте следующее:

- Откройте инструмент проверки URL.

- Проверьте URL страницы, представленный в результате поиска Google.Должен быть выбран ресурс Search Console, который содержит этот URL.

- Найдите статус в разделе результатов проверки Индексирование страниц. Если там значится Заблокировано в файле robots.txt, то проблема подтверждена. Как ее устранить, описано далее.

Если вы не подтвердили право собственности на сайт в Search Console, сделайте следующее:

- Выполните поиск валидатора для файла robots.txt.

- Введите в валидаторе URL страницы, описание которой отсутствует. Это должен быть URL, указанный в результатах поиска Google.

- Если валидатор сообщает, что доступ к странице для робота Google запрещен, то проблема подтверждена. Как ее устранить, описано далее.

2. Измените правило

- Чтобы узнать, какое правило блокирует доступ к странице и где находится файл robots.txt, воспользуйтесь валидатором для robots.txt.

- Измените или удалите правило:

- Если вы пользуетесь сервисом веб-хостинга (например, если ваш сайт построен на Wix, Joomla или Drupal), мы не можем предоставить вам точное руководство по обновлению вашего файла robots.txt. Причина в том, что для каждого сервиса хостинга инструкции будут разными. Чтобы узнать, как разблокировать доступ Google к странице или сайту, поищите нужные сведения в документации своего хостинг-провайдера. Советуем выполнить поиск по запросу «robots.txt название_провайдера» или «открыть Google доступ к странице название_провайдера«. Пример: robots.txt Wix.

- Если у вас есть возможность вносить изменения непосредственно в файл robots.txt, удалите правило или обновите его иным образом с учетом синтаксиса robots.txt.

Эта информация оказалась полезной?

Как можно улучшить эту статью?

Robots.txt — это текстовый файл, в котором прописаны указания (директивы) по индексации страниц сайта. С помощью данного файла можно указывать поисковым роботам, какие страницы на веб-ресурсе нужно сканировать и заносить в индекс (базу данных поисковой системы), а какие — нет.

Файл располагается в корневом каталоге сайта и доступен по адресу: domain.com/robots.txt.

Этот файл дает поисковым системам важные указания, которые напрямую будут влиять на результативность продвижения сайта. Использование Роботс может помочь:

- предотвращению сканирования дублированного контента и бесполезных для пользователей страниц (результаты внутреннего поиска, технические страницы и др.);

- сохранению конфиденциальности разделов веб-сайта (например, можно закрыть системную информацию CMS);

- избежать перегрузки сервера;

- эффективно расходовать краулинговый бюджет на обход полезных страниц.

С другой стороны, если robots.txt содержит неверные данные, то поисковые системы будут неправильно индексировать сайт, и в результатах поиска окажется не та информация, которая нужна.

Можно случайно запретить индексирование важных для продвижения страниц, и они не попадут в результаты поиска.

Например:

User-Agent: * Disallow: /

Эта запись говорят о том, что поисковые системы не смогут увидеть и проиндексировать ваш сайт.

Пустой или недоступный файл Роботс поисковые роботы воспринимают как разрешение на сканирование всего сайта.

Ниже приведены ссылки на инструкции по использованию файла:

- от Яндекса;

- от Google.

Какие директивы используются в robots.txt

User-agent

User-agent — основная директива, которая указывает, для какого поискового робота прописаны нижеследующие указания по индексации, например:

Для всех роботов:

User-agent: *

Для поискового робота Яндекс:

User-agent: Yandex

Для поискового робота Google:

User-agent: Googlebot

Disallow и Allow

Директива Disallow закрывает раздел или страницу от индексации. Allow — принудительно открывает страницы сайта для индексации (например, разрешает сканирование подкаталога или страницы в закрытом для обработки каталоге).

Операторы, которые используются с этими директивами: «*» и «$». Они применяются для указания шаблонов адресов при объявлении директив, чтобы не прописывать большой перечень конечных URL для блокировки.

* — спецсимвол звездочка обозначает любую последовательность символов. Например, все URL сайта, которые содержат значения, следующие после этого оператора, будут закрыты от индексации:

User-agent: *

Disallow: /cgi-bin* # блокирует доступ к страницам

# начинающимся с '/cgi-bin'

Disallow: /cgi-bin # то же самое

$ — знак доллара означает конец адреса и ограничивает действие знака «*», например:

User-agent: *

Disallow: /example$ # запрещает '/example',

# но не запрещает '/example.html'

Crawl-delay

Crawl-delay — директива, которая позволяет указать минимальный промежуток времени между окончанием загрузки одной страницы и началом загрузки следующей. Использовать ее следует в случаях, если сервер сильно загружен и не успевает обрабатывать запросы поискового робота.

User-agent: * Crawl-delay: 3.0 # задает тайм-аут в 3 секунды

С 22 февраля 2018 года Яндекс перестал учитывать директиву Crawl-delay. Чтобы задать скорость, с которой роботы будут загружать страницы сайта, используйте раздел «Скорость обхода сайта» в Яндекс.Вебмастере. Google также не поддерживает эту директиву. Для Google-бота установить частоту обращений можно в панели вебмастера Search Console. Однако роботы Bing и Yahoo соблюдает директиву Crawl-delay.

Clean-param

Директива используется только для робота Яндекса. Google и другие роботы не поддерживают Clean-param.

Директива указывает, что URL страниц содержат GET-параметры, которые не влияют на содержимое, и поэтому их не нужно учитывать при индексировании. Робот Яндекса, следуя инструкциям Clean-param, не будет обходить страницы с динамическими параметрами, которые полностью дублируют контент основных страниц.

Пример директивы Clean-param:

Clean-param: s /forum/showthread.php

Данная директива означает, что параметр «s» будет считаться незначащим для всех URL, которые начинаются с /forum/showthread.php.

Подробнее прочитать о директиве Clean-param можно в указаниях от Яндекс, ссылка на которые расположена выше.

Sitemap

Sitemap — это карта сайта для поисковых роботов, которая содержит рекомендации того, какие страницы необходимо проверить в первую очередь и с какой частотой. Наличие карты сайта помогает роботам быстрее индексировать нужные страницы.

Следует указать полный путь к странице, в которой содержится файл sitemap.

Пример использования:

Sitemap: https://www.site.ru/sitemap.xml

Пример правильно составленного файла robots.txt:

User-agent: * # нижеследующие правила задаются для всех поисковых роботов Allow: / # сайт открыт для индексации Sitemap: https://www.site.ru/sitemap.xml # карта сайта для поисковых систем

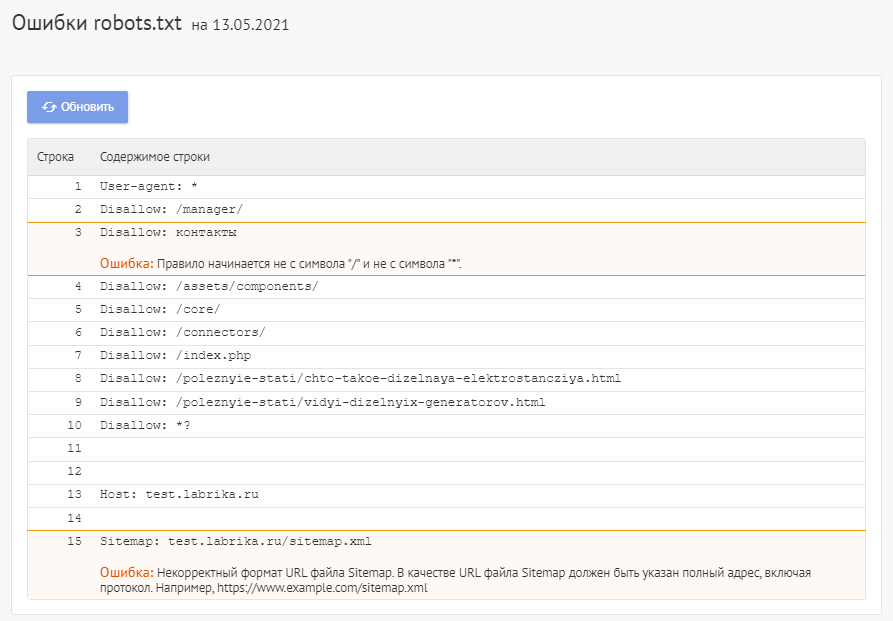

Как найти ошибки в robots.txt с помощью Labrika?

Для проверки файла robots используйте Labrika. Она позволяет увидеть 26 видов ошибок в структуре файла – это больше, чем определяет сервис Яндекса. Отчет «Ошибки robots.txt » находится в разделе «Технический аудит» левого бокового меню. В отчете приводится содержимое строк файла. При наличии в какой-либо директиве проблемы Labrika дает её описание.

Ошибки robots.txt, которые определяет Labrika:

Сервис находит следующие:

Директива должна отделятся от правила символом «:».

Каждая действительная строка в файле Роботс должна состоять из имени поля, двоеточия и значения. Использовать пробелы не обязательно, но рекомендуется для удобства чтения. Для добавления комментария применяется символ решётки «#», который ставится перед его началом. Весь текст после символа «#» и до конца строки робот поисковой системы будет игнорировать.

Стандартный формат:

<field>:<value><#optional-comment>

Пример:

User-agent Googlebot

Пропущен символ “:”.

Правильный вариант:

User-agent: Googlebot

Пустая директива и пустое правило.

Недопустимо делать пустую строку в директиве User-agent, поскольку она указывает, для какого поискового робота предназначены инструкции.

Пример:

User-agent:

Не указан пользовательский агент.

Правильный вариант:

User-agent: название бота

Например:

User-agent: Googlebot

Директивы Allow или Disallow задаются в формате: directive: [path], где значение [path] (путь к странице или разделу) указывать не обязательно. Однако роботы игнорируют директивы Allow и Disallow без указания пути. В этом случае они могут сканировать весь контент. Пустая директива Disallow: равнозначна директиве Allow: /, то есть «не запрещать ничего».

Пример ошибки в директиве Sitemap:

Sitemap:

Не указан путь к карте сайта.

Правильный вариант:

Sitemap: https://www.site.ru/sitemap.xml

Перед правилом нет директивы User-agent

Правило должно всегда стоять после директивы User-agent. Размещение правила перед первым именем пользовательского агента означает, что никакие сканеры не будут ему следовать.

Пример:

Disallow: /category User-agent: Googlebot

Правильный вариант:

User-agent: Googlebot Disallow: /category

Найдено несколько правил вида «User-agent: *»

Должна быть только одна директива User-agent для одного робота и только одна директива вида User-agent: * для всех роботов. Если в файле несколько раз указан один и тот же пользовательский агент с разными списками правил, то поисковым роботам будет сложно определить, какие из этих правил нужно учитывать. В результате возникает большая неопределенность в действиях роботов.

Пример:

User-agent: * Disallow: /category User-agent: * Disallow: /*.pdf.

Правильный вариант:

User-agent: * Disallow: /category Disallow: /*.pdf.

Неизвестная директива

Обнаружена директива, которая не поддерживается поисковой системой (например, не описана в правилах использования Роботс от Яндекса).

Причины этого могут быть следующие:

- была прописана несуществующая директива;

- допущен ошибочный синтаксис, использованы запрещенные символы и теги;

- эта директива может использоваться роботами других поисковых систем.

Пример:

Disalow: /catalog

Директивы «Disalow» не существует, допущена опечатка в написании слова.

Правильный вариант:

Disallow: /catalog

Количество правил в файле robots.txt превышает максимально допустимое

Поисковые роботы будут корректно обрабатывать файл robots.txt, если его размер не превышает 500 КБ. Допустимое количество правил в файле — 2048. Контент сверх этого лимита игнорируется. Чтобы не превышать его, вместо исключения каждой отдельной страницы применяйте более общие директивы.

Например, если вам нужно заблокировать сканирование файлов PDF, не запрещайте каждый отдельный файл. Вместо этого запретите все URL-адреса, содержащие .pdf, с помощью директивы:

Disallow: /*.pdf

Правило превышает допустимую длину

Правило не должно содержать более 1024 символов.

Некорректный формат правила

В файле robots.txt должен быть обычный текст в кодировке UTF-8. Поисковые системы могут проигнорировать символы, не относящиеся к коду UTF-8. В таком случае правила из файла robots.txt не будут работать.

Чтобы поисковые роботы корректно обрабатывали инструкции в файле robots.txt, все правила должны быть написаны согласно стандарту исключений для роботов (REP).

Использование кириллицы и других национальных языков

Использование кириллицы запрещено в файле robots.txt. Согласно утверждённой стандартом системе доменных имен название домена может состоять только из ограниченного набора ASCII-символов (буквы латинского алфавита, цифры от 0 до 9 и дефис). Если домен содержит символы, не относящиеся к ASCII (в том числе буквы национальных алфавитов), его нужно преобразовать с помощью Punycode в допустимый набор символов.

Пример:

User-agent: Yandex Sitemap: сайт.рф/sitemap.xml

Правильный вариант:

User-agent: Yandex Sitemap: https://xn--80aswg.xn--p1ai/sitemap.xml

Возможно, был использован недопустимый символ

Допускается использование спецсимволов «*» и «$». Например:

Disallow: /*.php$

Директива запрещает индексировать любые php файлы.

Если /*.php соответствует всем путям, которые содержат .php., то /*.php$ соответствует только тем путям, которые заканчиваются на .php.

Символ «$» прописан в середине значения

Знак «$» можно использовать только один раз и только в конце правила. Он показывает, что стоящий перед ним символ должен быть последним.

Пример:

Allow: /file$html

Правильный вариант:

Allow: /file.html$

Правило начинается не с символа «/» и не с символа «*».

Правило может начинаться только с символов «/» и «*».

Если значение пути указывается относительно корневого каталога сайта, оно должно начинаться с символа слэш «/», обозначающего корневой каталог.

Пример:

Disallow: products

Правильным вариантом будет:

Disallow: /products

или

Disallow: *products

в зависимости от того, что вы хотите исключить из индексации.

Некорректный формат URL файла Sitemap

В качестве URL файла Sitemap должен быть указан полный адрес, который содержит обозначение протокола (http:// или https://), название домена (главная страница сайта), путь к файлу карты сайта, а также имя файла.

Пример:

Sitemap: /sitemap.xml

Правильный вариант:

Sitemap: https://www.site.ru/sitemap.xml

Некорректное имя главного зеркала сайта

Директива Host указывала роботу Яндекса главное зеркало сайта, если к веб-ресурсу был доступ по нескольким доменам. Остальные поисковые роботы её не воспринимали.

Директива Host могла содержать только протокол (необязательный) и домен сайта. Прописывался протокол https, если он использовался. Указывалась только одна директива Host. Если их было несколько, робот учитывал первую.

Пример:

User-agent: Yandex Host: http://www.example.com/catalog Host: https://example.com

Правильный вариант:

User-agent: Yandex Host: https://example.com

Некорректный формат директивы Crawl-delay

При указании в директиве Crawl-delay интервала между загрузками страниц можно использовать как целые значения, так и дробные. В качестве разделителя применяется точка. Единица измерения – секунды.

К ошибкам относят:

- несколько директив

Crawl-delay; - некорректный формат директивы

Crawl-delay.

Пример:

Crawl-delay: 0,5 second

Правильный вариант:

Crawl-delay: 0.5

Некорректный формат директивы Clean-param

Labrika определяет некорректный формат директивы Clean-param, например:

В именах GET-параметров встречается два или более знака амперсанд «&» подряд:

Clean-param: sort&&session /category

Правильный вариант:

Clean-param: sort&session /category

Правило должно соответствовать виду «p0[&p1&p2&..&pn] [path]». В первом поле через символ «&» перечисляются параметры, которые роботу не нужно учитывать. Во втором поле указывается префикс пути страниц, для которых применяется правило. Параметры отделяются от префикса пути пробелом.

Имена GET-параметров должны содержать только буквы латинского алфавита, цифры, нижнее подчеркивание и дефис.

Префикс PATH URL для директивы Clean-param может включать только буквы латинского алфавита, цифры и некоторые символы: «.», «-«, «/», «*», «_».

Ошибкой считается и превышение допустимой длины правила — 500 символов.

Строка содержит BOM (Byte Order Mark) — символ U+FEFF

BOM (Byte Order Mark — маркер последовательности байтов) — символ вида U+FEFF, который находится в самом начале текста. Этот Юникод-символ используется для определения последовательности байтов при считывании информации.

Стандартные редакторы, создавая файл, могут автоматически присвоить ему кодировку UTF-8 с BOM меткой.

BOM – это невидимый символ. У него нет графического выражения, поэтому большинство редакторов его не показывает. Но при копировании этот символ может переноситься в новый документ.

Использование маркера последовательности байтов в файлах .html приводит к сбою настроек дизайна, смещению блоков, появлению нечитаемых наборов символов, поэтому рекомендуется удалять маркер из веб-скриптов и CSS-файлов.

Избавиться от ВОМ довольно сложно. Один из простых способов это сделать — открыть файл в редакторе, который может изменять кодировку документа, и пересохранить его с кодировкой UTF-8 без BOM.

Например, вы можете бесплатно скачать редактор Notepad++, открыть в нём файл с ВОМ меткой и выбрать во вкладке меню «Кодировки» пункт «Кодировать в UTF-8 (без BOM)».

Название

В наименовании должен быть использован нижний регистр букв.

Как исправить ошибки в robots.txt?

Исправьте ошибки в директивах robots.txt, следуя рекомендациям Labrika. Наш сервис проверяет файл robots.txt согласно стандарту исключений для роботов (REP), который поддерживают Google, Яндекс и большинство известных поисковых машин.

После исправления указанных в отчете Labrika ошибок нажмите кнопку «Обновить», чтобы получить свежие данные о наличии ошибок в файле robots.txt и убедиться в правильном написании директив.

Не забудьте добавить новую версию Роботс в Вебмастера.

О том, как написать правильный файл robots.txt и ответы на другие вопросы вы можете найти в отдельной статье на нашем сайте.

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

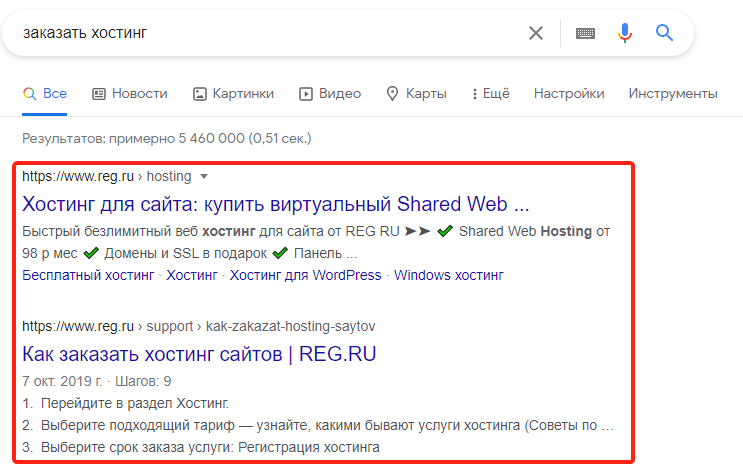

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

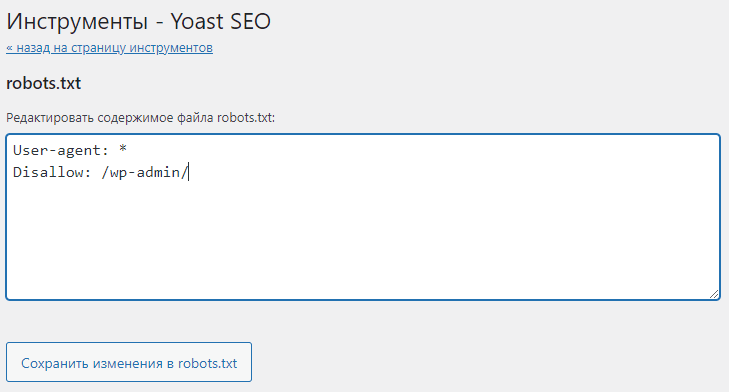

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

-

1.

Откройте файл robots.txt.

-

2.

Добавьте в начало нужные строки.

- Чтобы закрыть сайт во всех поисковых системах (действует для всех поисковых роботов):

User-agent: * Disallow: /- Чтобы запретить индексацию в конкретной поисковой системе (например, в Яндекс):

User-agent: Yandex Disallow: /- Чтобы закрыть от индексации для всех поисковиков, кроме одного (например, Google)

User-agent: * Disallow: / User agent: Googlebot Allow: / -

3.

Сохраните изменения в robots.txt.

Готово. Ресурс пропадет из поисковой выдачи выбранных ПС.

Запрет индексации папки

Гораздо чаще, чем закрывать от индексации весь веб-ресурс, веб-разработчикам требуется скрывать отдельные папки и разделы.

Чтобы запретить поисковым роботам просматривать конкретный раздел:

-

1.

Откройте robots.txt.

-

2.

Укажите поисковых роботов, на которых будет распространяться правило. Например:

- Все поисковые системы:

— Запрет только для Яндекса:

-

3.

Задайте правило Disallow с названием папки/раздела, который хотите запретить:

Где вместо catalog — укажите нужную папку.

-

4.

Сохраните изменения.

Готово. Вы закрыли от индексации нужный каталог. Если требуется запретить несколько папок, последовательно пропишите для каждой директиву Disallow.

Как закрыть служебную папку wp-admin в плагине Yoast SEO

Как закрыть страницу от индексации в robots.txt

Если нужно закрыть от индексации конкретную страницу (например, с устаревшими акциями или неактуальными контактами компании):

-

1.

Откройте файл robots.txt на хостинге или используйте плагин Yoast SEO, если сайт на WordPress.

-

2.

Укажите, для каких поисковых роботов действует правило.

-

3.

Задайте директиву Disallow и относительную ссылку (то есть адрес страницы без домена и префиксов) той страницы, которую нужно скрыть. Например:

User-agent: * Disallow: /catalog/page.htmlГде вместо catalog — введите название папки, в которой содержится файл, а вместо page.html — относительный адрес страницы.

-

4.

Сохраните изменения.

Готово. Теперь указанный файл не будет индексироваться и отображаться в результатах поиска.

Запрет индексации сайта поисковыми системами.

20.08.2019

Ответ

Для закрытия всего сайта от индексации во всех поисковых системах необходимо в файле robots.txt прописать следующую директиву:

Disallow: /

Далее, подробнее разберемся в вопросе подробнее и ответим на

другие вопросы:

- Процесс индексации что это?

- Зачем закрывать сайт от индексации?

- Инструкции по изменению файла robots.txt

- Проверка корректности закрытия сайта от

индексации - Альтернативные способы закрыть сайт от поисковых

систем

Оглавление

- Процесс индексации

- Зачем закрывать сайт от индексации

- Закрываем сайт от индексации в robots.txt

- Инструкция по изменению файла robots.txt

- Проверка корректности закрытия сайта от индексации

- Альтернативные способы закрыть сайт от поисковых систем

- Заключение

Процесс индексации

Индексация сайта – это процесс добавления данных вашего ресурса в индексную базу поисковых систем. Ранее мы подробно разбирали вопрос индексации сайта в Яндекс и Google.

Именно в этой базе и происходит поиск информации в тот

момент, когда вы вводите любой запрос в строку поиска:

Если сайта нет в индексной базе поисковой системе = тогда

сайте нет и в поисковой выдаче. Его невозможно будет найти по поисковым

запросам.

В каких случаях может потребоваться исключать сайт из баз поисковых систем?

Зачем закрывать сайт от индексации

Причин, по которым необходимо скрыть сайт от поисковых

систем может быть множество. Мы не можем знать личных мотивов всех вебмастеров.

Давайте выделим самые основные объективные причины, когда закрытие сайта от

индексации оправданно.

Сайт еще не готов

Ваш сайт пока не готов для просмотра целевой аудиторией. Вы

находитесь в стадии разработки (или доработки) ресурса. В таком случае его

лучше закрыть от индексации. Тогда сырой и недоработанный ресурс не попадет в

индексную базу и не испортит «карму» вашему сайту. Открывать сайт лучше после его полной

готовности и наполненности контентом.

Сайт узкого содержания

Ресурс предназначен для личного пользования или для узкого круга посетителей. Он не должен быть проиндексирован поисковыми системами. Конечно, данные такого ресурса можно скрыть под паролем, но это не всегда необходимо. Часто, достаточно закрыть его от индексации и избавить от переходов из поисковых систем случайных пользователей.

Переезд сайта или аффилированный ресурс

Вы решили изменить главное зеркало сайта. Мы закрываем от индексации старый домен и открываем новый. При этом меняем главное зеркало сайта. Возможно у Вас несколько сайтов по одной теме, а продвигаете вы один, главный ресурс.

Стратегия продвижения

Возможно, Ваша стратегия предусматривает продвижение ряда доменов, например, в разных регионах или поисковых системах. В этом случае, может потребоваться закрытие какого-либо домена в какой-либо поисковой системе.

Другие мотивы

Может быть целый ряд других личных причин закрытия сайта от индексации поисковыми системами. Можете написать в комментариях Вашу причину закрытия сайта от индексации.

Закрываем сайт от индексации в robots.txt

Обращение к Вашему сайту поисковой системой начинается с

прочтения содержимого файла robots.txt. Это служебный файл со специальными

правилами для поисковых роботов.

Подробнее о директивах robots.txt:

- Вебмастер.Яндекс

- Справка.Google

Самый простой и быстрый способ это при первом обращении к

вашему ресурсу со стороны поисковых систем (к файлу robots.txt) сообщить

поисковой системе о том, что этот сайт закрыт от индексации. В зависимости от

задач, сайт можно закрыть в одной или нескольких поисковых системах. Вот так:

| Закрыть во всех системах | Закрыть только в Яндекс | Закрыть только в Google |

|

User-agent: * Disallow: / |

User-agent: Yandex Disallow: / |

User-agent: Googlebot Disallow: / |

Инструкция по изменению файла robots.txt

Мы не ставим целью дать подробную инструкцию по всем

способам подключения к хостингу или серверу, укажем самый простой способ на наш

взгляд.

Файл robots.txt всегда находится в корне Вашего сайта.

Например, robots.txt сайта agency.sape.ru будет

находится по адресу:

https://agency.sape.ru/robots.txt

Для подключения к сайту, мы должны в административной панели

нашего хостинг провайдера получить FTP (специальный протокол передачи файлов

по сети) доступ: <ЛОГИН> И <ПАРОЛЬ>.

В описании

раздела или в разделе помощь, необходимо

найти и сохранить необходимую информацию для подключения по FTP к серверу,

на котором размещены файлы Вашего сайта. Данные отражают информацию, которую

нужно указать в FTP-клиенте:

- Сервер (Hostname) – IP-адрес сервера, на котором размещен Ваш аккаунт

- Логин (Username) – логин от FTP-аккаунта

- Пароль (Password) – пароль от FTP-аккаунта

- Порт (Port) – числовое значение, обычно 21

Далее, нам потребуется любой FTP-клиент, можно

воспользоваться бесплатной программой filezilla (https://filezilla.ru/).

Вводим данные в соответствующие поля и нажимаем подключиться.

После подключения прописываем необходимые директивы. См.

раздел:

Закрываем сайт от индексации в robots.txt

Проверка корректности закрытия сайта от индексации

После того, как вы внесли все необходимые коррективы в файл robots.txt

необходимо убедится в том, что все сделано верно. Для этого открываем файл

robots.txt

на вашем сайте.

Инструменты Sape Agency

В арсенале команды Sape Agency есть набор бесплатных инструментов для SEO-оптимизаторов. Вы можете воспользоваться бесплатным сервисом просмотра файла robots.txt:

Самостоятельно

Открыть самостоятельно, файл находится корне Вашего сайта, по адресу:

www.site.ru/robots.txt

Где www.site.ru – адрес Вашего сайта.

Сервис Я.ВЕБМАСТЕР

Бесплатный сервис Я.ВЕБМАСТЕР – анализ robots.txt.

Бесплатный сервис ЯНДЕКС.ВЕБМАСТЕР проверит ваш robots.txt, покажет какими секциями Вашего файла пользуется поисковая система Яндекс:

Так же, в сервисе можно проверить запрещена ли та или иная страница вашего сайта к индексации:

Альтернативные способы закрыть сайт от поисковых систем

Помимо классического

способа с использованием файла robots.txt можно прибегнуть и к другим, не

стандартным, подходам. Однако у них есть ряд недостатков.

- Вы можете

отдавать поисковым роботам отличный от 200 код ответа сервера. Но это не

гарантирует 100% исключения сайта из индекса. Какое-то время робот может

хранить копию Ваших страниц и отдавать именно их. - С помощью специального

meta тега: <meta name=”robots”>

<meta name=”robots” content=”noindex, nofollow”>

Но

так как метатег размещается и его действие относиться только к 1 странице, то

для полного закрытия сайта от индексации Вам придется разместить такой тег на

каждой странице Вашего сайта.

Недостатком

этого может быть несовершенство поисковых систем и проблемы с индексацией

ресурса. Пока робот не переиндексирует весь сайт, а на это может потребоваться

много времени, иногда несколько месяцев, часть страниц будет присутствовать в

поиске.

- Использование

технологий, усложняющих индексацию Вашего сайта. Вы можете спрятать контент

Вашего сайта под AJAX или скриптами. Таким образом поисковая система не сможет

увидеть контент сайта. При этом по названию сайта или по открытой части в

индексе поисковиков может что-то хранится. Более того, уже завра новое

обновление поисковых роботов может научится индексировать такой контент. - Скрыть все

данные Вашего сайта за регистрационной формой. При этом стартовая страница в

любом случае будет доступна поисковым роботам.

Заключение

Самым простым способом закрыть сайт от индексации, во всех поисковых системах, необходимо в файле

robots.txt прописать следующую директиву:

Disallow: /

«robots.txt» это служебный файл со специальными правилами для поисковых роботов.

Файл robots.txt всегда находится в корне Вашего сайта. Для изменения

директив файла Вам потребуется любой FTP-клиент.

Помимо классического способа с использованием файла robots.txt можно прибегнуть и к другим, не стандартным, подходам. Однако у них есть ряд недостатков. Для проверки текущих директив Вашего сайта предлагаем воспользоваться бесплатным сервисом просмотра файла robots.txt:

Содержание

В статье о том, зачем и как закрыть сайт от индексации в robots.txt, что можно скрыть и как проверить, что вы всё сделали правильно.

Зачем закрывать сайт от индексации

Когда поисковые роботы просканировали и проиндексировали страницы сайта, они начинают показываться в поисковых системах. Это значит, что пользователи могут находить сайт по конкретным поисковым запросам в Google, Яндексе и других поисковых системах.

При этом сайт может состоять из множества разных страниц, и некоторые из них пользователям и поисковым системам видеть не нужно. Например, служебные страницы, дубли страниц и другой малополезный контент. Страницы с таким контентом поисковые системы могут и сами «выбрасывать» из индекса или понижать их позиции, но тогда это может отразиться на ранжировании всего сайта.

Кроме того, стоит учитывать и краулинговый бюджет сайта — лимит на количество страниц сайта, которые поисковые роботы смогут обойти за сутки. И этот лимит может тратиться на неважные страницы сайта, в то время как важные целевые страницы могут долго быть непроиндексированными. Подробнее об этом мы писали в статье «Как оптимизировать краулинговый бюджет».

Что можно закрыть от индексации

Дубль

Это страницы сайта, которые отличаются URL‑адресом, но содержат одинаковый или практически одинаковый контент. Дубли могут привести к таким последствиям, как:

-

снижение скорости индексирования новых страниц. Индексирующий робот может медленнее доходить до новых страниц, из‑за того что будет обходить дубли;

-

поисковая система «склеит» дубли и сама выберет среди них основную страницу. При этом есть риск, что эта выбранная страница не будет вашей целевой;

-

в индексе останутся все дубли. Тогда все они могут конкурировать между собой, «моргать» в выдаче и т. д. Это может влиять на положение сайта в поиске.

Подробнее про дубли в Яндекс.Справке

Документ для скачивания

В некоторых случаях может быть нужно закрыть от индексации документы, например в формате pdf, docx и т. п. С помощью robots.txt это можно сделать.

С одной стороны, когда документы можно скачать из выдачи, не переходя на сайт, это может приводить к потере трафика, с другой стороны, может, наоборот, положительно повлиять на посещаемость сайта. Исходите из стратегии и пользы для вашего проекта.

Страницы, которые находятся в разработке

Если на странице нет контента или есть, но он дублирует другую страницу, если на странице идёт редизайн или доработка и мы пока не хотим её выкатывать и в других подобных случаях можно запретить её индексацию.

Если оставить такие страницы доступными для индексации, то ПС может сама понизить или исключить их из индекса, что может сказаться на оценке сайта в целом.

Техническая страница

Все служебные, технические страницы не содержат полезного контента для пользователей или вовсе могут быть пустыми. Поэтому их стоит закрыть от индексации.

Такими страницами, в зависимости от конкретного сайта и особенностей проекта, могут быть: страницы регистрации, авторизации, результаты поиска по страницам сайта, Личный кабинет, Корзина, Избранное и т. д.

Папка

Файлы сайта обычно распределяются по папкам, например по категориям, каталогам, разделам, подразделам и т. д. Если какой‑то раздел на сайте устарел целиком, то можно скрыть от индексации всю папку, а не только отдельные страницы.

Картинка

Помимо закрытия страниц сайта, можно также закрыть от индексации отдельный тип контента, например все картинки определённого формата или фотографии.

Если вы размещаете информативные и полезные изображения, закрывать их от индексации нежелательно.

Ссылка

С помощью robots.txt мы не можем запретить индексацию одной ссылки. Чтобы робот не переходил по ссылкам на странице, мы можем закрыть от индексации страницу, на которой размещена ссылка, или страницу, на которую она ведёт.

Чтобы скрыть от индексирования конкретную ссылку, Яндекс рекомендует использовать атрибут rel.

Блок на сайте

Мы не можем закрывать в robots.txt отдельные блоки на странице.

Запретить индексирование части текста в Яндексе можно с помощью тега noindex, но Google данный тег не поддерживает.

Как запретить индексацию в robots.txt

Файл robots.txt — это текстовый документ формата .txt, в котором прописаны специальные правила (директивы) для поисковых роботов. Они помогают управлять индексацией сайта.

С помощью этих правил можно указать поисковым роботам, какие страницы и файлы сайта не должны присутствовать в поисковой выдаче, а какие, наоборот, должны.

В файле robots.txt можно:

-

разрешить или запретить индексацию страниц или разделов сайта;

-

указать ссылку на карту сайта Sitemap.xml;

-

заблокировать показ изображений, видеороликов и аудиофайлов в результатах поиска.

В robots.txt мы обычно закрываем страницы массово: весь каталог, конкретные типы страниц, страницы или файлы с определёнными характеристиками.

Если у сайта есть robots.txt, то обычно он хранится он в корневой папке сайта — там, куда загружаются каталоги и другие файлы.

Кроме того, на некоторых сайтах robots.txt можно найти по ссылке site.ru/robots.txt, где site.ru — это ваш сайт. Например, https://topvisor.com/robots.txt.

Если файла нет, значит, скорее всего, сейчас для индексации доступны все страницы сайта и у поисковых роботов нет специальных указаний.

Поэтому файл нужно создать самостоятельно. Сделать это можно в Блокноте или другом текстовом редакторе. В файле нужно прописать специальные директивы, о которых расскажем ниже.

После этого сохраняем документ в формате .txt с названием robots и загружаем в корневую папку сайта.

Основные директивы robots.txt

-

User‑Agent — обязательная директива, которая говорит, какому именно поисковому роботу адресуются указанные ниже правила. В документе эта директива может повторяться несколько раз — с неё начинается каждая новая группа правил для конкретного бота.

В файле эта строка будет выглядеть так:

User‑agent:

После двоеточия мы прописываем название бота, к которому будут обращены последующие правила.

Чаще всего используем такие:

- * — когда обращаемся ко всем поисковым роботам;

- Googlebot — когда обращаемся к роботам Google;

- Yandex — когда обращаемся к роботам Яндекса.

Записи в файле будут выглядеть так:

User‑agent: * или: User‑agent: Yandex или: User‑agent: Googlebot

Список User‑agent поисковых роботов Google

Список User‑agent поисковых роботов Яндекса

Перед каждой новой директивой User‑agent, которую вы прописываете в документе, необходимо ставить дополнительный пропуск строки.

Например, если бы нам нужно было закрыть весь сайт от индексации для Яндекса и Google, мы бы написали так:

User‑agent: Googlebot Disallow: / User‑agent: Yandex Disallow: /

-

Disallow — этой директивой мы можем запретить роботу индексировать определённые разделы сайта, страницы или файлы. Здесь могут закрываться от индексации, например:

-

технические страницы: страницы регистрации, авторизации и др., у интернет‑магазинов это могут быть страницы «Корзина», «Избранное» и др.;

-

страницы сортировок, которые изменяют вид отображения информации;

-

страницы внутреннего поиска и т. д.

-

Правила указания директивы такие:

-

Сначала указываем саму директиву и двоеточие. Например: Disallow:

-

После этого указываем раздел или страницу в корневой папке текущего сайта без указания самого домена. Например: /ru/marketing/.

Если правило касается страницы, ставим полный относительный адрес. В начале должен идти знак «/». Например, /ru/marketing/57‑free‑seo‑tools.

Если закрываем весь каталог, то в конце строки должен стоять слеш «/».

Например, чтобы запретить роботам Яндекса индексацию всего раздела «Маркетинг» в Топвизор‑Журнале, мы бы написали в robots.txt так:

User‑agent: Yandex Disallow: /ru/marketing/

-

Allow — директива указывает поисковому роботу, какие разделы сайта можно индексировать. Обычно используется для указания подправила директивы Disallow, например, когда мы хотим разрешить сканирование какой‑то страницы или каталога внутри закрытого директивой Disallow раздела.

User‑agent: Yandex Disallow: /catalog/ Allow: /catalog/auto/ # запрещает скачивать страницы, начинающиеся с '/catalog/', # но разрешает скачивать страницы, начинающиеся с '/catalog/auto/'

Если в документе одновременно указаны директивы Allow и Disallow для одного и того же элемента, то предпочтение отдаётся директиве Allow — элемент будет проиндексирован.

О директиве Disallow и Allow у Яндекса

О директиве Disallow и Allow у Google

Дополнительно

При указании пути к разделу, странице или файлам может использоваться спецсимвол «*».

Он означает любую (в том числе пустую) последовательность символов. Может ставиться как префикс в начале адреса или как суффикс в конце.

Например:

Disallow: /catalog/*/shopinfo — запрещает индексацию любых страниц в разделе catalog, в URL которых есть shopinfo.

Disallow: *shopinfo — запрещает индексацию всех страниц, содержащих в URL “shopinfo”, например: /ru/marketing/shopinfo.

Подробнее о спецсимволах и правилах их использования в Яндексе

Спецсимволы работают в том числе и с директивой Allow.

-

Sitemap — в robots.txt мы можем указать путь к карте сайта (Sitemap.xml) и таким образом помочь поисковому роботу просканировать страницы сайта.

Путь указывается через директиву Sitemap, а сам путь должен быть полным, с указанием домена, как в браузере:

Sitemap: https://site.com/sitemaps1.xml

Если карт сайта несколько, директиву можно повторять несколько раз с новой строки.

Директива считается межсекционной: поисковые роботы увидят путь к карте сайта вне зависимости от места в файле robots.txt, где он указан.

О директиве Sitemap в Яндекс.Справке

О директиве Sitemap в Google Справке

-

Clean‑param для Яндекса — директива позволяет запретить поисковым роботам индексировать страницы с динамическими параметрами, например с GET‑параметрами или UTM‑метками и т. д.

Яндекс предупреждает, что если не закрыть страницы с параметрами через Clean‑param, то в поиске могут появиться многочисленные дубли страниц, что может негативно отразиться на ранжировании.

Синтаксис и правила оформления:

-

файл должен называться robots.txt;

-

размер файла не больше 500 КБ;

-

на сайте должен быть только один такой файл;

-

файл размещён в корневом каталоге сайта, но не в подкаталоге. Нужно вот так: https://www.example.com/robots.txt, а так нельзя: https://example.com/pages/robots.txt;

-

файл отдаёт ответ сервера 200 OK.

Подробные правила оформления robots.txt у Яндекса.

Подробные правила оформления robots.txt у Google.

Дополнительно про файл robots.txt:

-

есть директивы, которые одни ПС воспринимают, а другие нет. Например, Clean‑param для Яндекса;

-

те страницы, которые вы запретили в файле, всё равно могут быть проиндексированы. Например, Google говорит, что страницы могут попасть в индекс, если поисковый робот нашёл их по ссылке с других сайтов или страниц. Чтобы полностью скрыть информацию от краулеров, стоит использовать другие способы, например метатег robots и HTTP‑заголовок X‑Robots‑Tag и др.

Как проверить запрет

После создания из загрузки файла на сайт убедитесь, что он существует, размещён в корневом каталоге сайта и без проблем открывается. Для проверки введите в строку браузера адрес сайта с указанием файла в формате https://site.ru/robots.txt.

После этого можно проверить файл в панелях веб‑мастеров Яндекс.Вебмастер и Google Search Console.

Яндекс.Вебмастер

В Вебмастере открываем «Инструменты» → «Анализ robots.txt». Обычно содержимое файла сразу будет отображаться в строке. Если нет, копируем из браузера и вставляем сюда. Затем нажимаем кнопку «Проверить»:

Если в файле будут ошибки, Вебмастер подскажет, как их исправить.

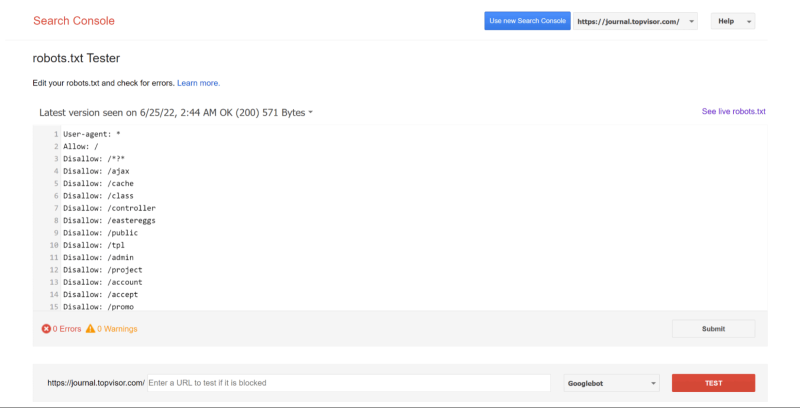

Google Search Console

Для того чтобы проверить файл robots.txt с помощью валидатора Google, необходимо:

1. Зайти в аккаунт Google Search Console.

2. Перейти в инструмент проверки robots.txt.

3. В открывшемся окне вы увидите уже подгруженную информацию из файла. Если нет, вставьте её из браузера.

GSC покажет, есть ли в файле ошибки и как их исправить.

Краткий конспект

На сайте может быть необходимо скрыть некоторые страницы, например:

-

служебные страницы или дубли;

-

неважные, неактуальные или малополезные страницы.

Закрывать от индексации можно как сайт полностью, так и отдельные страницы, файлы, изображения.

В robots.txt с помощью специальных директив мы обычно закрываем страницы массово: весь каталог, конкретные типы страниц, страницы или файлы с определёнными характеристиками.

После создания правил для индексирования сайта в robots.txt важно его проверить. Сделать это можно бесплатно в панелях веб‑мастеров Яндекс.Вебмастер и Google Search Console.